科技界出现了许多为人工智能和机器学习开发特殊芯片的初创公司。在加州圣克拉拉由老牌半导体分析公司Linley集团主办的Linley集团秋季处理器会议上,出现了一些最有趣的产品。

一家总部位于圣克拉拉的创业公司Cornami进行了一场演讲。

其联合创始人和首席技术官Paul Masters描述了一种机器学习的新方式,可以安排芯片的各个元素进行机器学习“训练”(神经网络就是在这里发展起来的)和“推理”(神经网络在不断的基础上提供答案)。

Cornami一直在秘密运作,这是Masters首次公开关于该公司芯片运作方式的一些细节。

Cornami的目标是向大众市场提供芯片,包括“边缘计算”领域,其中汽车和消费电子产品特别需要具有高响应性能的芯片,并且在运行神经网络方面具有高能效。

Masters说,该芯片可追溯到20世纪70年代和80年代的技术,称为脉动阵列。脉动阵列具有很多计算元件,例如乘法—累加器,以执行作为神经网络的基本计算单元的矩阵乘法。用线将这些元素彼此连接,并连接到网格中的内存。脉动矩阵是根据心脏的收缩功能来命名的:就像血流一样,数据是通过这些计算元素“泵”出来的。

根据演示,脉动阵列在它们首次出现时并未真正被重视,但它们正在成为构建AI芯片的主要方式。Masters表示:“你已经看到了,它很酷,它来自70年代。”

“谷歌正在使用它们,还有微软以及数十家初创公司,”他观察到脉动阵列的普及。

但Masters讨论了Cornami如何采用独特的脉动阵列方法。“脉动阵列的诅咒在于它们是方形的,”Masters说。他指的是乘数累加器的对称排列。由于这种刚性布局,将数据移入和移出这些计算元素将占用芯片大量的工作,甚至比每个计算元素中的计算本身还要多。

Masters 说“传统芯片的功耗在哪里?”,这是个大问题。“数据被转储到DDR [DRAM内存]中,它必须进入核心进行计算,因此数据从DDR进入三级高速缓存,二级高速缓存和一级高速缓存,然后进入寄存器,之后开始进行计算。如果核心耗尽,就必须反过来,先退出并将所有临时数据转储回寄存器,L1缓存,L2,L3,一遍又一遍。“

Masters解释说,只要用到L1缓存就需要四倍于实际计算的功耗。如果要用DRAM,几乎很难做到,而且需要更大的功率来驱动芯片。

Masters说:“传统机器中能效最低的就是移动数据”。解决方案是拥有数千个核心,通过保持数千个核心繁忙,可以避免返回到内存子系统,而只是简单地将计算的输入和输出从一个元素路由到下一个元素。“如果拥有8,000到32,000个核心,我们可以保持整个神经网络在一个芯片上”他说。

因此,为了降低进出内存的成本,Cornami芯片重新排列他们的电路,使计算元件可以切换到各种几何布局,有效地组织芯片上的计算活动,以满足目前的神经网络的需求。

“Cornami构建了一个可以根据需要构建任何尺寸,任何形状的脉动阵列的架构。” 脉动阵列可以被动态地重新排列成非正方形的各种新几何图形。这些奇怪的数组形状使得在计算元素之间移动输入和输出变得非常有效。因此,Cornami芯片可以最小化内存和缓存使用,从而“显著降低功耗和延迟,并提高性能”。

Masters自豪地说,凭借这种灵活性,单个Cornami芯片就可以处理整个神经网络,并且能够取代通常用于运行神经网络的CPU,GPU,FPGA和ASIC的各种组合。他表示,这是一个“芯片上的数据中心”,对于将AI置于汽车等“边缘计算”中具有重要意义。

Masters展示了一些性能统计数据:运行“SegNet”神经网络进行图像识别,与Nvidia“Titan V”GPU相比,Cornami芯片能够每秒处理877帧,功耗只有30瓦。而Titan GPU功耗250瓦,每秒只能处理8.6帧。

Cornami于2016年9月从Impact Venture Capital获得了300万美元的B轮风险投资。随后,该公司已收到资金,但尚未披露具体数额。

-

人工智能

+关注

关注

1791文章

47274浏览量

238481 -

机器学习

+关注

关注

66文章

8418浏览量

132629 -

AI芯片

+关注

关注

17文章

1887浏览量

35020

原文标题:Cornami AI芯片:革命性的脉动阵列架构

文章出处:【微信号:SSDFans,微信公众号:SSDFans】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

东软医疗光子计数CT获得革命性突破

安宝特案例 | AR技术在院外心脏骤停急救中的革命性应用

PC示波器:电子测试与测量的革命性工具

使用OPA129构建了一个电荷放大器,6脚输出经常出现尖峰的原因?

颠覆!硅光“黑马”打造革命性光学IO技术,可取代芯片内铜线

全新雷达水位流速仪,让河流管理更智能,革命性水文监测

日本推出革命性的人形机器人

Transformer架构在自然语言处理中的应用

苹果新专利,Apple Pencil将迎来革命性升级

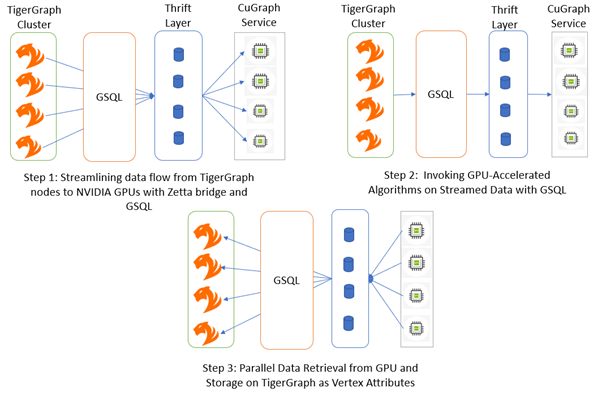

革命性的图形分析: NVIDIA cuGraph 加速的下一代架构

英伦科技室内裸眼3D广告机会议一体机正以其革命性的视觉体验引领着新的趋势

长电科技推出了一项革命性的高精度热阻测试与仿真模拟验证技术

利用太赫兹超构表面开发一款革命性的生物传感器

Cornami构建了一个革命性的脉动阵列架构

Cornami构建了一个革命性的脉动阵列架构

评论