谷歌重磅发布自然问题数据集(Natural Questions),包含30万个自然发生的问题和人工注释的答案,16000个示例,并发起基于此数据集的问答系统挑战赛。有望成为自然语言理解领域的SQuAD!

开放领域问题回答(QA)是自然语言理解(NLU)中的一项基准任务,它的目的是模拟人类如何查找信息,通过阅读和理解整个文档来找到问题的答案。

比如,给定一个用自然语言表达的问题“为什么天空是蓝色的?”("Why is the sky blue?”),QA系统应该能够阅读网页(例如“天空漫射”的维基百科页面)并返回正确的答案,即使答案有些复杂和冗长。

然而,目前还没有可以用于训练和评估QA模型的大型、公开的自然发生问题(即由寻求信息的人提出的问题)和答案数据集。

这是因为构建用于QA任务的高质量数据集需要大量的真实问题来源,并且需要大量人力来为这些问题寻找正确答案。

为了促进QA领域的研究进展,谷歌今天发布自然问题数据集(Natural Questions, NQ),这是一个用于训练和评估开放领域问答系统的新的、大规模语料库,也是第一个复制人类查找问题答案的端到端流程的语料库。

Natural Questions数据集

NQ的规模非常庞大,包含30万个自然发生的问题,以及来自Wikipedia页面的人工注释答案,用于训练QA系统。

此外,NQ语料库还包含16000个示例,每个示例都由5位不同的注释人提供答案(针对相同的问题),这对于***的QA系统的性能非常有用。

Natural Questions数据集中的示例

由于回答NQ中的问题比回答琐碎问题(这些问题对计算机来说已经很容易解决)需要有更深入的理解,谷歌还发起了一项基于此数据集的挑战赛,以帮助提高计算机对自然语言的理解。

NQ挑战赛排行榜

NQ数据集包含307K训练示例、8K开发示例和8K测试示例。

目前,NQ挑战赛排行榜上只有谷歌的BERT模型和DecAtt-DocReader模型的成绩。在论文中,谷歌证明在长答案选择任务上的人类的最优成绩为87% F1,在短答案选择任务上人类的最优成绩为76%。

来自谷歌搜索的真实问题

NQ是第一个使用自然发生的查询创建的数据集,并专注于通过阅读整个页面来查找答案,而不是从一个短段落中提取答案。

为了创建NQ,我们从用户提交给Google搜索引擎的真实、匿名、聚合的查询开始。

然后,我们要求注释者通过通读整个维基百科页面来找到答案,就好像这个问题是他们自己提出的一样。注释者需要找到一个长答案和一个短答案,长答案涵盖推断问题所需的所有信息,短答案需要用一个或多个实体的名称简洁地回答问题。

对NQ语料库的注释质量进行评估,显示准确率达到90%。

注释包含一个长答案和一个短答案

研究人员在论文《自然问题:问答研究的基准》(Natural Questions: a Benchmark for Question Answering Research)中对数据收集的过程进行了全面描述,论文已发表在《计算语言学协会会刊》(Transactions of the Association for computing Linguistics)。大家也可以在NQ网站上查看更多来自数据集的示例。

自然语言理解挑战

NQ的目的是使QA系统能够阅读和理解完整的维基百科文章,其中可能包含问题的答案,也可能不包含问题的答案。

系统首先需要确定这个问题的定义是否足够充分,是否可以回答——许多问题本身基于错误的假设,或者过于模糊,无法简明扼要地回答。

然后,系统需要确定维基百科页面中是否包含推断答案所需的所有信息。我们认为,相比在知道长答案后在寻找短答案,长答案识别任务——找到推断答案所需的所有信息——需要更深层次的语言理解。

我们希望NQ的发布以及相关的挑战赛将有助于推动更有效、更强大的QA系统的开发。我们鼓励NLU社区参与进来,并帮助缩小目前最先进方法的性能与人类上限之间的巨大差距。

-

谷歌

+关注

关注

27文章

6139浏览量

105059 -

人工智能

+关注

关注

1791文章

46820浏览量

237463

原文标题:NLP新基准!谷歌重磅发布开放问答数据集,30万自然提问+人工注释答案

文章出处:【微信号:aicapital,微信公众号:全球人工智能】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

易华录“基于北斗数据的高精度定位服务融合应用”入选案例集

谷歌发布革命性AI天气预测模型NeuralGCM

PyTorch如何训练自己的数据集

请问NanoEdge AI数据集该如何构建?

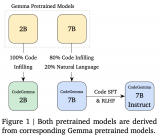

谷歌发布用于辅助编程的代码大模型CodeGemma

谷歌推出能制作旅行攻略的AI工具

谷歌发布开源AI大模型Gemma

谷歌重磅发布自然问题数据集

谷歌重磅发布自然问题数据集

评论