作为一名前半生奉献给学术,现在投身业界的研究者,Daniel Gutierrez习惯在数据科学业内工作的同时,跟进学术界的最新动态。

最近,通过一场网络研讨会,他发现人工智能大神吴恩达(Andrew Ng)也有一样的习惯。吴恩达提到,他经常随身携带一个装满研究论文的文件夹,利用搭车的空闲时间研究论文。

Daniel Gutierrez因此建议,不管是数据科学从业者还是研究者,都可以准备一个论文文件夹来装一些论文,就像吴恩达建议的:如果你每周阅读几篇论文(部分论文可以泛读),一年后你就阅读了100多篇论文,足够比较深入地了解一个新领域。

在这篇文章中,Daniel Gutierrez列出了2018年最具影响力的20篇数据科学研究论文清单,所有数据科学家都应该认真回顾。我还收录了一些综述性文章,它们可以帮助你看到当前技术领域的发展情况,同时还有完整的参考文献列表,其中不乏很多具有开创性的论文。

新一年随身携带的论文合集,不如就从这里开始吧!

一种新型无梯度下降的反向传播算法

我们都知道,在20世纪70年代初引入的反向传播算法是神经网络学习的支柱。反向传播利用大名鼎鼎的一阶迭代优化算法进行梯度下降,用于寻找函数的最小值。本文中, Bangalore的PES大学研究人员描述了一种不使用梯度下降的反向传播方法。他们设计了一种新算法,使用Moore-Penrose伪逆找出人工神经元权重和偏差的误差。本文还在各种数据集上进行了数值研究和实验,旨在验证替代算法的结果是否符合预期。

下载链接:

https://arxiv.org/pdf/1802.00027.pdf

一份基于深度学习的情感分析

情感分析经常被用于识别和分类文本中所表达的观点,因为它可以确定作者对特定主题、产品等态度是积极、消极还是中性的,所以在处理社交媒体数据时,情感分析非常有价值。

深度学习日益流行,它是一种强大的机器学习技术,可以学习到数据的多层特征并生成预测结果。随着深度学习在许多其他应用领域的成功,近年来,深度学习在情感分析中也得到了广泛的应用。本文对深度学习进行了全面的综述,并对其在情感分析领域的应用现状也进行了分析。

下载链接:

https://arxiv.org/ftp/arxiv/papers/1801/1801.07883.pdf

应用数学家所理解的深度学习是什么

作为一名数学家,我喜欢看一些关于数据科学的技术文档,并找到它们与应用数学的联系。本文从应用数学的角度出发,对深入学习的基本思想进行阐述。多层人工神经网络已在各个领域中被广泛使用,这场深度学习革命的核心实际上可以追溯到应用和计算数学的基础概念:特别是在微积分、偏微分方程、线性代数和近似/优化理论的概念中。

下载链接:

https://arxiv.org/pdf/1801.05894.pdf

论深度学习的起源

本文对深度学习模型进行了全面的历史回顾,它从人工神经网络的起源介绍到在过去十年的深度学习研究中占据主导地位的模型:如卷积神经网络、深度信念网络和循环神经网络。本文还重点介绍了这些模型的先例,分析了早期模型的构建过程,以及模型的发展历程。

下载链接:

https://arxiv.org/pdf/1702.07800.pdf?

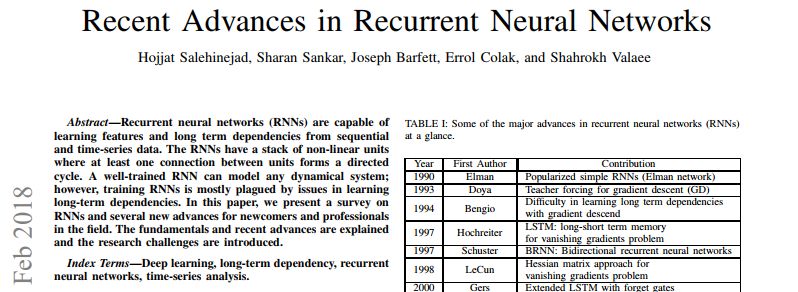

循环神经网络研究进展

循环神经网络(RNN)能够从时间序列数据中学习序列特征和长期依赖性。RNN由一堆非线性单元组成,单元之间至少有一个连接形成有向循环。一个训练完备的RNN可以模拟任何一个动态系统,然而,RNN在训练时一直受到长期依赖性问题的困扰。本文对RNN进行了综述,并着重介绍了该领域的一些最新进展。

下载链接:

https://arxiv.org/ftp/arxiv/papers/1801/1801.00631.pdf

关于深度学习的十大质疑

尽管深度学习的历史根源可以追溯到几十年前,但“深度学习”这一术语和技术在五年前才开始流行起来,当时该领域被Krizhevsky、Sutskever和Hinton等人所统治,他们在2012年发表了经典之作“基于深度卷积神经网络的图像分类”。但在接下来的五年中,深度学习领域中又有什么发现呢?在语音识别、图像识别和游戏等领域取得长足进步的背景下,纽约大学的AI反对者Gary Marcus对深度学习提出了十个问题,并表明如果我们想要获得通用的人工智能,深度学习必须辅以其他技术。

下载链接:

https://arxiv.org/ftp/arxiv/papers/1801/1801.00631.pdf

深度学习中的矩阵微积分

本文较为全面的介绍了深度神经网络中(以及参考文献表中大多数论文)所需的所有线性代数知识。除了基础微积分知识之外,本文深奥的数学知识很少。请注意,若你还是深度学习新手,这篇论文对你来说意义不大;相反,若你已经熟悉神经网络基础知识并希望加深对基础数学的理解,这篇论文将非常适合你研究。

相关报道:

https://arxiv.org/abs/1802.01528

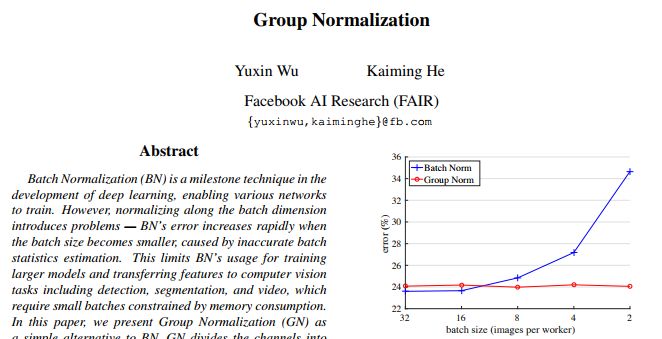

群组归一化

批量归一化(BN)是深度学习开发中的里程碑技术,它使得各种网络的训练成为了可能。但是,沿批量维度进行归一化会带来一些问题:当批量大小变小时,由于批次统计估计不准确,BN的误差会迅速增加。这限制了BN在训练大型模型以及计算机视觉任务(包括检测、分割视频)中的使用,因为这些任务需要的是受内存消耗限制的小批量。本文由Facebook AI研究人员(FAIR)提出,将Group Normalization(GN)作为BN的简单替代方案。GN将通道分成群组,并在每组内计算标准化的均值和方差。GN的计算与批量大小无关,并且其准确性在各种批量大小中都是稳定的。

下载链接:

https://arxiv.org/pdf/1803.08494.pdf

平均参数比重能带来更广泛的优化和更好的概括能力

深度神经网络的训练一般通过使用随机梯度陡降(SGD)变量和递减学习率来优化一个损失函数,直至其收敛。这篇论文指出,对SGD曲线上的多个点取简单平均数,并使用周期波动或恒定的学习率比传统训练方式有更好的概括能力。这篇论文还展示了,这个随机平均参数比重(SWA)过程比SGD有更广泛的优化能力,仅用一个模型就达到了之前快速集合法的效果。

下载链接:

https://arxiv.org/pdf/1803.05407.pdf

对基于神经网络进行文本总结方法的调查

自动总结归纳文本,或者说在保留主要含义的同时压缩文本长度,是自然语言处理(NLP)领域的一个重要研究范畴。这篇论文对近来基于神经网络的模型在自动文本总结方面进行了研究。作者详细审查了十款最前沿的神经网络摘要器:五款摘要模型,以及五款提炼模型。

下载链接:

https://arxiv.org/pdf/1804.04589.pdf

神经网络风格传输的回顾

Gatys等人在2015年“针对艺术风格的神经网络算法”这篇开创性著作中,展示了卷积神经网络(CNN) 能够分离和重组图片的内容和风格,在生成艺术图像上表现出了强大的能力。这个使用CNN来渲染不同风格的内容图像被称作神经网络风格传输(NST)。此后,NST在学术著作和工业应用上都很是热门,受到越来越多的关注,也产生了很多种致力改善或者扩展原有NST算法的方法。这篇论文对NST目前的发展状况提供了概览,也对未来研究提出了一系列问题。

下载链接:

https://arxiv.org/pdf/1705.04058.pdf

几何数据:在机器学习领域针对黎曼几何的一个Python包

在机器学习领域应用黎曼几何越来越受人们关注。这篇论文引入了几何数据这一概念,也给出了应用于诸如超球面、双曲空间、空间对称正定矩阵和李群变换等多重内容计算的python包。此外,论文中还包含了对于这些多重内容的应用,以及实用的黎曼度量和相关的外生性、对数图。相应的测地线距离提供了一系列机器学习损失函数的直观选择。作者还给出了对应的黎曼梯度。几何数据的操作可用于不同的计算后台,比如numpy, tensorflow和keras。文章作者使keras深度学习框架综合应用GPU和几何数据多重内容计算变成了可能。

下载链接:

https://arxiv.org/pdf/1805.08308.pdf

一个更通用的稳健损失函数

这篇论文展示了一个双参数损失函数,可视为对稳健统计学中很多常用的损失函数的一个概括,这些常用的损失函数包括Cauchy/Lorentzian, Geman-McClure, Welsch/Leclerc和广义卡尔波涅尔损失函数(按传递性分为L2,L1,L1-L2和pseudo-Huber/Charbonnier损失函数)。作者描述并可视化展示了这个损失和相应的分布,并列出了它的一些实用性特质。

下载链接:

https://arxiv.org/pdf/1806.01337.pdf

反向退出:随机反向传播算法

这篇论文引入了“反向退出”的概念,也即一个灵活而应用简便的方法,可以直观地表述为,退出现象仅沿着反向传播管道发生。反向退出的应用是沿着网络中特定点插入一个或多个屏蔽层。每个反向退出的屏蔽层在正推法中被视为特征,但几乎不屏蔽部分反向梯度传播。直观来看,在任何卷积层之后插入反向退出层会带来随机梯度,随刻度特征不同而有不同。因此,反向退出非常适用于那些有多重刻度、金字塔结构的数据。

下载链接:

https://arxiv.org/pdf/1806.01337.pdf

关系型强化深度学习

这篇论文引入了一个通过结构化感知和关系型推理从而提升强化深度学习(RL)的方法,主要表现在改善效率、泛化能力和提升传统方法的解读能力。通过自我感知来迭代推理场景中的主题和引导无模型原则之间的关系。结果显示,在一个拥有新型导航和任务计划的“盒世界”中,代理找到了可解释的解决方案,从而可以在基线之上改善样本的复杂度、泛化能力(在训练中能应对更的复杂场景)以及整体表现。

下载链接:

https://arxiv.org/pdf/1806.01830.pdf

一个非常有趣的案例:卷积神经网络和执行坐标转化方法的失败

深度学习里几乎没有别的概念像“卷积”那样大的影响力了。对包含像素或空间表征的任何问题,普遍的直觉就是试试看CNNs。这篇论文通过一个看似微不足道的坐标转化问题展示了一个反直觉的案例,也即单纯要求机器在坐标(x,y)笛卡尔空间和一个热像素的空间之间学习一个映射。虽然CNNs似乎很适用于这个场景,来自Uber的作者们证明了卷积神经网络法最终失败了。这篇论文展示并仔细检验了这个失败案例。

下载链接:

https://arxiv.org/pdf/1807.03247.pdf

反向传播法的演变

反向传播算法是深度学习的基石。尽管其非常重要,但很少有方法尝试调整其算法。这篇论文展示了一种发现新的反向传播方程变式的方法。来自Google的作者使用了一种领域专用语言,将升级的方程描述为一系列原始方程。基于进化的方法被用来发现新的反向传播原则,该原则在一系列最大训练次数后能够最大化泛化能力。这个研究发现了一些升级方程,相较标准的反向传播算法在较少次数内训练得更快,并在收敛时有与标准反向传播算法近似的表现。

下载链接:

https://arxiv.org/pdf/1808.02822.pdf

在深度卷积神经网络学习时代里,物体探测领域近来的发展

物体探测就是对于特定类别图片,比如车、飞机等进行探测的计算机视图任务,它在过去五年里在人工智能领域里吸引了非常多的关注。这些关注,既源于该领域在实际应用的重要性,也是因为自从CNNs时代的到来,它是人工智能领域里现象级的发展。这篇论文是对近来使用深度卷积神经网络学习方法的物体探测领域著作的一个全面回顾,也对近来这些发展进行了深刻的透析。

下载链接

https://arxiv.org/pdf/1809.03193.pdf

语言交互式AI的神经网络法

这篇论文对近年来发展出的语言交互式AI中神经网络方法进行了调查。语言交互式AI可被分为三个类别:1. 回答问题的机器人2. 以任务为导向的对话机器人3. 自动化语音聊天机器人。针对每个类别,文章使用特定系统和模型为案例,展示了领域最前沿的神经网络方法,并将其与传统方法比较,讨论其进步之处和仍面临的问题。

下载链接:

https://arxiv.org/pdf/1809.08267.pdf

可撤销的循环神经网络

循环神经网络(RNNs)在运行序列数据上表现最优秀,但训练起来更占用内存,也就限制了RNNs模型的灵活性。可撤销的循环神经网络,也就是“隐藏对隐藏”的转化能被撤销的RNNs,提供了减少训练所需内存的一个路径,因其隐藏状态无需存储,从而能够在反向传播算法中被重新计算。这篇论文展示了完美可撤销RNNs从根本上就是受限的,因为它们依然需要记住隐藏状态。随后,为了实现能够忘记隐藏状态的完美可撤RNNs,文章提供了存储少量bits的方法。作者这个方法达到了传统模型的近似效果,同时减少了活动内存成本约10-15个百分点。

下载链接:

https://arxiv.org/pdf/1810.10999.pdf

-

神经网络

+关注

关注

42文章

4778浏览量

101009 -

论文

+关注

关注

1文章

103浏览量

14971 -

数据科学

+关注

关注

0文章

165浏览量

10082

原文标题:2018年最具影响力的20篇数据科学研究论文,盘它!

文章出处:【微信号:BigDataDigest,微信公众号:大数据文摘】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于AX650N的M.2智能推理卡解决方案

慧能泰2A1C三端口控制器HUSB391A产品特性

智能化应急消防管理从这里开始:RFID系统

星闪技术已经发布一年多了,应用何去何从?

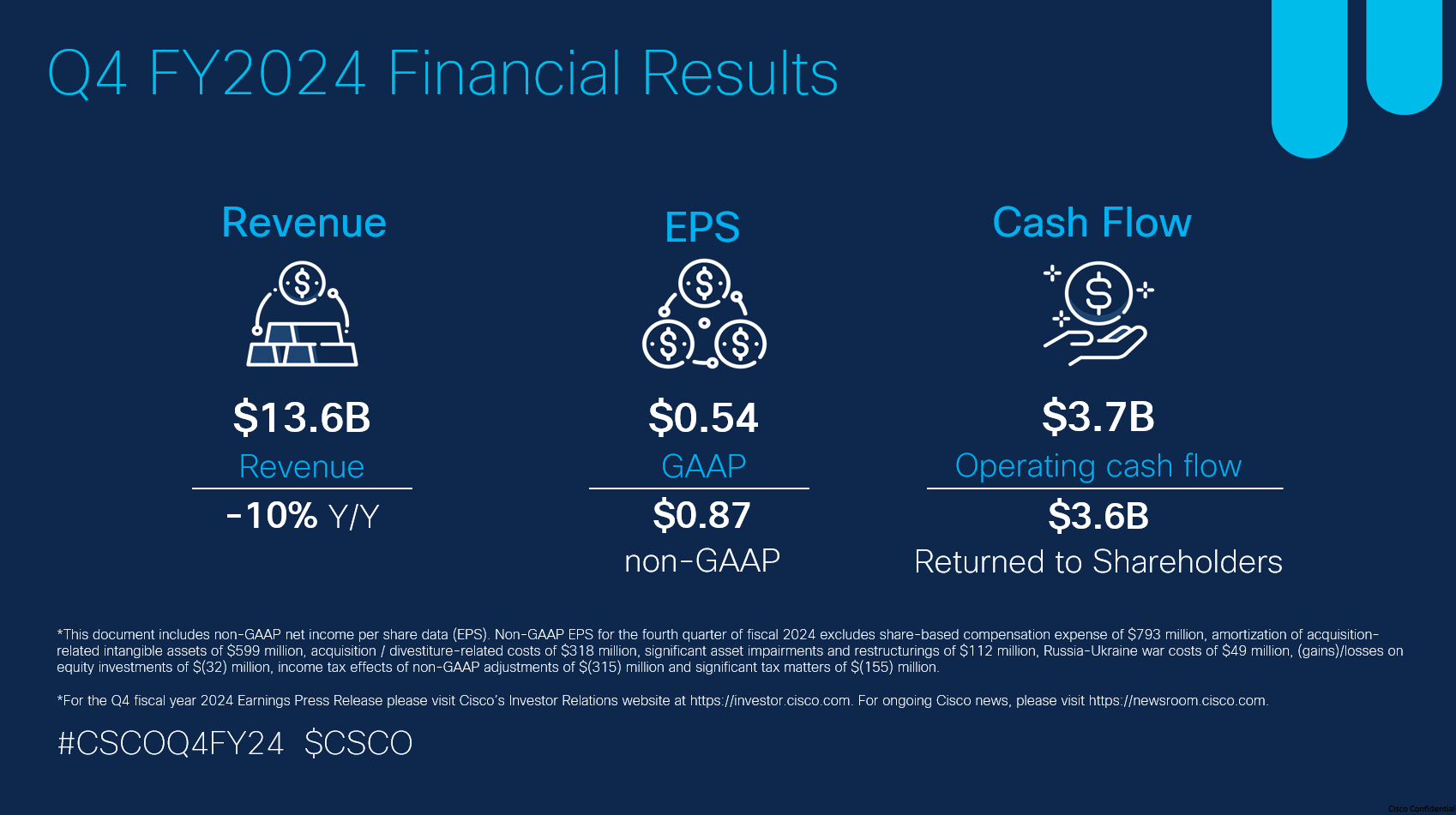

一年两度减员,思科迎来转型阵痛期

一年三连降,苹果没招了

创新从这里开始,益莱储邀您参加 Keysight World 2024

SK海力士HBM4E存储器提前一年量产

力积电与SBI在日合资晶圆厂或提前一年投产

2月全志芯片开源项目分享合集

亿道信息新品EM-T195轻薄型工业平板,隆重登场!

初心不改 踔厉奋发——记我们这一年

新一年随身携带的论文合集,不如就从这里开始吧!

新一年随身携带的论文合集,不如就从这里开始吧!

评论