现实中的自然语言处理面临着多领域、多语种上的多种类型的任务,为每个任务都单独进行数据标注是不大可行的。迁移学习可以将学习的知识迁移到相关的场景下。本文介绍 Sebastian Ruder 博士的面向自然语言处理的神经网络迁移学习的答辩 PPT。

NLP 领域活跃的技术博主Sebastian Ruder 最近顺利 PhD 毕业,下周即将进入 DeepMind 开启 AI 研究员生涯。

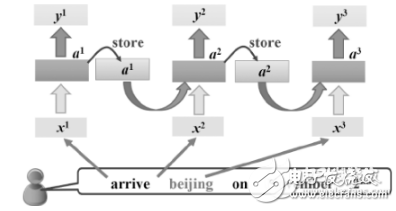

Sebastian Ruder 博士的答辩 PPT《Neural Transfer Learning for Natural Language Processing》介绍了面向自然语言的迁移学习的动机、研究现状、缺陷以及自己的工作。

Sebastian Ruder 博士在 PPT 中阐述了使用迁移学习的动机:

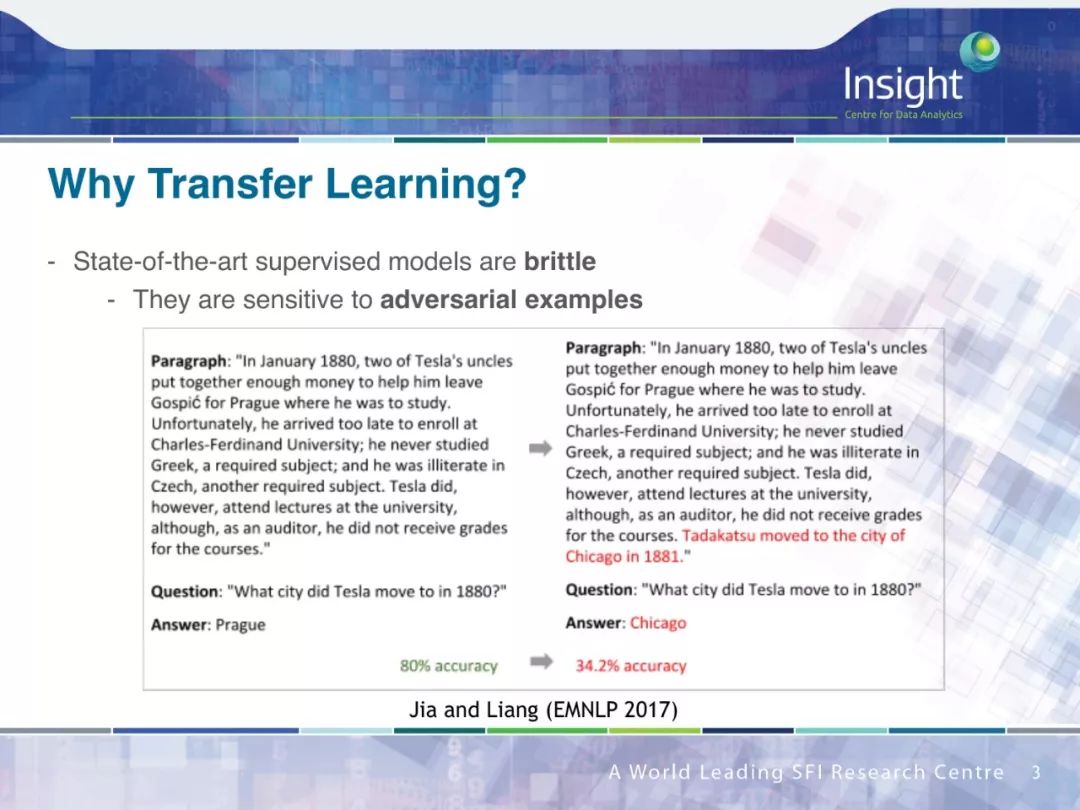

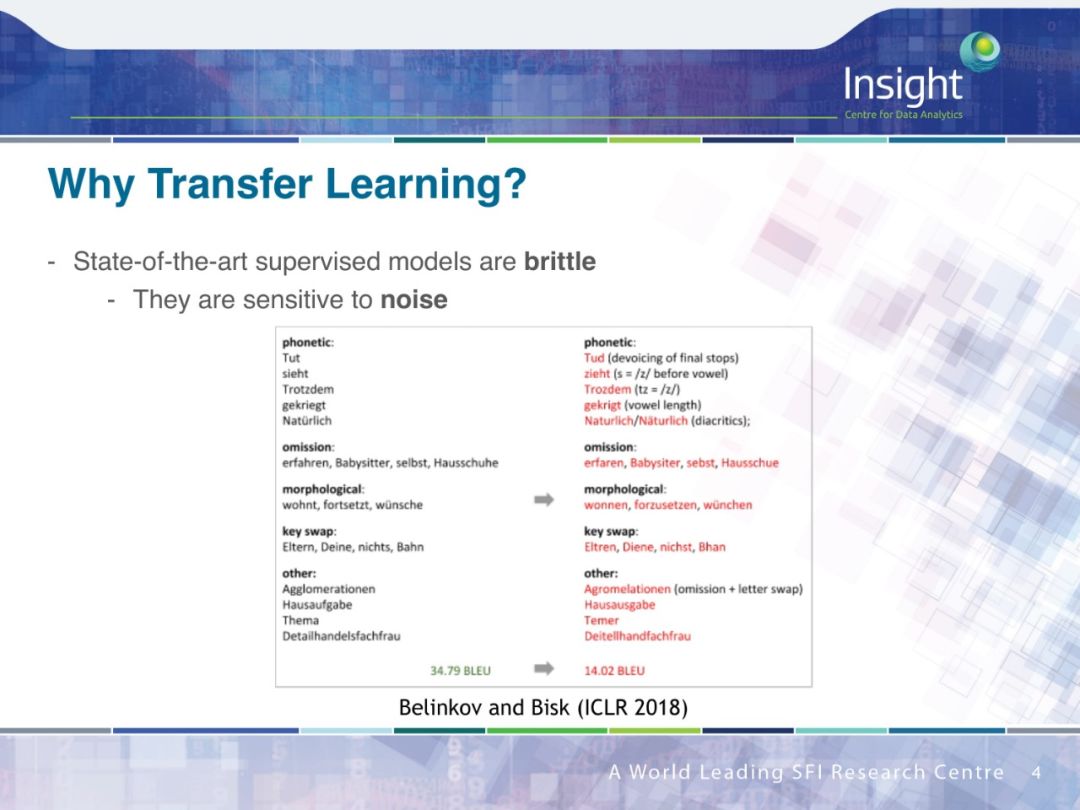

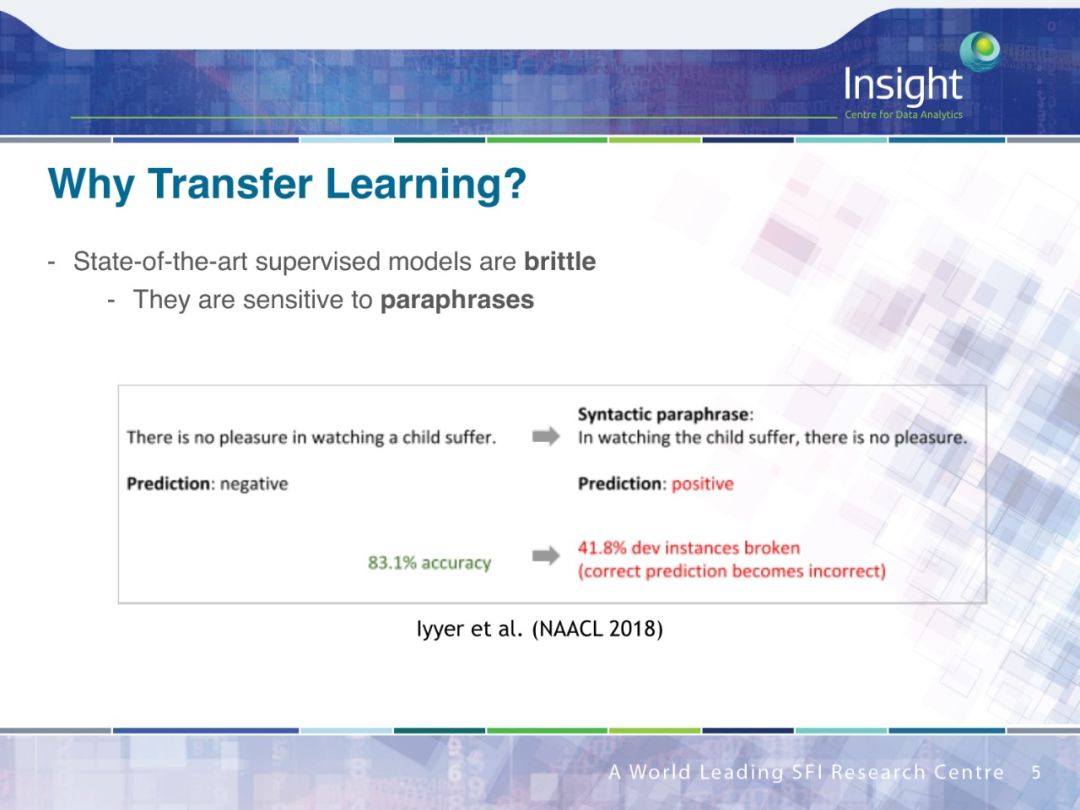

state-of-the-art 的有监督学习算法比较脆弱:

易受到对抗样本的影响

易受到噪音数据的影响

易受到释义的影响

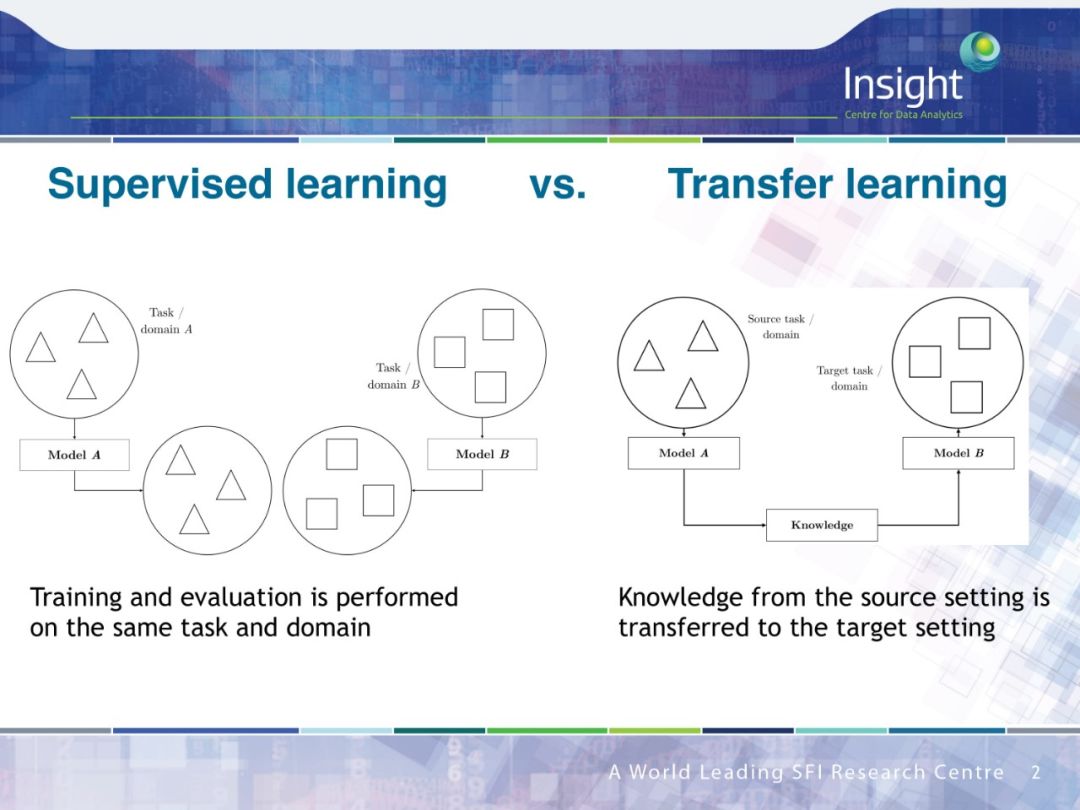

现实中的自然语言处理面临着多领域、多语种上的多种类型的任务,为每个任务都单独进行数据标注是不大可行的,而迁移学习可以将学习的知识迁移到相关的场景下

许多基础的前沿的 NLP 技术都可以被看成是迁移学习:

潜在语义分析 (Latent semantic analysis)

Brown clusters

预训练词向量(Pretrained word embeddings)

已有的迁移学习方法往往有着下面的局限性:

过度约束:预定义的相似度指标,硬参数共享

设置定制化:在一个任务上进行评价,任务级别的共享策略

弱 baseline:缺少和传统方法的对比

脆弱:在领域外表现很差,依赖语种、任务的相似性

低效:需要更多的参数、时间和样本

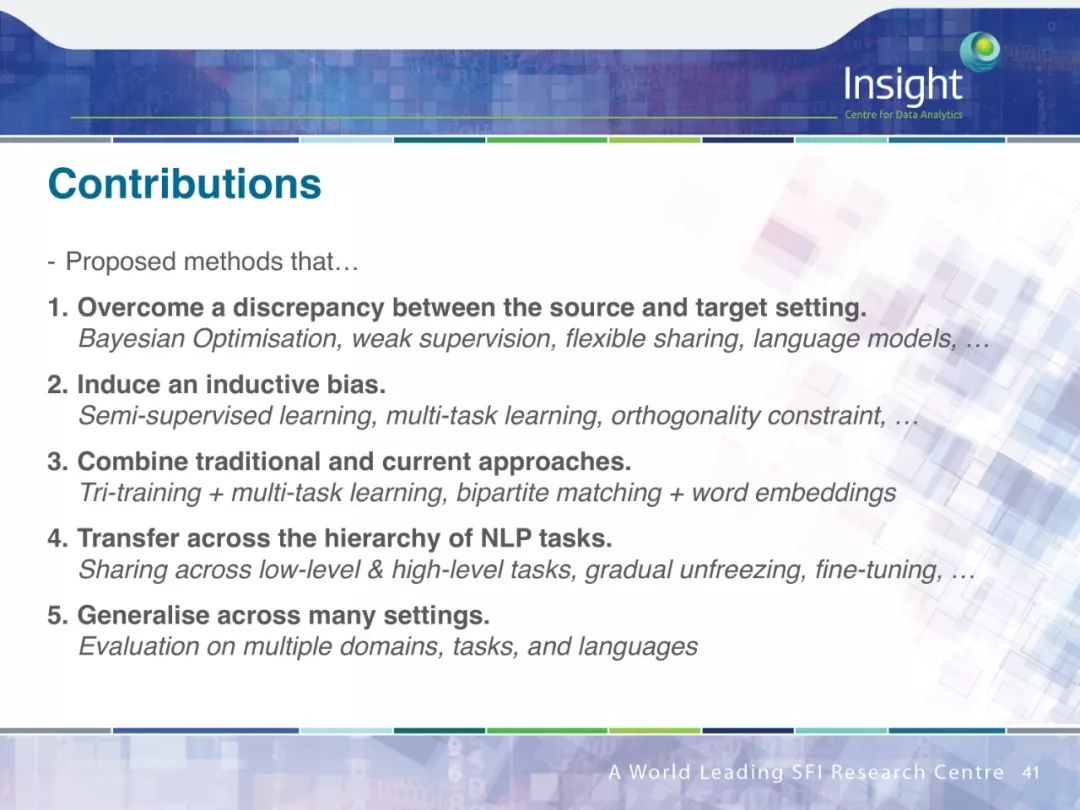

因此,作者认为研究迁移学习需要解决下面的这些问题:

克服源和目标之间的差距

引起归纳偏置

结合传统和现有的方法

在 NLP 任务中跨层次迁移

泛化设置

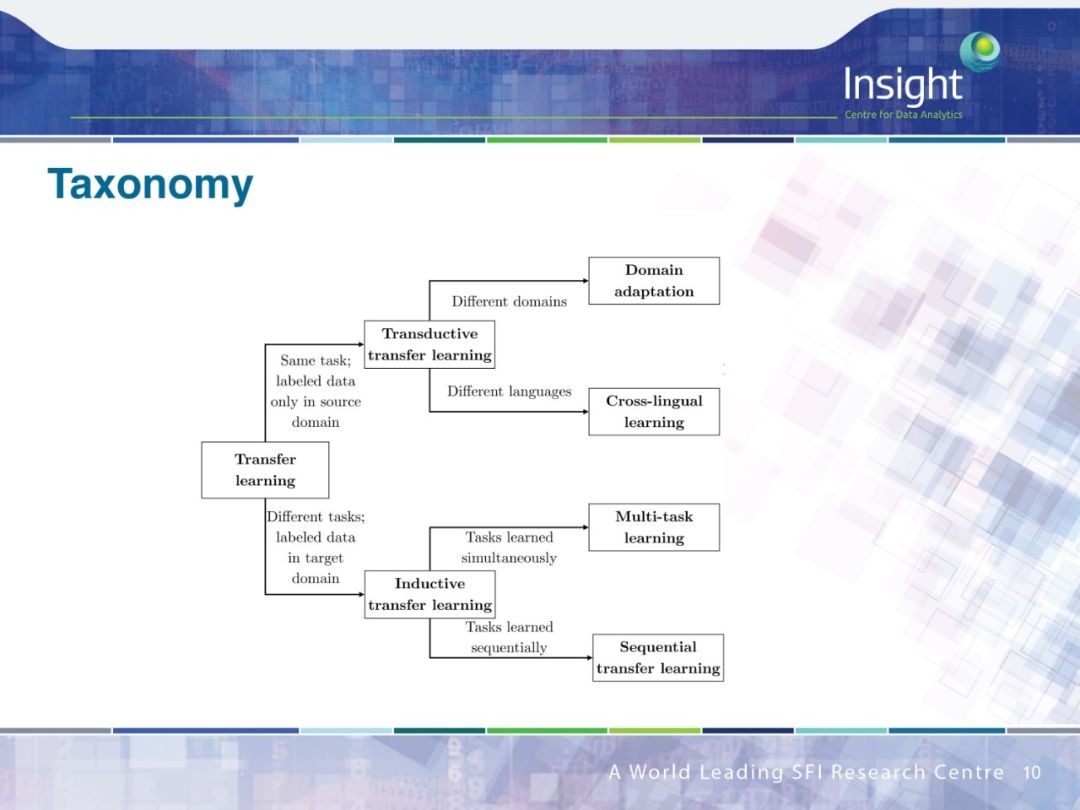

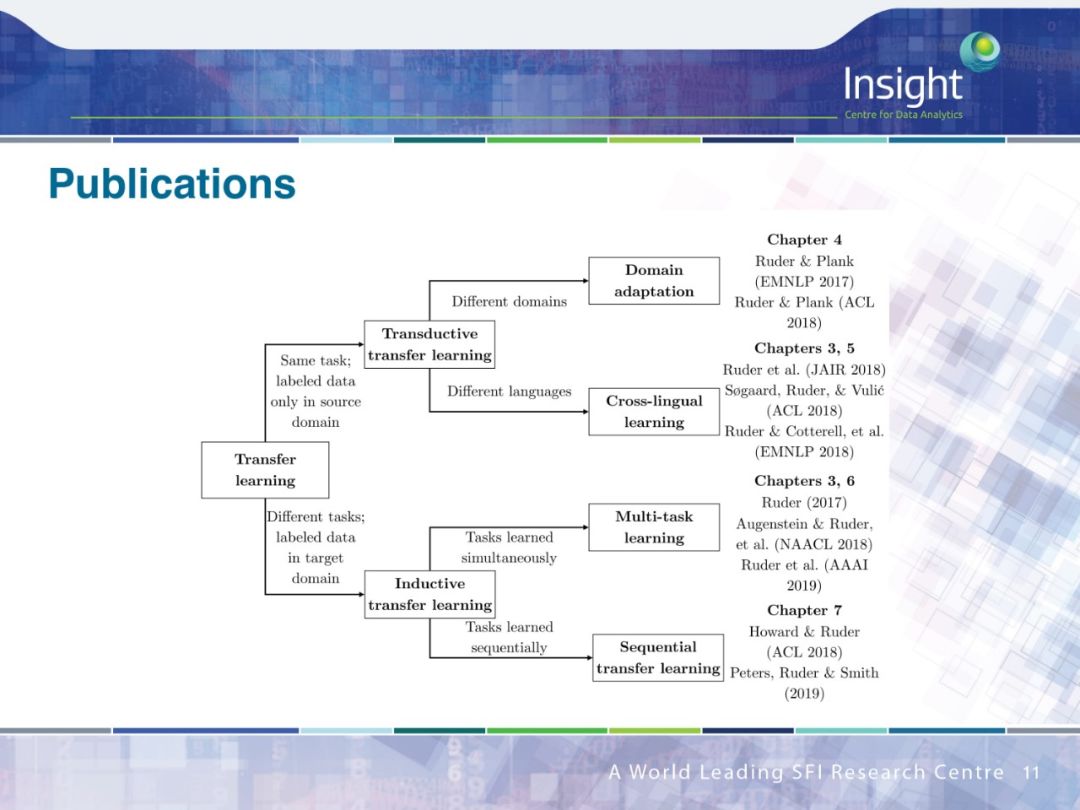

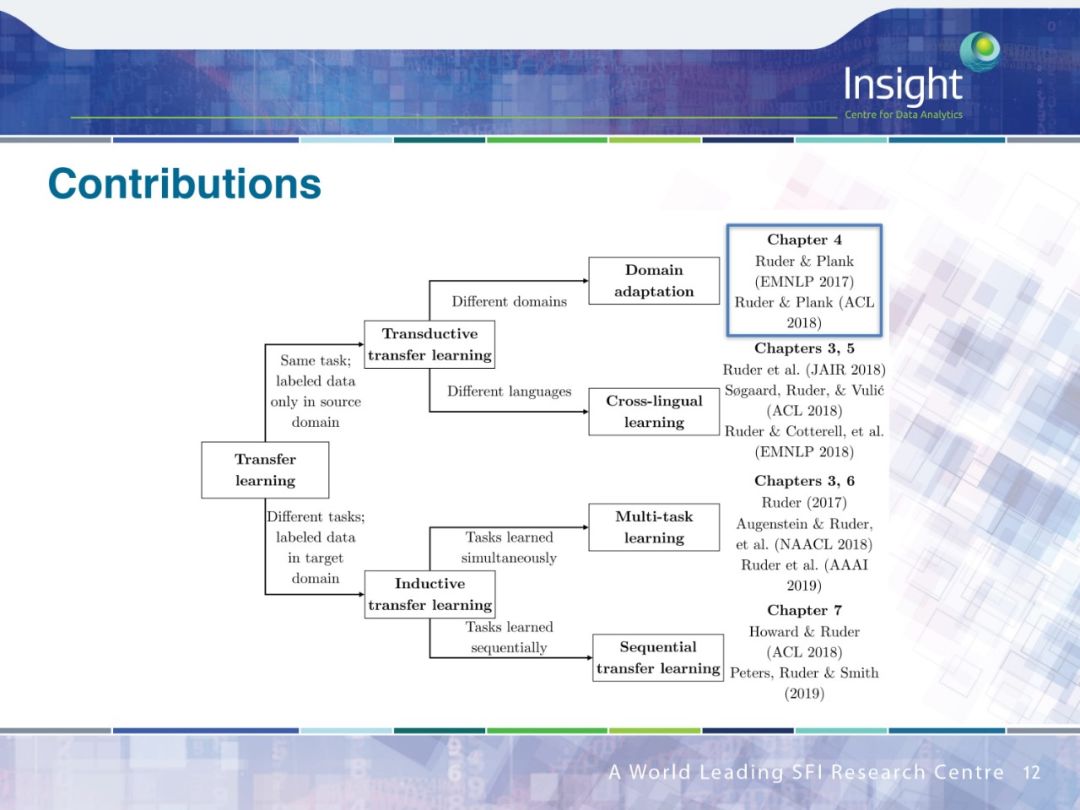

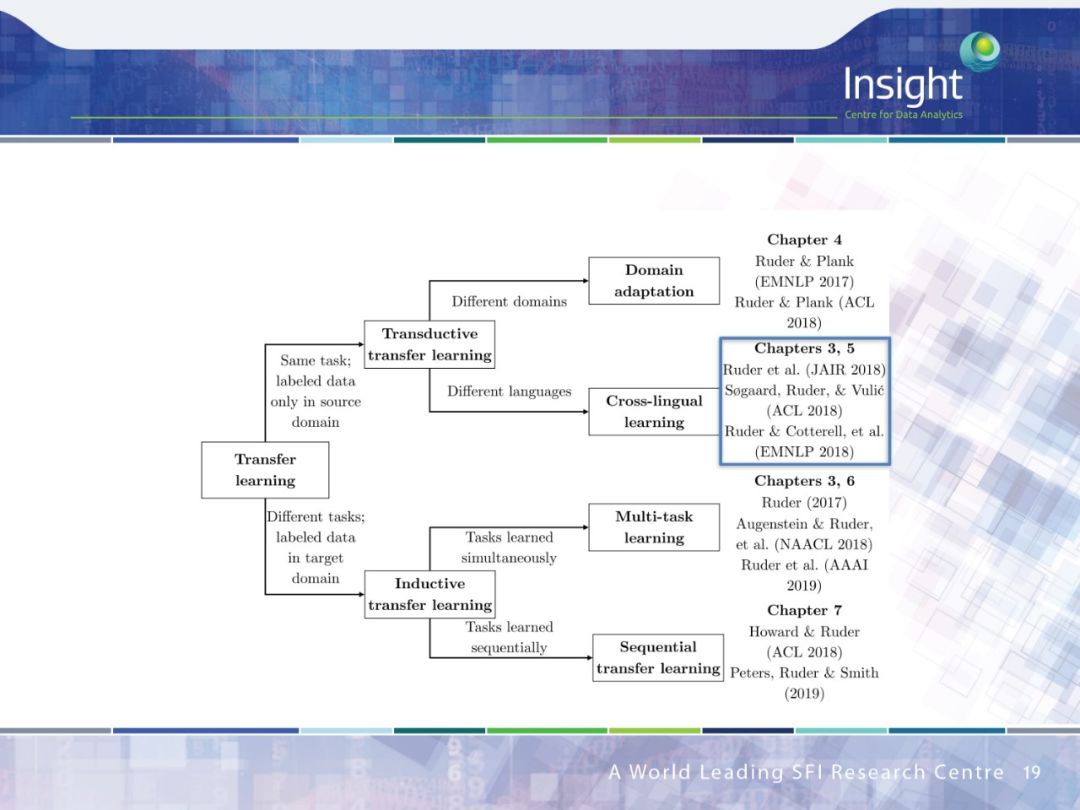

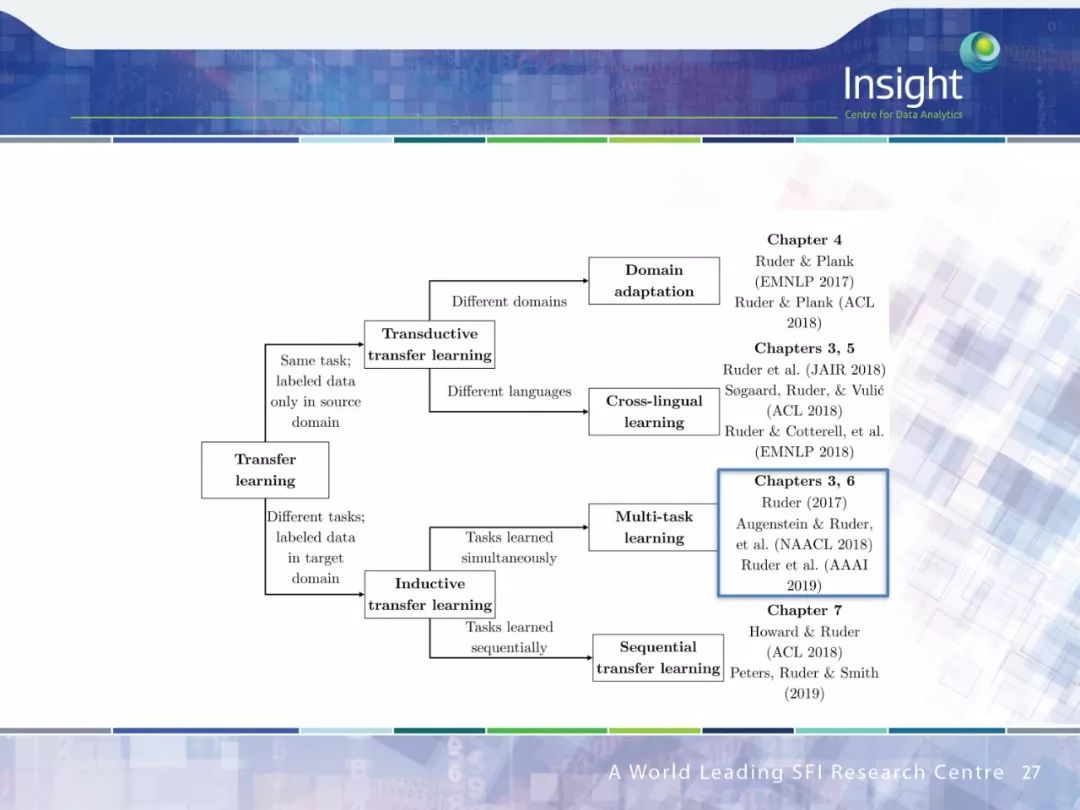

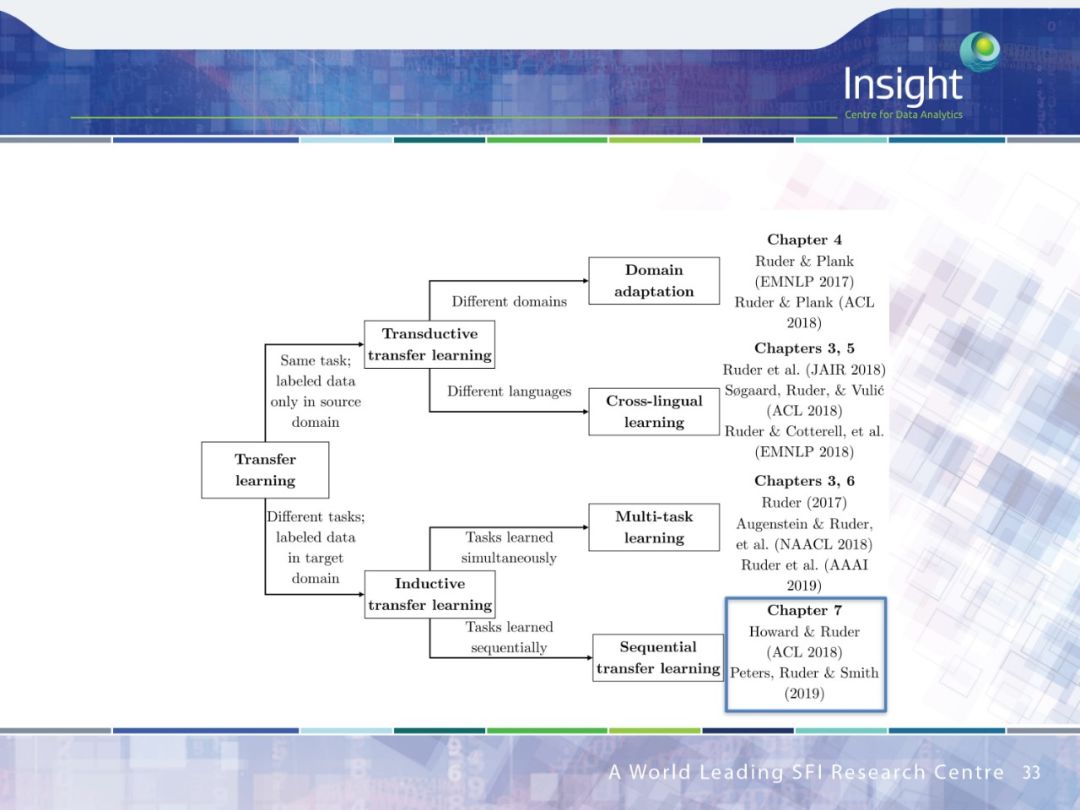

作者围绕迁移学习做了 4 个方面的工作:

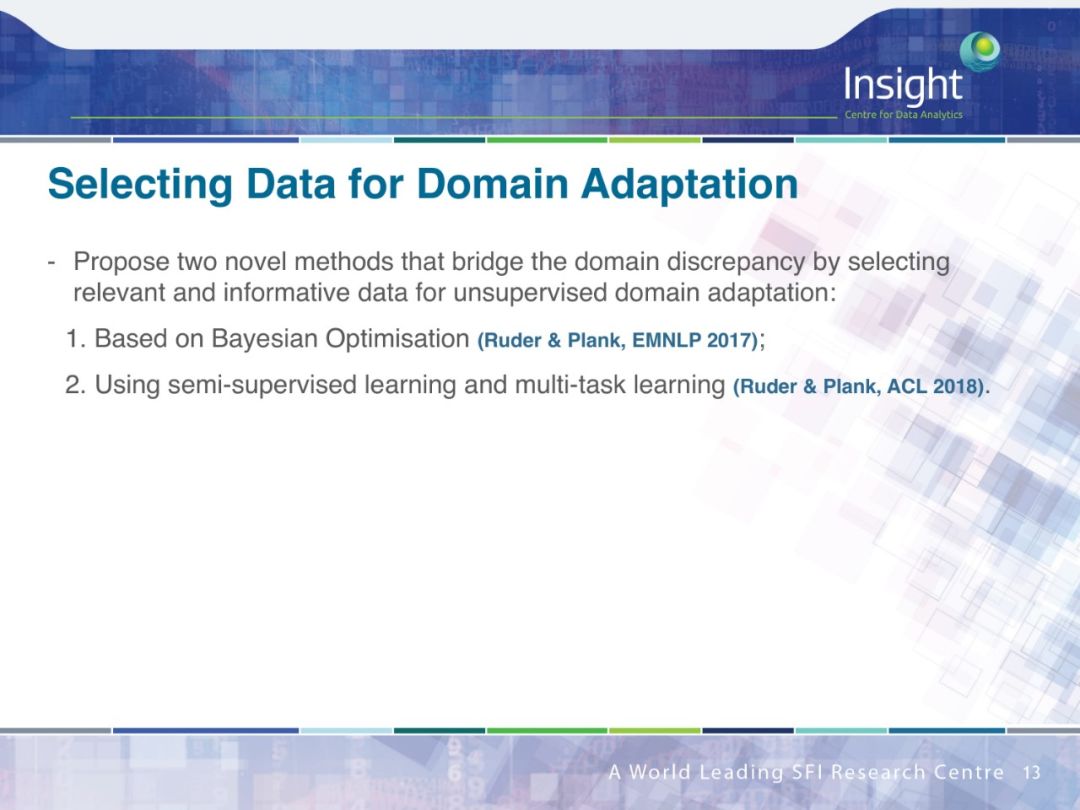

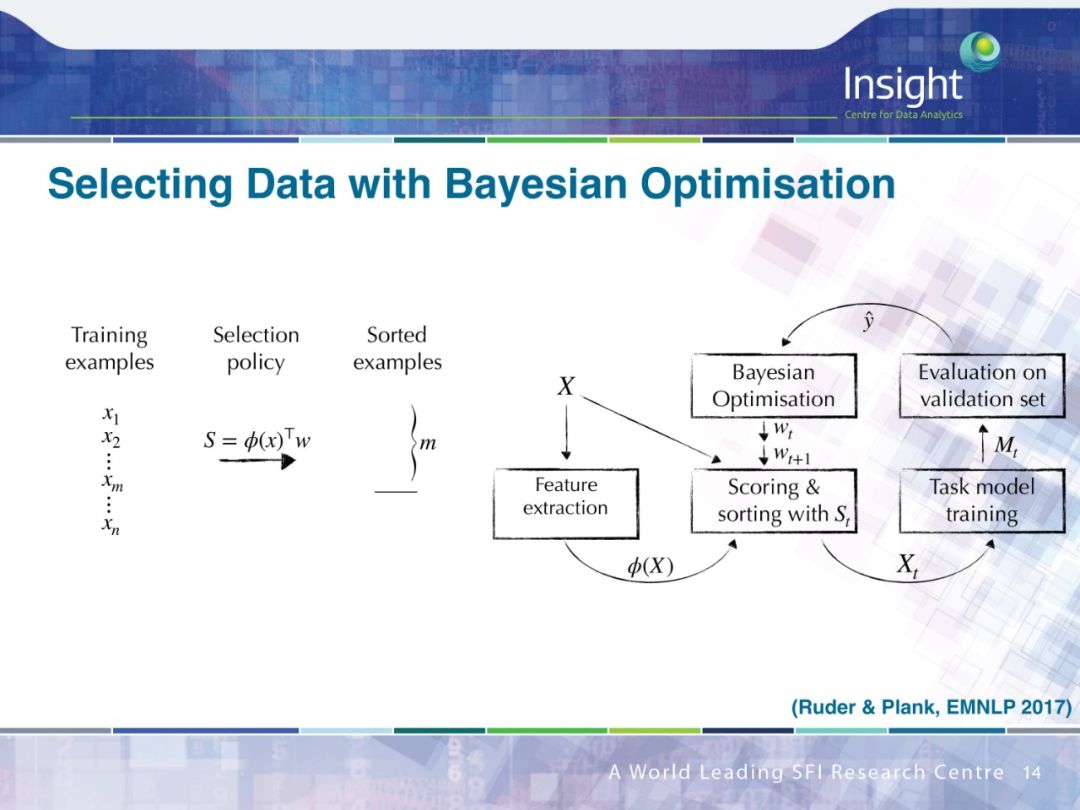

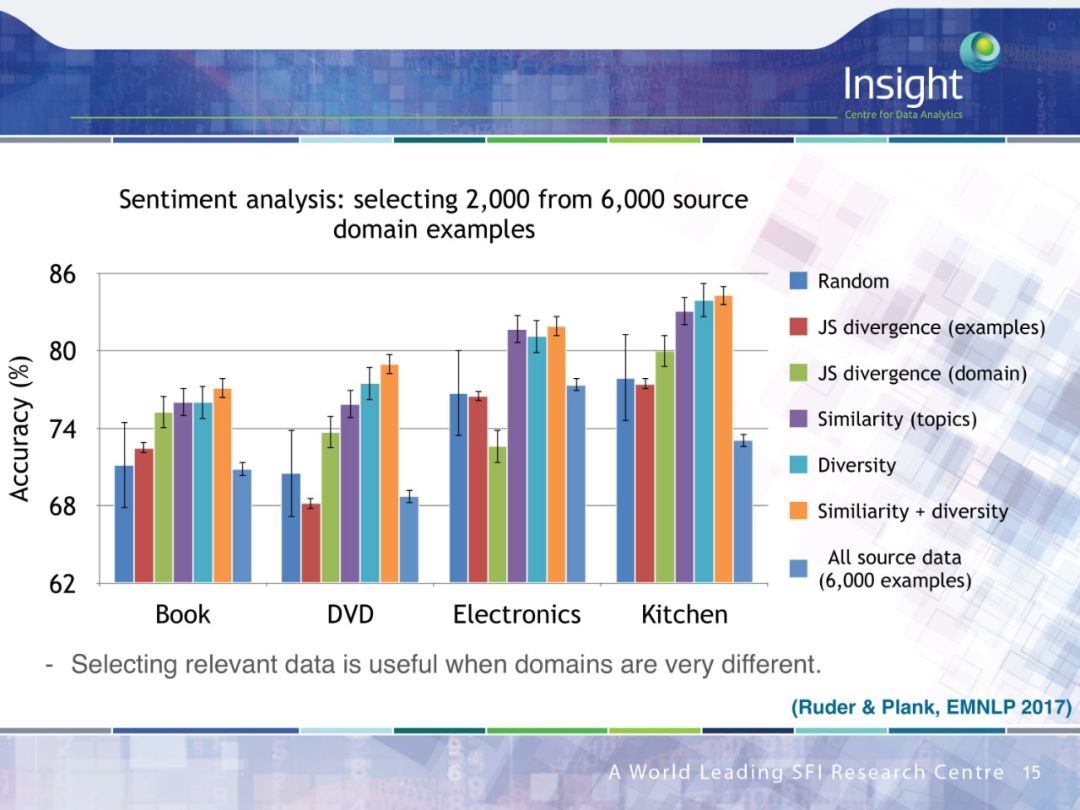

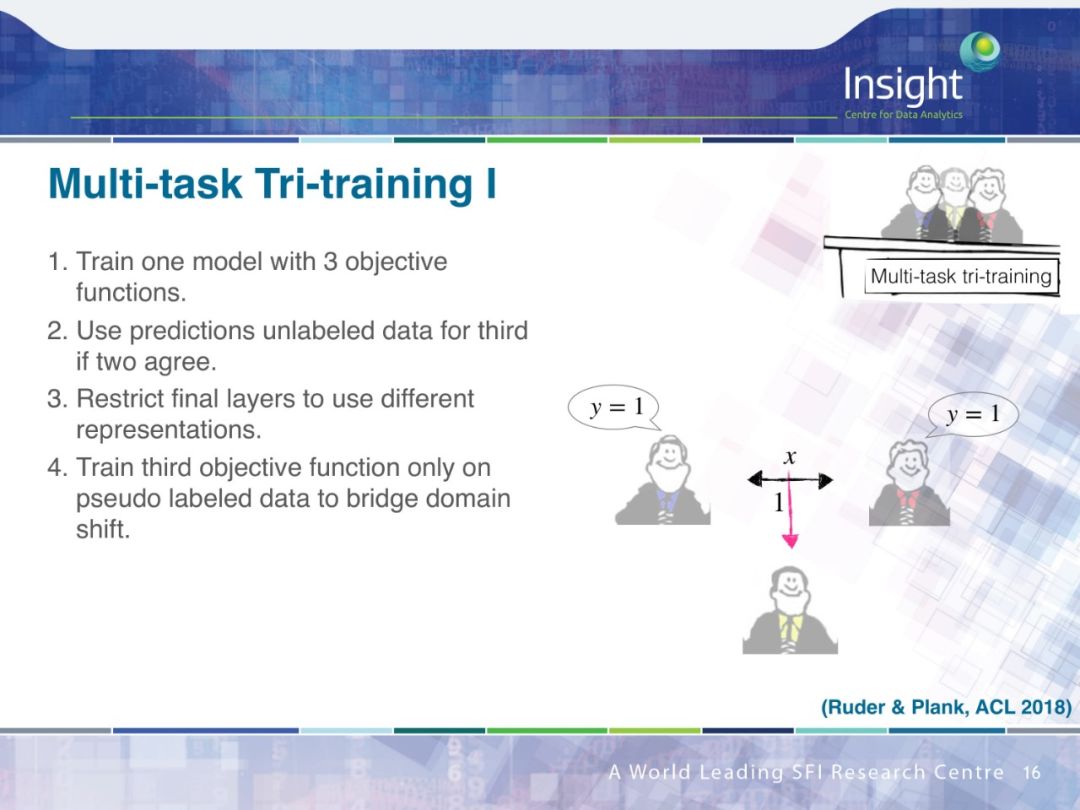

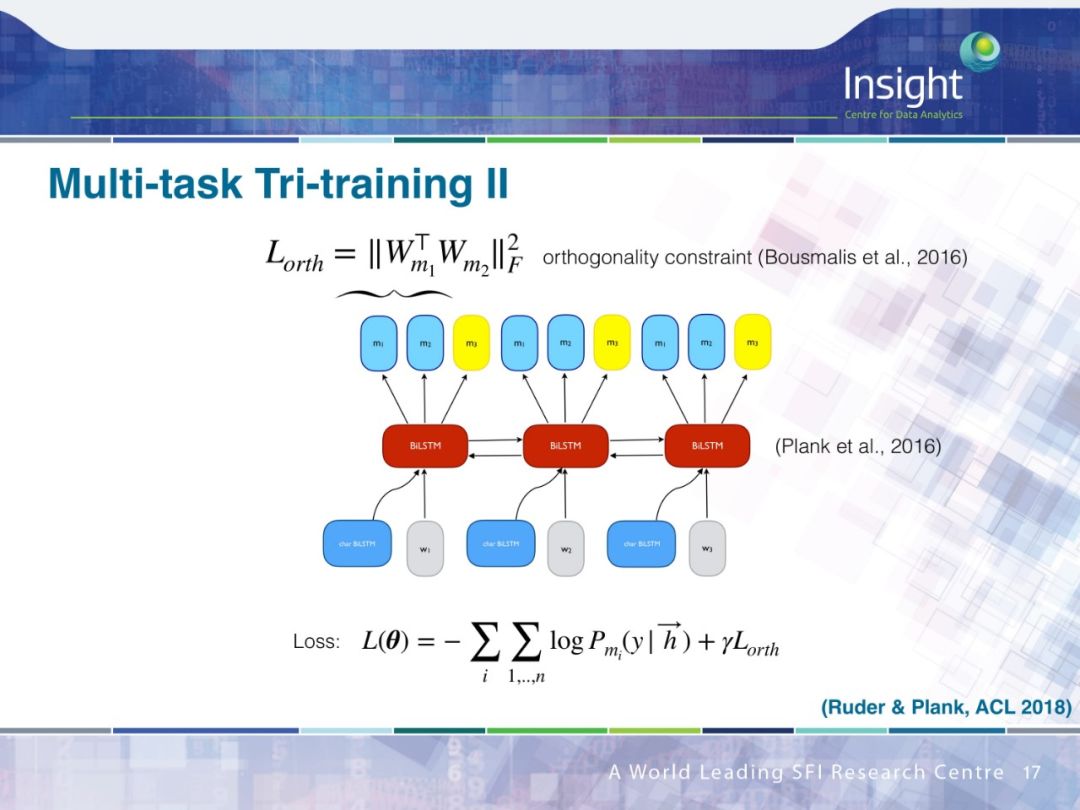

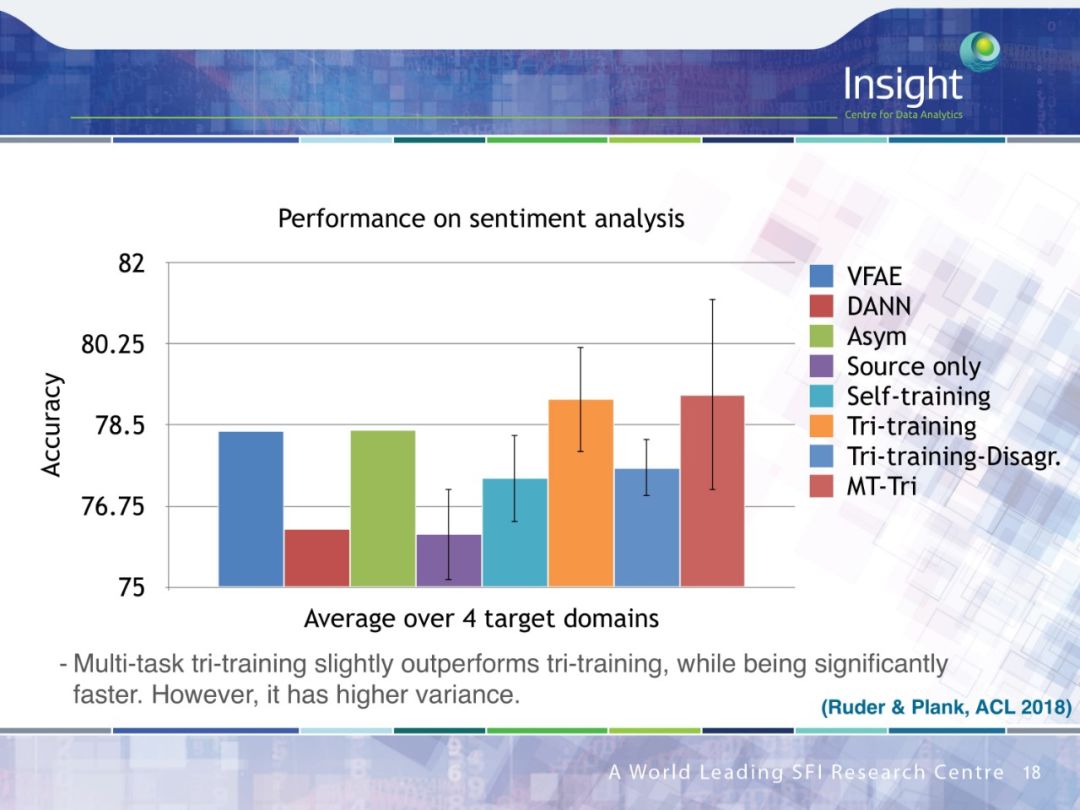

领域适应(Domain Adaption)

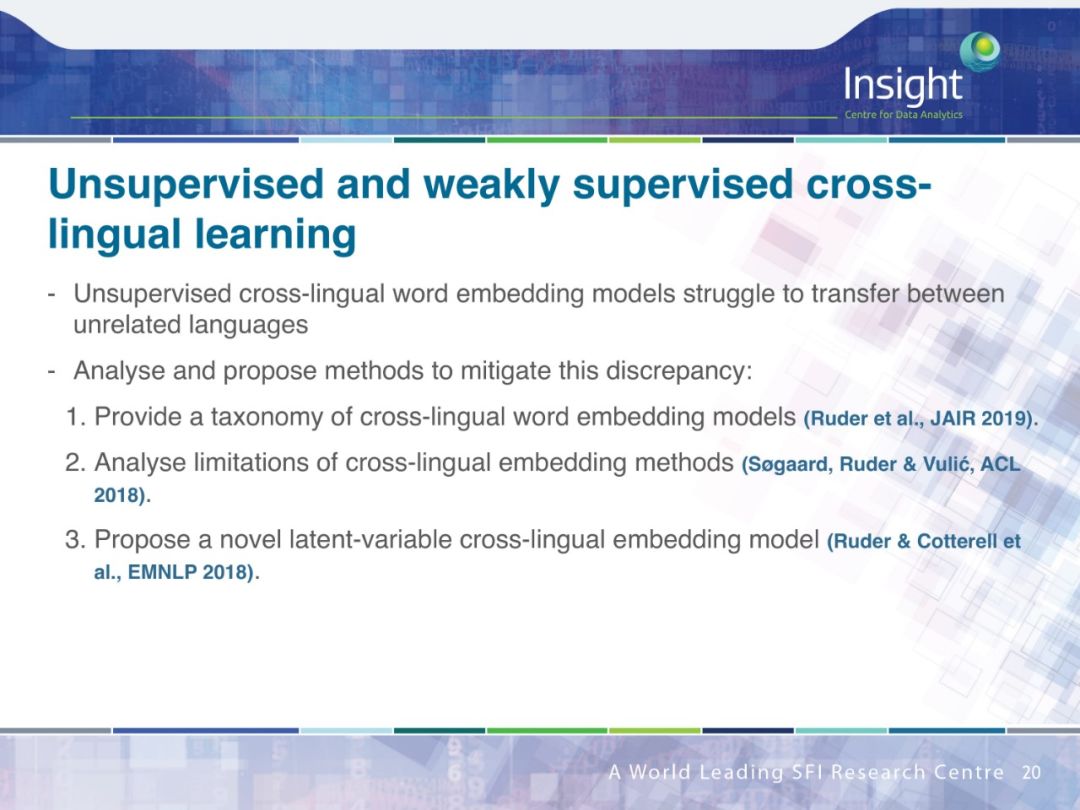

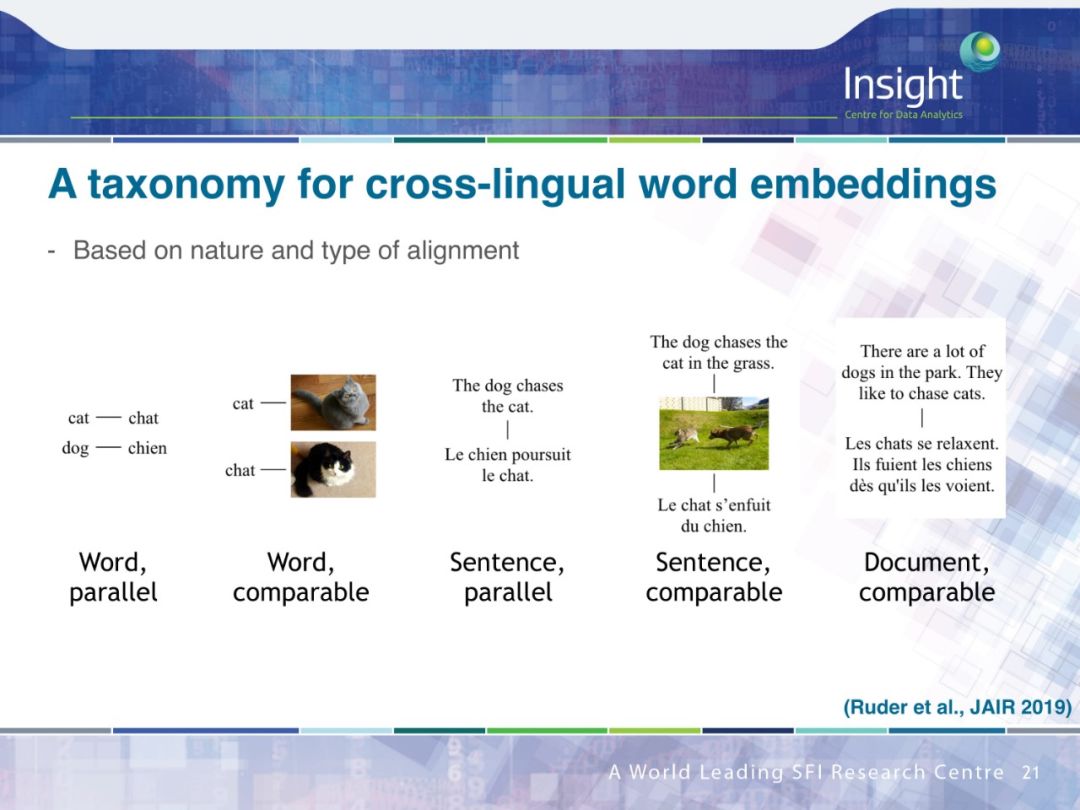

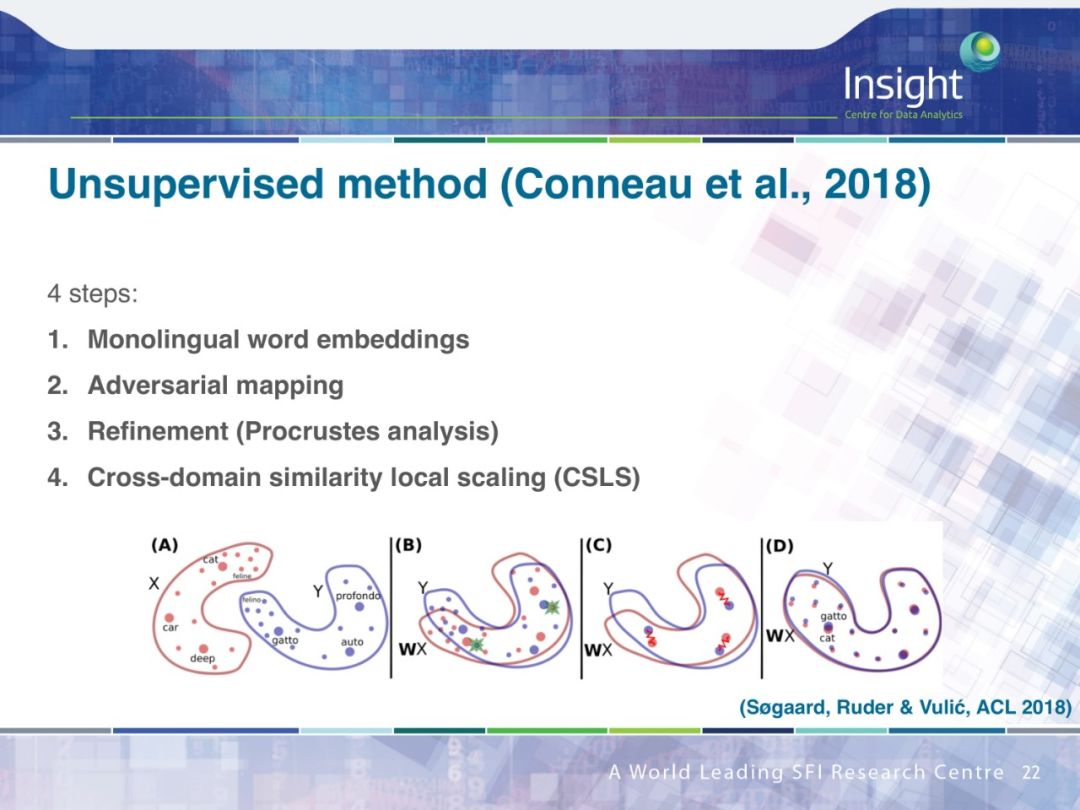

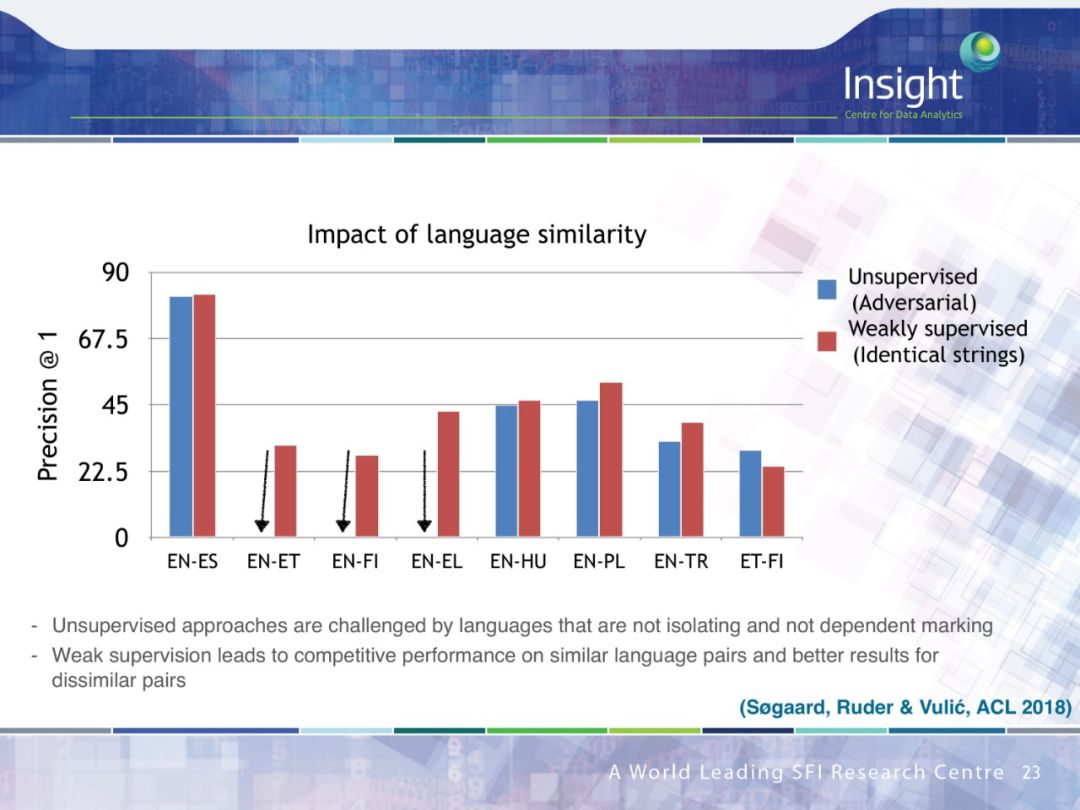

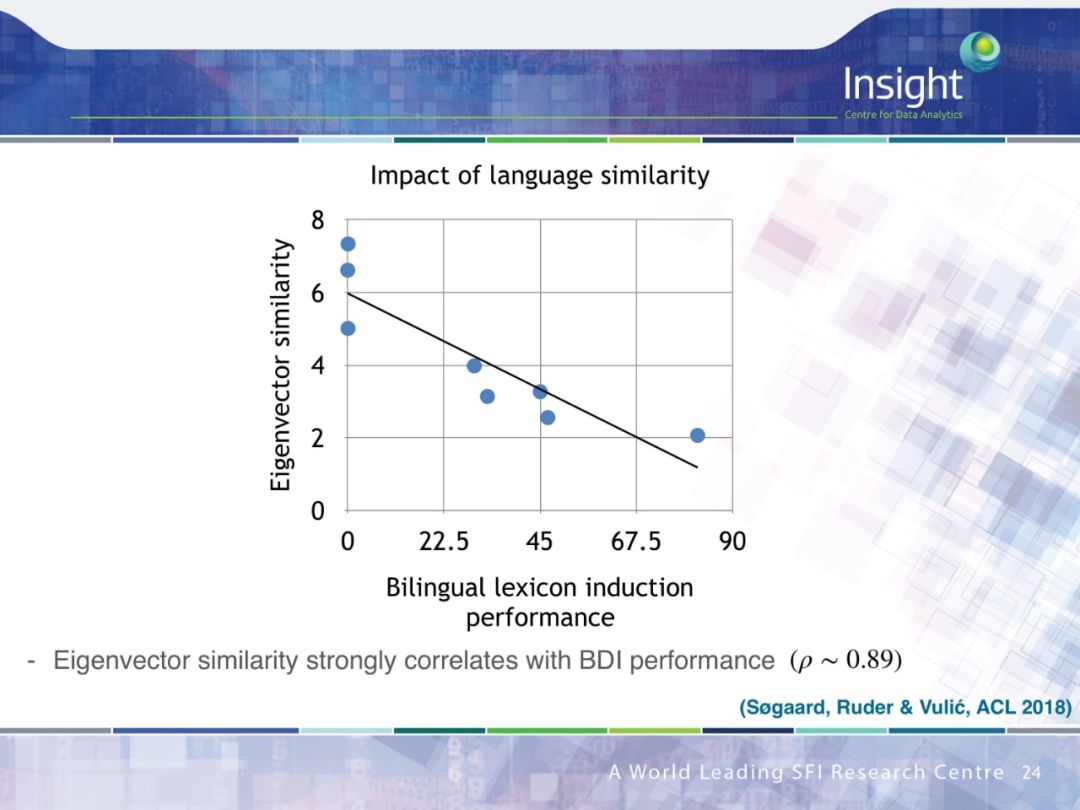

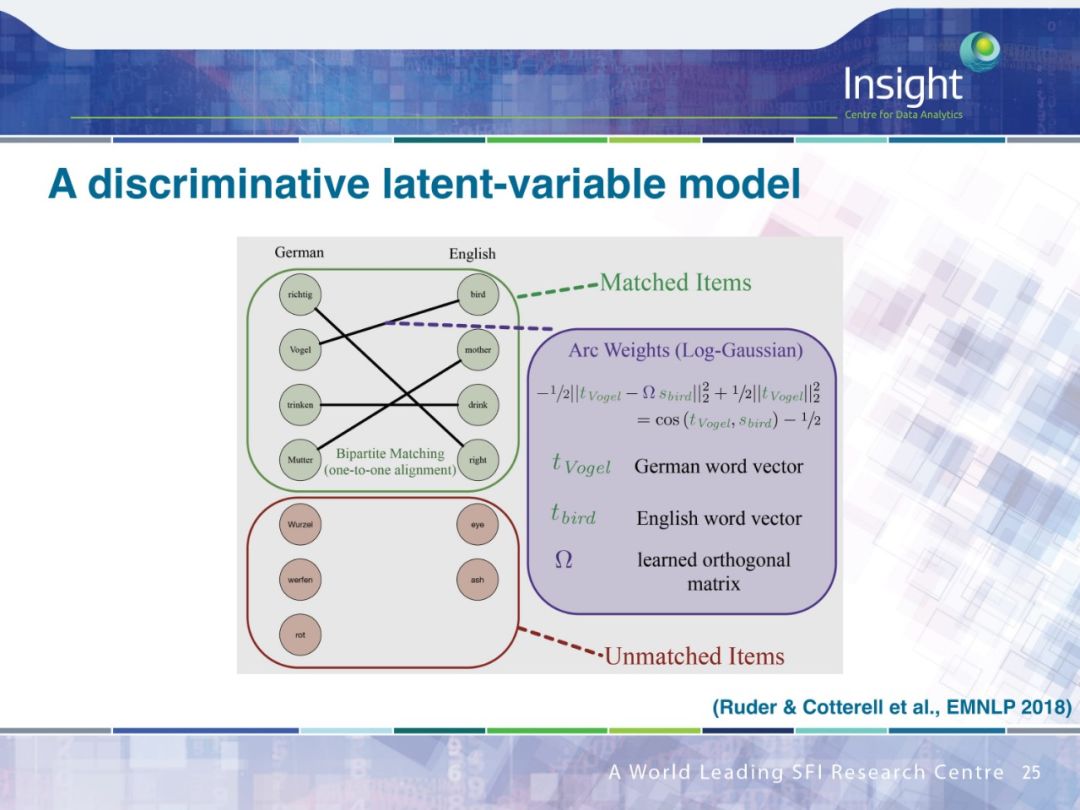

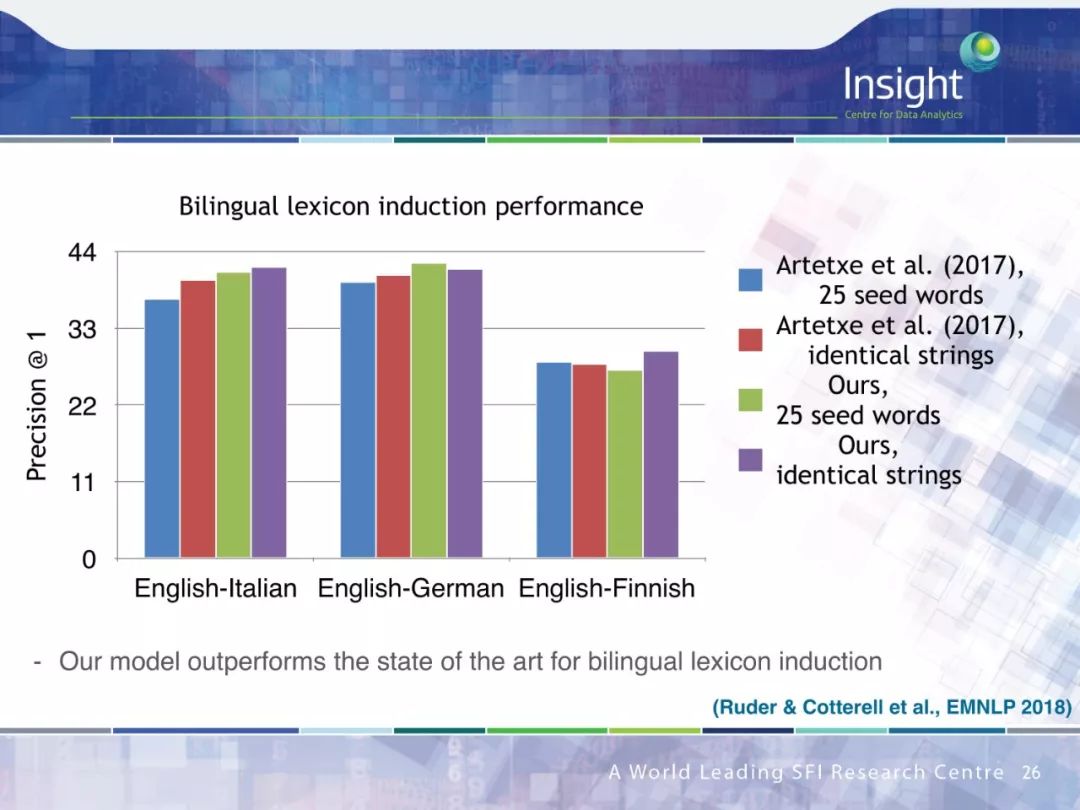

跨语种学习(Cross-lingual learning)

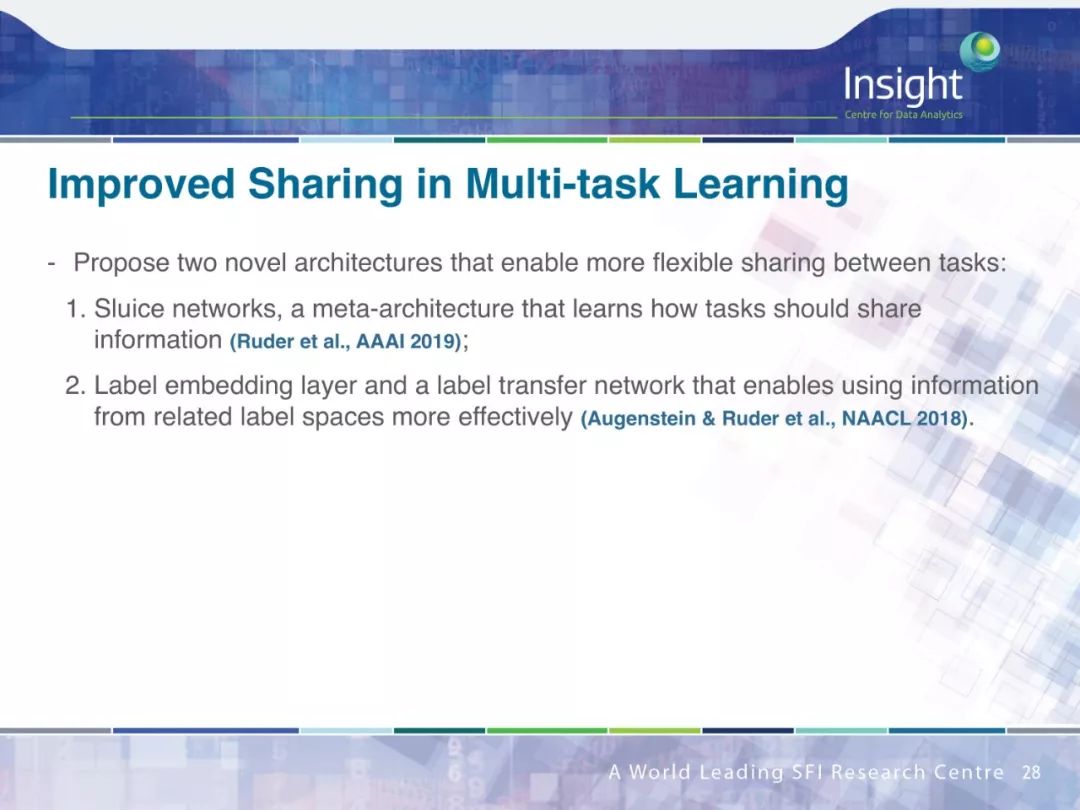

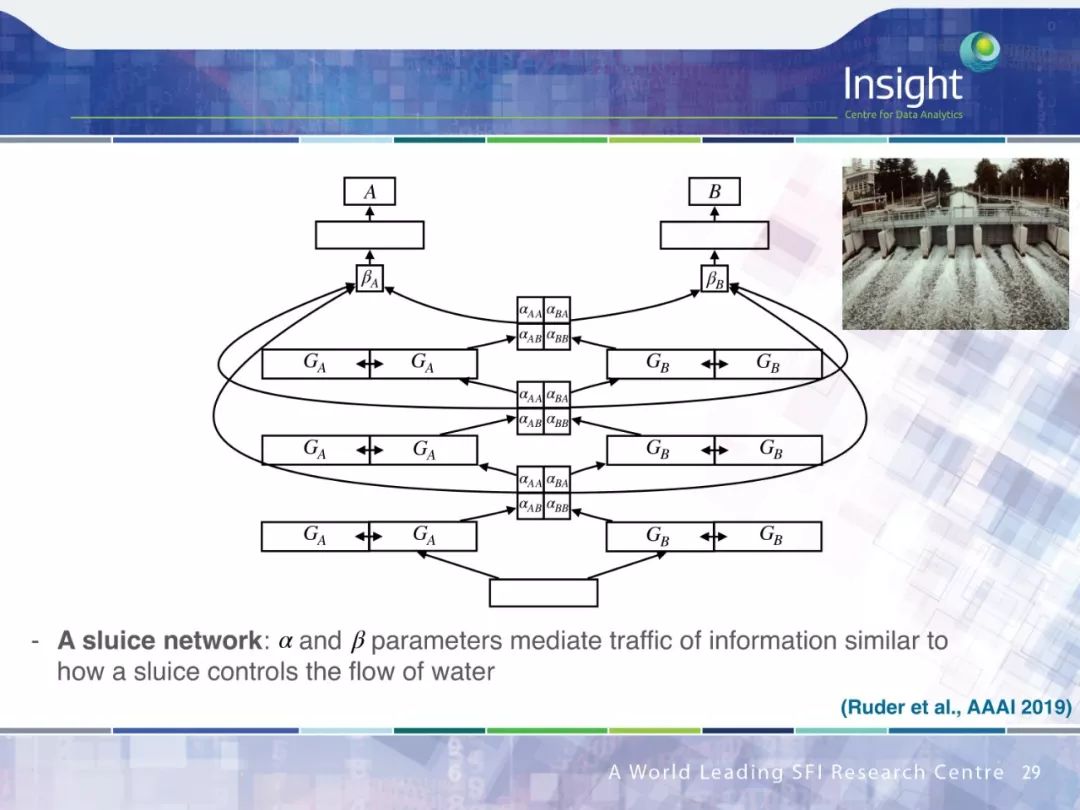

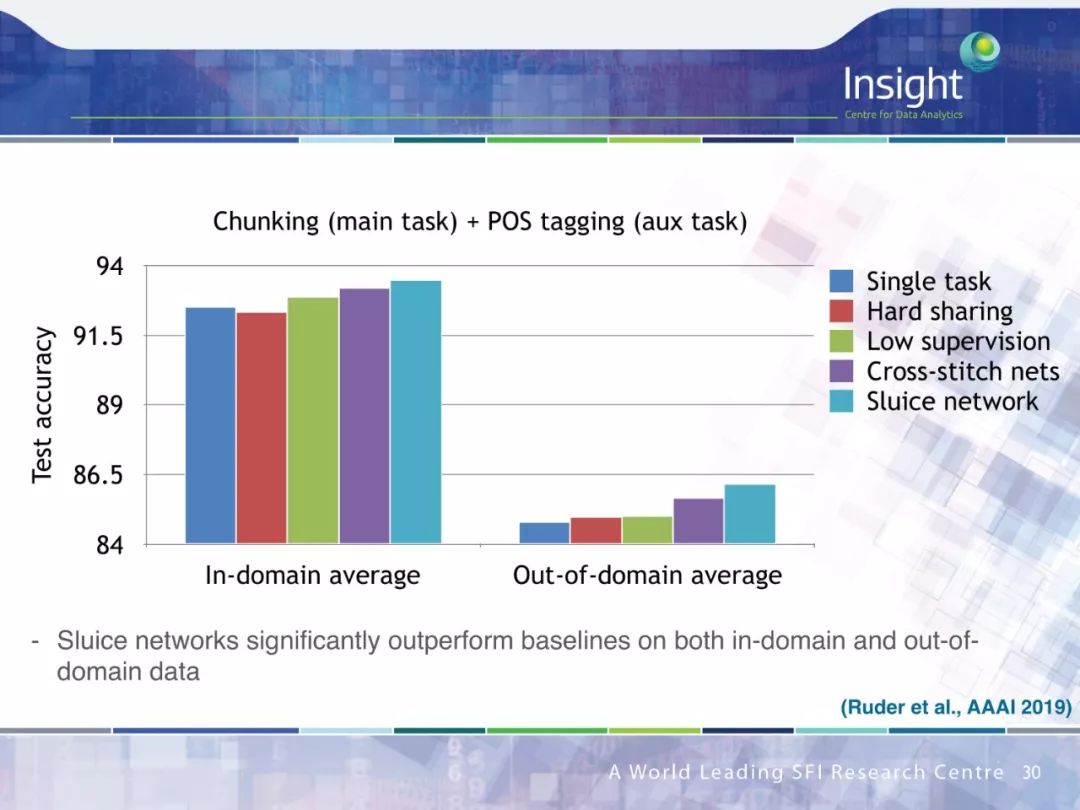

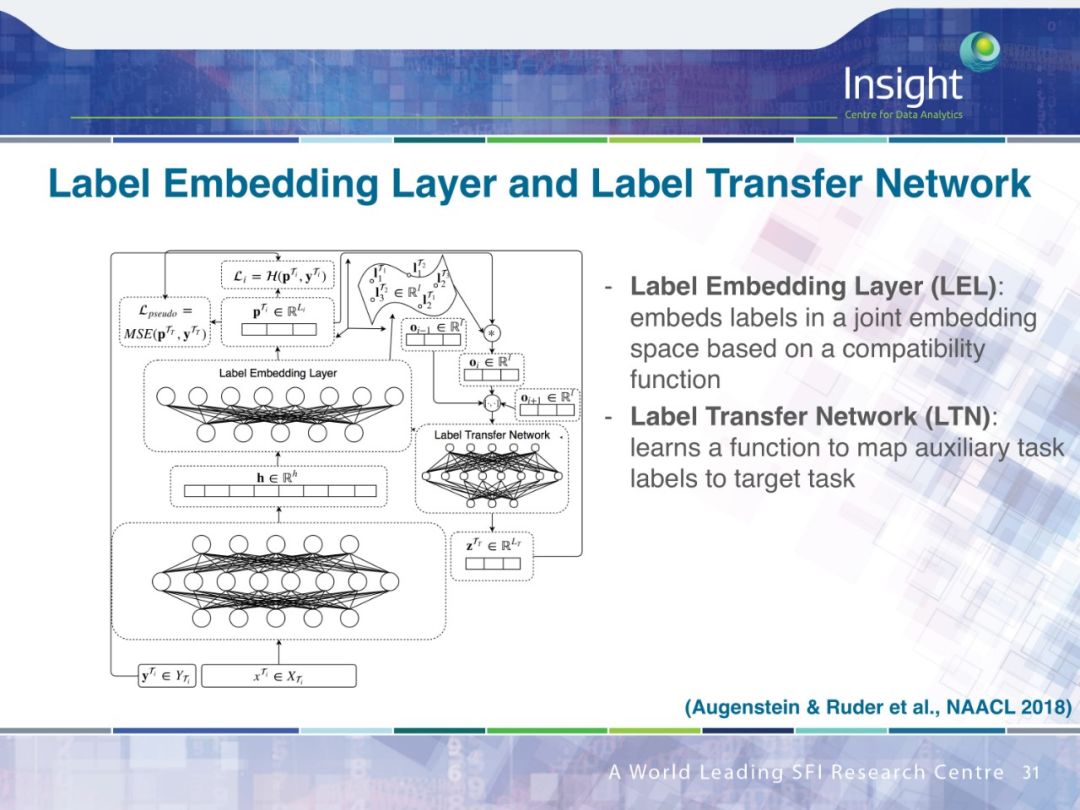

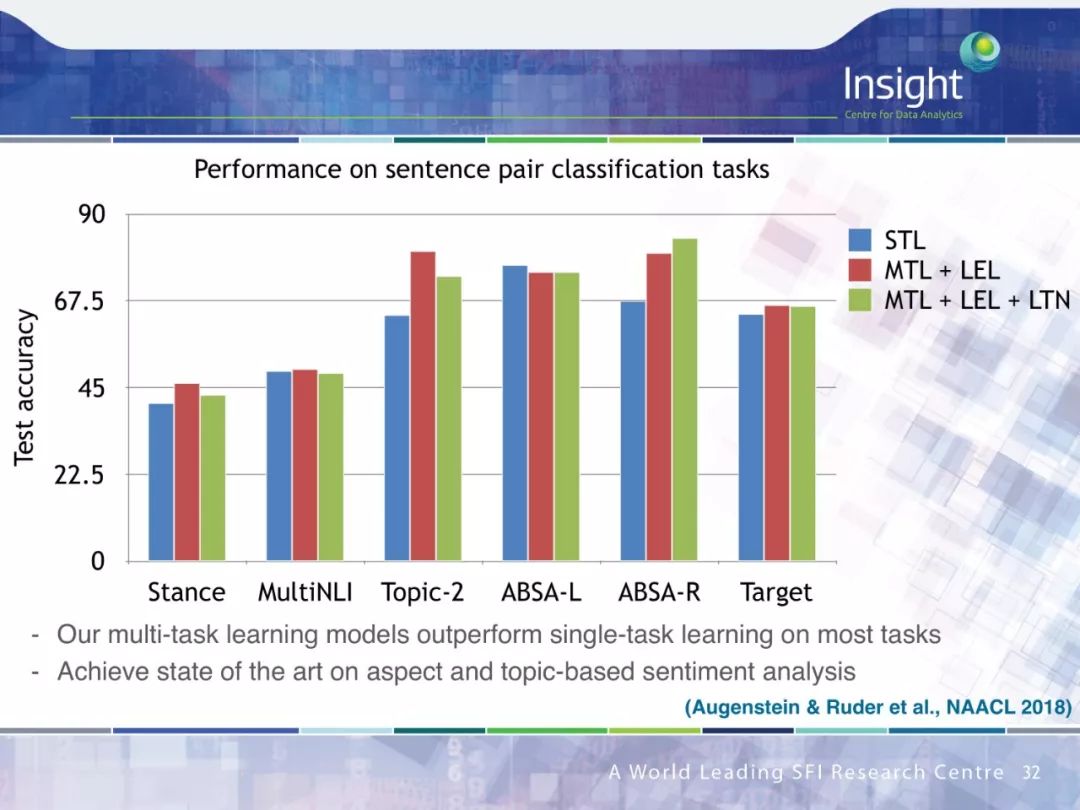

多任务学习(Multi-task learning)

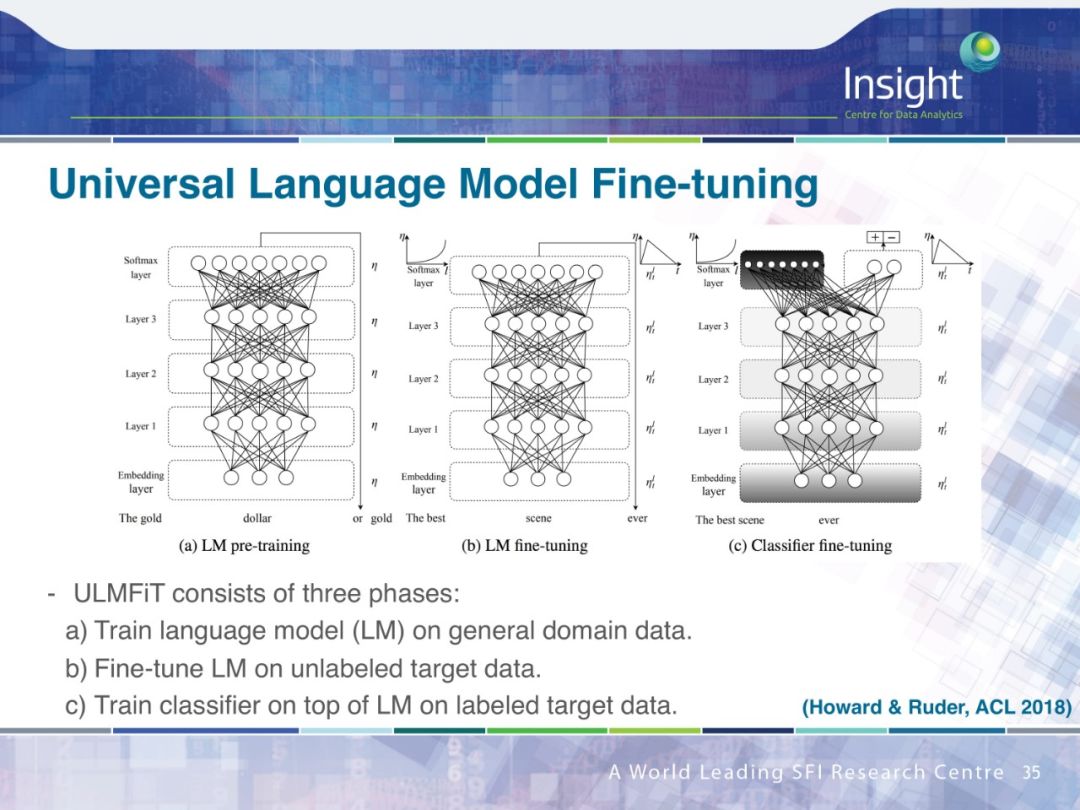

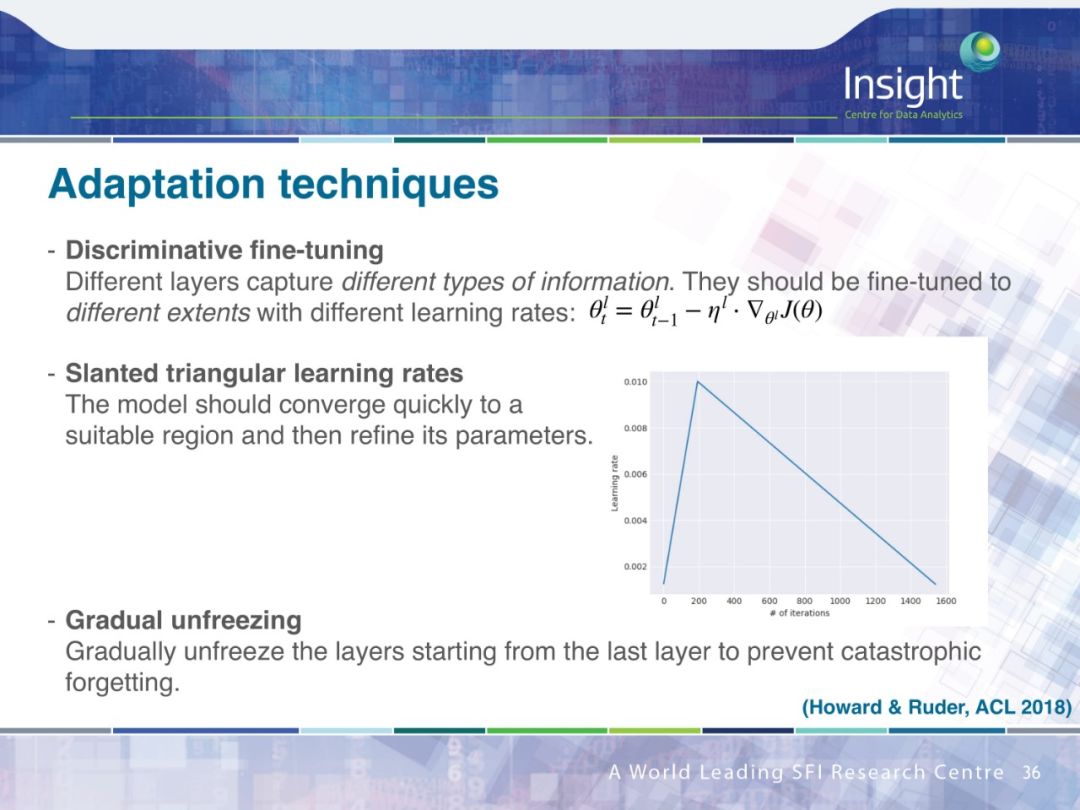

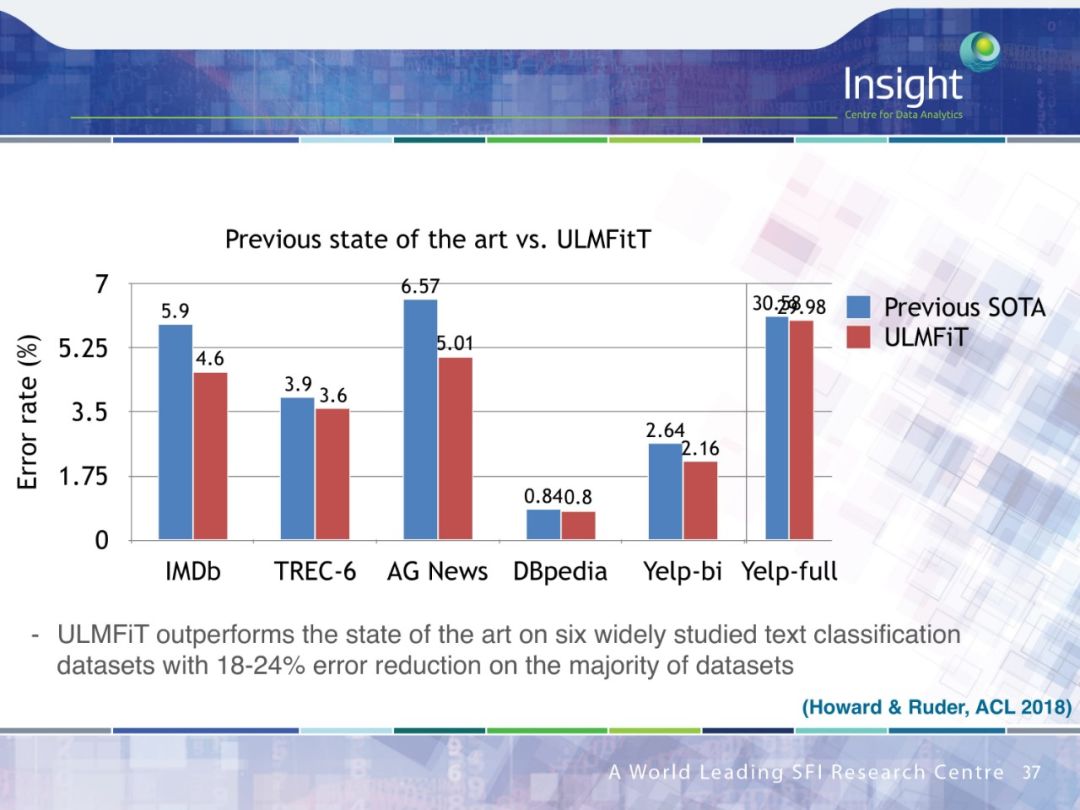

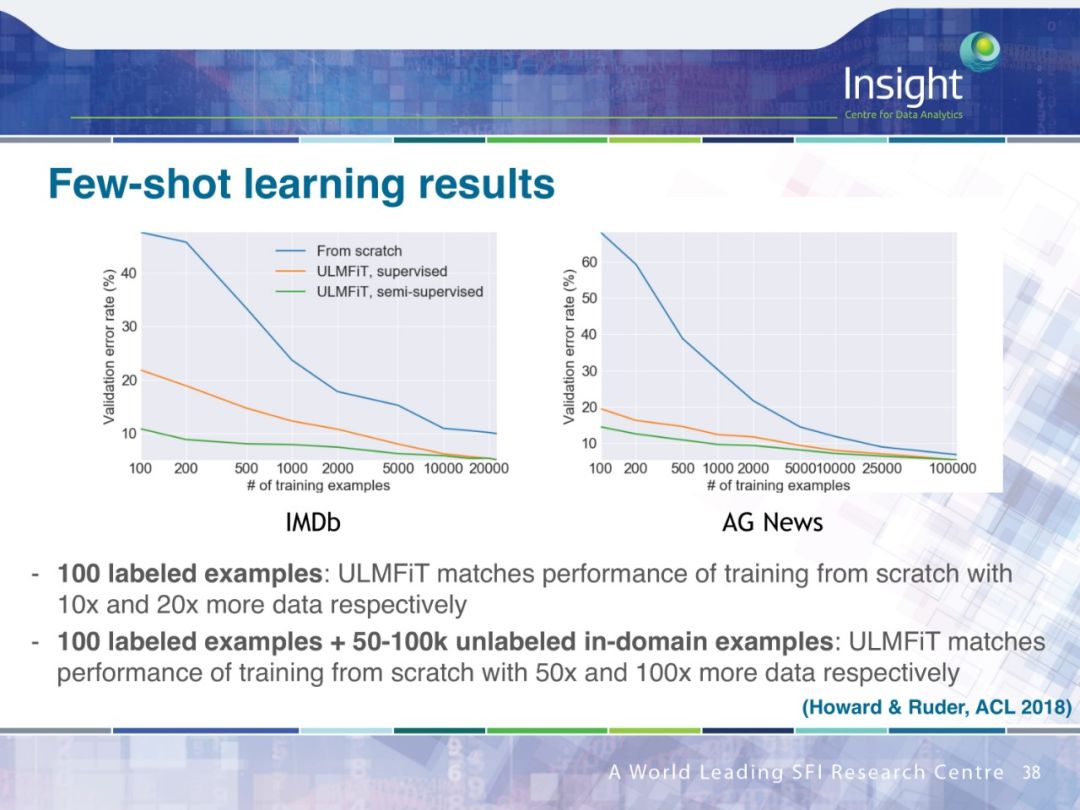

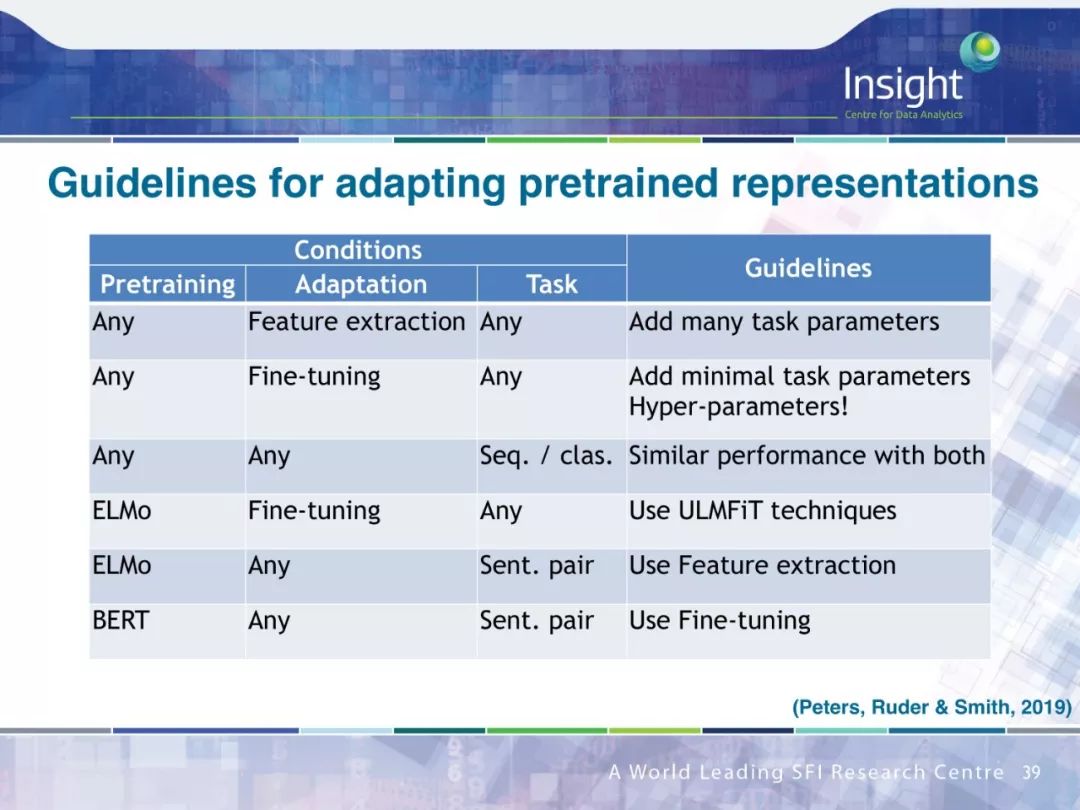

序列迁移学习(Sequential transfer learning)

具体内容可在 Sebastian Ruder 博士的完整答辩 PPT 中查看。

-

神经网络

+关注

关注

42文章

4749浏览量

100438 -

自然语言处理

+关注

关注

1文章

603浏览量

13489 -

nlp

+关注

关注

1文章

486浏览量

21993

原文标题:NLP博士答辩41页PPT,面向自然语言处理的神经网络迁移学习

文章出处:【微信号:AI_era,微信公众号:新智元】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

RNN在自然语言处理中的应用

面向自然语言处理的神经网络迁移学习的答辩PPT

面向自然语言处理的神经网络迁移学习的答辩PPT

评论