动漫《工作细胞》最终话已经更新完毕,这部动漫在 b 站上评分高达 9.7。除了口碑之外,热度也居高不下,更值得关注的是连很多平时不关注动漫的小伙伴也加入了追番大军。这次我们的目标是爬取 b 站上的所有短评进行分析,用数据说明为什么这部动漫会如此受欢迎。

一、工作细胞

《工作细胞》改编自清水茜老师的同名漫画,由 David Production 制作。众所周知,日本 ACG 作品向来信奉着“万物皆可萌”的原则。前有《黑塔利亚》,后有《舰队Collection》和《兽娘动物园》,分别讲述了将国家,战舰和动物拟人化后的故事。而在《工作细胞》里拟人的对象则轮到了我们的细胞。

这是一个发生在人体内的故事:人的细胞数量,约为37兆2千亿个。其中包括了我们的女主角:一个副业是运输氧气,主业是迷路的红血球。

男主角:一个作者懒得涂色但武力值 max 的白血球。两人一见面就并肩战斗,分别的时候更是满天粉红气泡。

虽然嘴上说着:不会,我只是千千万万个白细胞中的一员。身体却很诚实,从第一集偶遇女主到最后一集,每一集都充满了狗粮的味道。37兆分之一的缘分果然妙不可言。

除了男女主角,配角们的人气也都很高。连反派 boss 癌细胞都有人喜欢,主要还是因为身世感人+脸长得好。当然人气最!最!最!高的还是我们奶声奶气的血小板。

据宅男们反映:“看了这么多番。只有这一部的老婆是大家真正拥有的。”不仅有,还有很多。除了新颖的科普形式,这部番令人感触最深的是:我们每一个人都不是孤独的个体,有37兆个只属于我们的细胞和我们一同工作不息。每当颓唐和失意的时候,为了那些为了保护你而战斗不止的免疫细胞,为了萌萌的老婆们也要振作起来啊。

《工作细胞》的成功并不是一个偶然,而是众多因素共同作用的结果。下面从数据的角度分析它成为今年7月播放冠军的原因。

谢谢宇哥对这部分的贡献,显然超出我的能力范围!

二、爬虫

首先要做的是爬取 b 站的所有短评,包括评论用户名、评论时间、星级(评分)、评论内容、点赞数等内容,本部分内容为爬虫代码的说明,不感兴趣的读者可以直接跳过,阅读下一部分的分析。

爬的过程写了很久,b站短评不需要登陆直接就可以爬,刚开始用类似之前爬豆瓣的方法,用 Selenium+xpath 定位爬

但 b 站短评用这种方法并不好处理。网站每次最多显示 20 条短评,滚动条移动到最下面才会加载之后的 20 条,所以刚开始用了每次爬完之后将定位到当前爬的位置的方法,这样定位到当前加载的最后一条时,就会加载之后的 20 条短评。

逻辑上是解决了这个问题,但真的爬的时候就出现了问题,一个是爬的慢,20条需要十来秒的样子,这个没关系,大不了爬几个小时,但问题是辛辛苦苦爬了两千多条之后,就自动断了,不知道是什么原因,虽然之前爬的数据都存下来了,但没法接着断开的地方接着爬,又要重新开始,还不知道会不会又突然断,所以用这种方法基本就无解了。代码附在下面,虽然是失败的,但也可以爬一些评论下来,供参考。

1#-*-coding:utf-8-*- 2""" 3CreatedonMonSep1019:36:242018 4""" 5fromseleniumimportwebdriver 6importpandasaspd 7fromdatetimeimportdatetime 8importnumpyasnp 9importtime10importos1112os.chdir('F:\python_study\pachong\工作细胞')13defgethtml(url):1415browser=webdriver.PhantomJS()16browser.get(url)17browser.implicitly_wait(10)18return(browser)1920defgetComment(url):2122browser=gethtml(url)23i=124AllArticle=pd.DataFrame(columns=['id','author','comment','stars1','stars2','stars3','stars4','stars5','unlike','like'])25print('连接成功,开始爬取数据')26whileTrue:2728xpath1='//*[@id="app"]/div[2]/div[2]/div/div[1]/div/div/div[4]/div/div/ul/li[{}]'.format(i)29try:30target=browser.find_element_by_xpath(xpath1)31except:32print('全部爬完')33break3435author=target.find_element_by_xpath('div[1]/div[2]').text36comment=target.find_element_by_xpath('div[2]/div').text37stars1=target.find_element_by_xpath('div[1]/div[3]/span/i[1]').get_attribute('class')38stars2=target.find_element_by_xpath('div[1]/div[3]/span/i[2]').get_attribute('class')39stars3=target.find_element_by_xpath('div[1]/div[3]/span/i[3]').get_attribute('class')40stars4=target.find_element_by_xpath('div[1]/div[3]/span/i[4]').get_attribute('class')41stars5=target.find_element_by_xpath('div[1]/div[3]/span/i[5]').get_attribute('class')42date=target.find_element_by_xpath('div[1]/div[4]').text43like=target.find_element_by_xpath('div[3]/div[1]').text44unlike=target.find_element_by_xpath('div[3]/div[2]').text454647comments=pd.DataFrame([i,author,comment,stars1,stars2,stars3,stars4,stars5,like,unlike]).T48comments.columns=['id','author','comment','stars1','stars2','stars3','stars4','stars5','unlike','like']49AllArticle=pd.concat([AllArticle,comments],axis=0)50browser.execute_script("arguments[0].scrollIntoView();",target)51i=i+152ifi%100==0:53print('已爬取{}条'.format(i))54AllArticle=AllArticle.reset_index(drop=True)55returnAllArticle5657url='https://www.bilibili.com/bangumi/media/md102392/?from=search&seid=8935536260089373525#short'58result=getComment(url)59#result.to_csv('工作细胞爬虫.csv',index=False)

这种方法爬取失败之后,一直不知道该怎么处理,刚好最近看到网上有大神爬猫眼评论的文章,照葫芦画瓢尝试了一下,居然成功了,而且爬的速度也很快,十来分钟就全爬完了,思路是找到评论对应的 Json 文件,然后获取 Json 中的数据,过程如下。

在 Google 浏览器中按 F12 打开卡发者工具后,选择 Network

往下滑动,会发现过一段时间,会出现一个 fetch,右键打开后发现,里面就是 20 条记录,有所有我们需要的内容,Json格式。

所以现在需要做的就是去找这些Json文件的路径的规律。多看几条之后,就发现了规律:

第一个Json:

https://bangumi.bilibili.com/review/web_api/short/list?media_id=102392&folded=0&page_size=20&sort=0

第二个Json:

https://bangumi.bilibili.com/review/web_api/short/list?media_id=102392&folded=0&page_size=20&sort=0&cursor=76553500953424

第三个Json:

https://bangumi.bilibili.com/review/web_api/short/list?media_id=102392&folded=0&page_size=20&sort=0&cursor=76549205971454

显然所有的Json路径的前半部分都是一样,都是在第一条Json之后加上不同的 cursor = xxxxx,所以只要能找到cursor值的规律,就可以用循环的办法,爬完所有的Json,这个值看上去没什么规律,最后发现,每一个Json路径中 cursor 值就藏在前一个Json的最后一条评论中

在 python 中可以直接把 JSON 转成字典,cursor 值就是最后一条评论中键 cursor 的值,简直不要太容易。

所以爬的思路就很清晰了,从一个Json开始,爬完 20 条评论后,获取最后一个评论中的cursor值,更改路径之后获取第二个Json,重复上面的过程,直到爬完所有的Json。

至于如何知道爬完了所有Json,也很容易,每个Json中一个total键,表示了当前一共有多少条评论,所以只需要写一个while循环,当爬到的评论数达到total值时停止。

爬的过程中还发现,有些Json中的评论数不够 20 条,如果每次用 20 去定位,中间会报错停止,需要注意一下。所以又加了一行代码,每次获得Json后,通过 len() 函数得到当前Json中一共包含多少条评论,cursor 在最后一个评论中。

以上是整个爬的思路,我们最终爬到以下信息:

需要说明的地方,一个是 liked 按照字面意思应该是用户的点赞数,但爬完才发现全是 0,没有用。另一个是关于时间,里面有 ctime 和 mtime 两个跟时间有关的值,看了几个,基本都是一样的,有个别不太一样,差的不多,就只取了 ctime,我猜可能一个是点击进去的时间,一个是评论提交时间,但没法验证,就随便取一个算了,ctime 的编码很奇怪,比如某一个是 ctime = 1540001677,渣渣之前没有见过这种编码方式,请教了大佬之后知道,这个是Linux系统上的时间表示方式,是1970 年 1 月 1 日 0 时 0 分 0 秒到当时时点的秒数,python 中可以直接用 time.gmtime() 函数转化成年月日小时分钟秒的格式。还有 last_ep_index 里面存的是用户当前的看剧状态,比如看至第 13 话,第 6 话之类的,但后来发现很不准,绝大多数用户没有 last_ep_index 值,所以也没有分析这个变量。

代码如下:

1importrequests 2fromfake_useragentimportUserAgent 3importjson 4importpandasaspd 5importtime 6importdatetime 7headers={"User-Agent":UserAgent(verify_ssl=False).random} 8comment_api='https://bangumi.bilibili.com/review/web_api/short/list?media_id=102392&folded=0&page_size=20&sort=0' 910#发送get请求11response_comment=requests.get(comment_api,headers=headers)12json_comment=response_comment.text13json_comment=json.loads(json_comment)1415total=json_comment['result']['total']1617cols=['author','score','disliked','likes','liked','ctime','score','content','last_ep_index','cursor']18dataall=pd.DataFrame(index=range(total),columns=cols)192021j=022whilej

三、影评分析

最终一共爬到了 17398 条影评数据。里面的 date 是用 ctime 转过来的,接下来对数据进行一些分析,数据分析通过 python3.6 完成。

评分分布

评分取值范围为2、4、6、8、10分,对应1-5颗星

可以看出,几乎所有的用户都给了这部动漫五星好评,影响力可见一斑。

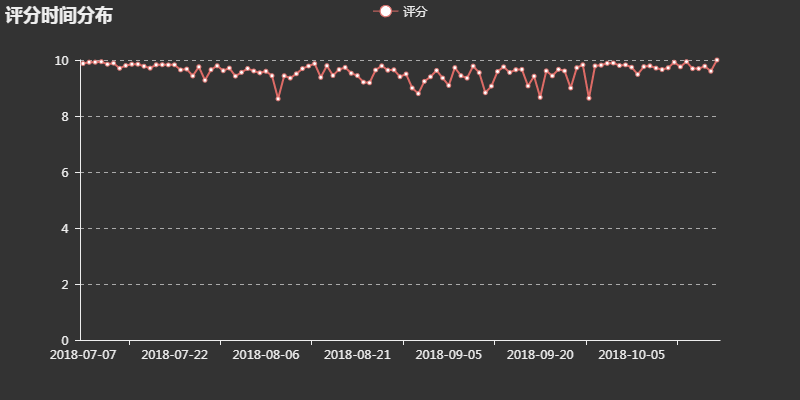

评分时间分布

将这部动漫从上线至今所有的评分按日进行平均,观察评分随时间的变化情况

可以看出,评分一直居高不下,尤其起始和结束时都接近满分,足见这是一部良好开端、圆满结束的良心作品。

每日评论数

看完评分之后,再看看评论相关的数据,我最感兴趣的是,这些评论的时间分布是怎么样的,统计了每一日的评论数之后,得到了评论数的分布图

基本上是每出了新的一话,大家看完后就会在短评中分享自己的感受,当然同样是起始和结束阶段的评论数最多,对比同期的百度指数

评论日内分布

除了每日的评论数,也想分析一下评论的日内趋势,用户都喜欢在每日的什么时间进行评论?将评论分 24 个小时求和汇总后,得到了下图

不过这个结果就不是很理想了,横轴是时间,纵轴是评论数,中午到下午的趋势上升可以理解,晚上七八点没有人评论反倒是凌晨三四点评论数最多,这个就很反常了,可能是评论在系统中上线的时间有一定偏差?

好评字数

此外还想分析一下,是否点赞数多的,一定是写的字数越多的?因为文章中大部分的评论是没有点赞的,所以这里中统计了有点赞(likes>0)的评论点赞数和评论字数的数据。由于有一条评论字点赞数太多,严重偏离整体趋势,所以做了对数图进行观察。

整体来看,似乎没什么关系,大量字数 1-100 不等的,点赞数都为 1,点赞数大于 5 的部分有一定的正相关性,说明评论不仅要看数量,还要看质量,写出了大家的心声,大家才会使劲点赞。

评论分析 TF-IDF

分析完基础数据后,想更深入挖掘一下评论信息,大家都说了些什么?为什么这部剧这么受欢迎?也许都能在评论中找到答案。

jieba 分词、去除停止词、计算词频和 TF-IDF 的过程不表,与之前两篇文章类似。我们提取了重要性前 500 的词,这里展示部分

血小板高居首位,毕竟大家对萌萌哒事物都是没什么抵抗力的。

词语中也存在一些意义不大的词,前期处理不太到位。不过从这些词云中还是可以看出很多东西,为什么这部剧如此受欢迎?这里通过分词可以得到以下三个解释:

1. 题材好:科普类动漫,老少皆宜

评论中提到了科普、生物、题材等词,还有各种细胞。区别于一般科普向动漫受众低幼的问题,这部番的受众年龄比较广泛。因为所涉及到的知识并不算过于常识。动漫中,每一话,身体的主人都会生一场病,每次出现新的细胞和病毒出现时,都会对他们的身份有比较详细和准确的介绍

这种形式寓教于乐,同时战斗的过程也充分地体现了每种细胞的特性。例如,前期因为战斗力弱而被别的细胞瞧不起的嗜酸性粒细胞,在遇到寄生虫的时候大放异彩。可以说,每一种细胞爆种都爆得都有理有据。

2. 人设好

这部番把几乎人体所有的细胞拟人化:红细胞、白细胞、血小板、巨噬细胞等。每一种细胞都有比较独特的设定,从御姐到萝莉,从高冷到话痨。十几个出场的主要人物都各自有立得住的萌点。满足各种口味的需求。

3. 制作精良

这一点是毋庸置疑的,好的人设好的题材,如果没有好的制作,都是白谈,评论中也有很多人提到了“声优”、“配音”等。

当然一部剧能够火,不仅仅是这么简单的原因,这里所说的,只是从数据可以看出的,观众的直观感受。

-

数据

+关注

关注

8文章

7010浏览量

88969 -

函数

+关注

关注

3文章

4329浏览量

62582 -

爬虫

+关注

关注

0文章

82浏览量

6869

原文标题:用Python分析《工作细胞》的一万多条评论后,非漫迷也要入番了

文章出处:【微信号:rgznai100,微信公众号:rgznai100】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

锂电车载式UPS产品受欢迎的原因

豆瓣电影Top250信息爬取

BLE低功耗蓝牙模块为何如此受欢迎?

iOS 12的装机率已达到88%,是什么让iOS 12如此受欢迎?

浅谈:耐弯曲电缆为何如此受欢迎?

阿尔法机器狗如此受欢迎的魅力是什么

爬取b站上的所有短评进行分析,用数据说明为什么这部动漫会如此受欢迎

爬取b站上的所有短评进行分析,用数据说明为什么这部动漫会如此受欢迎

评论