AI芯片是如何诞生的,发展的动力在哪?与传统的CPU相比有何不同?国内的AI科研以及投资出现了怎样的偏差?最近,美国杜克大学终身教授陈怡然接受了专访。

AI芯片,或许你已经听说,或许还没怎么意识到。当手机刷脸解锁,当闯红灯被拍,当无人车送货,当照片被自动分类,当你对着智能音箱大喊大叫,无论是在千里之外的云端还是近在咫尺的终端,AI芯片已无处不在。

AI芯片是如何诞生的,发展的动力在哪?与传统的CPU相比有何不同?AI对芯片设计会有怎样的影响?国内的AI科研以及投资出现了怎样的偏差?美国杜克大学终身教授陈怡然接受专访,纵论当芯片遇到AI,将发生怎样的进化。

陈怡然(杜克大学电子与计算机工程系教授)

《赛先生》:AI芯片是什么,在哪?

陈怡然:凡是主要目的是用来支撑AI应用的计算需求的芯片就叫AI芯片,我觉得现在基本上相对比较全面的定义就是这样。

AI芯片到处都有,原因是AI的应用现在到处都有,只要有这些应用就必然会产生对于计算的需求,有这种需求就一定要有芯片作为支撑,无论在云端还是边缘端,都是这样。

《赛先生》:AI这一波,我们回顾时通常说,某个时候有某个算法的发明,AI芯片是否和算法演进也紧密联系,它发展的推动力来自哪里?

陈怡然:它其实跟传统的科学计算是一样的,包括我们常说的Windows~Intel体系。它的推动力来自于AI算法的不断演进和数据量增长带来的处理需求。这两件事情造成了对计算能力需求的显著提升,才有不断的新的AI芯片被设计出来满足这样的需求。

如果把AI的算法作为当年Windows的标准看,GPU可以简单比作当年英特尔的中央处理器。当然现在不太一样的是,我们没有一个单独的公司去提供AI的算法,有很多公司在做这件事情,也没有哪一家公司获得了当年像Intel微处理器这样的地位。Nvidia很接近,但依然有别的公司参与。

《赛先生》:和传统的芯片相比,AI芯片设计有多大的变化?

陈怡然:AI芯片所针对的算法跟传统的科学计算并不太一样,这就造成了它主要的设计理念,实际上是如何更有效的把这种已经基本上定型的神经网络的架构,通过芯片或者具体来说的晶体管来做物理实现,这就是我们所说的AI芯片架构。

原来做传统科学计算的时候,要给一个比较通用的计算架构,把它抽象出来,然后在一个很高的层次上通过一些很通用的方式去实现计算。但是AI芯片不是这样的。它一开始就是给出一个类似物理连接的样子,我就把这个东西在CMOS电路上尽可能用有效的物理形态把它表示出来,这样就避免了那种先抽象,然后再普适的过程,当然就变的更加有效。

所以这就是为什么我们会看到,传统的科学计算的芯片跟AI芯片,架构会有显著的不同,是因为它的设计理念完全不一样。

而且这一定是一个长期的过程,因为这实际上是在一个更大的框架,叫做行业特定设计(Domain specific design)之下,说的是要针对特殊场景设计——针对一个场景本身,提取出来它最重要的部分;而不是抽象这个部分,再做有效的设计和实现。这种设计的理念可能今后会是一个很长期的趋势,原因就是摩尔定律停了,使得芯片的相对成本在整个系统实现成本里面所占比重逐渐降低。

今年图灵奖给了一个约翰·轩尼诗和大卫·帕特森。帕特森曾在一个演讲中表示,现在这个年代做一个芯片出来的成本,做最便宜的模型可能只需要几万美元(当然做一个很复杂的系统可能还是几千万),在这种情况下,大家就可以去尝试很多定制化设计,然后找到适合的。这就是为什么做RISC-V这种开源的架构,然后找到一个特殊的应用再去定制化把它做出来,这将来可能会是一个长期的趋势。

《赛先生》:通用还会作为一个追求的目标吗?

陈怡然:通用仍然会是长期存在的,因为这是我们的主干。但是随着业务的多样性,这种针对具体场景的芯片作为辅助会越来越多。

《赛先生》:AI对于传统芯片设计会带来很大的改变么?

陈怡然:对,实际上AI在EDA软件设计上的应用在美国是非常热门的话题,原因是,如果人能够下赢最顶级的棋手,他也应该能战胜最顶级的芯片设计师,因为毕竟来讲,芯片设计还是一个有一定规律可循的优化过程。

传统上来讲,我们在设计的时候,都希望把一个芯片设计的工作抽象成一个数学可以表达的模型再去做优化,AI最大的能力是什么?可以把一个任务在你可能不完全理解,或者不能很好的抽象成数学模型的情况下,它仍然可以做有效的优化,这个是AI最大的功能或者能力。

那么这个能力,用于EDA软件的改进,用于减小芯片设计的周期,我们可以看到是非常有效果的。所以,现在所有的EDA公司都在做大量的尝试,而且初步效果非常的好。

《赛先生》:将来芯片设计的周期缩的非常短?

陈怡然:芯片设计周期会缩短,现在叫做快速设计。现在提出的目标是能够在24小时内完成芯片设计,原来是需要几个月。

在无人值守的情况下能不能设计?就好像原来做皮鞋,都是培养出了一大堆非常心灵手巧的裁缝,有人剪皮子,有人缝,现在全都是机器去做出来了,完全不需要人工干预。

什么时候能实现这不好说,但一定我们是朝着这个方向去走的。

《赛先生》:芯片的开发周期会比较长,成本也相对较高。有没有可能芯片实现了某一个算法以后,因为算法的进展也很快,等芯片推向市场,已经并不是一个最适合的?

陈怡然:这种情况经常出现。因为算法经常会有一些新的不同的设计出现,简单的变化包括一些数字比如权重变化,不牵涉架构变化例如增加网络层级,这些就比较容易通过片上逻辑来实现。但比较复杂的是它如果出现了完全不同的架构或者以前没有过的操作,这就很难用已有的片上逻辑来实现。

我举一个简单的例子,比如说最早的人工智能芯片只支持MLP这样的架构,就是直接一个矢量和矩阵相乘就结束了。后来又出现了卷积神经网络,它要做卷积,卷积如果不被支持你就必须把卷积拆分成向量跟矩阵相乘,那这个计算效能就显著降下来了,这是一个很大的问题。

《赛先生》:这种问题怎么去解决?

陈怡然:现在来看有几种方式,一种方式是在技术上尽可能地会有一些可重构的器件。如果真的遇到原来设计上没出现过的东西,有些逻辑可以经过简单的可重构之后去支撑这样的计算。但是它不是没有代价的,这样做一定会带来性能的损失,至少不像直接做一个针对性的逻辑更为高效。

第二种,我把主要的方法先用一个芯片实现了。如果真的出现什么新情况,旁边加一个协处理器,通过两边的协同来完成。这有点像当年的386时代有一个整点运算器,有一个浮点运算器。只靠整点运算器也能算,慢一点,把浮点运算器加上就更快一点,这也是一种。

第三种就更极端。因为在实际部署中,一个芯片的销售周期大概是三年,就是从它做出来到在市场上大规模销售、使用、消失大概是三年,真正挣钱的周期在12~18个月。如果期间发现真的出现了一个新算法或者应用这一代芯片不支持,也没关系,下一代再支持就好了,因为一代芯片的生命周期非常短。但这一招对小公司不适用,因为小公司可能一代挣不到钱就死了。大公司能撑住,下一代加回来就行。

所以在技术和商业模式上大家都有各种各样的方法可以去应对,并不是这12~18个月内不能出现新的算法或应用。

《赛先生》:我们现在已经讨论晶体管很难做的更小了,这对于AI芯片设计会有怎样的影响?

陈怡然:有几点。第一点,摩尔定律发展下去,越做越小,可单位晶体管数目的成本其实不会再往下降或者降得很有限,原因是制造成本越来越高。在这种情况下,如何用相同的逻辑数量去做更多更有效的计算,或者进行计算的表达就变的非常重要。

一些新型的器件或者新型的工艺可以有帮助。我举两个例子,比如说有一种技术叫3D堆叠,可以在同一个单位面积上堆叠更多层,每层有很多的存储器或者计算逻辑,这样数据可以离计算非常近,提升计算时的数据传输效率。这当然就对AI芯片设计比较有效,因为AI计算时很大程度上是数据来回搬来搬去。

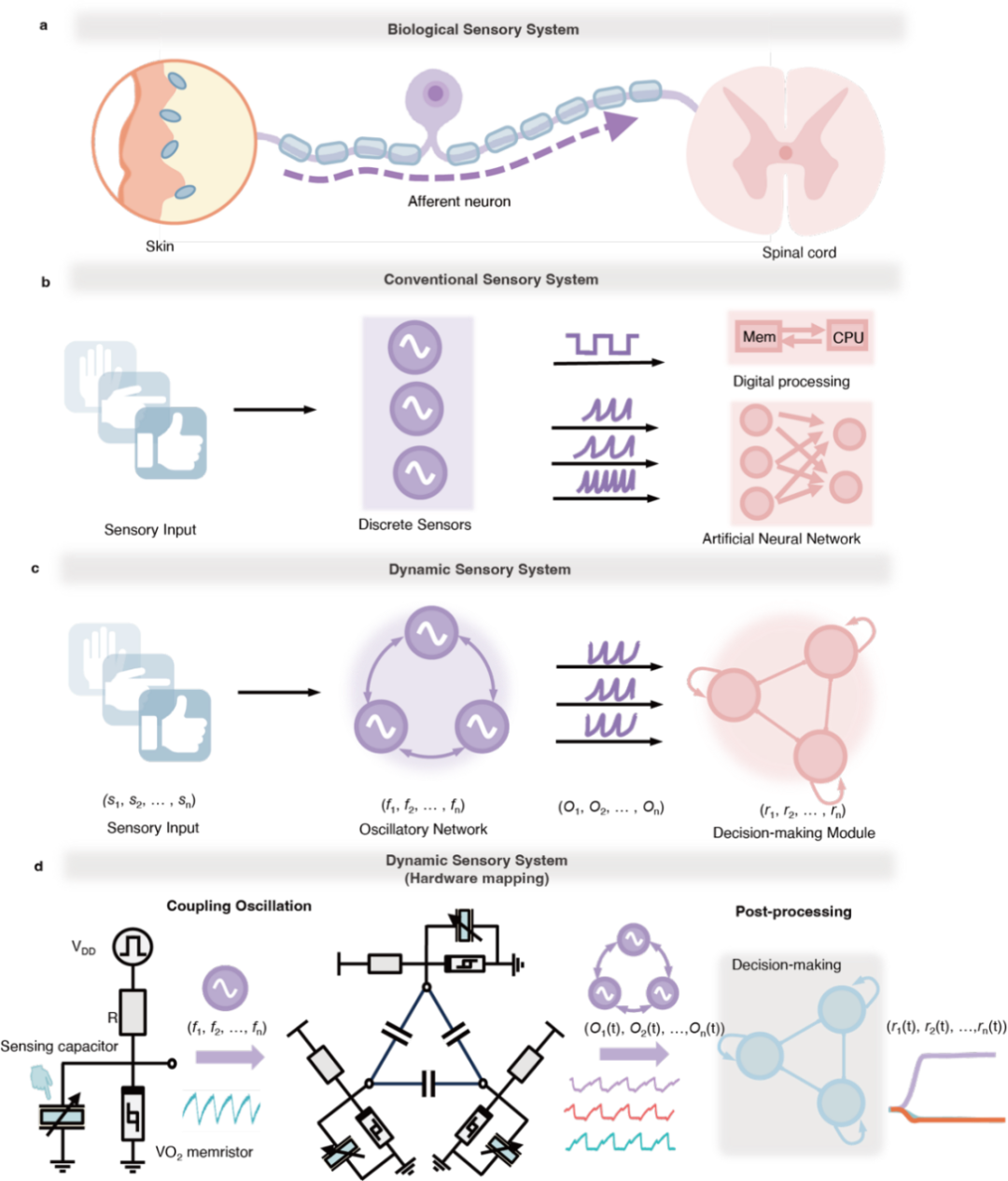

另外,也可以去看一些新的器件和材料,有些会更有效的去做一些AI的运算。比如像忆阻器这种东西,它器件的特性非常像神经网络的神经突触。如果用晶体管来实现,可能需要几十甚至上百个才能做出一个神经突触。可是一个甚至比晶体管还小的纳米器件就可以做这件事。所以后摩尔定律对AI芯片还是有帮助的。

《赛先生》:您提到忆阻器,现在对类脑芯片有很多不同的声音,有一种反对声音认为这个东西好像不太靠谱,包括IBM的TrueNorth,国内也有一些尝试,您怎么看这种类型的芯片?

陈怡然:首先说一条,我们其实并不非常清楚的知道人脑是怎么工作的。因为我们对人脑的理解,甚至对人脑认识的工具都处于非常原始的状态,当然我们已经有了一些初步理解。那么这样来讲,其实类脑芯片或者深度学习加速芯片,或者是类脑算法、深度学习的算法,它们的缘起实际上是一样的,都是最早对于人的神经网络尤其是视觉网络的学习和认识,只是在后期两边分道扬镳了。

一边觉得我希望在数学上做越来越多的事情,能够让它完成这个工作就好了。另外一边希望从生物上对这个网络有越来越多的理解,通过这个理解指导我的网络设计。这相当于两个流派,打一个比方,就像剑宗跟气宗,这两个实际上都是属于华山派的,现在互相不服气,深度学习加速芯片就说你们那个生物的好像没什么用,生物的说,你们那个解释不清楚,我觉得没有这个必要。

按照我的理解,一般来说类脑或者神经形态计算,就是希望能够通过特殊的编码形式,能够完成更有效的计算,而不是简单的对于某些数学模型直接的实现。我觉得这一部分还有很长的路要走,还是在一个初始的科研阶段。不过真的有所突破的话,对于芯片的设计还是有很多的借鉴意义。我们完全没有必要画一条线说,你们那个就是纯粹的科研,我们这个就是纯粹的做应用,我觉得这是没有必要的。

《赛先生》:AI芯片研究现在大的趋势或者方向是什么样的?

陈怡然:现在很重要的一个趋势主要是软硬结合,因为在很长一段时间之内我们做算法的跟做计算的分开,甚至互相都不太提及对方的贡献,我觉得这是不好的。

我们以前的数据分析的科学家,做算法的科学家跟做计算的科学家实通过他们三方的努力才把AI技术推到现在的程度,我们要保持他们这种相互之间的支持。

从我们的具体实践来看,我们也看到了如果你只是做算法,不想管它怎么算出来了,和你做芯片不管前面的算法将来会做什么样的变化和优化,都不可能达到一个最优的效果,所以这是现在的一大特点。

《赛先生》:感觉现在AI这一波来了以后,包括加上硬件本身的发展,摩尔定律结束,感觉好像进入了一个重新跟过去很不一样的时代?

陈怡然:前两天在杭州,我们开玩笑说很恍惚,为什么?原来我们觉得主流的一些东西,现在好像变的不主流了。

比如说我们以前觉得科学计算是一个主流,大规模并行计算是一个主流,现在发现AI是一个主流,但是AI不是科学计算,而且深度学习又不能完全解释它,那究竟谁在成为主流?

我觉得说不定谁的应用最多谁就是主流,我们以前做科学计算的时候,我们要讲求通用性,那时候它是主流。今后我们发现其实这种多样性,这种神经形态的计算的模型,我们称之为认知计算的这种东西变的越来越多,那么它可能就变成一个主流。

这是我们现在感到迷惑和恍惚的地方,我觉得这毕竟是一个新的时代,不以人的意志为转移,大家只能去拥抱它。

《赛先生》:现在有一种反对的声音,感觉降温也好反对也好,觉得现在AI离应用实际真正用的好、落地的场景,比如说很热大家都在讲的自动驾驶、安防也好,甚至有不同的声音认为这个东西离应用好像还没有那么完美,甚至还没有怎么落地,我不知道从AI芯片设计的角度来说有没有去考虑过这个问题?

陈怡然:有,因为做芯片来讲,我得知道哪个应用将来最火,我才去设计,那我不知道什么会最火我该怎么办。

我觉得AI这件事情的应用,是很多因素造成现在的情况。最简单的,从投资角度,做一个AI的应用,得找到人买单。所以为什么大家做人脸识别,因为它的用户有很强的付款的意愿,比如安防之类的。

但是实际上我们发现很多传统行业,也有大量AI的应用,比如生产线质量检测。那为什么没有人去做?因为这种应用往往是很碎片化的,造成了它的定制化成本非常高。他们这些产业利润率又特别薄,他们愿意掏钱的愿望和能力都没有那么高,你就挣不到钱,所以我们没有去做。

我觉得AI的应用仍然有很多,有各种各样现在我们完全没有在做的。但因为它是一个经济问题,不全是一个技术问题,这是第一。

第二,泡沫出现在头部企业和应用,但是并不代表整个产业我们都解决完了。仍然有很多问题都是是可以解决但是没有解决的,所以AI会持续很长的时间。泡沫也许会消亡,但是从研究和技术发展的角度来讲,AI会在很长一段时间内成为一个平稳发展的行业。

《赛先生》:AI芯片方面,我没有提到,但您认为还可以强调的?

陈怡然:我想说的一点就是,其实AI没有运算的支撑是不可能大量更好更有效的部署的。我们要更多的去重视它的计算平台,更多的注重它在具体场景的实现。

尤其是在国内,现在有大量注意力是集中在AI的应用层面上,甚至投资也主要是在应用层面上。如果不是因为中兴这件事,我觉得AI芯片这件事不会像现在这么火,这也从另外一个角度说明其实我们在国内的投资眼光之前实际上是有它的偏见的。

我举一个简单的例子,我最近听到一种论调,在AI芯片架构这个领域,说我们现在跟美国是同一个水平线上。

我想举一个例子,比如说像IBM的TrueNorth芯片,立项实际上是2007年,2008年项目正式开始,11年前它就有这样的眼光,说要做一个类脑芯片、加速芯片。那我现在要问的一个问题就是,有没有人可以告诉我,你觉得十年之后我们想要一个什么样的AI芯片,或者在计算领域十年之后什么会是最需要的技术,还没有人能告诉我这件事情。

所以我觉得我们还是有太多的工作需要去做,不能满足于现状,看到一两个还不错的点,就下结论说我们已经够了,我们的投入、人已经够了,我觉得这是不行的,这是没有远见的。

《赛先生》:这就涉及到怎么样才能有眼光,去选择非常重要的问题持续进行研究或者投入,您这方面有怎样的建议?

陈怡然:这个问题就太大了,我觉得可以单独去请一些人讲。但是我觉得至少有一点,一定要有多样性。

实际上你看到的这些有点名气的老师都是当年做的某一个点,这个点后来恰好越来越火,其实有很多老师做的很多工作甚至这些有名的老师自己做的其他一些东西后来也就默默无闻了,因为它们没有变成一个热点。

那是不是我们吃了第七个饼吃饱了,前面六个就不需要了?不是这样的。这种多样性一定是需要的,有多样性就会在某一天某一点爆发的时候,说这是我们当年的一个积累——这种积累就像一个很小很小的种子,最后长成了一棵参天大树。

-

gpu

+关注

关注

28文章

4744浏览量

129018 -

EDA软件

+关注

关注

6文章

97浏览量

18709 -

AI芯片

+关注

关注

17文章

1889浏览量

35087

原文标题:杜克大学终身教授陈怡然专访:让非主流成为主流,AI芯片的起源、现状与前路

文章出处:【微信号:AI_era,微信公众号:新智元】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

恒玄科技研发AI眼镜专用芯片

2024软通动力AI+数字孪生创新发展论坛圆满落幕

软通动力亮相福建昇腾AI产业发展论坛

西湖大学:科学家+AI,科研新范式的样本

数据驱动AI工具在哪

AI教父预测:超越人类智慧的AI或5年内问世

司罗加盟斑马智行出任CTO

开启全新AI时代 智能嵌入式系统快速发展——“第六届国产嵌入式操作系统技术与产业发展论坛”圆满结束

校企携手,探索“最强大脑”电子科技大学特聘研究员Minati教授访问阿尔泰科技:探索大脑与电子系统的交叉

香港中文大学教授、IEEE Fellow邢国良出任国科微AI首席科学家

普林斯顿大学联手DARPA研发人工智能芯片

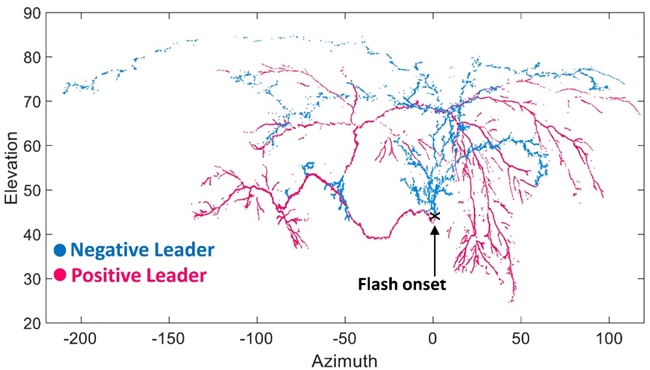

Spectrum仪器8通道数字化仪系统助力闪电研究

杜克大学终身教授陈怡然专访:AI芯片是如何诞生的,发展的动力在哪?

杜克大学终身教授陈怡然专访:AI芯片是如何诞生的,发展的动力在哪?

评论