【导语】ICLR 是深度学习领域的顶级会议,素有深度学习顶会 “无冕之王” 之称。今年的 ICLR 大会将于5月6日到5月9日在美国新奥尔良市举行,大会采用 OpenReview 的公开双盲评审机制,共接收了 1578 篇论文:其中 oral 论文 24 篇 (约占 1.5%),poster 论文共 476 篇 (占30.2%)。在这些录用的论文中,深度学习、强化学习和生成对抗网络 GANs 是最热门的三大研究方向。

今天, ICLR2019 公布了最佳论文,有两篇论文获得了最佳论文,在此对获奖论文作者及团队表示祝贺!一篇是《Ordered Neurons: Integrating Tree Structures into Recurrent Neural Networks》,在 RNN 网络中集成树结构,提出一种神经元排序策略,由蒙特利尔大学、微软研究院共同研究发表;另一篇是 MIT CSAIL 的研究成果《The Lottery Ticket Hypothesis: Finding Spare, Trainable Neural Networks》。下面就为大家带来这两篇最佳论文的解读。

论文一

论文地址:

https://openreview.net/forum?id=B1l6qiR5F7

摘要

自然语言可视为是一种小单元 (如短语) 嵌套在大单元 (如字句) 中的分层结构。当结束一个大单元时,内部所嵌套的小单元也将随之关闭。尽管标准的 LSTM 结构允许不同的神经元跟踪不同时间维度信息,但它对于层级结构建模中的各组成没有明确的偏向。针对这个问题,本文提出神经元排序策略来添加一个归纳偏置量 (inducive bias),当主输入向量和遗忘门结构确保给定的神经网络更新时,后续跟随的所有神经元也将随之更新。这种集成树结构的新颖循环神经网络 ON-LSTM (ordered neurons LSTM) 在四种不同的 NLP 任务:语言建模、无监督解析、目标句法评估和逻辑推理上都取得了良好的表现。

研究动机

将树结构集成到神经网络模型用于 NLP 任务主要有如下原因:

学习抽象的逐层特征表征是深度神经网络结构的一大关键特征

对语言的组成影响进行建模并通过 shortcuts 连接方法为反向传播过程提供有效的梯度信息,这有助于解决深度神经网络结构的长期依赖性问题

通过更好的归纳偏置来改善模型的泛化能力,同时能够减少模型训练过程对大量数据的需求

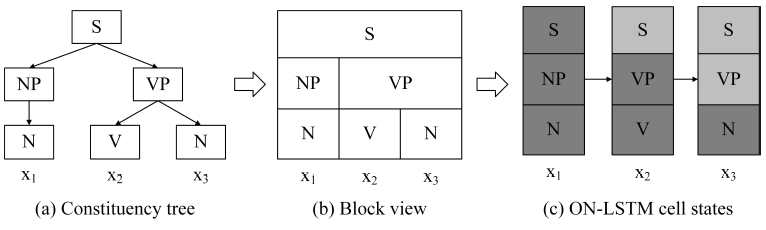

基于以上动机,该研究提出一种有序化神经元方法 (结构示意图如下图1),通过归纳偏置来强化每个神经元中的信息储存:大的、高级的神经元储存长期信息,这些信息通过大量的步骤保存;小的、低级的神经元储存短期信息,这些信息能够快速遗忘。此外,一种新型的激活函数 cumulative softmax (cumax) 用于主动为神经元分配长/短期所储存的信息,有效地避免高/低级神经元的固定划分问题。

总的来说,本文的研究集成树结构到 LSTM 网络中,并通过归纳偏置和 cumax 函数,构建一种新颖的 ON-LSTM 模型,在多项 NLP 任务中都取得了不错的性能表现。

图1 组成解析树结构与 ON-LSTM 模型隐藏状态的对应关系

实验结果

在四种 NLP 任务中评估 ON-LSTM 模型的性能,具体如下。

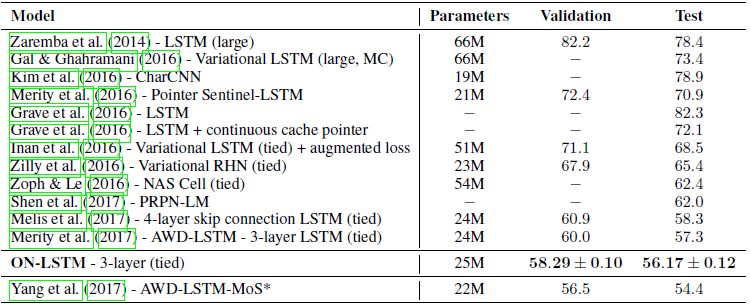

语言建模

图2 Penn Treebank 语言建模任务验证机和测试集的单模型困惑度

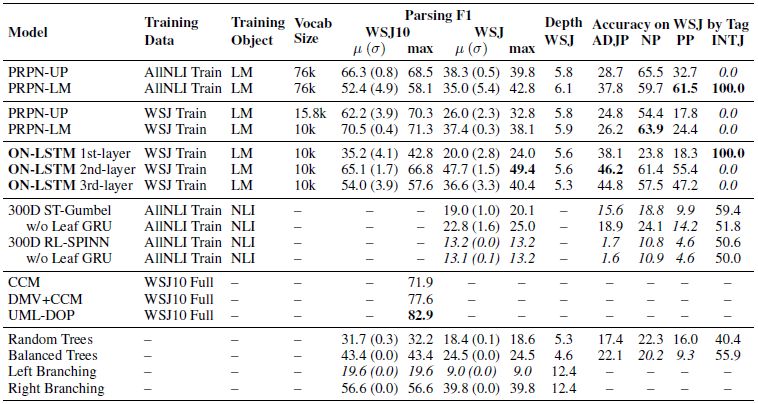

无监督句法组成分析

图3 full WSJ10 和 WSJ test 数据集上的句法组成分析评估结果

目标句法评估

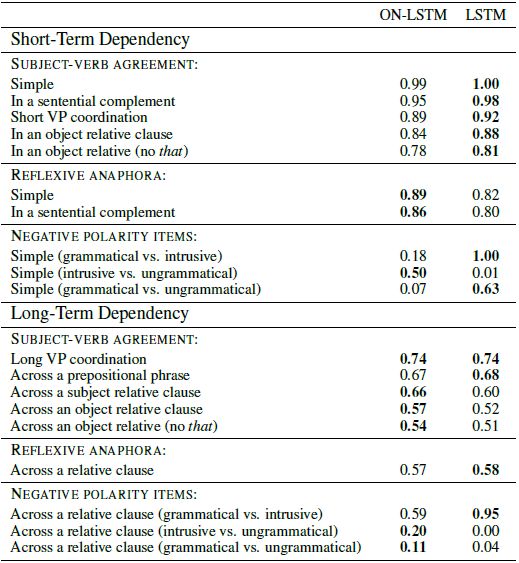

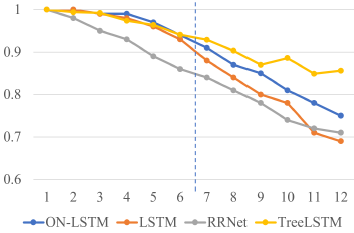

图4 ON-LSTM 和 LSTM 模型在每个测试样本的总体精度表现

逻辑推理

图5 在逻辑短序列数据上训练的模型的测试精度

论文二

论文地址:

https://openreview.net/forum?id=rJl-b3RcF7

摘要

神经网络的剪枝技术能够在不影响模型准确性能的情况下,减少网络的训练参数量,多达90%以上,在降低计算存储空间的同时提高模型的推理性能。然而,先前的研究经验表明,通过剪枝技术得到的稀疏网络结构在初期是很难训练的,这似乎也有利于训练性能的提升。一个标准的剪枝技术能够自然地发现子网络结构,这些子网络的初始化能够帮助网络更有效地训练。

因此,本研究提出一种 lottery ticket hypothesis:对于那些包含子网络 (winning ticket) 结构的密集、随机初始化前馈网络,当单独训练这些子网络时,通过相似的训练迭代次数能够取得与原始网络相当的测试性能。而这些子网络也验证了初始的假设:即具有初始权重的连接网络能够更有效地训练。

基于这些结果,本文提出一种算法来确定子网络结构,并通过一系列的实验来支持 lottery ticket hypothesis 以及这些偶然初始化的重要性。实验结果表明,在 MNIST 和 CIFAR-10 数据集上,子网络的规模始终比几种全连接结构和卷积神经网络小10%-20%。当规模超过这个范围时,子网络能够比原始网络有更快的学习速度和更好的测试精度表现。

研究动机与方法

本文分析验证了存在较小的子网络结构,在相当的测试精度表现前提下,一开始就训练网络能够达到与较大子网络一样,甚至更快的训练速度。而基于此,本文提出 Lottery Ticket Hypothesis:将一个复杂网络的所有参数作为一个奖励池,存在一个参数组合所构成的子网络 (用 winning ticket 表示),单独训练该网络能够达到与原始复杂网络相当的测试精度。

对于该子网络结构的确定,主要是通过训练一个网络并剪枝其中最小权重来确定子网络,而其余未剪枝部分连接构成自网络的结构。具体步骤如下:

首先通过随机初始化得到一个复杂的神经网络 f

接着重复训练该网络 j 次,得到网络参数

然后对该模型按 p% 进行剪枝得到一个掩码 m;将步骤二中的网络参数作为参数向量,每个向量元素对应于一个 m,用于表征是否丢弃。

最后,对于存留下来的模型,在原始复杂网络参数组合进行初始化,创建一个子网络结构。

总的来说,本研究的主要贡献如下:

验证了剪枝技术能够发现可训练的子网络结构,而这些网络能够达到与原始网络相当的测试精度。

提出了一种 lottery ticket hypothesis,从一种新的角度来解释这些神经网络的组成。

证明了通过剪枝技术得到的子网络相比于原是网络,有着更快的学习速度、更高的测试精度和更好的泛化性能。

应用

本文的研究验证了确实存在比原始网络更快速、性能更佳的子网络,这种结构能够给未来的研究提供诸多方向:

提高模型训练性能:由于子网络能够从一开始就进行单独训练,因此尽早进行剪枝的训练方案值得进一步探索。

设计更好的网络结构:子网络结构的存在说明稀疏架构和初始化组合有利于模型的学习。因此设计出有助于学习的新结构和初始化方案,甚至将子网络结构迁移到其他任务仍需要进一步研究。

提高神经网络的理论理解高度:更加深入地理解随机初始化网络与子网络的关系、网络优化与泛化性能的知识等。

-

神经网络

+关注

关注

42文章

4762浏览量

100522 -

神经元

+关注

关注

1文章

363浏览量

18436 -

深度学习

+关注

关注

73文章

5491浏览量

120958

原文标题:ICLR 2019最佳论文揭晓!NLP深度学习、神经网络压缩夺魁 | 技术头条

文章出处:【微信号:rgznai100,微信公众号:rgznai100】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

2024 年 19 种最佳大型语言模型

中科驭数联合处理器芯片全国重点实验室获得“CCF芯片大会最佳论文奖”

Aigtek安泰电子论文奖励政策再升级,激励科研创新未来可期!

芯动力科技论文入选ISCA 2024,与国际巨头同台交流研究成果

南方科技大学深港微电子学院三篇研究文章入选VLSI Symposium

KLA再度入选《福布斯》“全球最佳雇主”

苹果寻求利用新闻机构素材开发AI系统

论文遭首届ICLR拒稿、代码被过度优化,word2vec作者Tomas Mikolov分享背后的故事

ICLR 2024高分投稿:用于一般时间序列分析的现代纯卷积结构

ICLR2019公布了最佳论文,有两篇论文获得了最佳论文

ICLR2019公布了最佳论文,有两篇论文获得了最佳论文

评论