我们现在所使用的神经网络模型,可能有 80% - 90% 的体积是多余的,这浪费了巨大的处理能力。

近日,麻省理工学院的计算机科学与人工智能实验室(MIT CSAIL)公布了一项新的研究成果,用富有创意的“彩票机制”修剪了传统神经网络模型,选择性地剔除了对结果意义不大的连接(权重),使其变为更小的子神经网络。

最终,在保证预测准确率前提下,他们将实验中的子网络模型的体积减少了 80% - 90%,进而降低了对训练数据量和硬件的需求,而且学习速度还有所提升。

研究团队将这一方法称为“彩票假设(Lottery Ticket Hypothesis)”,成果以论文形式发表在最近召开的 ICLR 2019 大会上,并且被评选为两篇最佳论文之一。《麻省理工科技评论》报道了这一成果,预测这种构建微小神经网络的新方法,可以在手机上创建强大的人工智能。

将训练神经网络看作是抽奖

如今,深度学习技术已经成为了计算机科学领域的最热门研究方向,从应用自然语言处理的语音识别,到应用计算机视觉的自动驾驶,都十分依赖于构建(深度)神经网络。而为了达到最佳学习效果,构建神经网络通常需要非常庞大的数据集,用来训练和测试模型。很多研究团队都在想办法优化这一过程,在不牺牲准确度的前提下,让神经网络和模型变得更小巧轻便。

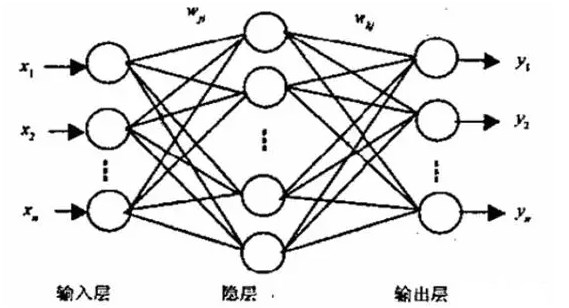

传统神经网络由很多层和神经元构成,神经元之间的连接可以用权重来衡量,通过调整某些权重的参数,我们就可以改变相应的连接在整个网络中的作用。权重一般都是随机初始化的,随着模型经过大量训练,神经网络会慢慢“学会”哪些神经元和连接更重要,继而改变对应的权重参数,输出准确率更高的结果。

图 | 神经网络剪枝示意图(来源:Dr. Lance Eliot, the AI Trends Insider)

在 MIT 研究人员看来,这就像是一个抽奖过程:最开始我们手里有一大堆数字,但只有少部分数字最富价值,所以我们可以在训练过程中将它们筛选出来,用这些数字组合成一张“中奖彩票”,也就是实现了准确预测的目的。

如果我们可以在最开始就知道哪些数字能够或者更容易中奖,那么就可以*直接**去除**剩下**那些价值不大的**数字*,从而在保证准确率的情况下,缩小神经网络的体积,甚至是提高训练效率。

研究人员将这一思路命名为“彩票假设”。他们认为,一个随机初始化的密集神经网络包含一个(一些)子网络,在独立初始化并训练相同迭代次数后,它们的预测准确率能够媲美原始的神经网络。

图 |“彩票假设”定义

“稀疏剪枝”法修剪出微小神经网络

值得注意的是,目前已存在多种神经网络剪枝(Pruning)技术,AI 大牛 Yann LeCun 就曾提出过。在最理想的情况下,可以将网络体积缩小 90%。但修剪之后的网络普遍难以重新训练,而且重新训练还会导致准确率降低等问题。

相比之下,MIT 团队想要找到一种,可以在最开始就训练修剪过的小型神经网络的方法。

为了验证“彩票假设”,研究人员先进行了复杂的数学推导,从理论上证明了实现的可行性。然后随机初始化了一个神经网络,并且迭代训练 N 次,获得了第 N 次迭代之后的所有参数,再按照特定的比例和方法剪掉部分参数,比如剔除数量级最小的权重,创造出一个蒙版。最后将所有剩余参数还原到初始值,套上刚刚得到的参数蒙版,由此创建了一套“中奖彩票”,再进行重新初始化和训练。

图 | 如何找到“中奖彩票”的官方解释

研究团队使用了全连接网络和卷积神经网络来测试“彩票假设”的效果,分别建立在 MNIST 和 CIFAR10 数据集之上——两者都是深度学习领域知名数据集。

针对这两种网络,他们在多种条件下重复进行了数万次实验,尝试分析和组合很多不同的方法,从而确定在不牺牲学习能力和准确度的前提下,可以最多删除多少个参数。

结果显示,“稀疏剪枝(Sparse Pruning)”方法是找到“中奖彩票”的最有效手段。由此生成的子网络大小只有原始网络前馈架构大小的 10% - 20%,而且在某些情况下,例如使用早停,Dropout 或随机重初始化等方法,还可以使学习速度加快,甚至是获得超过原始网络的准确度。

研究人员认为,这样的成果还只是起步,如果想找到合适的子网络,必须经过多次迭代、训练和修剪,对于算力有较高要求,而且存在一定的局限性,因为他们只找到了“稀疏剪枝”这一种寻求“彩票”的方法,还只考虑了数据集相对较小的视觉分类任务。

不过“彩票假设”的新思路可以激发机器学习领域的其它团队,尝试更多类似的网络压缩和优化研究。研究团队下一步将围绕更多的剪枝方法展开研究,分析为什么迭代剪枝(Iterative Pruning)在更深的网络中无法找到“中奖彩票”,同时对参数初始化机制进行更透彻的研究。

他们相信,如果投入更多的努力,能够找到最有效的剪枝手段,或许有望加速很多深度学习模型的训练过程,节省可观的开支和工作量,甚至是创造更有价值的新模型。

-

神经网络

+关注

关注

42文章

4767浏览量

100663 -

人工智能

+关注

关注

1791文章

47059浏览量

238047

原文标题:ICLR最佳论文:训练神经网络就像买彩票?

文章出处:【微信号:deeptechchina,微信公众号:deeptechchina】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

脉冲神经网络怎么训练

神经网络如何用无监督算法训练

人工神经网络模型训练的基本原理

深度神经网络与基本神经网络的区别

反向传播神经网络和bp神经网络的区别

bp神经网络和卷积神经网络区别是什么

卷积神经网络训练的是什么

卷积神经网络的原理是什么

卷积神经网络的基本原理、结构及训练过程

如何训练和优化神经网络

Kaggle知识点:训练神经网络的7个技巧

将训练神经网络看作是抽奖?如何找到“中奖彩票”的官方解释

将训练神经网络看作是抽奖?如何找到“中奖彩票”的官方解释

评论