对于未经过特殊训练的人来说,很难分辨出深度假视频(Deepfake),因为它们可能非常逼真。无论是作为一种新型的“调侃”方式,还是用于其他目的,描述人们从未做过或说过事情的虚假视频都是对“眼见为实”这一长期理念的根本威胁。

大多数深度假视频是通过向计算机算法显示某个人的许多图像,然后让它使用其所看到的信息生成新的人脸图像。同时,这些人的声音也是合成的,所以看起来和听起来都像是这个人说了某些新东西。

我(本文作者,纽约州立大学奥尔巴尼分校计算机视觉和机器学习实验室主任Siwei Lyu)的研究小组早期的一些工作,让我们能够检测出不包括人眼正常眨眼次数的深度假视频,但最新一代的深度假视频技术已经适应了这种趋势,因此我们的研究继续推进。

现在,我们的研究可以通过仔细观察特定帧的像素来识别视频的真伪。更进一步,我们还推出了积极的措施,以保护个人不成为深度假视频的受害者。

发现缺陷

在最近的两篇研究论文中,我们描述了检测有缺陷深度假视频的方法,而这些缺陷是伪造者无法轻易修复的。

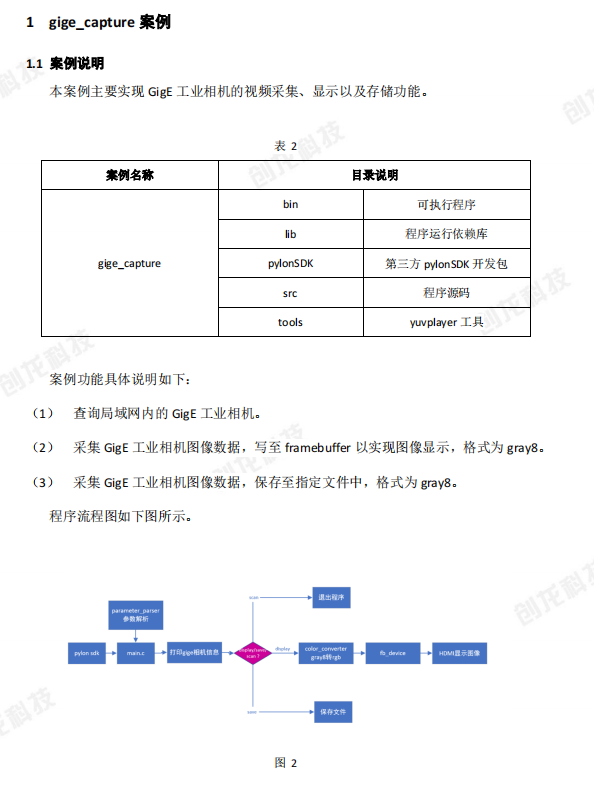

当深度假视频合成算法生成新的面部表情时,新图像并不总是能与人的头部位置、光照条件或到摄像头的距离完美匹配。为了使这些假脸融入周围环境,必须对它们进行几何变形——旋转、调整大小或以其他方式进行扭曲。这个过程在生成的图像中会留下数字痕迹。

我们已经注意到,有些深度假视频有很明显的数字痕迹。这些痕迹可以让照片看起来明显经过了修改,比如模糊的边框和人为修订的光滑皮肤。更细微的改变仍然会留下证据,我们已经教会了一种算法来检测它,即使人眼看不出区别。

如果深度假视频中有个人没有直视摄像头,这些伪影就会发生变化。拍摄真人的视频显示他们的脸会在三维空间中移动,但深度假视频的算法还不能在三维空间中伪造人脸。相反,它们会生成一张常规的二维人脸图像,然后尝试旋转、调整和扭曲该图像,使其符合人们想要看到的方向。

这类算法还没有很好地做到这一点,这就为发现它们提供了机会。我们设计了一种算法来计算人的鼻子在图像中的指向,它还可以通过人脸轮廓计算出头部指向的方向。在一个真实的人的头部视频中,这些应该是可以预见的。然而,在深度假视频中,它们往往是错位的。

图2:当电脑把尼古拉斯·凯奇(Nicolas Cage)的脸放在埃隆·马斯克(Elon Musk)的头上时,它可能无法将脸和头正确对齐

检测深度假视频

从技术上说,检测深度假视频的科学就像军备竞赛,因为伪造者们也在不断改进自己的技术,所以我们的研究总是要努力跟上,甚至需要保持超前。

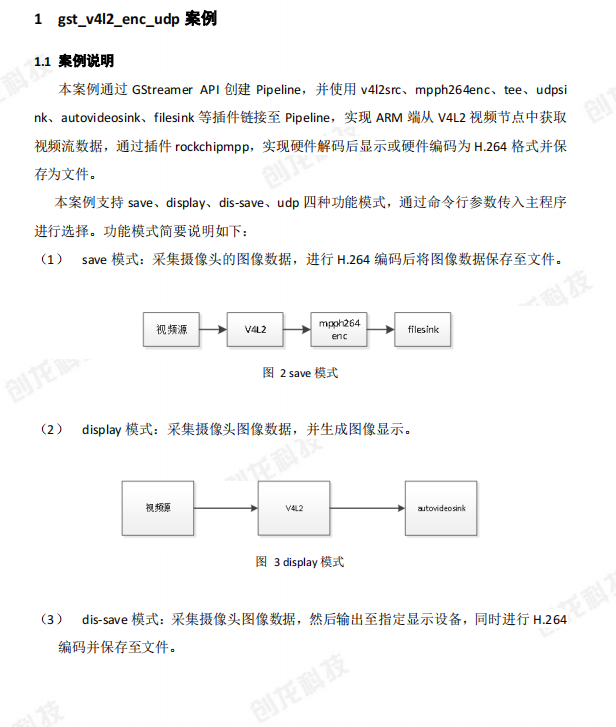

如果有一种方法可以影响创建深度假视频的算法,使它们的效果变得更差,这将使我们更好地检测伪造视频。我的团队最近找到了一种方法来实现这个目标。

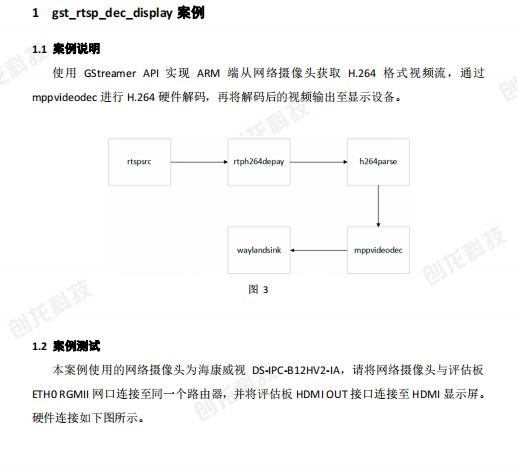

图3:左侧图片中,在我们处理之前很容易在图像中检测到人脸。在中间图片中,我们添加了些干扰,使算法能够检测到其他人脸,但不能检测到真实的人脸。右边图像中,我们修改了图像,增强了30倍使其可见

人脸图像库是由算法组合而成的,这些算法处理数千张在线照片和视频,并使用机器学习来检测和提取人脸。计算机可能会查看一张班级照片,发现所有学生和老师的面孔,然后将这些面孔添加到库中。当生成的库中有大量高质量的人脸图像时,生成的深度假视频更有可能成功地欺骗过用户。

我们发现了一种方法,可以在人眼看不到的数码照片或视频中添加特殊设计的噪音,但却可以欺骗人脸检测算法。它可以隐藏人脸探测器用来定位人脸的像素模式,并创建一些假信号,表明在没有人脸的地方有一张脸,比如某块背景或某人衣服的正方形。由于真脸更少,非真脸更多,训练数据受到“污染”,深度伪造视频算法生成假脸的能力就越差。这不仅减慢了制作深度假视频的过程,而且使生成的深度假视频暗藏更大缺陷,更容易检测出来。

当我们开发这个算法时,我们希望能够将它应用到任何人上传到社交媒体或其他在线站点的任何图像上。在上传过程中,他们可能会被问到:“你想保护视频或图像中的人脸不被用于深度伪造吗?”如果用户选择‘是’,那么该算法可以添加数字噪音,让人们依然能在网上看到人脸,但同时也能将其有效地隐藏起来,不让算法试图模仿它们。

-

人工智能

+关注

关注

1791文章

46915浏览量

237754 -

DeepFake

+关注

关注

0文章

15浏览量

6664

原文标题:向假视频宣战!研究人员开发出了鉴定假视频的“照妖镜”

文章出处:【微信号:smartman163,微信公众号:网易智能】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

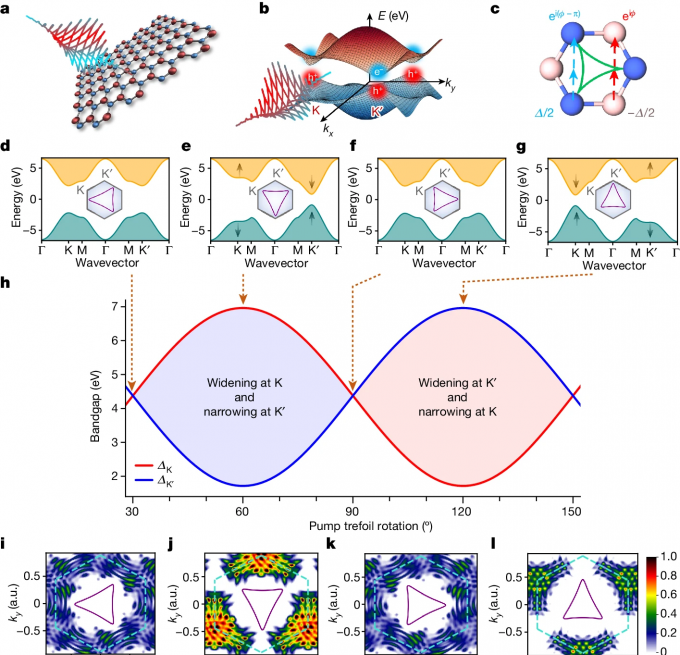

研究人员利用定制光控制二维材料的量子特性

研究人员开发出高性能p型非晶氧化物半导体

造成虚焊、假焊的原因有哪些?如何预防虚焊假焊

一种基于单像素光电探测器的高光谱视频成像系统设计

假焊现象为什么会发生?如何处理?

向假视频宣战!研究人员开发出了鉴定假视频的“照妖镜”

向假视频宣战!研究人员开发出了鉴定假视频的“照妖镜”

评论