联发科技今日宣布推出曦力P70(Helio P70)系统单芯片(SoC),其增强型AI引擎结合CPU与GPU的升级,实现了更强大的AI处理能力。

2018-10-25 09:46:03 5096

5096 的BERTSG、北京智源人工智能研究院的悟道2.0等等。 那么训练出这样一个大模型需要怎样的硬件前提?如何以较低的成本完成自己模型训练工作?这些都是不少AI初创企业需要考虑的问题,那么如今市面上有哪些训练芯片是经得起考验的呢?我

2021-12-18 06:51:00 2822

2822 华为轮值主席徐直军在这里推出华为高端 AI 芯片昇腾 910 ,开启华为在先进技术领域挑战硅谷的最新尝试。

2019-08-27 16:31:54 3300

3300 电子发烧友网报道(文/李弯弯)近日,北京君正在某平台上表示,普惠型AI芯片产品可向客户提供具有AI处理能力的高性价比芯片产品,产品面向行业和消费类安防市场;AI算力引擎:神经网络处理器已应用于公司

2023-08-10 09:16:59 1662

1662 算法的兼顾,英伟达不仅能用GPU满足AI构建的训练需求,还能用TeslaRT用来部署,很好实现AI构建,所以英伟达也率先成了这一波AI热潮的最大受益者。给机器人“造脑”,英伟达发布全新AI芯片

2018-06-11 08:20:23

阿里云上的NGC容器, 开发者们可以快速的接入深度学习框架,大大缩减了产品开发以及业务部署的时间;,用户通过阿里云和NGC即可以完成自己AI 的应用的搭建。自2015年起,阿里云就陆续推出了弹性GPU

2018-04-04 14:39:24

、GPU、FPGA及ASIC四种,依特性与使用目的不同又可区分为云端运算与边缘运算。 前者云端运算因为需要处理庞大数据,加上长时间运作,芯片需求特性为功耗较高,整体效能佳,主要应用在数据中心与超级计算机

2017-12-05 08:09:38

虽然GPU解决方案对训练,AI部署需要更多。

预计到2020年代中期,人工智能行业将增长到200亿美元,其中大部分增长是人工智能推理。英特尔Xeon可扩展处理器约占运行AI推理的处理器单元的70

2023-08-04 07:25:00

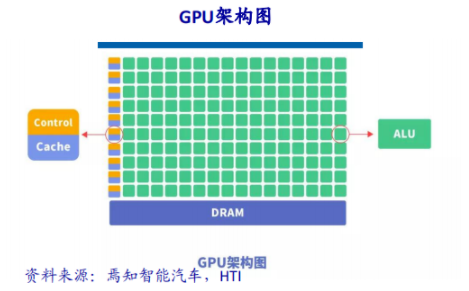

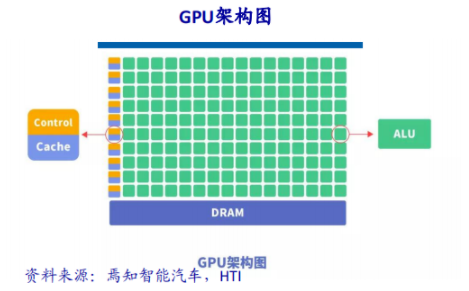

的核心处理器。GPU是显卡的“心脏”,也就相当于CPU在电脑中的作用,它决定了该显卡的档次和大部分性能,同时也是2D显示卡和3D显示卡的区别依据。图形处理芯片。GPU能够从硬件上支持T&L

2016-01-16 08:59:11

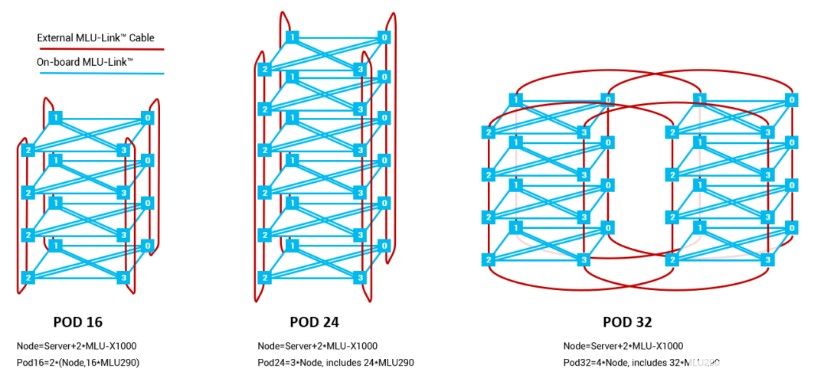

可以满足高吞吐量互联的需求,为自然语言处理、计算机视觉、语音交互等人工智能应用场景提供强大的算力支持,支撑AI算法训练和推理过程。当前在云端场景下被最广泛应用的AI芯片是英伟达的GPU,主要原因

2021-12-07 10:04:11

ai芯片和gpu的区别▌车载芯片的发展趋势(CPU-GPU-FPGA-ASIC)过去汽车电子芯片以与传感器一一对应的电子控制单元(ECU)为主,主要分布与发动机等核心部件上。...

2021-07-27 07:29:46

训练好的ai模型导入cubemx不成功咋办,试了好几个模型压缩了也不行,ram占用过大,有无解决方案?

2023-08-04 09:16:28

,在数据中心高性能计算及 AI 训练中,CPU 这一“主角”的重要性下降,而以往的“配角们”,即 GPU、FPGA、TPU、DPU 等的加速器的重要性在上升。

图3:MLP网络本质是并行的乘法和累加

2023-11-09 14:09:46

基础设施,人们仍然没有定论。如果 Mipsology 成功完成了研究实验,许多正受 GPU 折磨的 AI 开发者将从中受益。

GPU 深度学习面临的挑战

三维图形是 GPU 拥有如此大的内存和计算能力

2024-03-21 15:19:45

Habana Labs System 1H(HLS-1H)为数据中心带来了新水平的Al计算性能和电源效率,以及大规模的可扩展性。

HLS-1Hin包含四个Gaudi HL-205 Mezzanine

2023-08-04 06:06:14

英特尔正在使其GPU多样化,以与x86以外架构的处理器兼容,这可能是使其从芯片制造商成为以代工为首要业务的公司的一步。英特尔即将推出的名为Ponte Vecchio的GPU,将会和SiPearl

2022-03-29 14:41:33

月和今年7月两度树立了数据中心神经网络训练的性能标杆。今天发布的行业基准测试结果显示,NVIDIA还引领着数据中心内部与外部AI网络趋势。NVIDIA Turing GPU和Xavier 芯片系统在

2019-11-08 19:44:51

PRD1211,5 Vin,200 Vout,2 mA参考设计。本设计使用带四倍电荷泵的升压转换器。它采用创新的4级电荷泵,将升压级的输出电压提高4倍。可以使用许多不满额定输出电压的器件。此外,级联FET(Q1)用于提高ADP1613的电压能力

2019-07-17 08:11:56

使用最多的是GPU,因为它适用于单指令、多数据处理,可用于深度学习的训练和推理。英伟达AI技术中心亚太首席技术官Simon See接受第一财经采访时表示,英伟达要做通用性的芯片,“通用是我们的优势

2018-06-14 11:44:13

项目名称:基于HiSpark AI Camera的夜间目标检测项目试用计划:本人目前大四,曾做过基于STM32747ZI的疲劳检测项目,基于 Arm 处理器核的智能化 SoC

2020-11-19 20:49:15

摘要: 阿里云GPU云服务器全力支持AI生态发展,进一步普惠开发者红利,本周将会推出针对异构计算GPU实例GN5年付5折的优惠活动,希望能够打造良好的AI生态环境,帮助更多的人工智能企业以及项目顺利

2017-12-26 11:22:09

光电编码器软件四倍频和辨向程//A接P1.0,B接P1.1if((P1|0xfc)==0xfc){if(P1_temp==0xfd) {a-=0.0100*jzcs;sign=0;plus++

2015-05-20 16:39:42

可以满足高吞吐量互联的需求,为自然语言处理、计算机视觉、语音交互等人工智能应用场景提供强大的算力支持,支撑AI算法训练和推理过程。当前在云端场景下被最广泛应用的AI芯片是英伟达的GPU,主要原因

2021-12-07 09:59:04

。相较于四个 Cortex-A73核心,处理相同 AI 任务,新的异构计算架构拥有约50倍能效和 25 倍性能优势。

而且,华为第二代AI芯片海思麒麟 980也将在本季度正式量产,采用台积电

2018-05-07 09:26:47

在 FPGA、GPU 或 ASIC 控制的系统板上,仅有为数不多的几种电源管理相关的设计挑战,但是由于需要反复调试,所以这类挑战可能使系统的推出时间严重滞后。

2019-10-09 06:21:11

在 FPGA、GPU 或 ASIC 控制的系统板上,仅有为数不多的几种电源管理相关的设计挑战,但是由于需要反复调试,所以这类挑战可能使系统的推出时间严重滞后。

2019-09-30 06:59:24

突破性的飞跃,拥有了更强大的处理浮点运算的能力。当前最顶级的CPU只有4核或者6核,模拟出8个或者12个处理线程来进行运算,但是普通级别的GPU就包含了成百上千个处理单元,高端的甚至更多,这对于多媒体

2017-03-15 11:40:15

参考的数据(正弦波)是以四倍的采样时钟速率发送数据的,这是为什么呢?2.HDL代码中有IODEALY原语,如果我不适用这个原语,对信号接收会有什么影响吗?(因为我改动的里面没有使用这个)3.对于默认参数,我

2018-12-26 14:24:15

3月18日消息,继推出智能语音专用处理器R328之后,近日全志科技正式发布主打AI语音专用的重磅产品R329,这是全志科技首款搭载Arm中国全新AI处理单元(AIPU)的高算力、低功耗AI语音专用芯片。

2020-11-23 14:18:03

华为海思麒麟9000s是一款旗舰级处理器,采用了5nm工艺制程,是目前华为公司最强大的芯片之一。该芯片主要应用于华为Mate40系列手机中,其性能指标非常出色,从CPU、GPU、AI计算能力等

2023-08-31 09:34:09

。K510是嘉楠公司推出的第二代AI加速芯片,它采用双核RISC-V CPU@800Mhz,内置DSP协处理器和强大的AI运算单元KPU,支持 BF16浮点数据格式,可在边缘端进行高精度推理,是国内少有

2022-11-22 15:52:15

AmazonEC2 M6g、C6g 和 R6g 实例。这些芯片的计算核心数量是 AWS 第一代基于 Arm 核心的 Graviton处理器的两倍,其缓存的计算核心数量是其四倍。据 AWS 称,它们还拥有 5

2022-09-02 15:55:27

问题最近在Ubuntu上使用Nvidia GPU训练模型的时候,没有问题,过一会再训练出现非常卡顿,使用nvidia-smi查看发现,显示GPU的风扇和电源报错:解决方案自动风扇控制在nvidia

2022-01-03 08:24:09

所在的电信领域对开发者业务知识要求高,且电信场景多样化、网络设备复杂,华为推出的这款电信领域AI开发平台到底如何帮助开发者攻克电信领域AI开发的障碍?我们或可从AI模型开发生命周期的四个阶段“数据准备

2021-02-25 06:53:41

如何提升CPU芯片处理事件能力?

2022-02-07 09:07:12

对GPU进行数据交互。交换完成后,对每个GPU内的数据进行训练。接下来将编号0和4,1和2,3和7,5和6的四对GPU进行点数据交换。在进行4轮后,当前时间范围内的图数据将被得到训练。同时在数据交换中,我们

2022-09-28 10:37:20

ad9777芯片手册的内插问题,对ad9777的寄存器进行配置,可以实现数据的四倍内插嘛?

2023-12-01 06:03:09

CSDN下载链接:目录1 技术方案 11.1 可选方案 11.1.1 ARM 11.1.2 CPU+FPGA 11.1.3 AI芯片 11.1.4 树莓派 11.2 挑战与解决 11.2.1 挑战

2021-10-27 06:45:29

,这使得这块芯片的AI运算能力相比四个Cortex-A73核心提高至大约25倍性能和50倍能效的恐怖级别。另外的一个亮点是华为Mate 10 Pro的双摄配置,其采用了后置1200万彩色和2000万

2017-11-24 16:10:21

是人工智能大跃进的基础,在线下模型训练中Xeon-Phi、GPU等发挥着巨大的作用,而在线上的推理任务中,浪潮FPGA深度学习加速解决方案则能够实现7倍以上的能效比提升。 卷积网络之父、Facebook

2021-09-17 17:08:32

于今年 I/O 大会上推出第二代 AI 芯片 TPU。为劝说人们购买下一代设备——不管是手机、VR 头盔,甚至是汽车,所有的体验将更好,更流畅。

“消费者期待的是没有延迟,实时处理

2017-07-31 21:17:15

Times,扩大规模也带来了自身的挑战。“当你开始在计算能力方面变得更强大时,你必须处理更多的数据移动、分段、权重管理、DMA 缓冲等。”他说。Neutron 可以运行包括 CNN、RNN、TCN

2023-02-16 11:20:03

`` 为什么发起AI芯片设计众筹 ?1、传统指令驱动的处理器(CPU和GPU)已经无法支持数据驱动的AI技术,专用AI芯片已成为市场真实的强劲的需求,拥有AI芯片开发能力和经验的工程师将会受到产业

2019-07-19 11:54:01

高通(Qualcomm)不只是一家在移动SoC芯片和3G通信技术上造诣颇深的公司,而且是一家拥有移动GPU自主设计能力和生产能力的公司。移动GPU是SoC芯片的一部分,与ARM架构的通用处理器(CPU)一起构成SoC芯片体现应用性能的两个重要部分。·······

2011-08-09 10:52:23

AI实现的特点有哪些?AI芯片设计和开发面临哪些挑战?

2021-11-02 09:19:08

背景介绍数据、算法和算力是人工智能技术的三大要素。其中,算力体现着人工智能(AI)技术具体实现的能力,实现载体主要有CPU、GPU、FPGA和ASIC四类器件。CPU基于冯诺依曼架构,虽然灵活,却

2021-07-26 06:47:30

。能力优势99.5%的识别精确度海量训练数据,数据源丰富多样,精确度高于99.5%,误检率只有万分之一。四个级别精细区分可区分色情、高度性感、性感、正常四个级别,识别更为精细化。应用场景UGC内容鉴黄

2018-08-03 12:48:59

最先进的人工智能模型在不到五年的时间内经历了超过 5,000 倍的规模扩展。这些 AI 模型严重依赖复杂的计算和大量内存来实现高性能深度神经网络 (DNN)。只有使用 CPU、GPU 或专用芯片等

2023-07-28 10:10:17

,支持广泛的应用程序和动态工作负载。本文将讨论这些行业挑战可以在不同级别的硬件和软件设计采用Xilinx VERSAL AI核心,业界首创自适应计算加速平台超越了CPU/GPU和FPGA的性能。

2020-11-01 09:28:57

。 X2000 作为一个端侧 AI 平台,其能力是综合的:既有固化在芯片中的硬能力,如 XBurst 2 的算力、指令集、内存管理,也有北京君正团队多年耕耘掌握自主可控的操作系统和各类物联网应用开发支持套件

2022-10-09 14:33:09

在没有正交编码器计数器接口的电路中,对于速度不高的编码器,可以用软件的方式来实现原理过程参考此文档:编码器四倍频电路的单片机高速算法设计 - 百度文库 (baidu.com)正交编码器鉴相表前一个

2022-01-12 07:35:07

自动驾驶车辆中采用的AI算法自动驾驶车辆中AI面临的挑战

2021-02-22 06:39:55

设计采用ADP1613升压转换器和四倍电荷泵。它采用创新的4级电荷泵,将升压级的输出电压提高4倍。可以使用许多不满额定输出电压的器件。此外,级联FET(Q1)用于提高ADP1613的电压能力。使我们能够使用非常便宜的集成FET升压控制器

2019-07-16 06:35:37

基本的关键词识别编码并借助后台的内容逻辑编码树把对应的内容抓取输出而已。对完整语义的识别和上下文对话能力还很弱,更不要说多轮的自然语言交互。只有经过较长时间大量的训练和校准,机器人的客户需求识别与问题响应能力

2018-04-10 10:48:40

的服务器通常配置2个CPU+四个GPU,甚至有的厂商推出了一机8卡,一机16卡的服务器。 随着单机GPU数量的不断增加,前端计算系统的计算能力和计算密度得到了极大的提升,这也给后端的存储系统带来极大

2018-08-23 17:39:35

FM-20500423 是一个将5 - 12.5 GHz 输入频率信号四次倍频到20 - 50 GHz 信号并放大输出的四倍频放大器,独特的设计使得它在约3 dBm

2022-04-25 10:13:40

Nano4th 四倍频转换器Nano4th是一款紧凑型四倍频转换器,可将飞秒低能量红外激光脉冲(nJ范围)转换为2次和4次谐波,且转换效率。它的工业级设计,使其成为一个强大而可靠的解决方案,将扩展您

2023-05-24 09:33:33

在为这样的大规模应用部署GPU加速时,出现了一个主要的技术挑战:训练数据太大而无法存储在GPU上可用的存储器中。因此,在训练期间,需要有选择地处理数据并反复移入和移出GPU内存。为了解释应用程序的运行时间,研究人员分析了在GPU内核中花费的时间与在GPU上复制数据所花费的时间。

2018-03-26 10:29:15 4282

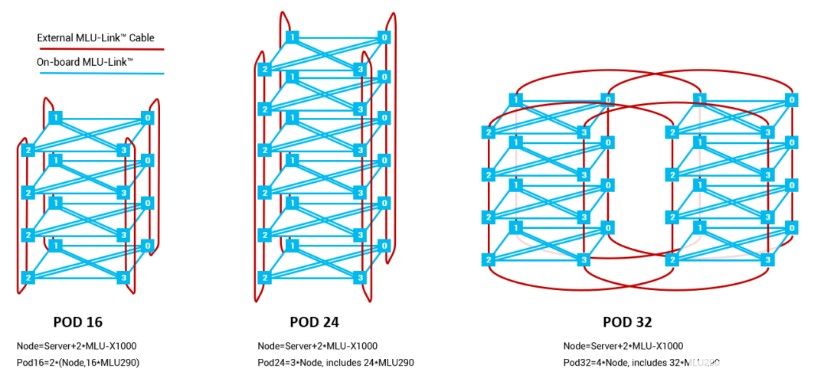

4282 虽然近年来 GPU 硬件算力和训练方法上均取得了重大进步,但在单一机器上,网络训练所需要的时间仍然长得不切实际,因此需要借助分布式GPU环境来提升神经网络训练系统的浮点计算能力。

2018-05-28 11:11:39 4859

4859

联发科技今日宣布推出曦力P70(Helio P70)系统单芯片(SoC),其增强型AI引擎结合CPU与GPU的升级,实现了更强大的AI处理能力。

2018-10-26 09:50:06 3904

3904 亚马逊宣布推出Inferentia,这是由AWS设计的芯片,专门用于部署带有GPU的大型AI模型,该芯片将于明年推出。

2018-12-03 09:46:08 1753

1753 昨日,阿里达摩院发布2019十大科技趋势,其中就指出:AI专用芯片将挑战GPU的绝对统治地位。当下数据中心的AI训练场景下,计算和存储之间数据搬移已成为瓶颈,新一代的基于3D堆叠存储技术的AI芯片架构已经成为趋势。

2019-01-04 15:52:00 1579

1579 阿里达摩院官网公布2019十大科技趋势:AI仍是最火方向,其中,语音AI在特定领域有望通过图灵测试、自动驾驶则进入冷静发展期、AI专有芯片将挑战GPU绝对统治地位;数字身份有望成为第二张身份证;5G连接能力将增强至百亿级。

2019-01-05 10:00:56 5846

5846 芯片进行基因体定序与优化语音辨识所需的深度学习,察觉FPGA 的耗能低于GPU 且处理速度较快。相较于GPU 只能处理运算,FPGA 能以更快速的速度一次处理所有与AI 相关资讯。

2019-01-18 14:14:42 499

499 当前主流的AI芯片主要分为三类,GPU、FPGA、ASIC。其中GPU、FPGA均是前期较为成熟的芯片架构,属于通用型芯片。ASIC属于为AI特定场景定制的芯片。

2019-03-07 14:39:21 29058

29058 以色列AI芯片公司Habana Labs上周宣布,推出人工智能处理器Gaudi,专供机器学习训练(inference)任务。公司首席执行官David Dahan 称Gaudi带来了业界最高的性能,基于Gaudi训练系统,可实现比拥有相同数量的GPU系统高近四倍的处理能力。

2019-06-28 10:17:01 1477

1477 到目前为止,云端AI市场一直由英伟达的GPU和英特尔的CPU主导,来自中国的三位挑战者,寒武纪云端AI芯片思云270、华为云端训练芯片昇腾910和平头哥云端推理AI芯片含光800的公开发布,在这个竞争激烈的市场,中国挑战者正试图撬开市场的版图。

2019-09-27 08:59:37 6860

6860 在GPU编程方面,阿里云会推出分布式多机多卡训练框架和其他GPU上的性能优化服务,能够大大降低客户使用多机多卡的门槛,从而减少客户在云上做深度学习训练的时间。

2019-10-14 14:29:04 487

487 据悉,Habana Labs创立于2016年,致力于提高AI芯片的处理性能并降低其成本和功耗,其AI芯片主要针对深度神经网络训练的特定需求。

2019-12-06 09:53:23 2106

2106 Habana Gaudi 芯片是为训练神经网络而设计的,包括支持 ROCE 以实现远程存储访问的片上 100Gb 结构。

2020-02-03 18:54:38 449

449 Habana已经开发了两款自己的AI芯片,即Habana Gaudi和Habana Goya(如图)。前者是高度专门化的神经网络训练芯片,而后者是用于推理的处理器,在主动部署中使用神经网络。

2020-02-06 15:06:10 2189

2189 针对GPU制造商最直接的产品是Nervana NNP-T1000神经网络处理器。它是针对硬件密集型任务进行优化的集成电路,该任务使用示例数据训练AI模型。今天,此过程对于确保模型产生准确的结果是必不可少的,如今已在绝大多数AI项目中使用Nvidia芯片进行了此过程。

2020-03-24 15:19:30 2337

2337 训练最新 AI 系统需要惊人的计算资源,这意味着囊中羞涩的学术界实验室很难赶上富有的科技公司。但一种新的方法可以让科学家在单台计算机上训练先机的 AI。2018 年 OpenAI 报告每 3.4 个月训练最强大 AI 所需的处理能力会翻一番,其中深度强化学习对处理尤为苛刻。

2020-07-29 09:45:38 580

580 狗的训练通常情况下都需要人的参与,但如果没有人的参与会带来更好的结果吗?在旧金山动物保护组织 SPCA 的合作下, 名为 Companion Labs 的初创公司近日推出了首款用于训练狗的AI 训练机--CompanionPro。

2020-11-26 11:50:39 1242

1242 在近日举办的re:Invent开发人员大会上,AWS宣布推出全新的AI训练芯片AWS Trainium,这是该公司用于训练机器学习模型的下一代定制芯片。该公司承诺,通过对TensorFlow,PyTorch和MXNet的支持,它可以提供比云中任何竞争对手更高的性能。

2020-12-02 15:21:30 1940

1940 1月21日,寒武纪思元290智能芯片及加速卡、玄思1000智能加速器在官网低调亮相,寒武纪表示该系列产品已实现规模化出货。去年,寒武纪招股书曾简单披露了一款训练芯片的“彩蛋”,此后,寒武纪思元290

2021-01-21 13:52:15 2205

2205

三星宣布新的HBM2内存集成了AI处理器,最高可提供1.2 TFLOPS嵌入式计算能力,使内存芯片本身可以执行CPU、GPU、ASIC或FPGA的操作。

2021-02-20 16:35:46 1841

1841 在MLCommons近日发布的AI性能行业基准测试结果中,代号为Sapphire Rapids的第四代英特尔至强可扩展处理器和专用于深度学习AI训练的Habana Gaudi2加速器展现了卓越的训练表现。

2022-12-01 15:24:24 381

381 使用光而非电的处理器有望成为实现人工智能的一种更快、更节能的方式。到目前为止,它们只用于运行已经训练过的模型,但新的研究首次证明了在光学芯片上训练人工智能的能力。

2023-05-25 10:57:51 669

669 当chatgpt掀起一股新的ai大规模模型热潮时,提供基本计算能力的nvidia是最大的受惠者之一,而nvidia的gpu产品几乎没有能够替代大规模模型训练的东西。

2023-06-05 10:58:42 1090

1090 1 英特尔发布Gaudi2争夺AI芯片市场 7月11日,英特尔面向中国市场推出了AI芯片 Habana Gaudi 2,Gaudi 2直接对标英伟达GPU的100系列,欲争夺AI算力市场的宝座

2023-07-13 11:21:38 353

353 nvidia的a100、h100和其他ai gpu目前使用控制台来制造晶片和2.5包的前端工程。nvidia ai gpu使用的hbm芯片由sk海力士独家提供。但是tsmc没有能力处理2.5d包装所需的所有工作。

2023-07-20 10:45:23 538

538 AI芯片也被称为AI加速器或计算卡,即专门用于处理人工智能应用中的大量计算任务的模块(其他非计算任务仍由CPU负责)。当前,AI芯片主要分为 GPU 、FPGA 、ASIC。

2023-08-03 17:19:11 1812

1812 AI芯片在处理大规模数据和复杂计算任务(例如深度学习算法)时具有更高的计算性能。它们通常集成了多个高性能的计算单元,如GPU(图形处理器)或专门的神经网络处理器(NPU)。

2023-08-05 16:11:02 4015

4015

人工智能(AI)芯片和图形处理单元(GPU)芯片都是现代计算机中使用的重要组件。虽然两者可以用于处理大规模数据,但它们的设计目的是不同的。在本文中,我们将深入探讨两种芯片之间的区别,以及各种应用。

2023-08-07 17:42:27 3745

3745 ai芯片和gpu芯片有什么区别? AI芯片和GPU芯片是当今比较流行的芯片类型,它们都是为了更好地处理数据而设计的。虽然它们都在处理数据方面有类似之处,但在设计和使用方面还是有很大的区别。 首先

2023-08-08 18:02:28 3597

3597 GPU 的 A3 GPU 虚拟机,加速 AI 模型训练速度 谷歌云近日宣布,他们将在下个月正式推出搭载 Nvidia H100 GPU 的 A3 GPU 虚拟机。这款 A3 虚拟机结合

2023-08-31 13:00:07 377

377

星火一体机将提供从底层算力、AI框架、训练算法、推理能力、应用成效等全栈AI能力,可用于问答系统、对话生成、知识图谱构建、智能推荐等多个领域的应用,具备大模型预训练、多模态理解与生成、多任务学习和迁移等能力。

2023-09-01 14:46:56 800

800 生成式AI和大语言模型(LLM)正在以难以置信的方式吸引全世界的目光,本文简要介绍了大语言模型,训练这些模型带来的硬件挑战,以及GPU和网络行业如何针对训练的工作负载不断优化硬件。

2023-09-01 17:14:56 1046

1046

浪潮信息宣布旗下NF5468系列AI服务器率先支持英伟达最新推出的L40S GPU,可为人工智能大模型训练和推理、元宇宙及图形视频处理等应用提供强大算力。实际测试表明,搭载8颗NVIDIA L40S

2023-09-22 11:20:54 1440

1440 。为了解决这个问题,英伟达将针对中国市场推出新的AI芯片,以应对美国出口限制。本文将探讨如何在多个GPU上训练大型模型,并分析英伟达禁令对中国AI计算行业的影响。

2023-11-16 11:39:31 898

898

在计算领域,GPU(图形处理单元)一直是性能飞跃的代表。众所周知,高端GPU的设计充满了挑战。GPU的架构创新,为软件承接大模型训练和推理场景的人工智能计算提供了持续提升的硬件基础。GPU架构

2023-12-21 08:28:00 381

381

Nvidia 计划在 2024 年推出大量新的加速器、GPU 架构和网络套件。英特尔将与新的 Habana Gaudi AI 芯片一起推出可以说是多年来最引人注目的 Xeon。

2024-01-11 10:27:28 302

302

大模型训练和推理的硬件以通用图形处理单元(GPU)为主,2022年全球GPU市场规模达到448.3亿美元,美国AI芯片巨头英伟达公司占有80%的市场份额并仍在持续攀升。

2024-01-19 14:12:38 268

268

电子发烧友App

电子发烧友App

评论