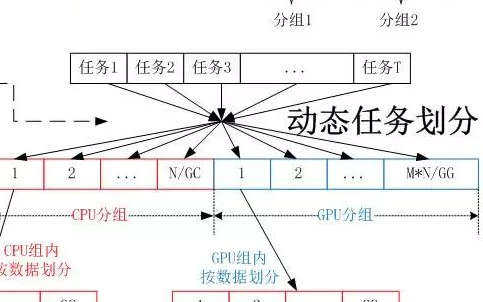

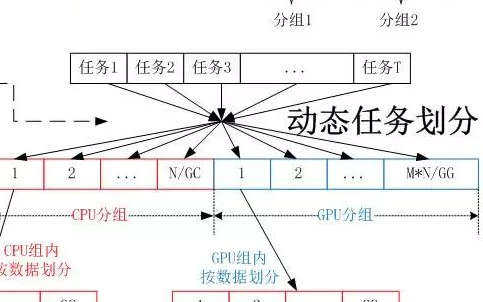

在CPU+GPU协同计算中,CPU和GPU的计算能力不同,静态地给CPU和GPU划分任务会导致CPU和GPU计算不同步,导致严重的负载不均衡,为了实现CPU和GPU的负载均衡,需要对CPU和GPU不同的划分方法。

2018-05-03 09:01:29 6452

6452

中所有的元素进行和、最大值或乘积计算。Brook还完全隐藏了图形API的所有细节,并把GPU中类似二维存储器系统这样许多用户不熟悉的部分进行了虚拟化处理。用Brook编写的应用程序包括线性代数子程序

2016-01-16 08:59:11

GPU150HF120D2

2023-03-28 18:08:25

GPU300HF120D2

2023-03-29 17:17:40

GPU450HF120D2SE

2023-03-28 18:08:25

,以增强游戏用户体验。何以实现?一个字:快!GPU并行计算的基础结构、可以执行海量数据计算;GPU访存速度快;GPU拥有更高的浮点运算能力,对图形与媒体加工速度快。RTX的光追为水面镜面带来逼真的光影

2021-12-07 10:04:11

CPU负担过大,甚至无法进行其他运算。因此,增加GPU这个构建,专门用于图像的计算,从而使CPU脱离出来去做其他事情...

2021-07-19 08:48:12

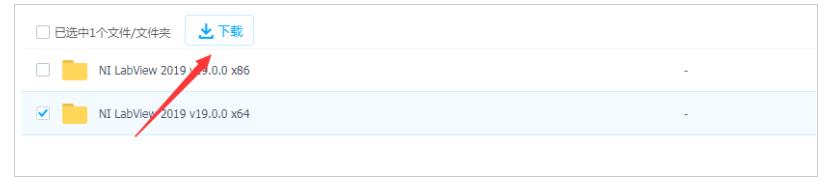

labVIEW读取excel数据并进行计算

2018-04-17 09:16:32

硬件:AM5728

软件:ti-processor-sdk-linux-am57xx-evm-03.00.00.04-Linux-x86-Install.bin

编译器:arm-linux-gnueabihf-gcc

AM5728 可以调用GPU用于通用数学计算吗?通过何种方式和接口,有没有文档或者范例?

谢谢。

2018-06-01 11:39:47

多得多的处理单元。这使马里™ GPU可以在不使用更多功率的情况下以比应用程序处理器更高的速率进行计算。

马里™ GPU可以有一个或多个着色器核心。

标量指令是并行执行的,因此GPU同时对多个数据元素进行操作。执行此操作不需要对代码进行矢量化

2023-08-10 07:47:19

嵌入式算法移植优化学习笔记5——CPU,GPU,TPU,NPU都是什么一、什么是CPU?二、什么是GPU?三、什么是TPU?四、什么是NPU?附:一、什么是CPU?中央处理器(CPU),是电子计算

2021-12-15 06:07:07

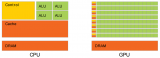

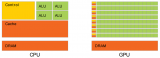

CPU和GPU都是具有运算能力的芯片,CPU更像“通才”——指令运算(执行)为重+ 数值运算,GPU更像“专才”——图形类数值计算为核心。在不同类型的运算方面的速度也就决定了它们的能力——“擅长

2017-12-03 15:43:58

CPU和GPU都是具有运算能力的芯片,CPU更像“通才”——指令运算(执行)为重+ 数值运算,GPU更像“专才”——图形类数值计算为核心。在不同类型的运算方面的速度也就决定了它们的能力——“擅长

2017-12-03 20:08:47

上涨,因为事实表明,它们的 GPU 在训练和运行 深度学习模型 方面效果明显。实际上,英伟达也已经对自己的业务进行了转型,之前它是一家纯粹做 GPU 和游戏的公司,现在除了作为一家云 GPU 服务

2024-03-21 15:19:45

的高性能计算机,但没有提到该CPU是基于Arm Neoverse V1设计的。英特尔没有回复关于英特尔GPU与PC和服务器中Arm处理器兼容性的评论。Ponte Vecchio还将在即将到来的极光超级计算

2022-03-29 14:41:33

这边是NVIDIA HR Allen, 我们目前在上海招聘GPU高性能计算架构师(功能验证)的岗位,有意向的朋友欢迎发送简历到 allelin@nvidia.comWechat

2017-09-01 17:22:28

TensorFlow 支持 CPU 和 GPU。它也支持分布式计算。可以在一个或多个计算机系统的多个设备上使用 TensorFlow。TensorFlow 将支持的 CPU 设备命名为

2020-07-28 14:33:28

嗨,我在ESX 6中使用GRID K2。Atm有像GPU0和GPU1之间的负载平衡。如果我在主机上打开2 K240q,则第一个VM被分配给GPU0,即第二个GPU1。我无法启动此主机上的任何

2018-09-10 17:14:36

请问一下XS GPU是什么?XS GPU的主要特性包括哪些?XS GPU具备哪些功能?主要应用于哪些领域?

2021-07-01 06:55:05

openharmony怎么调用芯片里的GPU进行视频和图片的编解码?

每个不同的芯片需要单独调整适配吗?

2023-08-14 15:10:26

openharmony怎么调用芯片里的GPU进行视频和图片的编解码?

比如RK3588等。openharmony 3.2 Release。

2023-08-14 15:04:23

【嵌入式AI】多目标分类检测系统实战中,tengine是如何使用arm的GPU进行加速的,这个原理能详细说明一下吗?

2022-09-02 14:18:54

无论是人工智能、高性能计算,还是汽车或TWS,我们已经在各种产品形态中看到了RISC-V的身影。然而,有一种产品却成了RISC-V长久以来的痛,那就是GPU。固然,RISC-V在某些方面已经有了不逊

2022-03-24 15:53:12

的参数空间已从百万级上升到百亿级,这对计算能力提出了新的挑战。相比CPU,GPU更适合深度学习的神经网络模型,可进行高度统异构计算明星规格族“GN5”。阿里云异构计算通用实例“GN5”规格族就是一款

2017-12-26 11:22:09

我们知道DSP芯片处理数字信号速度快,精度高,那为什么计算机不用DSP而是用CPU/GPU呢?或者说计算机有哪个模块是使用了DSP的吗?那么计算机中有硬件乘法器吗?

2018-05-20 16:51:52

算法计算力CPU、GPU、TPUCPU和GPU的简单对比:CPU主要适合I/O密集型的任务GPU主要适合计算密集型的任务那么什么样的程序适合在GPU上运行呢?1...

2021-09-07 07:56:00

Arm拥有跨所有处理器的计算IP。而且,无论您要在GPU,CPU还是NPU上进行ML推理,都可以在一个通用框架下使用它们:Arm NN。Arm NN是适用于CPU,GPU和NPU的开源推理引擎。它

2022-04-11 17:33:06

是否可以使用NVidia虚拟化在云计算中使用GPU虚拟化创建VM群集?怎么能实现呢?以上来自于谷歌翻译以下为原文Is it possible to use NVidia virtualization

2018-09-30 10:47:56

如果没有其他用户共享K520,您是否可以抓取两个GPU进行CUDA计算作业?我们的应用程序使用GPU进行显示和计算。当我们在AWS K520实例上运行时,CUDA只能看到K520上的一个GPU。我们

2018-09-26 15:23:49

我在xenserver 6.2 SP1上的传递模式中有K2,我正在尝试确定我的应用程序如何强调GPU。我添加了nvidia WMI包,但是对于我关心的所有GPU值,例如内存和%GPU,windows

2018-10-10 16:17:40

如何对RK GPU进行调试呢?有哪些技巧呢?

2022-02-15 07:21:08

较慢的CPU,将NN的FPGA实现与GPU / NPU和ASIC的实现进行一下对比。事实证明,FPGA的独特优势在于其可重新配置能力。这也解释了为什么目前很多学术资源研究如何将FPGA高效地用于NN

2023-02-08 15:26:46

怎么使用ARM处理器上的GPU进行编程工作呢?有哪位大神可以解释一下

2022-08-04 14:17:35

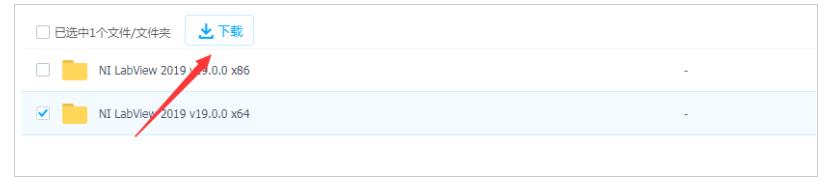

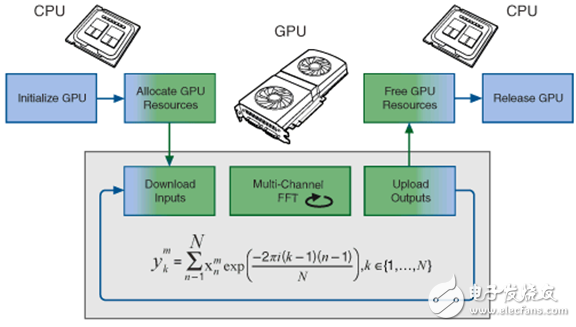

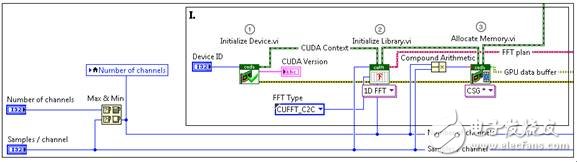

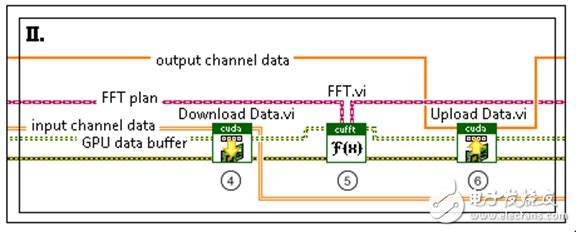

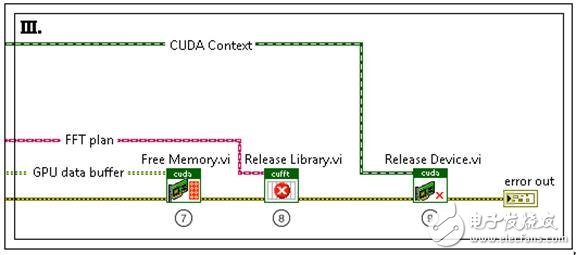

最近在看labview中GPU模块的使用,但是GPU模块只有3个例子,难懂啊。有木有大神会的

2014-03-12 10:05:14

最近在准备做个树莓派GPU编程的项目,发现水还是很深的。不过还是有一些心得,准备稍微整理一下,留作后来人的参考。先放一张图:分别是CPU和GPU计算的效率对比具体内容,元旦后整理作为一个系列,也作为自己的一个纪念。

2016-12-28 23:13:26

通用计算。移动端的GPU主要以基于tile的计算为主,mali的全系列(截止目前)都是基于tile的计算。基于tile的计算可以简单的认为,在进行计算的时候一张图会被划分成若干张小矩形,每个矩形可以

2022-04-12 11:01:11

,是英伟达十多年来在计算机图像领域最大的创新。据悉,三款新 GPU 预计今年第四季度发售,Quadro RTX 8000 配备 48GB 内存,售价 10000 美元;Quadro RTX 6000

2018-08-15 10:59:45

Mali T604 GPU的结构是由哪些部分组成的?Mali T604 GPU的编程特性有哪些?Mali GPU的并行化计算模型是怎样构建的?基于Mali-T604 GPU的快速浮点矩阵乘法并行化该如何去实现?

2021-04-19 08:06:26

我在用RK3399pro的NPU做深度学习计算,使用了两个rknn模型进行推理,但是在这两个rknn模型之间需要进行一些中间计算(从第一个模型输出到第二个模型输入之间的计算),计算主要是对图像进行

2022-05-09 15:26:51

谁有labview2013GPU工具包的学习资料?

2014-07-10 22:39:43

软件工具可以提供帮助。两种高级描影语言CG和HLSL能够让用户编写类似C的代码,随后编译成碎片程序汇编语言。Brook是专为GPU计算设计,且不需要图形知识的高级语言。因此对第一次使用GPU进行开发

2015-11-04 10:04:53

本文讨论了应用G 语言平台labview 进行Monte Carlo 模拟实验,并以敌我双方的射击实验为实例进行详细说明。

2009-09-23 11:05:20 9

9 l强大的处理能力 GPU接近1Tflops/s

l高带宽 140GB/s

l低成本 Gflop/$和Gflops/w高于CPU

l当前世界超级计算机五百强的入门门槛为12Tflops/s

l一个

2010-08-16 16:12:21 0

0 GPU将开创计算新纪元

魏鸣,是NVIDIA公司中国区市场总监。

美国著名计算机科学家、田纳西州大学计算机创新实验室主任Jack Dongarra博士曾经说过,将来的计算

2009-12-30 10:17:39 1220

1220 NVIDIA采用了两项关键技术——G80统一图形与计算架构(最先采用于GeForce 8800、Quadro FX 5600与Tesla C870 GPU)和CUDA。CUDA作为一种软硬件架构,可采用多种高级编程语言对GPU进行编程

2011-08-09 09:56:27 2593

2593 在微处理器上用LabVIEW进行快速原型周勇

2013-09-13 14:42:44 79

79 用于Labview实现简单的计算器,可以简单计算四则运算,比较一目了然和容易理解。

2016-03-28 16:14:55 157

157 Labview之计算e近似值,很好的Labview资料,快来下载学习吧。

2016-04-19 10:56:22 0

0 Labview之复杂公式计算,很好的Labview资料,快来下载学习吧。

2016-04-19 10:56:22 0

0 Labview之函数计算与绘图,很好的Labview资料,快来下载学习吧。

2016-04-19 10:56:22 0

0 Labview之函数计算与绘图,很好的Labview资料,快来下载学习吧。

2016-04-19 10:56:22 0

0 以前寫論文收集的一些資料,学习labview的好资料!!!!

2016-10-25 17:14:10 8

8 基于LabVIEW的泰克示波器与计算机的通信

2016-12-14 21:50:03 40

40 虚拟化环境下多GPU并行计算研究_闵芳

2017-01-03 15:24:45 0

0 labview实现简单计算器功能

2017-03-23 14:30:36 33

33 labview的计算器代码分享

2017-05-04 15:34:03 0

0 本文详细介绍了Labview进行仪器控制的原因。

2017-11-15 14:15:28 11

11 梯度投影算法求解对偶变量。数值实验分别在GPU与CPU上进行。实验结果表明,总变分去噪模型对偶算法在CPU设备上执行的效率高于在CPU上执行的效率,并且随着图像尺寸的增大,GPU并行计算的优势更加突出。

2017-12-18 17:09:02 1

1 针对目前医学图像配准技术无法满足临床实时性需求问题,对基于图形处理器( GPU)加速的医学图像配准技术进行综述探讨。首先对GPU通用计算进行概述,再以医学图像配准基本框架为主线,对近年来基于GPU

2018-01-03 11:08:49 1

1 下图对CPU与GPU中的逻辑架构进行了对比。其中Control是控制器、ALU算术逻辑单元、Cache是cpu内部缓存、DRAM就是内存。可以看到GPU设计者将更多的晶体管用作执行单元,而不是

2018-05-07 11:47:00 25803

25803

如何快速开发LabVIEW项目,成为LabVIEW开发的高手。如果您手里有LabVIEW项目,领导催的又很紧,该怎么办? 如果您公司规模小,就想把LabVIEW项目快速搞定,有什么好的途径?

2018-09-28 17:41:18 63

63 了新的可能性。利用工业标准计算机的强大性能和LabVIEW的灵活性,您可以完成自定义的音频测量。本文描述了如何使用LabVIEW以及声音与振动工具包对音频数据进行采集、分析与显示。我们将会演示最常见的测量以及在音频测量过程中完成多个任务的LabVIEW代码。 介

2018-10-08 00:58:01 505

505 这个章节将集中介绍 LabVIEW 软件中的控制系统设计的基本特性。我们在这里假定读者们已经熟悉了 LabVIEW 软件的其它部分。在我们开始之前,请确保你的计算机上已经安装了可使用的控制设计和仿真工具包。

2019-01-17 08:00:00 15

15 本文档的主要内容详细介绍的是使用LabVIEW的SQL进行连接的程序免费下载。

2019-09-26 08:00:00 11

11 英特尔公布了一款基于Xe架构的通用GPU,专门针对高性能计算和人工智能加速进行优化,研发代号为“Ponte Vecchio”。

2019-11-19 09:09:09 685

685 利用LabVIEW进行图像处理是一个非常重要的应用。在许多行业中采用图像的采集和识别来进行判断、控制,使操作更加精确,具有可信度、人性化、智能化。本节将讲解利用LabVIEW进行图像采集和处理的实例。

2019-11-21 08:00:00 18

18 NVIDIA从提出GPU以及CUDA核心开始,NVIDIA便开始逐步迈出游戏圈,不断向全新的计算领域发起攻势。时至今日,NVIDIA GPU计算从机器人、自动驾驶,一路扩展到云计算、医疗甚至是NASA火星登录计划。

2019-12-23 09:12:33 6930

6930 PC在刚诞生的时候,其实是没有GPU的,所有的图形计算都由CPU来计算。后来人们意识到CPU做图形计算太慢了,于是他们设计了专门的图形加速卡用来帮忙处理图形计算,再后来,NVIDIA提出了GPU的概念,将GPU提升到了一个单独的计算单元的地位。

2020-01-01 17:31:00 5656

5656

LabVIEW概述 LabVIEW是一种程序开发环境,由美国国家仪器(NI)公司研制开发,类似于C和BASIC开发环境,但是LabVIEW与其他计算机语言的显著区别是:其他计算机语言都是采用基于文本

2020-05-07 08:49:10 13833

13833

本文将概括了在LabVIEW中可用的几种计算模型,以及何时使用这些模型的指南。

2021-04-25 15:46:28 21

21 在本文中,我们首先介绍下GPU及其分类,并简单回顾下GPU绘制流水线的运作,最后又如何演化为通用计算平台。

2021-06-15 10:37:22 9988

9988

计算器labview实现的课程实验报告

2022-01-13 14:07:04 26

26 GTC2022大会黄仁勋:Hopper 实现首个GPU机密计算,是处理器架构和软件的结合,每个Hopper 实例都支持在受信任执行环境中进行机密计算。

2022-03-23 17:47:26 1805

1805

NVIDIA 与智东西公开课共同策划推出「GPU 加速高性能计算(HPC)经典应用在线研讨会」。研讨会将聚焦经典高性能计算和科学计算应用,以及如何在 GPU 平台更好的加速这些应用。

2022-05-27 09:53:19 1274

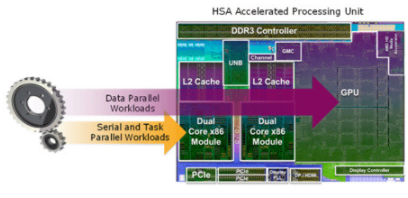

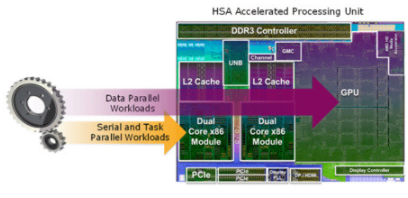

1274 具体来说,教程是异构系统架构——下一代异构计算的基础,以及医疗和打印成像中的 GPU 计算,而小组的主题是异构系统架构:未来的功率、性能和编程。

2022-06-13 10:12:30 1089

1089

NVIDIA 与智东西公开课共同策划推出「GPU 加速高性能计算(HPC)经典应用在线研讨会」。研讨会将聚焦经典高性能计算和科学计算应用,以及如何在 GPU 平台更好的加速这些应用。

2022-06-22 10:06:32 1307

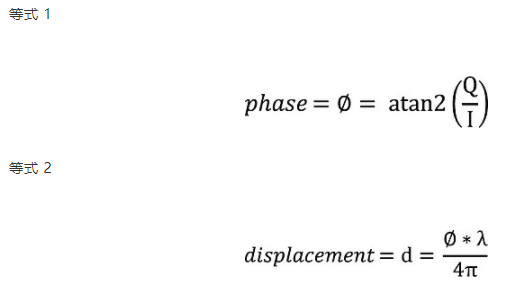

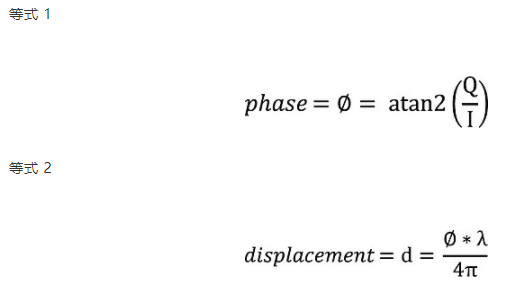

1307 平均而言,GPU 计算位移的时间为 51.50 毫秒,而 CPU 计算的时间为 621.5 毫秒。凭借其高度并行的架构,GPU 的性能比 CPU 高出 12 倍。梳理 GPU 时序测量进一步显示

2022-08-11 15:00:38 680

680

可进行labview激活的工具免费下载。

2022-09-07 14:28:06 8

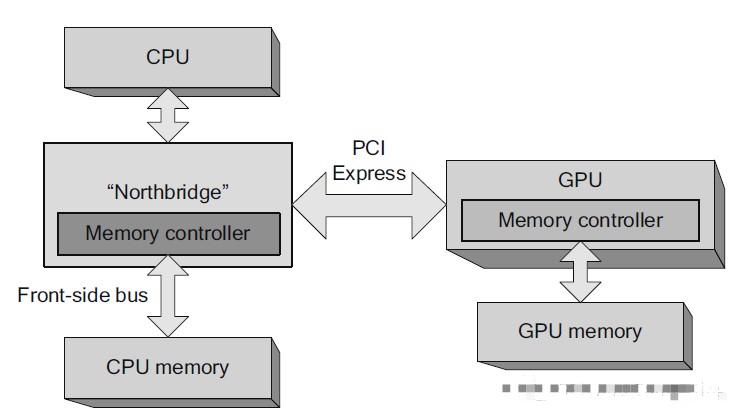

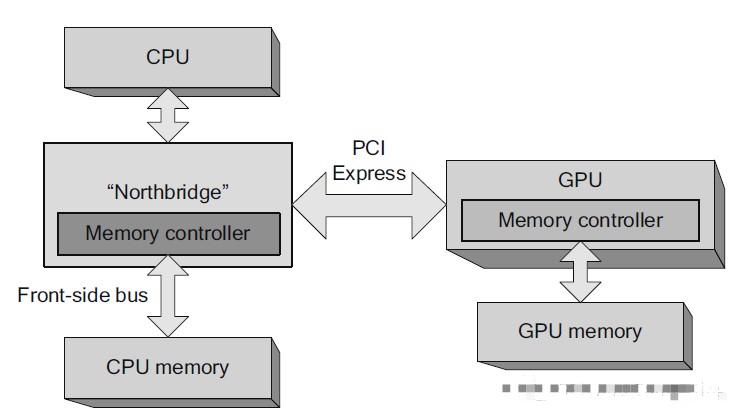

8 GPU是协处理器,与CPU端存储是分离的,故GPU运算时必须先将CPU端的代码和数据传输到GPU,GPU才能执行kernel函数。涉及CPU 与GPU通信,其中通信接口PCI-E的版本和性能会直接影响通信带宽。

2022-11-29 14:48:25 4491

4491 LabVIEW 是 许多 数据 采集 应用 的 常用 编 程 环境。DATAQ 仪器 硬件 产品 可以 通过 应用 我们 的 ActiveX 软件 工具 在 LabVIEW 下 进行 编 程。

2022-12-02 15:44:16 1245

1245

在异构计算架构中,GPU与CPU通过PCIe总线连接在一起来协同工作,CPU所在位置称为为主机端(host),而GPU所在位置称为设备端(device),两者优势互补。

2023-01-10 09:54:51 2428

2428 labview计算器程序分享

2023-05-29 10:34:39 12

12 Labview的9点标定计算 矩阵运算公式 直接运行 不依赖其他库

2023-06-15 18:09:03 47

47 GPU 任务会交替的使用 CPU 和 GPU 进行计算,当 CPU 计算成为瓶颈时,就会出现 GPU 等待的问题,GPU 空跑那利用率就低了。

2023-06-19 12:22:22 860

860

来源:渲大师在没有GPU之前,基本上所有的任务都是交给CPU来做的。有GPU之后,二者就进行了分工,CPU负责逻辑性强的事物处理和串行计算,GPU则专注于执行高度线程化的并行处理任务(大规模计算任务

2023-07-31 23:46:13 588

588

labview计算秒小程序

2023-08-21 10:34:51 2

2

正在加载...

电子发烧友App

电子发烧友App

评论