从本科到研究生阶段,再到2014年出来创业以后,这前后大概5年的时间里,我始终聚焦在视觉领域的学习。所以能够比较清晰地看到,在这几年时间里,以视觉为核心的,包括人脸识别、物体识别、空间定位、导航避障等在内的感知层算法正在随着底层人工智能的基础型算法架构(比如我们现在熟知的机器学习、深度学习,以及最近很火的增强学习)和硬件传感器的发展产生着日新月异的变化。

在实验室的时候,我的主要研究方向是为特种机器,包括微小型的无人机、功能性的机器人构建一套以视觉感知为主的机器人视觉系统,而在2011年后发展起来的这一波感知层算法的进步与传感器硬件上面的推陈出新恰恰为这样的研究提供了有利的支持,以至于到今天推动了整个资本市场上对于人工智能项目的大热与追捧。

下面,我将从机器人视觉系统、视觉技术原理和未来发展趋势三个方面,为大家讲述我们是如何为机器人构建起一个“三维世界”的。

机器人视觉系统发展与三维视觉的兴起

我们知道“机器人”这一名词是1920年一位捷克作家在一本科幻剧中提出的,到了1950年前后,另一位美国作家阿西莫夫才系统性的提出了“机器人学”这一概念,并给出了著名的机器人三定律。在那之后,从1970年,随着计算机的兴起,现代控制技术、传感器技术的发展,机器人开始了真正的产品化的进程。也正是从那个时候开始,搭载一颗基于CCD芯片摄像头的机器人,可以为人们提供某一时刻的光学影像信息记录,而这也形成了最早期的机器人视觉系统。值得一提的是,1969年美国的阿波罗登月飞船上搭载的正是基于CCD感光芯片的照相机,为机器人视觉系统的硬件架构提供了系统性的参照。由于具备一定的简单的记忆存储能力,那个时候的机器人可以进行简单的重复作业,但是对周围环境没有任何感知与反馈控制能力,我们称当时的机器人为第一代机器人。

时间推进到80年代,视觉传感器、力触觉传感器、接近传感器和计算机在这一时期进入到了快速发展期,特别是摩尔定律的发现代表着信息技术的发展速度在这一时期确确实实到了顶峰。这一时期的机器人已经具备了一定的感知能力,能够获取作业环境与作业对象的部分信息,并进行一定的实时处理,引导机器人进行作业。比如下图我们看到的当时美国斯坦福研究所开发实现的Shakey移动机器人,拥有电子摄像头、测距仪等感知设备,建立了一套底层到顶层的分层控制机制和当时最先进的视觉系统,用来帮助机器人在非结构化的环境中进行独立的推理、运动规划与实时控制。这是当时人工智能技术应用于移动机器人最为成熟的成果之一,Shakey的诞生自此也揭开了智能移动机器人研究的大幕。

自此以后,世界各国都开始投入到了对移动机器人的研究上,而在这之中,视觉系统更是被公认为是机器人走向智能的核心入口。因为在研究的推进中,人们需要机器人对环境拥有更完善的感知能力、逻辑思维能力、判断决策能力,甚至是根据作业要求与环境信息进行自主的工作。比如美国DARPA在90年代研究的ALV自主车可以选择路标识别实现导航,达到10km/h的移动虚度,还采用了立体视觉、卫星导航等当时的先进技术。2004年NASA研制的火星探测器机遇号与勇气号成功在火星表面登陆,搭载当时最为先进的图像采集与立体视觉技术,帮助探测器在复杂的星球表面完成各项未知任务。而也正是在这样一个时期,三维视觉系统在移动机器人上的重要性被首次提出。

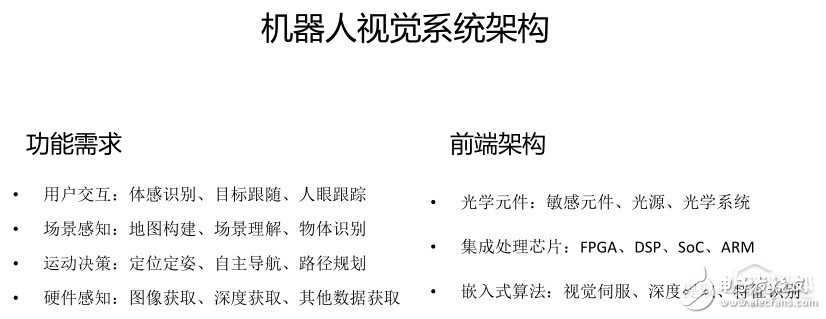

通过上面的介绍,不难发现,从上个世纪六七十年代发展起来的机器人视觉系统,到今天,实际上是建立在不同时期最先进的算法技术和硬件传感器的基础之上的。在视觉系统的算法技术上,通过几十年的发展,形成了用户交互、识别感知、运动决策和数据优化4个层级,分别对应实现体感识别、目标跟随、人眼跟随;地图构建、场景理解、物体识别;定位定姿、自主导航、路径规划;图像优化、深度优化、其他数据优化等诸多今天大家耳熟能详的算法。在硬件传感器上,也主要分为前端传感器表现,集成处理芯片和嵌入式算法三个层级。在今天的钛坦白分享课上,我会主要介绍一下三维视觉的主要实现原理。

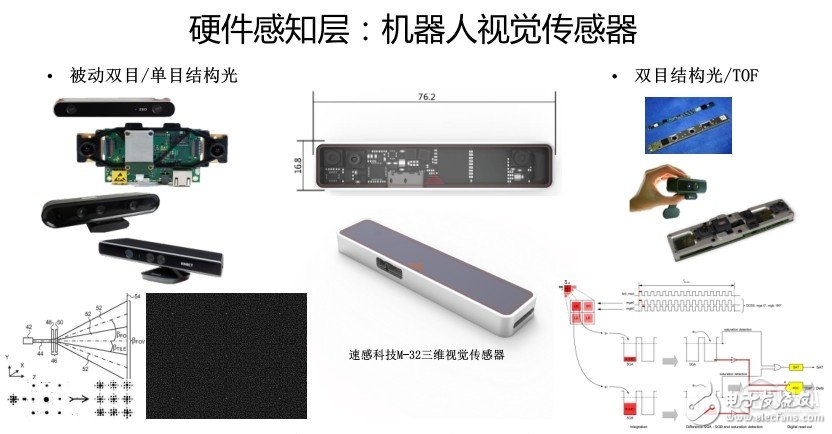

在前面的介绍中,我们看到,机器人视觉系统一路走来,和光学传感器的演进密不可分。可以说视觉系统几十年的发展史,就是光学传感器的演进史。今天,我们大体将机器人视觉系统中搭载的视觉传感器分为三类:以单线激光雷达为代表的一维线阵传感器,以嵌入式摄像头为代表的二维面阵传感器和以特殊光源为代表的三维深度传感器。其中,以特殊光源为代表的三维深度传感器是实现机器人三维视觉系统的最主要也是最关键的传感器,三维数据的获取质量直接影响了移动机器人后端的算法结果与决策控制。

目前实现三维深度传感器的主流技术大体在2010年后发展起来,路线有以下几类:基于单目结构光技术路线、基于双目结构光技术路线以及基于飞行时间法技术路线。速感科技在今年的11月份,面向服务机器人厂商推出的M-32三维传感器就是基于其中的双目结构光原理实现的,且集成嵌入式视觉算法的视觉传感器。结构光的原理是利用激光的光学衍射原理,通过传感器投射出特定的图案,用以加速或辅助深度图的获取。其中特定的图案可以分为规则、伪随机或随机点状散斑和特殊图形斑几类,其优势在于精度高,刷新率快,但缺点是不适合在户外强光下的环境进行使用。飞行时间的原理也称TOF原理,是利用调制光源在不同距离接收到的相位不同从而根据光的传播速度反算距离这一原理实现的深度获取,这一原理的优势测量精度不会随着距离递减,但劣势是分辨率低且环境扰动大。

基于视觉的机器人感知技术SLAM

讲到基于视觉的机器人感知算法原理,就不得不提到这两年大火的SLAM技术。 SLAM (simultaneous localization and mapping,即时定位与地图构建。由于其重要的理论与应用价值,被很多学者认为是实现真正全自主移动机器人的关键。

我和我的合伙人2012年开始接触这一技术,到2014年创业的时候,除了国内一些研究机器人自动化技术的实验室和老师,几乎做图形图像的学术圈都没怎么听说过SLAM,更不用说当时的创业公司和资本市场。而今天,几乎整个人工智能领域似乎都对SLAM这一技术报以了极大的关注度与期望,这实际上是和这一技术在今天对于机器人和人工智能的重要地位以及代表性产品的推出是分不开的。我认为SLAM技术在资本市场上获得极大的关注度有很大一部分原因是去年美国明星创业团队Magic Leap在AR领域的技术探索,微软公司在去年推出的Hololens以及今年10月份Google开源了一套SLAM算法密不可分的。由于在这之前,大家都没有听说过SLAM这一技术,更不必说意识到这一技术在2010年后在机器人领域取得突飞猛进的进步。当有代表性的产品或者公司将这一技术运用起来,便一下子引起了大家的关注。

今天我和大家介绍一些2010年后随着三维视觉传感器的兴起,SLAM的进一步演进,也就是今天我们应用在各种移动机器人上的vSLAM(基于视觉的同时定位与构图技术),是如何建立起来并且被应用在机器人的自主导航、路径规划等方案中的。

从2012年开始在实验室的接触研究,再到后来成立速感和同事们推进技术的迭代中,我觉得对于SLAM到今天为止,有三个里程碑式的事件:

2000年左右的国际机器人研讨会上,首次给出了SLAM这一基本框架和收敛性的验证结果,并针对这一理论给出了具体的证明和结论,自此,以MIT、悉尼大学为代表的研究移动机器人地图构建和定位的学术圈前辈才正式开始致力于SLAM技术的研究,补充并完善的给出了SLAM的技术可行性依据。在这之前尽管SLAM这一理论被提出有10年之久,但学术圈普遍认为这一理论得到的地图估计误差是不收敛的,因此不能通过处理一个同时包含机器人定位与特征路标位置的联合状态对模型进行求解从而得到结果;

2011年前后,正好是我进入到实验室,和实验室的师兄师弟开始对无人机视觉系统的定位定姿与地图构建进行系统性的学习与开发的阶段,以Kinect 1为代表的视觉传感器开始在SLAM研究领域兴起,为SLAM的大踏步发展奠定了底层硬件上的基础契机。从整个机器人视觉系统的发展历程来看,任何一个关键技术的应用需要一个较长时间的技术转化周期,而突破性的进展离不开底层关键元器件、计算芯片或传感器的支持。而我认为,三维视觉传感器的兴起正是为SLAM的发展提供了这样的关键一步;

从去年开始到今年的这一波世界范围内的人工智能浪潮。诚然我们需要看清楚的是,在这一次人工智能复兴的浪潮中,存在很多被称为“伪命题”的黑科技,但是也要清楚的看到随着深度学习、增强学习以及迁移学习这样基础性的数据训练与学习方式的变革,带动了一批过去我们看来在实际商业化与产品化并不成熟的行业。比如VR/AR,比如无人驾驶,再比如机器人、无人机。很幸运的是,在目前最热的人工智能涉及到的这三个行业中,我们都看到了SLAM的影子,并且看到了这一技术在这其中所发挥出的巨大价值。

今天广泛被人们讨论和学习的vSLAM,简单来说,是SLAM技术发展到今天结合目前的底层技术实现与硬件,离产品化最近的一种表现形式。针对不同端的应用需求,被分为了sparse(稀疏)和dense(稠密)两大类,前者侧重空间中对位置的感知与描述,后者侧重空间中对环境的构建与理解,但无论是哪一类,其基础性的构造框架对于数据的处理一定是分为前端和后端两部分的。其中前端用来对数据进行实时的特征提取、剔除噪声、帧匹配得到位置转移向量,这一部分又可以单独作为轻量级的视觉定位定姿算法,成为VO,常见的优化包括加入IMU惯性测量单元数据进行计算,也叫VIO。后端主要从全局的角度出发,通过滤波算法、图优化、树优化等方法对前端得到的结果进行闭环检测、循环迭代等方法的二次优化,最终得到最优的计算结果。

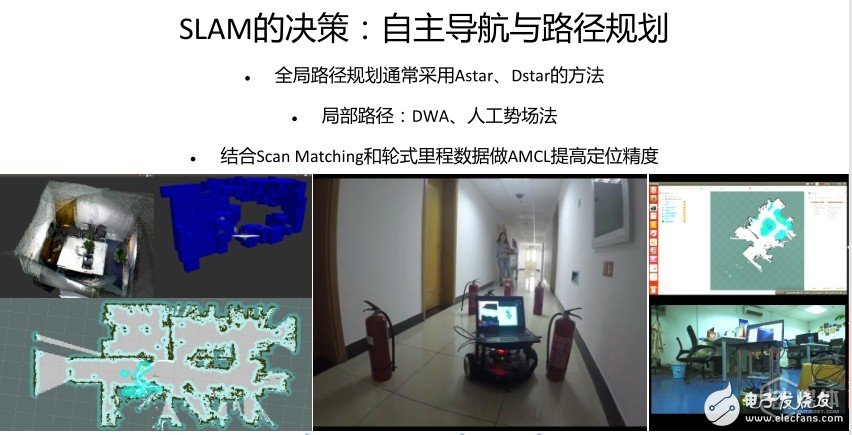

对于SLAM算法,很多人觉得掌握了SLAM算法就解决了机器人移动这样关键性的基本问题,事实上并非如此。SLAM在今天之于人工智能机器人等领域的发展上,已经越来越像深度神经网络一样,成为一项基础性的工具。一个表现好的SLAM框架可以帮助我们得到一个鲁棒性高的空间运动模型和空间环境模型,但是只是让机器人看到了世界,并不能真正指导机器人的决策,因此我们需要利用这样的模型,回到具体环境中有针对性的进行接下来的自主导航与路径规划等方案的开发。目前我们基于vSLAM算法,针对机器人在环境中的全局路径规划和局部路径规划,我们开发了一套鲁棒性高,可以实时决策的路径规划与导航算法框架,可以有针对性的结合vSLAM得到的最优计算结果,进行有效的多传感器融合与前端处理器的嵌入式集成,使其可以在不同复杂的环境中获得良好的表现结果。

在这一点上,我觉得过去这几年,人工智能的研究始终停留在对于感知算法的迭代优化上,包括人脸识别、 语义分析等等,我们追求更高的测试与跑分结果,反倒是忽略了这样的技术应该如何更好地在商业领域、工业领域产生更多的价值。因此我们也发现,从去年开始的这一波人工智能浪潮,正在推动学术界在人工智能的研究从感知向真正的决策与使用转移。比如今天我们看到的VR/AR设备、无人驾驶汽车等等都是将这样的技术在一个具体细分的行业里面加以实践,实践中遇到了棘手的问题,然后寻找解决办法,指导底层硬件进行决策。我觉得这是真正的进步,而在接下来的几年,人工智能最大的增长点应该是如何帮助人们去优化地进行决策。

三维视觉在机器人上的发展方向

机器人自诞生之日起,视觉功能就是其最核心的功能与智能化的入口,三维视觉已经在近10年的发展中逐渐成为机器人的主流与标准配置,用以解决以往移动机器人“看不见”这一难题。但是由于从目前的硬件发展局限性而言,依然存在计算量大、使用环境受限等问题。针对更细分的应用场景,设计实现三维视觉技术的小型化、模块化、前端化将会成为今后两到三年业内主流的发展方向。

小型化:从CCD、CMOS芯片的相机,再到一维、二维激光雷达及三维视觉传感器,数据量在增加的同时,小型化的体积更加利于系统的集成;

模块化:机器人视觉系统功能与定位越来越明确,通用性的接口与标准正在逐步形成,行业进入方向明确化发展阶段;

前端化:GPU、FPGA、DSP等专用处理器飞速发展,通用处理器的计算资源需求正在被简化,将更侧重于交互功能的实现。

在这条道路上,整个机器人行业正在兴起,行业格局也越发清晰,产业链的上下游已经初见成熟,希望速感科技目前在做的事情,能够通过自身在发展中的不断积累,真正的,实实在在的推动正在兴起的机器人产业的进步与发展。(本文独家首发钛媒体,根据速感科技创始人、CEO陈震在钛坦白上的分享整理)

陈震毕业于清华大学信息交叉学科(计算机方向)信息科学国家实验室,主攻机器人交互技术。是中关村双创服务机器人产业联盟(RFC)成员、2016中关村U30成员、北京市海淀区青年英才、“雏鹰计划”成员、多所国际顶尖学术机构访问学者。曾担任国家重点科研项目负责人,获全国大学生挑战杯金奖,参与多项机器人研究项目合作,个人拥有多项国家科技发明专利及学术论文。速感科技是一家以机器视觉为核心的人工智能创业公司,目前已完成三轮融资。

电子发烧友App

电子发烧友App

评论