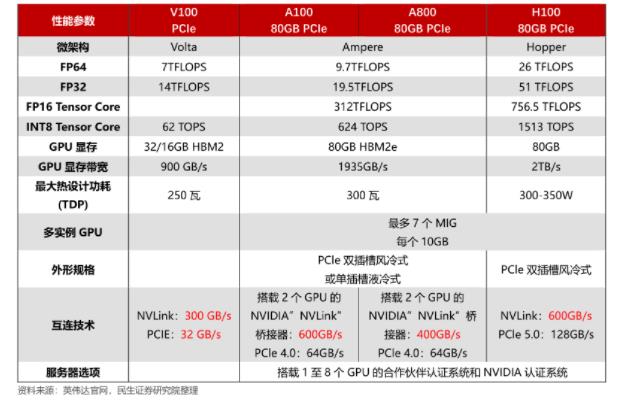

AI 训练和推理 SoC 和系统开发人员正在通过 HBM2e 和 GDDR 规范进行组合,以确定哪种风格最适合他们的下一代设计。

几乎每天都有新的人工智能 (AI) 应用程序涌现。然而,训练和推理 SoC 设计人员和系统工程师在内存带宽、容量和内存使用均衡方面面临着与深度学习计算元素相关的巨大挑战。

下一代 AI 应用面临的挑战包括是选择高带宽内存第 2 代增强型 (HBM2e) 还是图形双倍数据速率 6 (GDDR6) DRAM。对于某些 AI 应用程序,每种应用程序都有其自身的优点,但作为训练或推理 SoC/系统设计人员,您必须仔细评估每个应用程序以成功实施您的设计。

获得概要

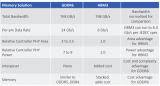

这里是您在继续进行 AI 设计时可以期待的概要。 HBM2e 和 GDDR6 的“概览”比较,突出了有助于指导您的 AI 设计的关键差异。

对于不同的架构和系统,您可以使用不同的尺寸、容量和预期性能水平来实现以每瓦兆次运算 (TOPS/W) 衡量的所需性能。但是,在此处的讨论中,我们将比较给定 AI 加速器设计的相同带宽要求。

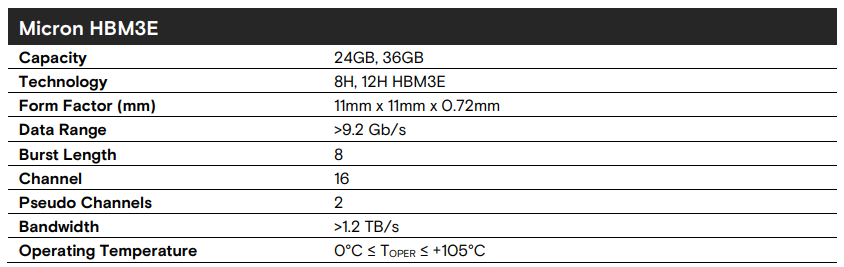

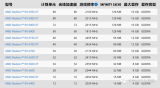

在我们的比较示例中,使用了一个设备、一个堆栈的 HBM2e。它具有 8 千兆位 (Gb) 的容量,以及高达每秒 2.8 兆位 (Tb/s) 的带宽。在 HBM2e 下,带宽被分解为 2.8 Tb/s × 1,024 输入/输出 (I/O) 等于 2.8 Tb/s。

至于 GDDR6,为了达到 2.0-Tb/s 的带宽,您需要四个设备,每个设备提供高达 2-Gb 的容量,因此总容量与 HBM2e 的 8 Gb 相同。在带宽方面,每个 GDDR I/O 提供大约 16 Gb/s 的带宽。因此,这四个设备中的 32 × 4 或 128 个 I/O 加起来可以提供大约 2 Tb/s。这里的要点是,与四个 GDDR6 设备相比,单个 HBM2e 设备可以为您提供更多带宽。

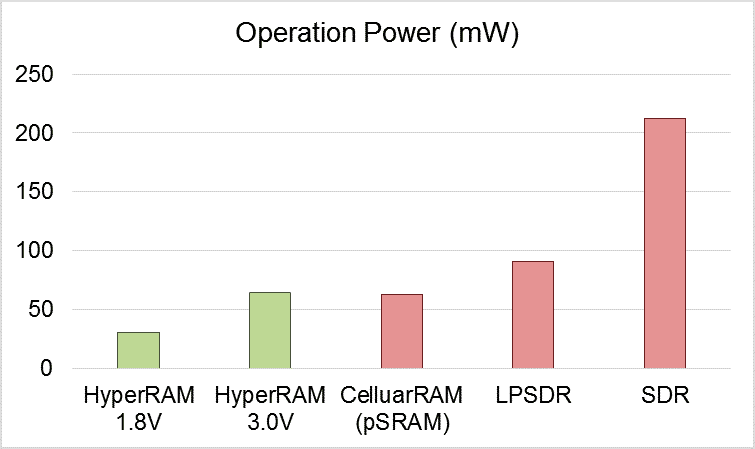

HBM2e 设备在 2.8-Gb/s 带宽下的功耗约为 5 瓦。相比之下,在 GDDR6 的情况下,四个设备中的每个设备的功耗约为 2.5 W,总功耗为 10 W。因此,很明显单个 HBM2e 设备的功耗几乎是 GDDR6 解决方案的一半。

系统性能

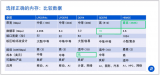

现在,让我们进入系统性能。AI 芯片通常以每瓦特浮点运算 (TFLOPS/W) 的形式进行比较。需要指出的是,系统设计师和架构师将以不同的方式构建深度学习加速器。

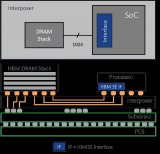

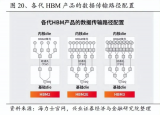

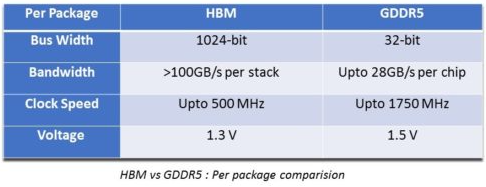

HBM2e 采用 2.5D 封装技术,并通过中介层与 SoC 或 ASIC 进行 die-to-die 连接。因此,与 GDDR6 相比,它在给定操作中消耗的能量更少。与 GDDR6 相比,提供的 TOPS/W 明显翻了一番。

因此,与 GDDR6 相比,HBM2e 在视频和图像识别等 AI 应用中更有效,并为您提供双倍的性能功耗比。这是因为处理元件通过管芯上的中介层直接连接到 HBM2e。此外,每瓦浮点运算提供了更好的性能。相比之下,在 GDDR6 的情况下,功能从一个芯片转移到另一个芯片,因此能耗和延迟要高得多。

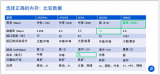

HBM2e 中介层和 TCO

如上所述,HBM2e 是一种基于 2.5-dB 的技术。这意味着在将 ASIC 连接到 HBM2e 内存时需要插入器。然而,这种中介层是一种较旧的 65 纳米工艺技术。因此,它更便宜。由于 2.5D 封装是一项相对较新的技术,因此 HBM2e 的总拥有成本 (TCO) 与 GDDR6 相比略高。

另一方面,GDDR6 是一种特殊但商品化的内存。它可从三个半导体供应商处获得,而 HBM2e 目前仅可从两个供应商处获得。

最大优势

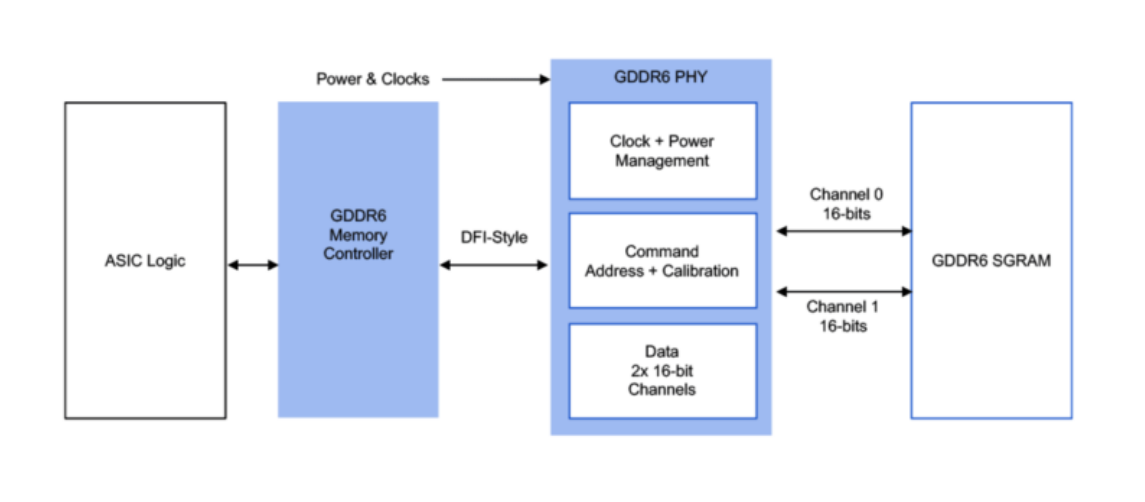

I/O 可能是 HBM2e 相对于 GDDR6 的最大优势。对于 GDDR6,它们是标准的高速单端 I/O。SoC 需要一个额外的 128 位 I/O 用于数据,该 I/O 在非常高的功率下切换,并且还与其他信号(例如接地和电源信号)的风险命令相关联。

然而,基于中介层的 HBM2e 具有从芯片到芯片的宽 I/O,并且功耗更低。因此,与控制器 SoC 上的典型 GDDR6 PHY 相比,裸片上的内存控制器 PHY 功耗要低得多。

结论

HBM2e 为您提供与 GDDR6 相同或更高的带宽和类似的容量,但功耗几乎是一半,而 TOPS/W 则增加了一倍。因此,HBM2e 是业内久经考验的解决方案。

说了这么多,HBM2e 和 GDDR6 在印刷电路板 (PCB) 级别仍然存在设计问题和注意事项。一旦将这些器件放置在 PCB 上,就会出现信号完整性、特性和电路板空间问题,以及相关的设计注意事项。特别是基于中介层的 HBM2e 及其 2.5D 封装需要特殊的 PCB 制造。

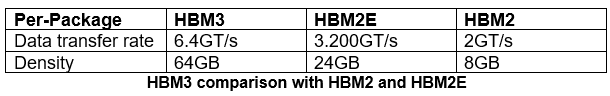

总体而言,HBM2e 是 AI 应用的首选。HBM2e 一代拥有 2.8-Gb/s I/O 或 3.2-Gb/s I/O 带宽,将满足下一代 AI 应用的高性能要求。

审核编辑 黄昊宇

电子发烧友App

电子发烧友App

评论