2019年7月24日下午,中央深改委召开第九次会议,审议通过《国家科技伦理委员会组建方案》。这表明国家对构建科技伦理治理体系前所未有的高度重视,而人工智能伦理是科技伦理中重要的内容。

在此背景下,我国人工智能企业成立伦理委员会正当其时。但人工智能企业怎么组建伦理委员会也成为一大现实难题。昨天我们发文讨论了组建国家科技伦理委员会释放了什么信号?今天,新京报智慧城市研究院特别刊登中国人民大学法学院副教授,未来法治研究院社会责任和治理研究中心主任郭锐、中国人民大学法学硕士李依及刘雅洁的深度长文,为企业和大众进一步解答人工智能企业的伦理委员会应当如何组成。

人工智能技术的开发和应用深刻地改变着人类的生活,渗透交通出行、金融科技、教育培训、资讯平台等方方面面。日益广阔的应用场景,让一个共识逐渐明晰:人工智能对伦理秩序冲击的深度和广度,可能是任何现代科技都难以比拟的。而掌握最前沿技术、担负着技术落地执行者角色的科技公司们,尤其应该有明确的伦理意识,并将对伦理的考量贯穿始终。这其中尤为重要的方式之一便是设立伦理委员会。

AI伦理委员会在实践中有多种称谓,常见的有“伦理道德委员会”“伦理审查委员会”“伦理风险委员会”等。而设置伦理委员会的目的,从这些大同小异的名称中也可见一斑:一是让AI伦理“成为问题”:让合伦理性在AI产品开发的诸多考量因素中占据一席之地;二是让AI伦理的审查尽可能专业、独立:与其让一线研发人员在技术和伦理的不同标准中无所适从,不如将伦理部分剥离出来,交由专门机构集中应对。

许多科技公司面临的一个困境是,尽管算法歧视等AI伦理风险普遍存在,但程序员缺乏对伦理进行准确判断的专业知识,也难以承担诸如“自动驾驶汽车应优先保护车内乘客还是车外行人”等关键伦理选择的责任。因此,相对独立集中且成员具备多元背景的伦理委员会,更适于对这些伦理问题进行判断。

其实,这一尝试在国外早已有之。目前、Google、Lucid AI、微软等多家大型科技公司已经设立了伦理审查委员会。审查委员会一般由具有不同知识背景和经验的专家组成,在审查时参考一定的行业标准,并最大限度地考虑安全和伦理问题。如微软成立了“伦理道德委员会”,由产品开发、研究员、法律事务、人力资源等部门的负责人组成。[1]

伦理委员会应当具备哪些职能?

从机构定位上看,伦理风险管理委员会应当作为伦理风险管理的领导机构,组成人员可以包括主要人工智能研发部门的负责人、企业法务和/或合规部负责人以及处理伦理风险问题的协调专员。主要职能可以包括制定企业内部伦理风险管理政策、对伦理风险管理的相关问题做出决策、进行算法审计及质量审查工作以及协调企业内部各部门的伦理风险应对工作。

尤应注意的是,伦理委员会并不是企业在构建AI伦理风险治理机制时唯一依赖的机构,企业不能奢望将所有伦理问题委由伦理委员会一揽子解决,而不提供配套的执行机制。从委员会的性质上看,成员将主要负责评估和风险决策的制定,但难以作为执行机构将具体决定落到实处。

因此,伦理委员会可领导整个风险管理流程的实施及监督,并交由各业务部门的具体伦理风险管理小组具体实施相关决策,并定期将成果汇报至伦理委员会。

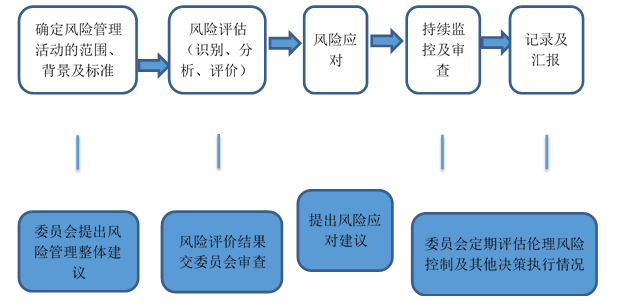

一般意义上的AI风险管理流程(白底框)和人工智能伦理委员会职能(蓝底框)的对应关系大致如下图所示:

具体而言,企业内部设立的人工智能伦理委员会应当具备如下职能:

1. 领导AI伦理风险控制流程的实施及监督。此外,为管理人工智能可能产生的伦理风险,委员会可以建立相应的内部制度对风险进行识别、评估、处理、监控及汇报,以管理相关风险。对于伦理风险的管理应从人工智能产品或服务的设计阶段开始,并贯穿于产品或服务的整个生命周期。

2. 参与AI的伦理风险评估。委员会可以定期进行伦理风险评估,对企业总体可能涉及的伦理风险进行识别,评估一段时间内相关伦理风险应对措施是否适当且有效。委员会可以根据相关法律法规以及政府及行业标准的规定,具体评估本企业所面临的风险,并记录评估内容及结果。还可以视情况聘请外部专家参与评估,确保评估的有效性。

3. 审查伦理评价结果。对于某项具体的人工智能产品或服务而言,企业可采用相关手段识别可能涉及的伦理风险,对该伦理风险的性质和特征进行分析并进行风险评价,记录评价结果并交由伦理风险管理委员会进行审查。风险分析的目的是理解包括风险水平在内的风险性质和特征。

此外,一项AI产品的伦理风险不是不变的。在基于算法的深度学习过程中,算法模型会根据数据库的样本不断更新,并可能带来新的伦理问题或逐渐消除原有的伦理风险。因此,常态化的委员会可以定期对以往的伦理评价进行二次审查,确保伦理评价结果的适时性。

4. 定期审查决策执行情况。如前所述,在伦理委员会之下,还有承接决定执行的伦理风险管理小组。小组对委员会决策的执行情况,自然也需要定期的审查和监督。

有专家指出,对人工智能的伦理审查存在一个悖论:如何为自己尚未完全理解的问题设计解决方案?因此,委员会起初作出的决策并不一定实际可行,具体效果要通过实践检验。而风险管理小组便可承担向委员会汇报并反馈实践结果的职能。

谷歌伦理委员会的火速解散,留下了什么启示?

继2018年公布谷歌人工智能原则后,3月26日,Google全球事务高级副总裁Kent Walker在Google博客中发文宣布,为了贯彻落实Google AI七原则,完善相关的内部治理结构和流程,成立先进技术外部咨询委员会(Advanced Technology External Advisory Council , ATEAC)。

谷歌成立的这个人工智能委员会旨在检查公司的决策,定期开会并制作有关该领域和谷歌技术进展的报告。Kent在博客中写道:“该委员会不具有否决权,但意在为我们的工作提供多样化视角。”

该委员会是帮助解决谷歌在其公布的引导其研究和产品的发展和使用的人工智能原则中出现的一些挑战。比如像人脸识别,机器学习中一些令人不安的因素。一个值得注意的点是,委员会的设立是为了从多个角度分析与人工智能伦理相关的问题,而委员会的成员是非Google员工的具有多样化背景的外部人员:

• Alessandro Acquisti,行为经济学家,隐私问题研究者,卡耐基梅隆大学信息技术与公共政策教授。

• Bubacarr Bah,应用和计算数学家,高级研究员,南非非洲数学科学研究所(AIMS)数据科学专业的德国研究主席。

• 吴德恺,音乐技术和机器学习专家,港科大计算机科学与工程教授,伯克利国际计算机科学研究所杰出研究者。

• Dyan Gibbens,工业工程和无人系统专家,Trumbull Unmanned公司CEO,该公司专注于自动化、数据、能源和防御的环境恢复能力。

• Joanna Bryson,心理学和人工智能伦理学专家,巴斯大学计算机系副教授,多家人工智能公司的顾问。

• Kay Coles James,美国传统基金会主席,曾在美国各级政府担任公共政策专家。

• Luciano Floridi,哲学家,数字伦理专家,牛津大学哲学和信息伦理教授,指导牛津互联网研究所的数字伦理实验室,艾伦图灵研究院数字伦理小组主席。

• William Joseph Burns,外交政策专家,美国前副国务卿,卡内基国际和平基金会主席。

委员会的组成人员来自学界、企业、和政界的不同背景。谷歌原本的计划是,第一届的8位成员从4月开始举行四次会议,直到2019年年底届满。但是早在2019年3月31日,Alessandro Acquisti在Twitter上公开表示退出ATEAC,认为讨论AI伦理这种重大事项,这个机构不合适。2019年4月4日,该委员会宣布解散。

谷歌成立伦理委员会到解散伦理委员会的经历虽然时间不长,但是其中仍然有几点值得我们思考。首先,伦理委员会是否应当由企业外部人员构成?第二,伦理委员会的组成应当怎样选择?第三,有哪些议题需要伦理委员会来讨论?第四,伦理委员会做出的决定效力如何,企业是应当直接落实还是加以借鉴?第五,如何保证伦理委员会讨论的透明性?

谷歌伦理委员会的火速解散,也给后来者一个思考,企业成立这样的伦理委员会是否能够真的实现其设立的初衷?其将怎样改变企业的行为模式?

从用户到企业,伦理委员会意义几何?

考虑到人工智能伦理问题的复杂性,中国人工智能企业,尤其是一些掌握大量个人数据的企业,可以考虑设置专门的人工智能伦理委员会,以协助企业在面对伦理问题时做出更加正确的选择。设置人工智能企业的伦理委员会能够更好地规范相关企业,促进良性发展。

目前,世界上确实很多企业和机构都在着手制定相关的人工智能伦理政策,但从效果来看,很多政策操之过急,大部分的人工智能伦理原则都是宣誓性或者纸上谈兵,缺乏在企业相应制度框架下的思考,无法实际解决企业发展中遇到的问题,或是缺乏前瞻性的考虑,无法排除将来发展中可能遇到的障碍。

而设置人工智能伦理委员会,系统地从企业发展的角度对于伦理问题作出分析和安排,可以从制度的层面帮助相应的人工智能伦理政策更好的落实,并帮助确定未来的发展方向。

从实践的角度看,不仅是谷歌,很多国外企业都建立了相应的人工智能委员会。谷歌旗下的人工智能公司Deep,ind设立了伦理和安全委员会,但是DeepMind没有向外界透露委员会的组成成员、讨论的议题,甚至是他们是否有过正式的见面等问题。[2]

微软有自己的人工智能原则,并在2018年成立了人工智能伦理委员会Microsoft’sAI and Ethics in Engineering and Research (AETHER) Committee,[3]该委员会由公司内部的高管组成,积极制定内部政策,并决定怎样负责任地处理出现的问题。[4]亚马逊资助了美国国家科学基金会“人工智能中的公平”的研究,Facebook则与慕尼黑工业大学共同组建了人工智能伦理的研究中心。[5]

人工智能伦理委员会应当包括科学家、企业领袖和伦理/法律界人士。实践中与此最相近的做法是,今日头条于2018年成立的“技术战略委员会”[6],这一委员会实质上也包括了上述部分伦理委员会承担的职能,其目的是“更好地让今日头条的人工智能技术最终造福人类,同时应对人工智能技术发展带来的挑战”,首批委员包括,图灵奖得主JohnE.Hopcroft教授,中国工程院院士、国家自然科学基金委员会副主任高文教授和中国科学院院士张钹教授等。

从企业的角度来说,设置企业人工智能伦理委员会,可以协助企业对数据的收集、处理和使用作出规制,以此保护用户权益,并降低合规风险、保护企业利益。具体而言,对于信息从用户传输到系统的过程中,应当规范对于信息的收集,包括可以收集哪些信息,怎样进行收集等。

对于在此过程中的对用户权利义务的告知、同意以及是否能再次转让等问题。组成企业人工智能伦理委员会可以帮助改进隐私政策,包括规范弹窗及授权内容,资助相应研究,推出相应的隐私保护白皮书等。

从用户的角度来说,企业设置专门的人工智能伦理委员会,也是为了更好地保护用户对于个人数据的知情权和自决权。用户有理由担心企业如何处理用户数据,尤其是敏感信息与隐私数据。

而人工智能伦理委员会的设立能够帮助企业进行人工智能伦理决策时多进行道德上的考虑,并符合与时俱进的法律法规,通过规范和约束企业的行为,加强个人数据的保护。

电子发烧友App

电子发烧友App

评论