院解释,单纯的深度学习已经成熟,而结合了深度学习的图神经网络将端到端学习与归纳推理相结合,有望解决深度学习无法处理的关系推理、可解释性等一系列问题。

2019-01-02 13:49:08 1994

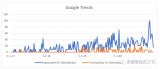

1994 模型的可解释性是机器学习领域的一个重要分支,随着 AI 应用范围的不断扩大,人们越来越不满足于模型的黑盒特性,与此同时,金融、自动驾驶等领域的法律法规也对模型的可解释性提出了更高的要求,在可解释

2023-09-28 10:17:15 437

437

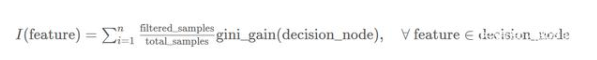

通过建立既可解释又准确的模型来改良这种错误的二分法。关键是将神经网络与决策树相结合,在使用神经网络进行低级决策时保留高级的可解释性。

2020-05-31 10:51:44 7986

7986 人工智能、AI智能大模型已经孵化;繁衍过程将突飞猛进,ChatGPT已经上线。

世界首富马斯克认为AI对人类是一种威胁;谷歌前CEO施密特认为AI和机器学习对人类有很大益处。

每个国家对核武器的运用有两面性,可造可控;但AI智能他具备学习能力,如果他自装意识形态,自己衍生,人类是否可控?

2023-06-27 10:48:14

1 个 AI 模型 = 5 辆汽车终身碳排量,AI 为何如此耗能?

2021-01-22 06:35:03

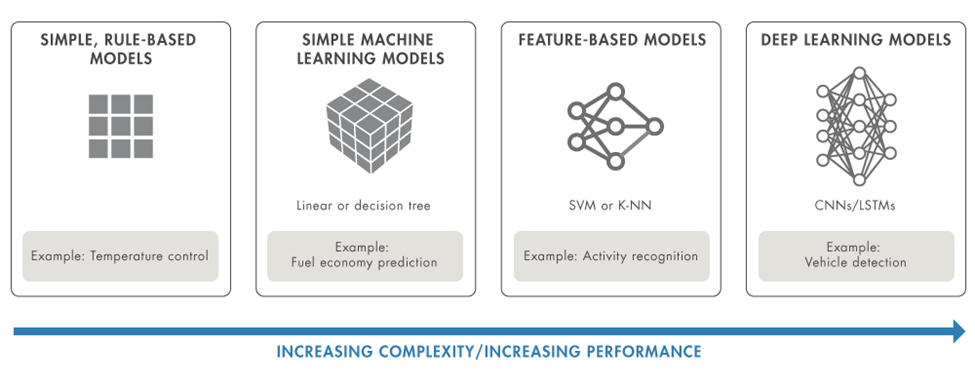

AI算法中比较常用的模型都有什么

2022-08-27 09:19:06

【资源下载】《可解释的机器学习》,打开机器学习黑匣子

2020-05-20 14:16:57

cubemx ai导入onnx模型后压缩失败。请问我怎么解决

2024-03-19 07:58:47

FFT运算(Vivado)

四、硬件加速之—使用PL加速矩阵乘法运算(Vitis HLS)

五、Vitis AI 构建开发环境,并使用inspector检查模型

六、Vitis AI 进行模型校准和来

2023-10-14 15:34:26

语义网络。图谱构建中会面临较大的挑战,但构建之后,可在数据分析、推荐计算、可解释性等多个场景中展现出丰富的应用价值。 其中,构建挑战包括: Schema 难定义。目前尚无统一成熟的本体构建流程,且特定

2022-11-22 15:37:08

介绍在STM32cubeIDE上部署AI模型的系列教程,开发板型号STM32H747I-disco,值得一看。MCUAI原文链接:【嵌入式AI开发】篇四|部署篇:STM32cubeIDE上部署神经网络之模型部署

2021-12-14 09:05:03

使用cube-AI分析模型时报错,该模型是pytorch的cnn转化成onnx

```

Neural Network Tools for STM32AI v1.7.0 (STM.ai v8.0.0-19389)

INTERNAL ERROR: list index out of range

```

2024-03-14 07:09:26

你好, 我试图在 X-CUBE-AI.7.1.0 中导入由在线 AI 平台生成的 .h5 模型,收到错误:E010(InvalidModelError): Model saved with Keras 2.7.0 but

2022-12-27 06:10:35

将AI推向边缘的影响通过在边缘运行ML模型可以使哪些具体的AI项目更容易运行?

2021-02-23 06:21:10

训练好的ai模型导入cubemx不成功咋办,试了好几个模型压缩了也不行,ram占用过大,有无解决方案?

2023-08-04 09:16:28

在设计防止AI大模型被黑客病毒入侵时,需要考虑到复杂的加密和解密算法以及模型的实现细节,首先需要了解模型的结构和实现细节。

以下是我使用Python和TensorFlow 2.x实现深度学习模型

2024-03-19 11:18:16

1) 非常完美地将各种side information融入到一个统一的模型;

2)利用meta-path,可以设计出各种各样的推荐策略,除了推荐准确性提升之外,还能提供「可解释性」。

2017-10-10 11:47:09 2645

2645 深度学习的热潮还在不断涌动,神经网络再次成为业界人士特别关注的问题,AI 的未来大有可期,而深度学习正在影响我们的日常生活。近日斯坦福大学给我们分享咯一则他对深度神经网络可解释性的探索的论文,我们去看看他是如理解的吧!

2018-01-10 16:06:30 4032

4032

而对于自底向上的模式,将商业模型中的一部分委派给机器学习,甚至从机器学习中得到全新的商业想法。自底向上的数据科学一般与手工劳作的自动化过程相关。例如制造业公司可将传感器放置在设备上收集数据并预测

2018-04-11 15:48:04 13151

13151

关于红外检测技术的解释性论文

2018-05-21 11:15:58 2

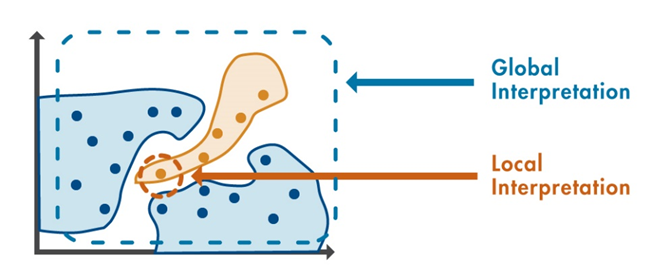

2 广义上的可解释性指在我们需要了解或解决一件事情的时候,我们可以获得我们所需要的足够的可以理解的信息。

2018-06-25 10:21:11 5608

5608

如果考察某些类型的“事后可解释性”(post-hoc interpretable),深度神经网络具有明显的优势。深度神经网络能够学习丰富的表示,这些表示能够可视化、用语言表达或用于聚类。如果考虑对可解释性的需求,似乎线性模型在研究自然世界上的表现更好,但这似乎没有理论上的原因。

2018-07-24 09:58:20 19321

19321 所以网络学习特征向量,和未见分类一起保存于可微记忆块之中。这一表示不断发展,给了神经网络学习“如何快速学习”的能力,这正是我们将其称为元学习的原因。就这样,神经网络的行为开始变得更像人类了。人类联系过去和现在的能力极强。例如,即使我没见过这一奇异的外星生物,我仍然可以说它像是一个长着牛角的狒狒或者大猩猩。

2018-11-10 10:07:55 4777

4777 正如Xavier Amatriain说的那样,深度学习的寒冬不会到来——这项技术已经用到产业里并带来了收益,现实让人们收起了一部分对AI的期望和恐惧,业界开始思考数据的公平性、模型的可解释性等更本质的问题。

2018-12-26 08:59:52 3600

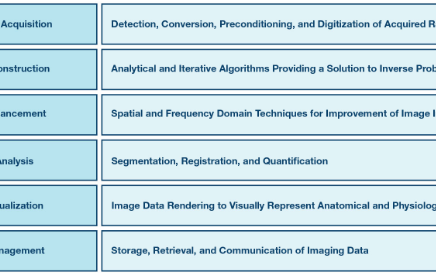

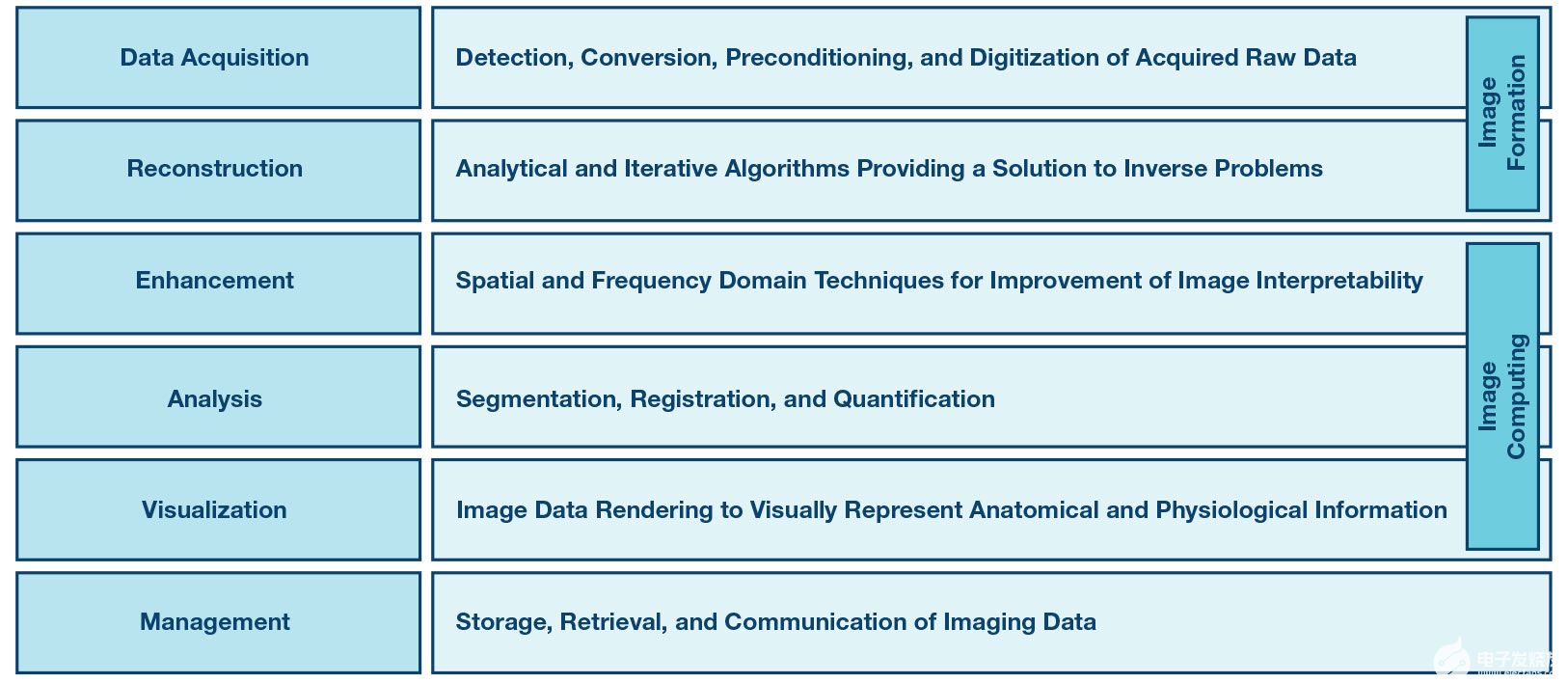

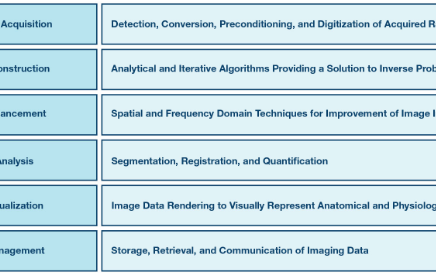

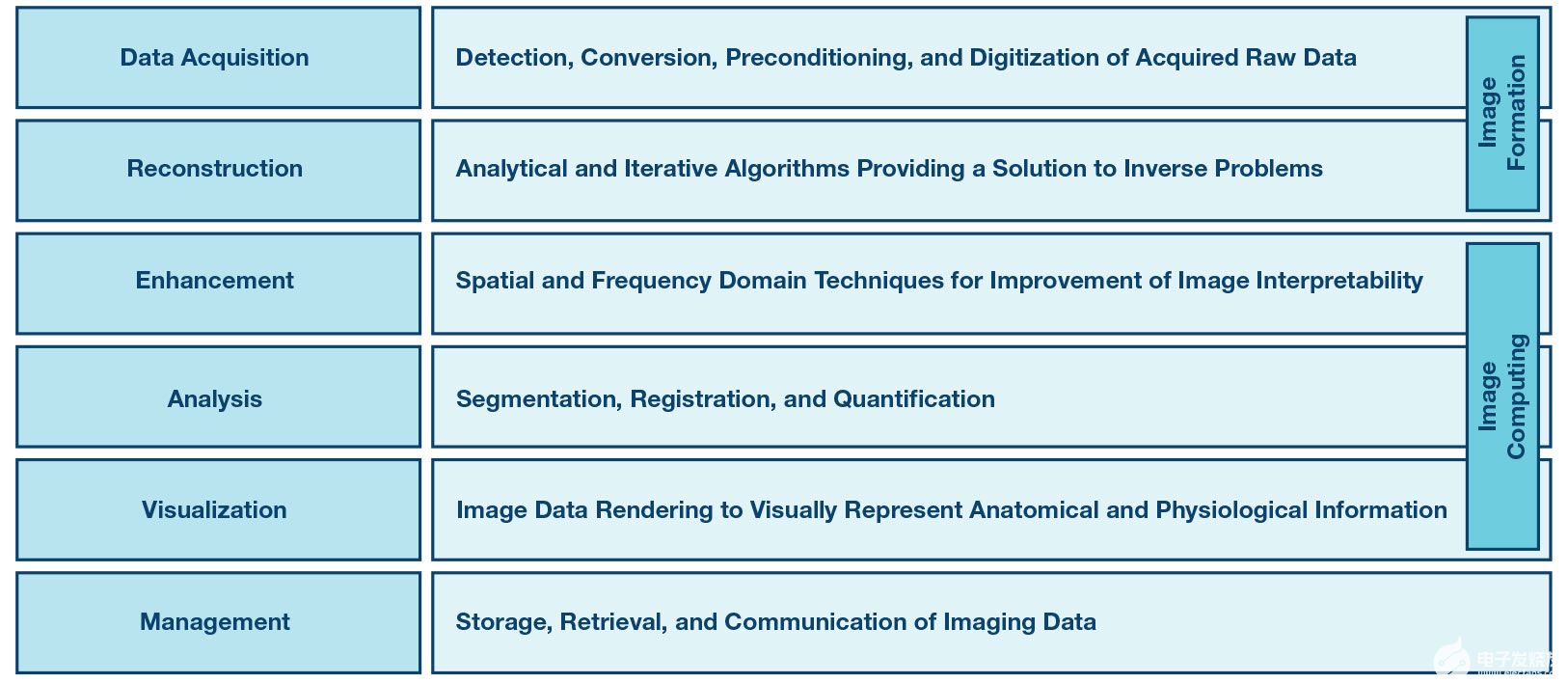

3600 图像形成过程包括数据采集和图像重建步骤,为数学逆问题提供解决方案。图像计算的目的是改善重建图像的可解释性并从中提取临床相关信息。

2019-04-15 16:29:09 6752

6752

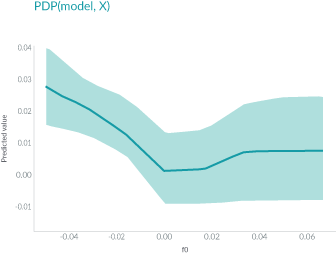

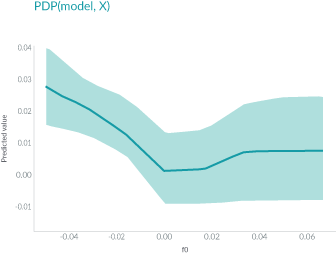

下图则阐述了在需要清晰简单的模型可解释性时,通常首选白盒模型 (具有线性和单调函数) 的原因。图的上半部显示,随着年龄的增长,购买数量会增加,模型的响应函数在全局范围内具有线性和单调关系,易于解释模型。

2019-04-04 17:30:23 2470

2470

人工智能(AI)的能力无疑令人震惊,这让许多人想知道它是如何做到的?,而这个问题的答案推动了可解释人工智能的概念,有时候称为XAI。

2019-05-09 16:33:45 420

420 在现实生活中,我们经常会为朋友做推荐或者让别人帮我们推荐,比如推荐旅游地、推荐电影、推荐书籍、推荐餐厅等。现实生活中的推荐,大家都会给出推荐原因的,比如推荐餐厅,我们会说这家环境好、好吃、卫生等等。

2019-06-07 16:19:00 3199

3199 神经网络的可解释性,从经验主义到数学建模

2019-06-27 10:54:20 4942

4942 最近,Google Brain团队的研究人员发表了一篇论文,提出了一种名为概念激活向量(Concept Activation Vectors, CAV)的新方法,它为深度学习模型的可解释性提供了一个新的视角。

2019-07-31 14:11:46 2702

2702 虽然神经网络在近年来 AI 领域取得的成就中发挥了关键作用,但它们依旧只是有限可解释性的黑盒函数近似器。

2019-08-15 09:17:34 12652

12652 语言是人类智能的重要标志,在人类文明中的地位与作用毋庸置疑,自然语言处理,通俗地解释就是“让计算机学习人类语言”。

2019-08-15 09:41:46 2540

2540 “因此,可解释性对机器学习,特别是深度学习是一个很大的挑战。只有人类理解了AI的决策过程,才能将其应用在更广泛的社会场景中。”徐飞玉表示。

2019-09-27 11:24:01 2230

2230 Google LLC已在其云平台上推出了一项新的“可解释AI”服务,旨在使机器学习模型做出决策的过程更加透明。

2019-11-30 11:06:51 882

882 可解释的人工智能意味着人类可以理解IT系统做出决定的路径。人们可以通过分解这个概念来探究人工智能如此重要的原因。

2020-01-30 08:50:00 6437

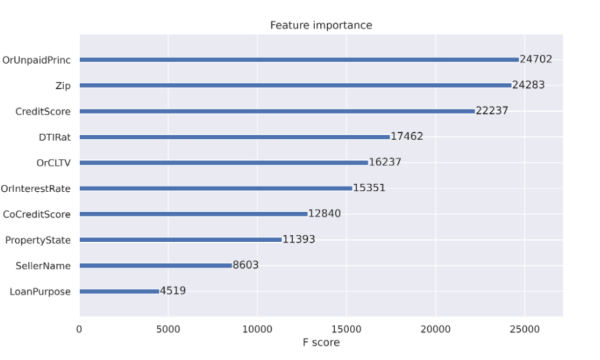

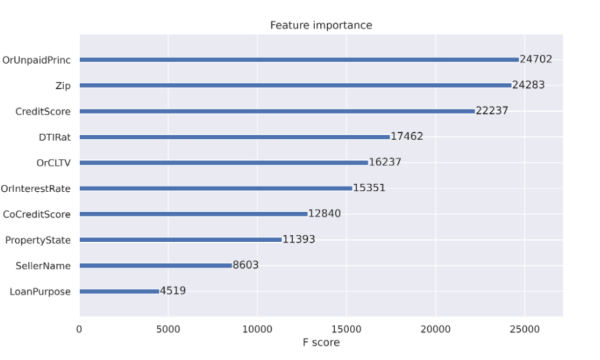

6437 Google Cloud AI战略总监Tracy Frey在 今天的博客中解释说,Explainable AI旨在提高机器学习模型的可解释性。她说,这项新服务的工作原理是量化每个数据因素对模型产生的结果的贡献,帮助用户了解其做出决定的原因。

2020-03-24 15:14:21 2655

2655 人工智能系统所面临的两大安全问题的根源在于深度神经网络的不可解释性。深度神经网络可解释性定义为可判读(interpretability)和可理解(explainability)两方面的内容。可判读性,即深度神经网络输出可判读

2020-03-27 15:56:18 2632

2632 可解释AI(X AI)近年来一直是一个积极的研究课题,受到DARPA2016年倡议的推动。 计算机视觉和自然语言处理等“感知”问题的机器学习的广泛采用,导致了分类器的可解释性技术的发展,包括LIME和AllenNLP解释技术。

2020-04-03 14:57:48 2620

2620 今年秋天,Facebook发布了带有量化和TPU支持的PyTorch 1.3,以及深度学习可解释性工具Captum和PyTorch Mobile。还有诸如PyRobot和PyTorch Hub之类的东西,用于共享代码并鼓励机器学习(ML)实践者实现可重复性。

2020-04-15 16:40:00 1703

1703 透明度和可解释性:应该有透明性和负责任的披露,以确保人们知道他们何时受到AI系统的重大影响,并可以找出AI系统何时与他们互动。

2020-04-20 15:52:47 1513

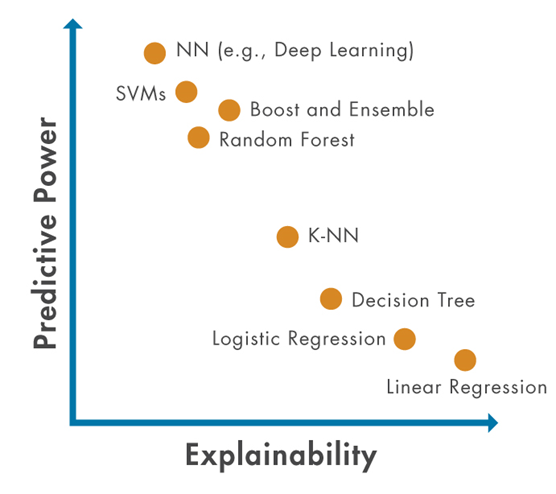

1513 一般来说,效能(正确率)与可解释性呈现负相关的关系,也就是说,可解释性越高,效能就越差;效能越高,可解释性就越低。

2020-05-17 09:49:08 641

641 针对人工智能安全问题,他提出四大对策。第一方面对策是可解释性,即我们了解或者解决一件事情的时候,可以获得我们所需要的足够可以理解的信息。比如说过去算法是黑盒算法,缺乏透明性、可解释性,一旦发生问题,难以分析和验证到底问题出处。

2020-07-04 13:00:20 2783

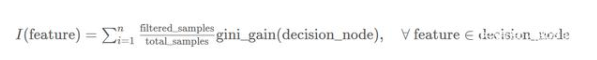

2783 决策树模型是白盒模型的一种,其预测结果可以由人来解释。我们把机器学习模型的这一特性称为可解释性,但并不是所有的机器学习模型都具有可解释性。

2020-07-06 09:49:06 3073

3073

以深度学习为代表的人工智能技术在信息领域的应用,极大地提高了信息的利用效率和挖掘价值,深刻的影响了各领域的业务形态,同时也引发了监管部门和用户对这一新技术运用中出现的 “算法黑箱”问题关切和疑虑。如何对相关算法、模型、及其给出的结果进行合理的解释成为数据科学家亟需解决的问题

2020-07-15 17:28:11 1166

1166 AutoML中准确性和可解释性的自动平衡 -除了追求最高准确性的模型外,还使过程自动化,以最小的准确性变化探索更简单的ML模型。这使用户可以根据他们的业务需求来平衡准确性和可解释性。

2020-09-11 10:32:04 1085

1085 性,涵盖了可解释AI的多学科性质,包括计算机科学、工程学和心理学领域。可解释性是可信AI的主要特征之一,不同的AI用户需要不同类型的解释,因此并不存在唯一的解释。“草案”提出了五类解释,总结了可解释AI理论

2020-09-15 11:09:36 3539

3539 一旦人们对一项技术失去了信任,就很难再获得回报。因此,开发和使用人工智能的组织要想提高人工智能应用程序的可信度和透明度,就必须超越负责任的人工智能。解决方案是实现可解释人工智能(XAI),即以普通人能够理解的方式描述人工智能解决方案的目的、原理和决策过程。

2020-09-20 10:19:04 3276

3276 对于机器学习模型来说,我们常常会提到2个概念:模型准确性(accuracy)和模型复杂度(complexity)。

2021-01-05 14:02:28 2825

2825

Al应用平台RealBox凭借在鲁棒性、可解释性方面的强大性能顺利通过可信AI认证,RealAI也成为首批通过该项评估的十家企业之一。 伴随日新月异的飞速发展,人工智能的不可解释、偏见歧视、存在攻击漏洞等安全问题正日益对法律、伦理、社会等方面不断提出挑战。 在

2020-09-29 12:29:56 852

852 在过去的十年里,深度学习在一系列的应用中取得了巨大的成功。然而,为了验证和可解释性,我们不仅需要模型做出的预测,还需要知道它在...

2020-12-08 22:14:02 262

262 模型可解释性方面的研究,在近两年的科研会议上成为关注热点,因为大家不仅仅满足于模型的效果,更对模型效果的原因产生更多的思考,这...

2020-12-10 20:19:43 533

533 与问题文本特征进行3种注意力加权,利用MASK屏蔽与问题无关的答案,从而增强模型的可解释性。实验结果表明,该模型在视频问答任务中的准确率达到61%,与ⅤQA+、SA+等视频问答模型相比,其具有更快的预测速度以及更好的预测效果。

2021-03-11 11:43:28 2

2 深度神经网络具有非线性非凸、多层隐藏结构、特征矢量化、海量模型参数等特点,但弱解释性是限制其理论发展和实际应用的巨大障碍,因此,深度神经网络解释方法成为当前人工智能领域研究的前沿热点。针对军事金融

2021-03-21 09:48:23 18

18 安全性得到重视,传统融合策略可解释性差的冋题凸显。夲文基于心理学中的知识线记忆理论进行建模参考人类决策过程,提出了一种拥有较好可解释性的启发式多分类器集成算法,称为知识线集成算法。该算法模拟人类学习与推断的

2021-03-24 11:41:33 13

13 图神经网络的可解释性是目前比较值得探索的方向,今天解读的2021最新综述,其针对近期提出的 GNN 解释技术进行了系统的总结和分析,归纳对比了该问题的解决思路。

2021-03-27 11:45:32 5583

5583

:https://arxiv.org/pdf/2012.15445.pdf 参考文献 0.Abstract近年来,深度学习模型的可解释性研究在图像和文本领域取得了显著进展

2021-04-09 11:42:06 2440

2440

设计。传统的可视化任务需要使用大量的数据,而联邦学习的隐私性决定了其无法获取用户数据。因此,可用的数据主要来自服务器端的训练过程,包括服务器端模型参数和用户训练状态。基于对联邦学习可解释性的挑战的分析,文

2021-04-29 11:13:59 3

3 ,以提升其可解释性。此外,对高斯混合模型的推理过程进行优化,给出一种基于批次处理方式的可扩展变分推理算法,求解图像去噪中所有隐变量的变分后验分布,实现先验学习。实验结果表明,该模型在图像去噪任务中较巸PLL等传

2021-04-29 11:17:49 7

7 为了提高驾驶分心识别的应用性及识别模型的可解释性,利用迁移学习方法硏究构建驾驶人驾驶分心行为识别模型并采用神经网络可视化技术硏究对模型进行解释。以ⅤGσ-6模型为基础,对原模型全连接层进行修改以适应

2021-04-30 13:46:51 10

10 伴随着模型复杂度的增加,机器学习算法的可解释性越差,至今,机器学习的可解释性依旧是个难题.通过算法训练出的模型被看作成黑盒子,严重阻碍了机器学习在某些特定领域的使用,譬如医学、金融等领域.目前针对机器学习的可解释性综

2022-01-25 08:35:36 790

790

本文介绍目前常见的几种可以提高机器学习模型的可解释性的技术。

2022-02-26 17:20:19 1831

1831

本文介绍目前常见的几种可以提高机器学习模型的可解释性的技术,包括它们的相对优点和缺点。

2022-02-16 16:21:31 3986

3986

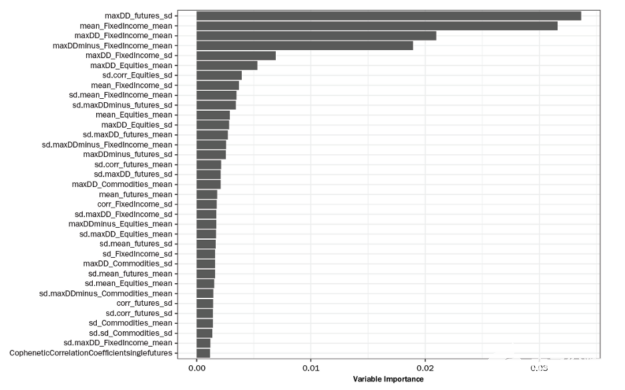

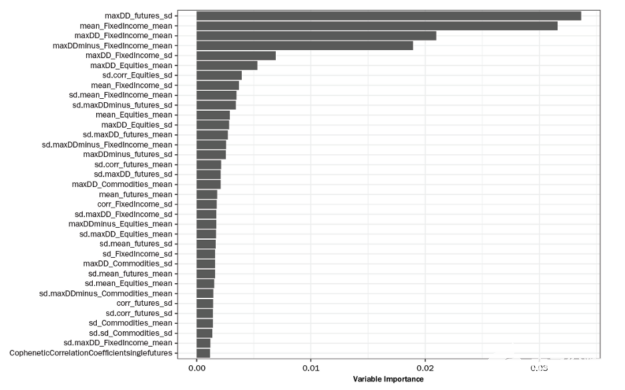

在本文中,我们将演示如何检查相互竞争的模型(称为 challenger models ),并使用 GPU 加速,通过简单、经济高效且可理解的模型可解释性应用程序获得成功。当 GPU 加速在模型开发过程中被多次使用时,建模者的时间将通过在数十次模型迭代中摊销培训时间和降低成本而得到更有效的利用。

2022-04-06 17:33:41 988

988

SHAP 聚类提供了机器学习模型的局部、全局和组级决策的解释。这里提供的扩展允许对解释进行进一步分析。这允许从业者为基于机器学习的决策构建一个叙述和解释,以满足业务、监管和客户需求。

2022-04-07 09:12:23 2275

2275

对形状值进行聚类的想法基于 EU Horizon 项目FIN-TECH中最成功的 AI 用例,发布为可解释机器学习在信用风险管理中的应用。它

2022-04-07 09:20:48 1296

1296

模型解释性 帮助开发人员和其他利益相关者理解模型特征和决策的根本原因,从而使流程更加透明。能够解释模型可以帮助数据科学家解释他们的模型做出决策的原因,为模型增加价值和信任。在本文中,我们将讨论:

2022-04-21 09:25:56 1922

1922 ./oschina_soft/interpret.zip

2022-06-16 09:51:54 1

1 可解释机器学习

2022-06-17 14:41:05 1

1 在实践中,人工智能的规模化应用推广,在很大程度上依赖于用户能否充分理解、合理信任并且有效管理人工智能这一新型伙伴。为此,确保人工智能产品、服务和系统具有透明性(Transparency)与可解释性(Explainability)是至关重要的。

2022-08-09 10:04:01 1132

1132 这一代人工智能浪潮也许到终点还是没有推理能力,没有可解释能力。而下一波人工智能浪潮的兴起,就是实现具有推理、具有可解释性、具有认知的人工智能。

2022-09-22 10:58:34 1289

1289 随着信息技术的不断发展,人工智能实现了 从能存会算的“计算智能”,到能听会说、能看会 认的“感知智能”[1-3],再到下一阶段具备理解、 推理和解释能力的“认知智能”[4-6]的逐渐演变, 这 3 个阶段的实现难度和价值同时逐次提升。

2022-12-21 10:50:46 428

428 一是自动驾驶高度依赖不具备可解释性的深度学习神经网络,不具备可解释性就意味着无法真正迭代升级。公认自动驾驶技术霸主的Waymo研发自动驾驶已经14年,但近10年来都没有取得显著进展原因就是如此。

2022-12-21 11:44:10 728

728 图像形成过程由数据采集和图像重建步骤组成,为数学逆问题提供了解决方案。图像计算的目的是提高重建图像的可解释性,并从中提取临床相关信息。最后,图像管理处理采集的图像和衍生信息的压缩、存档、检索和通信。

2022-12-22 14:35:03 1297

1297

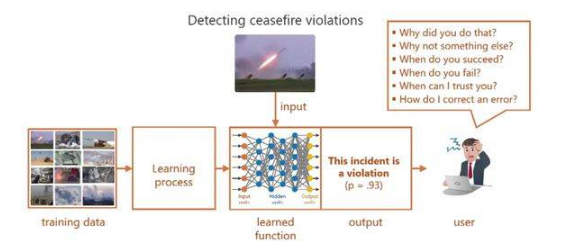

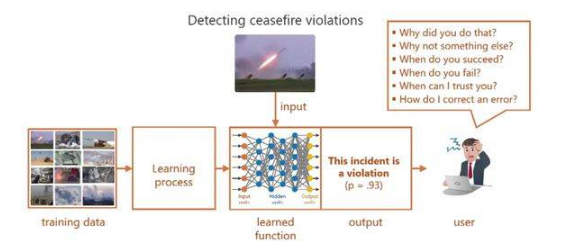

自主性挑战的动机是需要有效管理AI合作伙伴。例如,国防部寻求半自主系统来增强作战人员的能力。操作员需要了解它们的行为,以便确定在未来任务中如何以及何时最好地使用它们。有效的解释将更好地促成这种决定

2023-01-30 11:40:47 407

407 目前很多机器学习模型可以做出非常好的预测,但是它们并不能很好地解释他们是如何进行预测的,很多数据科学家都很难知晓为什么该算法会得到这样的预测结果。这是非常致命的,因为如果我们无法知道某个算法是如何进行预测,那么我们将很难将其前一道其它的问题中,很难进行算法的debug。

2023-02-03 11:34:06 1038

1038

本文介绍目前常见的几种可以提高机器学习模型的可解释性的技术,包括它们的相对优点和缺点。

2023-02-08 14:08:52 861

861 最近图灵奖得主Yann LeCun参与撰写了一篇关于「增强语言模型」的综述,回顾了语言模型与推理技能和使用工具的能力相结合的工作,并得出结论,这个新的研究方向有可能解决传统语言模型的局限性,如可解释性、一致性和可扩展性问题。

2023-03-03 11:03:20 673

673 本文对数据起源、可解释AI(XAI)和可信赖AI(TAI)进行系统的文献综述,以解释基本概念,说明数据起源文件可以用来提升基于人工智能系统实现可解释性。此外,文中还讨论了这个领域近期的发展模式,并对未来的研究进行展望。

2023-04-28 15:55:48 905

905

可解释性研究的一种简单方法是首先了解 AI 模型各个组件(神经元和注意力头)在做什么。传统的方法是需要人类手动检查神经元,以确定它们代表数据的哪些特征。这个过程很难扩展,将它应用于具有数百或数千亿个参数的神经网络的成本过于高昂。

2023-05-15 09:40:29 310

310 这就使得,原本深度学习被诟病可解释性问题,其实不再是问题。因为从业务顶层已经被拆分,拆分成一个个可以被人理解的因子,无法被合理解释的因子,项目启动的评审都无法通过。

2023-05-19 10:09:40 244

244

为了建立可信、可控、安全的人工智能,学术界与工业界致力于增强人工智能系统与算法的可解释性。具体地,可信人工智能旨在增强人工智能系统在知识表征、表达能力、优化与学习能力等方面的可解释性与可量化性以及增强人工智能算法内在机理的可解释性。

2023-05-24 10:02:16 363

363

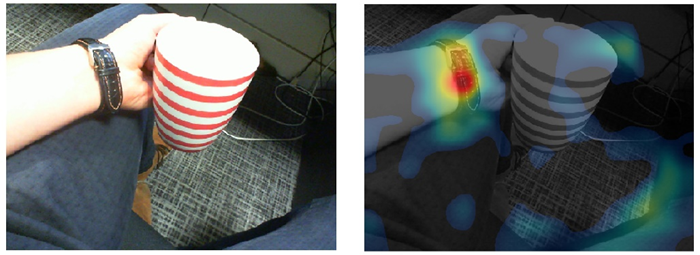

当使用神经网络时,我们可以通过它的准确性来评估模型的性能,但是当涉及到计算机视觉问题时,不仅要有最好的准确性,还要有可解释性和对哪些特征/数据点有助于做出决策的理解。模型专注于正确的特征比模型的准确性更重要。

2023-06-09 16:53:54 613

613

为了找到NMT模型的潜在缺陷,构建更加可解释的知识库,我们提出以局部准确性这一新概念作为分析角度。其中,局部准确性又包含两个子概念:条目准确性(entry correctness)和邻域准确性(neighborhood correctness)。

2023-06-13 15:25:19 390

390

本文旨在更好地理解基于 Transformer 的大型语言模型(LLM)的内部机制,以提高它们的可靠性和可解释性。 随着大型语言模型(LLM)在使用和部署方面的不断增加,打开黑箱并了解它们的内部

2023-06-25 15:08:49 991

991

LLM 是黑箱模型,缺乏可解释性,因此备受批评。LLM 通过参数隐含地表示知识。因此,我们难以解释和验证 LLM 获得的知识。此外,LLM 是通过概率模型执行推理,而这是一个非决断性的过程。对于 LLM 用以得出预测结果和决策的具体模式和功能,人类难以直接获得详情和解释。

2023-07-10 11:35:00 1354

1354

随着人工智能的不断发展和应用,机器学习模型的大小越来越成为一个重要的问题。在机器学习中,我们通常将模型分为两类:大模型和小模型。本文将介绍AI大模型和小模型是什么,并分析它们各自的优缺点以及区别。

2023-08-08 16:55:33 4555

4555 非常重要。本文将详细探讨AI算法和模型的区别,并解释它们在AI应用中的作用。 AI算法 人工智能算法是一组定义和实现任务的计算机指令。例如,许多AI算法用于分类和预测。这些算法可以从数据中提取有用的信息,并根据其他变量预测结果。AI算法适用于处

2023-08-08 17:35:39 2264

2264 咨询大中华区高级合伙人, 中国区金融行业总经理 范斌 以下为范斌演讲内容: IBM 作为一家专注于云计算和 AI 的公司,在金融科技方面有很多的投入和经验,在中国市场过去几十年的历史中,IBM

2023-09-07 18:15:08 294

294

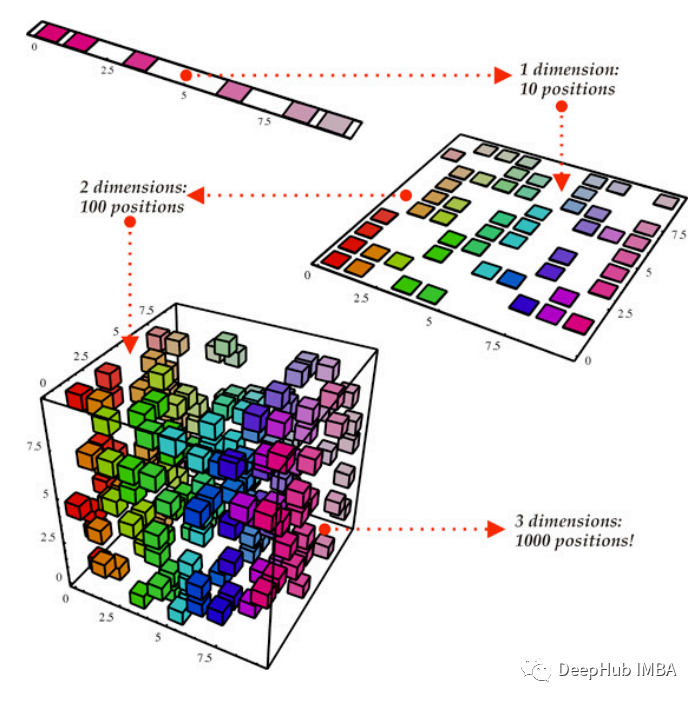

随着数据集的规模和复杂性的增长,特征或维度的数量往往变得难以处理,导致计算需求增加,潜在的过拟合和模型可解释性降低。

2023-10-09 10:13:47 422

422

是可解释AI。比尔.盖茨预测,未来10年(2030年-2039年),AI领域的主角将成为可解释AI。 大部分人预判:GPT-5将明显优于GPT-4,成为生成式AI领域天花板。 尽管OpenAI还没有对外界公布GPT-5的确切上线时间,甚至还曾遭到马斯克等人的反对,被其“联名上

2023-12-06 10:36:01 499

499

除此之外,还存在行业训练数据安全控制、大模型幻觉缓解消除及可解释性、构建具有强大逻辑推理规划能力的大模型、基于图数据的知识增强技术、通用结构化数据特性对齐和预训练,以及视觉领域下一个token预测任务建模等挑战。

2023-12-25 10:33:53 436

436 Density-based方法:基于密度的方法通常采用预训练的模型来提取输入图像的有意义嵌入向量,测试图像时通过计算嵌入表示与参考表示分布之间的相似度以得到异常分数。这种方法在MVTec AD等数据集上取得了较高的指标分数,但需要预训练模型加持且可解释性不足。

2024-01-11 16:02:35 188

188

日前,爱立信宣布在其专为运营商设计的认知软件组合中,新增采用“可解释性人工智能(Explainable AI,XAI)”的新功能,进一步加速在网络设计和优化中采用人工智能后的价值转化。

2024-02-22 09:22:19 570

570

电子发烧友App

电子发烧友App

评论