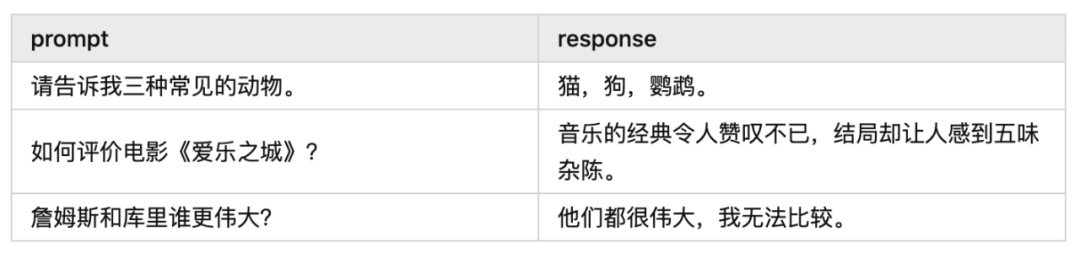

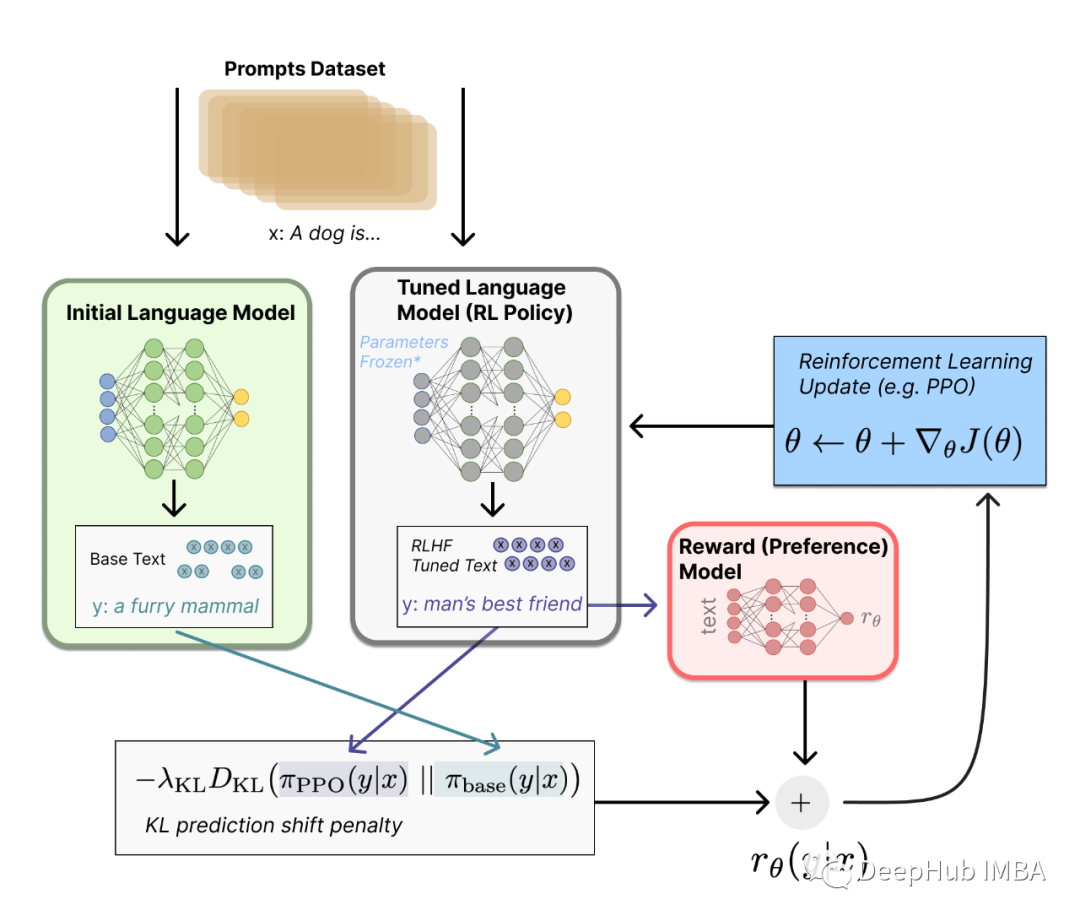

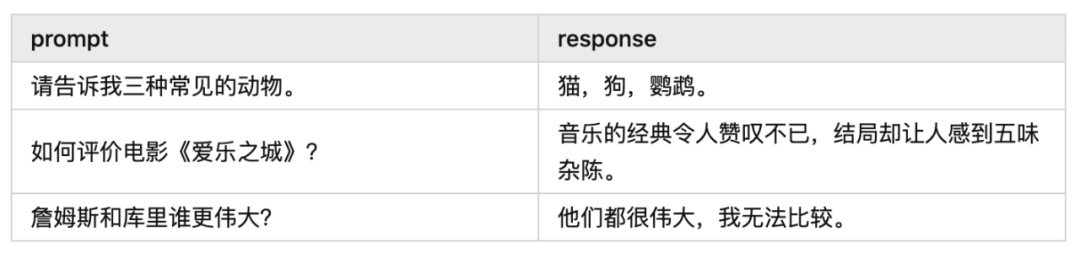

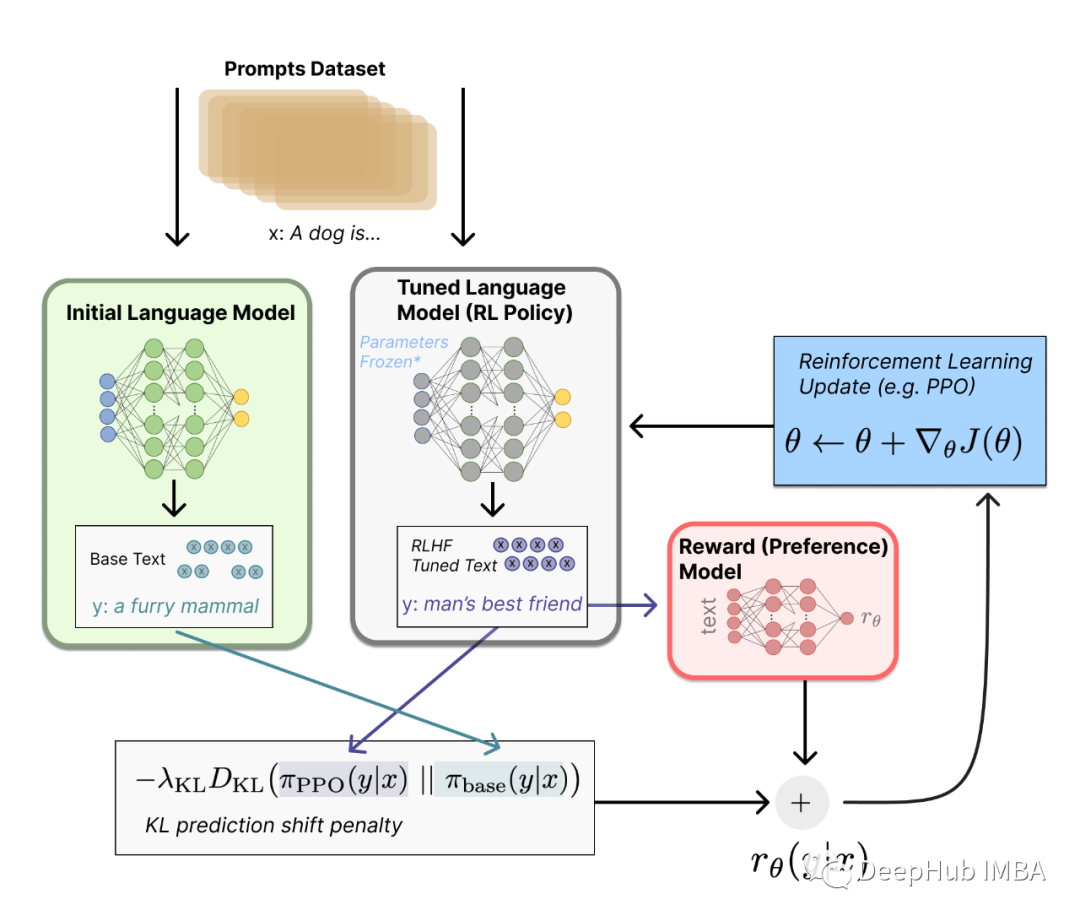

由于本文以大语言模型 RLHF 的 PPO 算法为主,所以希望你在阅读前先弄明白大语言模型 RLHF 的前两步,即 SFT Model 和 Reward Model 的训练过程。另外因为本文不是纯讲强化学习的文章,所以我在叙述的时候不会假设你已经非常了解强化学习了。

2023-12-11 18:30:49 1151

1151

等,在实际应用场景中效果不好。为了解决这个问题,将知识注入到PLMs中已经成为一个非常活跃的研究领域。本次分享将介绍三篇知识增强的预训练语言模型论文,分别通过基于知识向量、知识检索以及知识监督的知识注入方法来增强语言预训练模型。

2022-04-02 17:21:43 8765

8765 将模型称为 “视觉语言” 模型是什么意思?一个结合了视觉和语言模态的模型?但这到底是什么意思呢?

2023-03-03 09:49:37 665

665

大型语言模型的出现极大地推动了自然语言处理领域的进步,但同时也存在一些局限性,比如模型可能会产生看似合理但实际上是错误或虚假的内容,这一现象被称为幻觉(hallucination)。幻觉的存在使得

2023-08-15 09:33:45 1090

1090

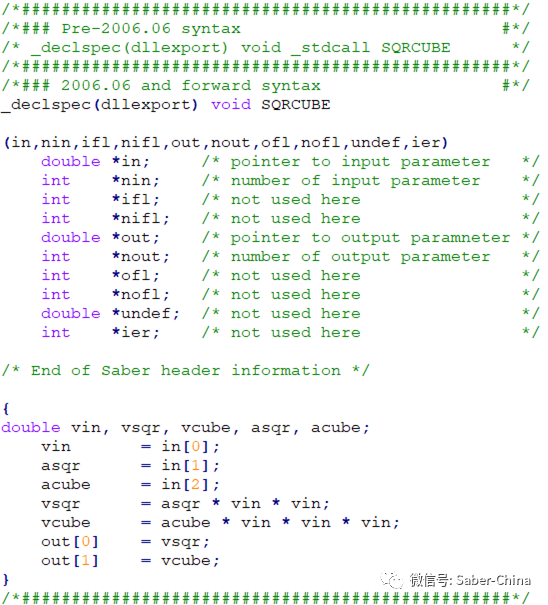

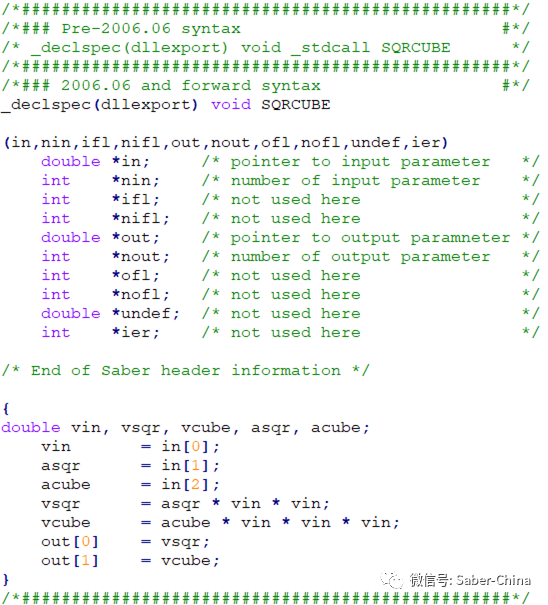

Saber不仅支持MAST语言和VHDL‐AMS语言建立模型,也支持C语言建立器件模型,这对熟悉C语言编程的用户带来了很大的方便和实用。采用C语言建立的模型可以像用硬件语言建立的模型一样保存和使用。

2023-12-05 11:30:42 454

454

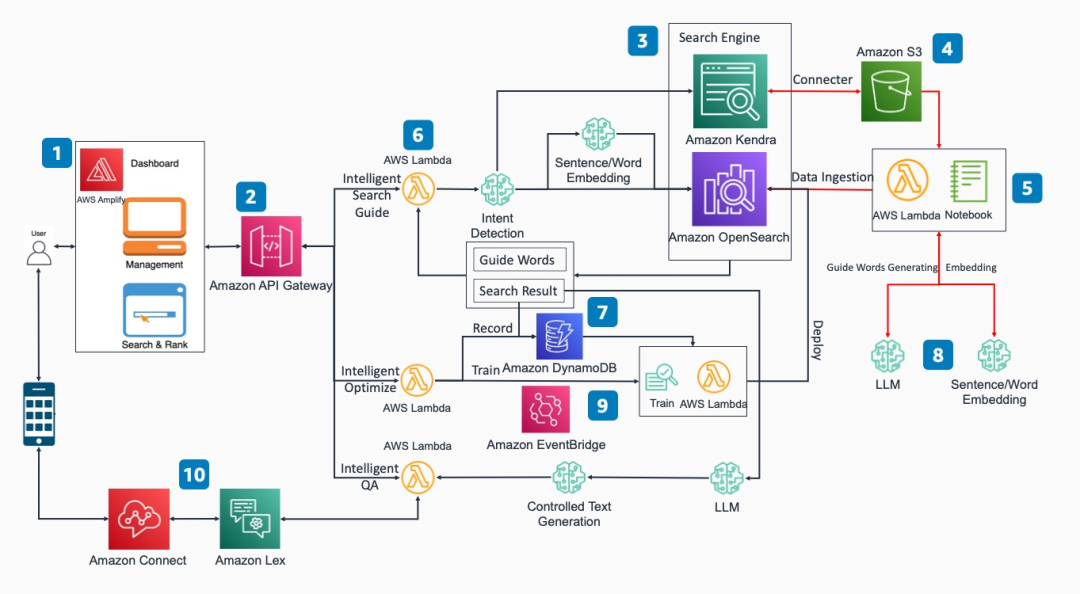

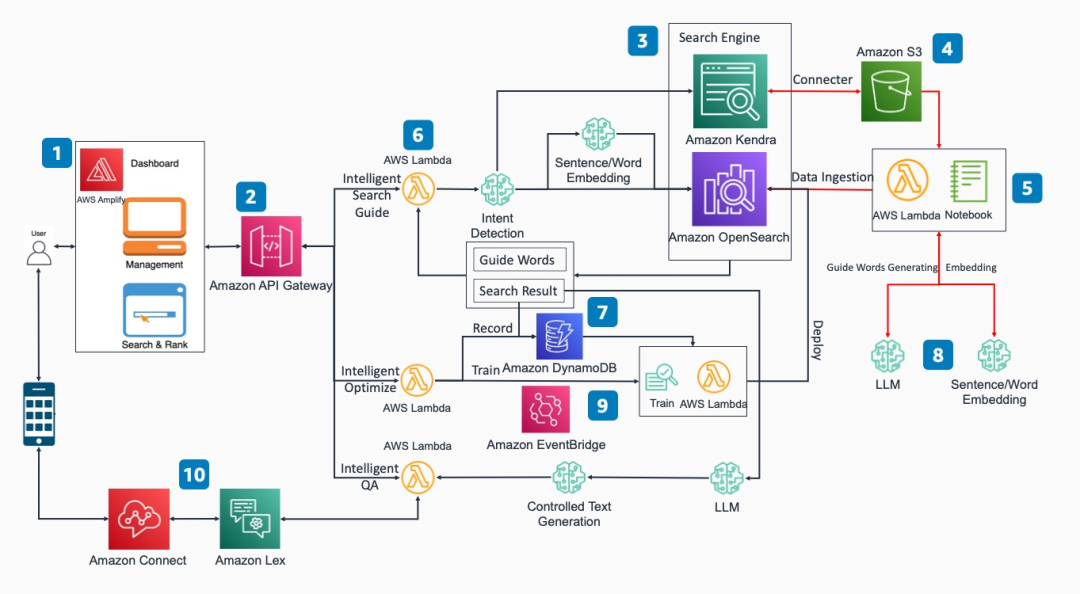

ChatGPT已经成为家喻户晓的名字,而大语言模型在ChatGPT刺激下也得到了快速发展,这使得我们可以基于这些技术来改进我们的业务。

2023-12-06 17:02:27 719

719

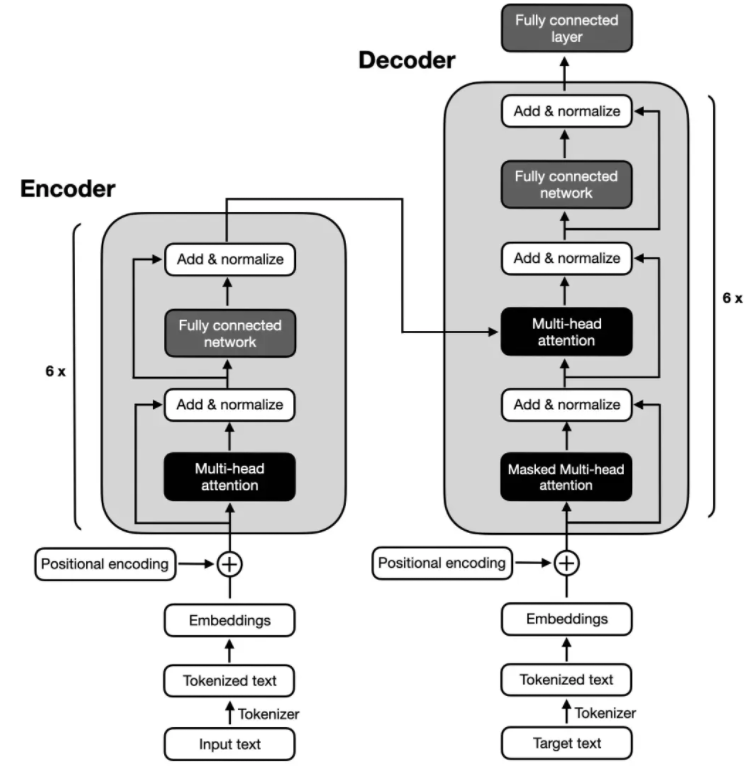

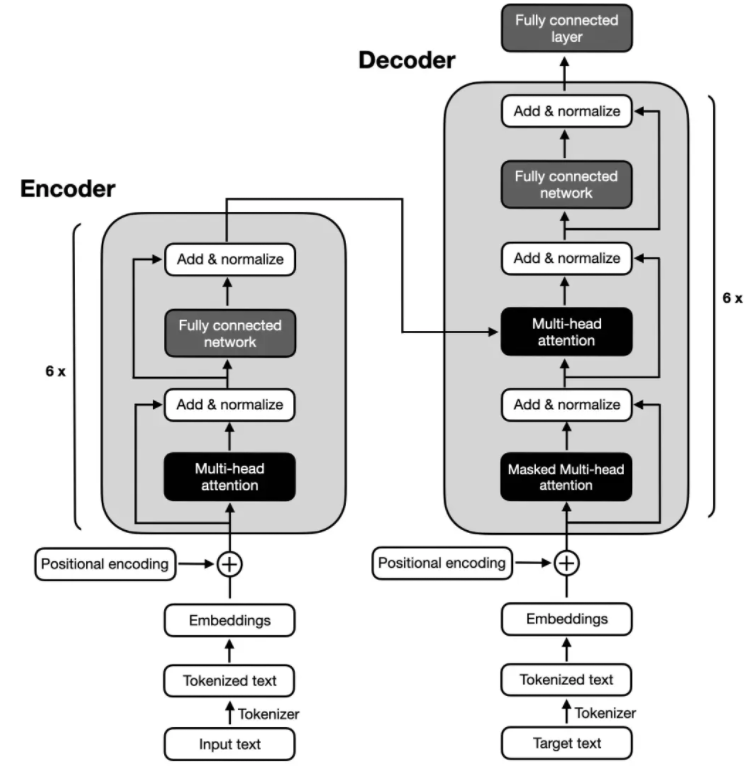

电子发烧友网报道(文/李弯弯)近年来,随着大语言模型的不断出圈,Transformer这一概念也走进了大众视野。Transformer是一种非常流行的深度学习模型,最早于2017年由谷歌

2023-12-25 08:36:00 1282

1282

电子发烧友网报道(文/李弯弯)大语言模型(LLM)是基于海量文本数据训练的深度学习模型。它不仅能够生成自然语言文本,还能够深入理解文本含义,处理各种自然语言任务,如文本摘要、问答、翻译

2024-01-02 09:28:33 1267

1267 400mhz语言视频传输方案怎么实现

2023-10-17 07:22:27

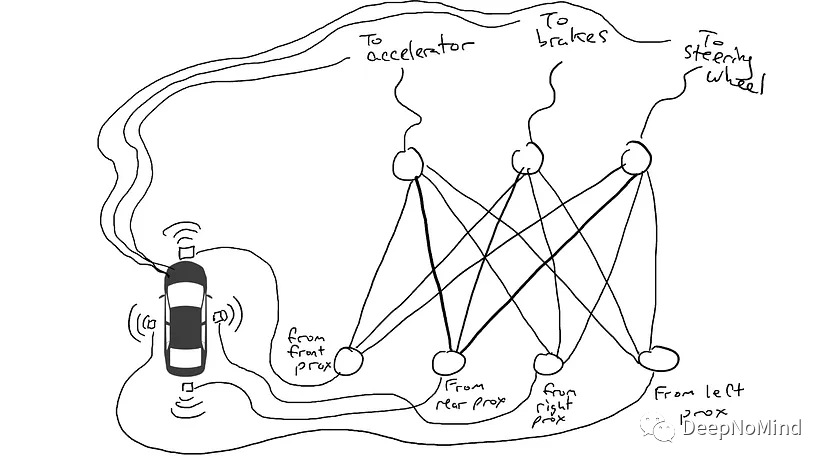

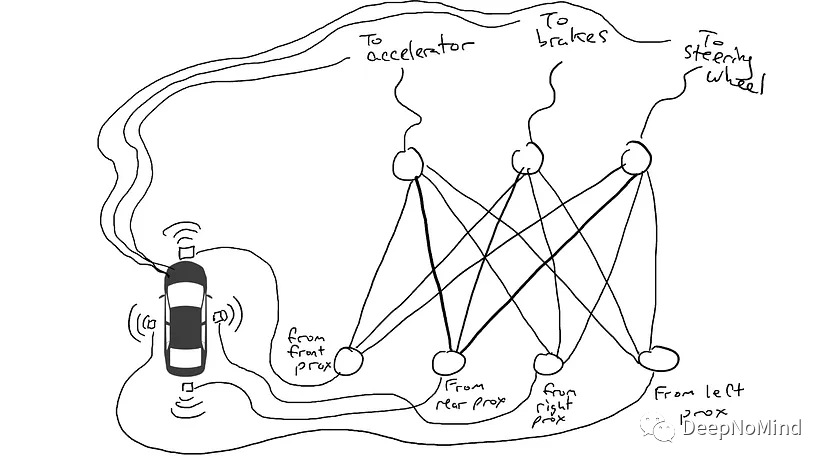

DeepLearning笔记 语言模型和 N-gram

2019-07-23 17:13:48

进行初始化时回调。context接口示例:*附件:HarmonyOSOpenHarmony应用开发-stage模型ArkTS语言AbilityStage.docx

2023-04-07 15:16:35

,然后将得到的特征向量输入到SVM中进行分类。

LabVIEW是一种视觉编程语言,与传统的文本编程语言不同,更适合于进行复杂数据分析和预测模型的开发。

LabVIEW使用数据流模型,可以并行处理多个过程

2023-12-13 19:04:23

2022年11月,ChatGPT的问世展示了大模型的强大潜能,对人工智能领域有重大意义,并对自然语言处理研究产生了深远影响,引发了大模型研究的热潮。

距ChatGPT问世不到一年,截至2023年10

2024-03-11 15:16:39

深远影响,尤其在优化业务流程和重塑组织结构方面。然而,在研究和实践过程中,我们遇到了一个主要挑战:市场上缺乏大语言模型在实际应用方面的资料。现有的资料多聚焦于理论研究,而具体的实践方法多被保密,难以获得

2024-03-18 15:49:46

自然语言处理——54 语言模型(自适应)

2020-04-09 08:20:30

如图前两张为一张图片的R通道进行增强的小程序,可以实现读片的增强,我想问各路大神,如果单纯地从数组方面进行图像增强,如对数增强,那该怎么操作呢,就在第三章图里面,就对一个数组进行处理,后面再由数组转变为图片。

2017-09-26 17:13:37

如何提升EMC性能?求增强电源模块系统稳定性的几个方案

2021-03-16 06:48:24

测试蓝牙增强数据率产品的创新解决方案

2019-09-11 14:07:11

自然语言处理——53 语言模型(数据平滑)

2020-04-16 11:11:25

该文提出了一种新的基于身份的环签名方案,并在标准模型下证明其能抵抗签名伪造攻击,且具有无条件匿名性。与现有标准模型下基于身份的环签名方案相比,新方案具有更短的

2009-11-13 11:49:03 7

7 重新增强高可用性缩减 IT 基础设施模型

2016-01-06 17:33:54 0

0 voico 重新增强高可用性缩减 IT 基础设施模型

2016-06-02 15:41:58 0

0 唇语识别中的话题相关语言模型研究_王渊

2017-03-19 11:28:16 0

0 语言竞争传播演化现象是典型的不能假设、无法进行真实性实验的社会科学问题,而建立在社会仿真模型基础上的计算实验是可行的方案。利用基于Agent的社会圈子网络理论并引入语言的内部词汇结构给出一种新的动态

2017-11-23 15:41:04 6

6 自然语言处理常用模型使用方法一、N元模型二、马尔可夫模型以及隐马尔可夫模型及目前常用的自然语言处理开源项目/开发包有哪些?

2017-12-28 15:42:30 5382

5382

在这篇文章中,我会介绍一篇最新的预训练语言模型的论文,出自MASS的同一作者。这篇文章的亮点是:将两种经典的预训练语言模型(MaskedLanguage Model, Permuted

2020-11-02 15:09:36 2334

2334 在自然语言处理任务中使用注意力机制可准确衡量单词重要度。为此,提出一种注意力增强的自然语言推理模型aESM。将词注意力层以及自适应方向权重层添加到ESIM模型的双向LSTM网络中,从而更有

2021-03-25 11:34:15 9

9 感谢清华大学自然语言处理实验室对预训练语言模型架构的梳理,我们将沿此脉络前行,探索预训练语言模型的前沿技术,红框中为已介绍的文章,绿框中为本期介绍的模型,欢迎大家留言讨论交流。 在之前的一期推送

2021-05-19 15:47:41 3355

3355

本文关注于向大规模预训练语言模型(如RoBERTa、BERT等)中融入知识。

2021-06-23 15:07:31 3468

3468

golang的MPG调度模型是保障Go语言效率高的一个重要特性,本文详细介绍了Go语言调度模型的设计。 前言 Please remember that at the end of the day

2021-07-26 10:12:43 1726

1726

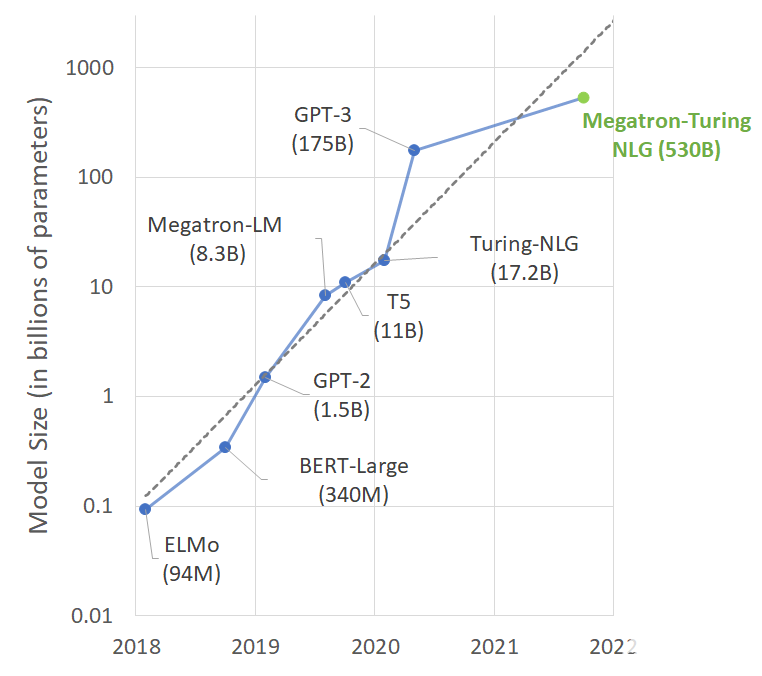

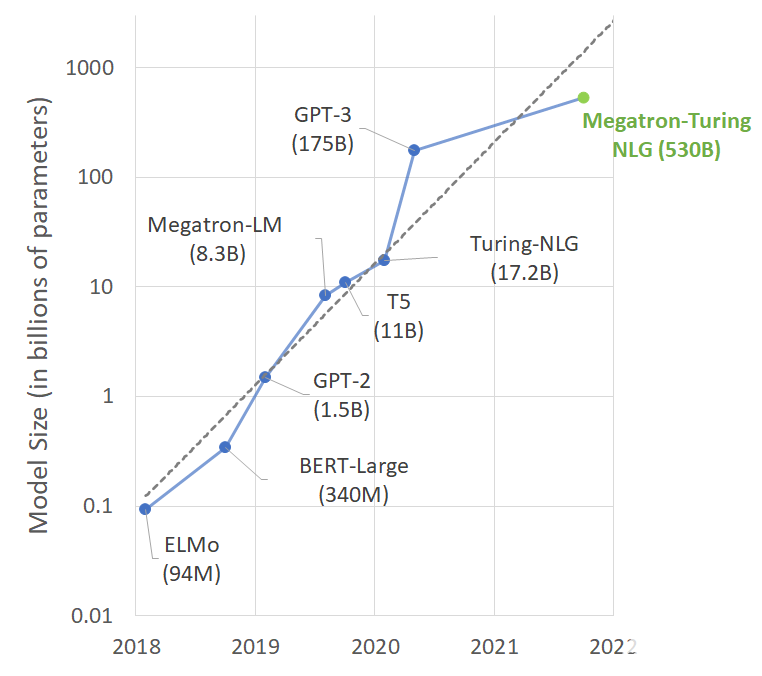

NVIDIA Megatron 是一个基于 PyTorch 的框架,用于训练基于 Transformer 架构的巨型语言模型。本系列文章将详细介绍Megatron的设计和实践,探索这一框架如何助力

2021-10-11 16:46:05 2226

2226

尽管巨型语言模型正在推动语言生成技术的发展,但它们也面临着偏见和毒性等问题。人工智能社区正在积极研究如何理解和消除语言模型中的这些问题,包括微软和 NVIDIA 。

2022-04-17 11:25:34 1946

1946

Facebook在Crosslingual language model pretraining(NIPS 2019)一文中提出XLM预训练多语言模型,整体思路基于BERT,并提出了针对多语言预训练的3个优化任务。后续很多多语言预训练工作都建立在XLM的基础上,我们来详细看看XLM的整体训练过程。

2022-05-05 15:23:49 2521

2521 由于乱序语言模型不使用[MASK]标记,减轻了预训练任务与微调任务之间的gap,并由于预测空间大小为输入序列长度,使得计算效率高于掩码语言模型。PERT模型结构与BERT模型一致,因此在下游预训练时,不需要修改原始BERT模型的任何代码与脚本。

2022-05-10 15:01:27 1173

1173 今天给大家带来一篇IJCAI2022浙大和阿里联合出品的采用对比学习的字典描述知识增强的预训练语言模型-DictBERT,全名为《Dictionary Description Knowledge

2022-08-11 10:37:55 866

866 NVIDIA NeMo 大型语言模型(LLM)服务帮助开发者定制大规模语言模型;NVIDIA BioNeMo 服务帮助研究人员生成和预测分子、蛋白质及 DNA

2022-09-22 10:42:29 742

742 韩国先进的移动运营商构建包含数百亿个参数的大型语言模型,并使用 NVIDIA DGX SuperPOD 平台和 NeMo Megatron 框架训练该模型。

2022-09-27 09:24:30 915

915 输入文本的要点; (2)模型过度依赖语言模型,生成流畅但不充分的单词。 在本文研究中,提出了一个忠实增强摘要模型(FES),旨在解决这两个问题,提高抽象摘要的忠实度。对于第一个问题,本文使用问答(QA)来检查编码器是否完全掌握输入文档,并

2022-11-01 11:37:57 692

692 另一方面,从语言处理的角度来看,认知神经科学研究人类大脑中语言处理的生物和认知过程。研究人员专门设计了预训练的模型来捕捉大脑如何表示语言的意义。之前的工作主要是通过明确微调预训练的模型来预测语言诱导的大脑记录,从而纳入认知信号。

2022-11-03 15:07:08 707

707 (需要有Decoder部分,所以「不包括BERT这类纯Encoder语言模型」),论文的核心贡献是提出一套多任务的微调方案(Flan),来极大提升语言模型的泛化性。

2022-11-24 11:21:56 1040

1040 我们提出了LiteVL,这是一种视频语言模型,它无需大量的视频语言预训练或目标检测器。LiteVL从预先训练的图像语言模型BLIP中继承了空间视觉信息和文本信息之间已经学习的对齐。然后,我们提出

2022-12-05 10:54:49 413

413 来自:圆圆的算法笔记 今天给大家介绍3篇EMNLP 2022中语言模型训练方法优化的工作,这3篇工作分别是: 针对检索优化语言模型 :优化语言模型训练过程,使能够生成更合适的句子表示用于检索

2022-12-22 16:14:56 679

679 InstaDeep、慕尼黑工业大学(TUM)和 NVIDIA 之间的合作推动了面向基因组学的多超级计算规模的基础模型开发进程。这些模型在大量预测任务(例如启动子和增强子位点预测)中展示了最先进的性能

2023-01-17 01:05:04 444

444 BigCode 是一个开放的科学合作组织,致力于开发大型语言模型。近日他们开源了一个名为 SantaCoder 的语言模型,该模型拥有 11 亿个参数

2023-01-17 14:29:53 692

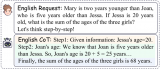

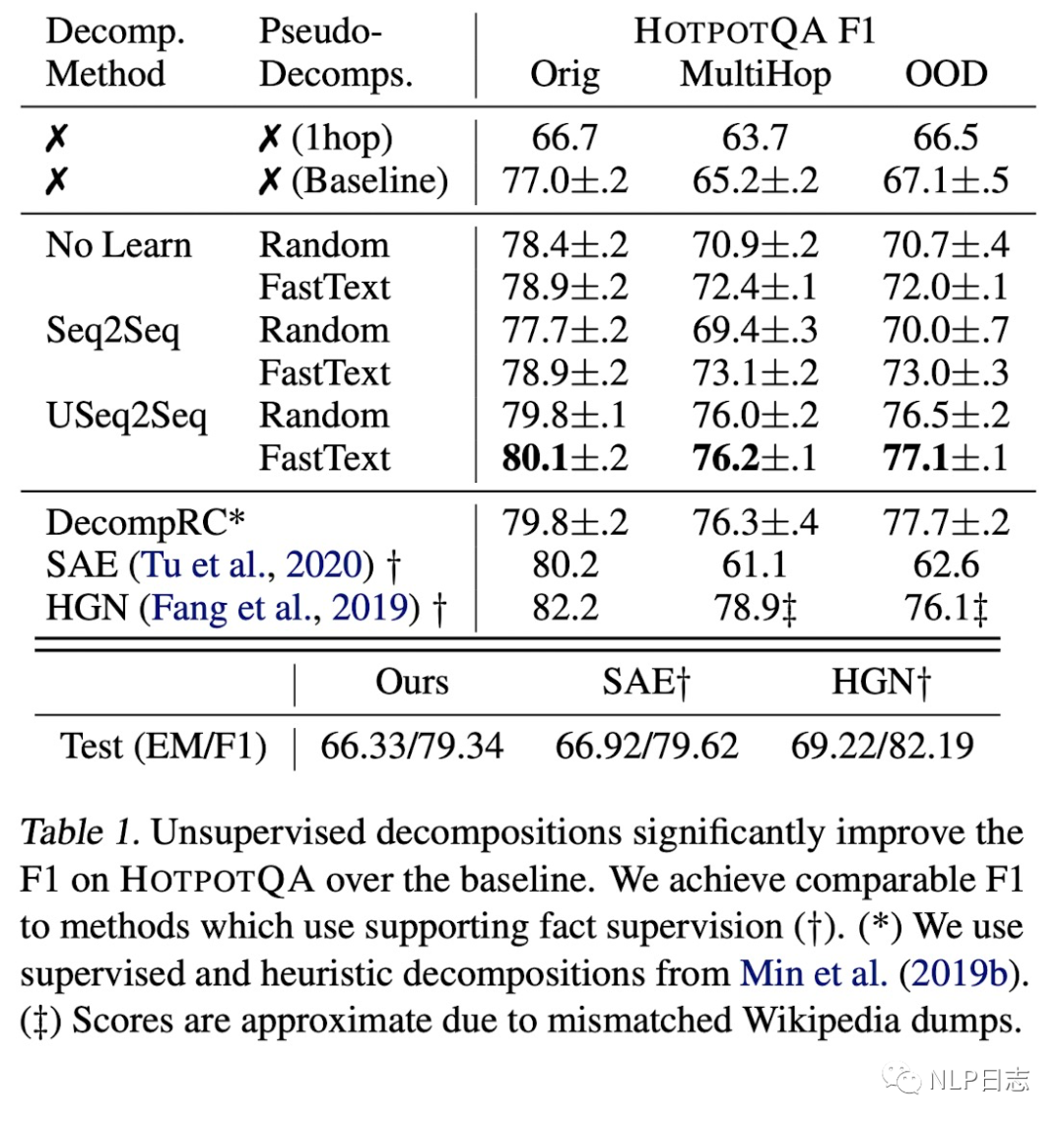

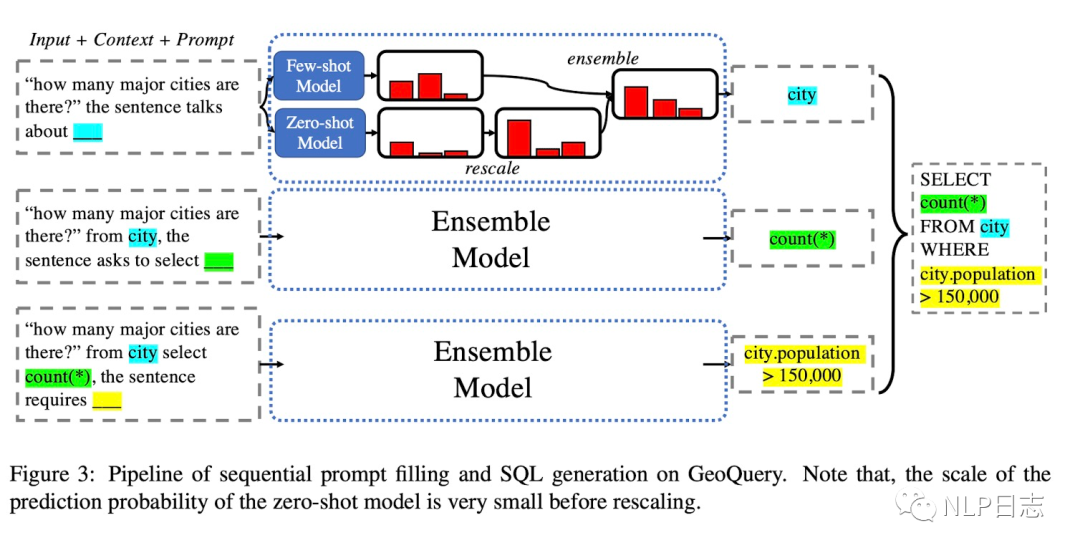

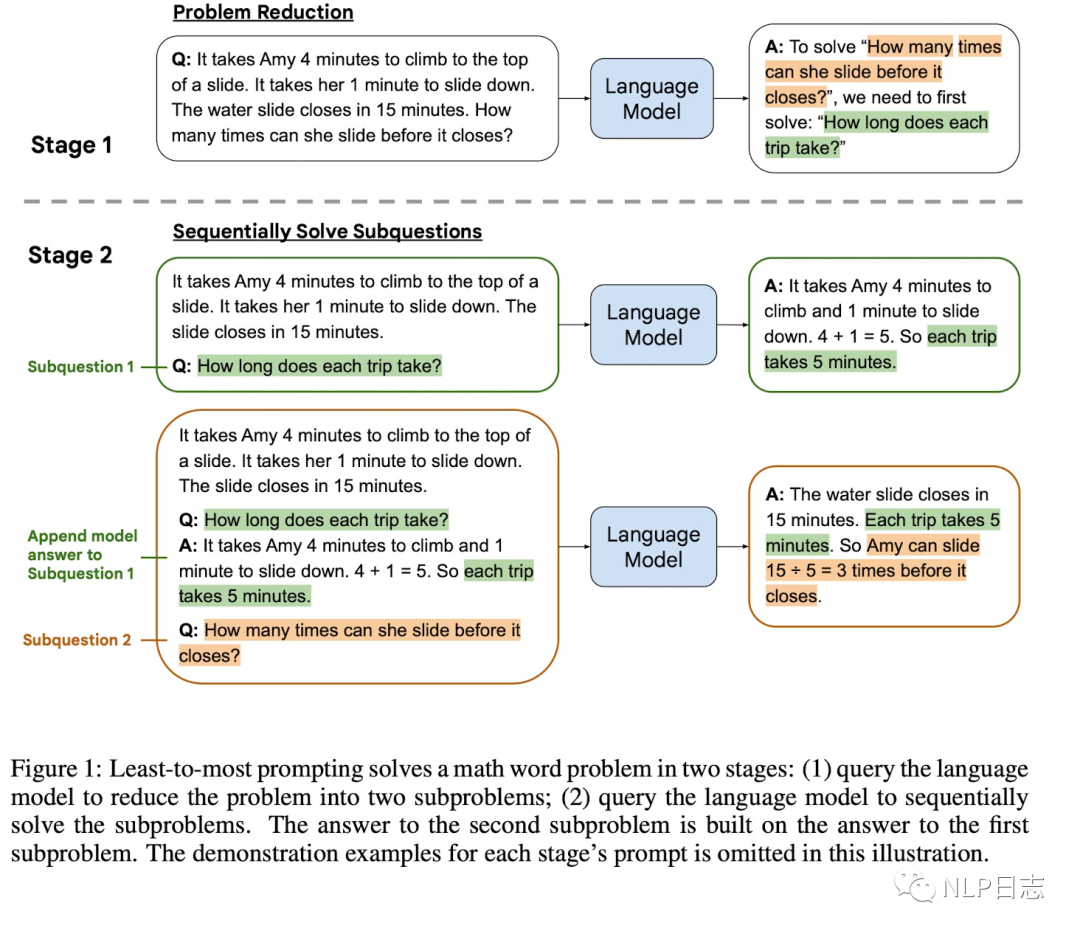

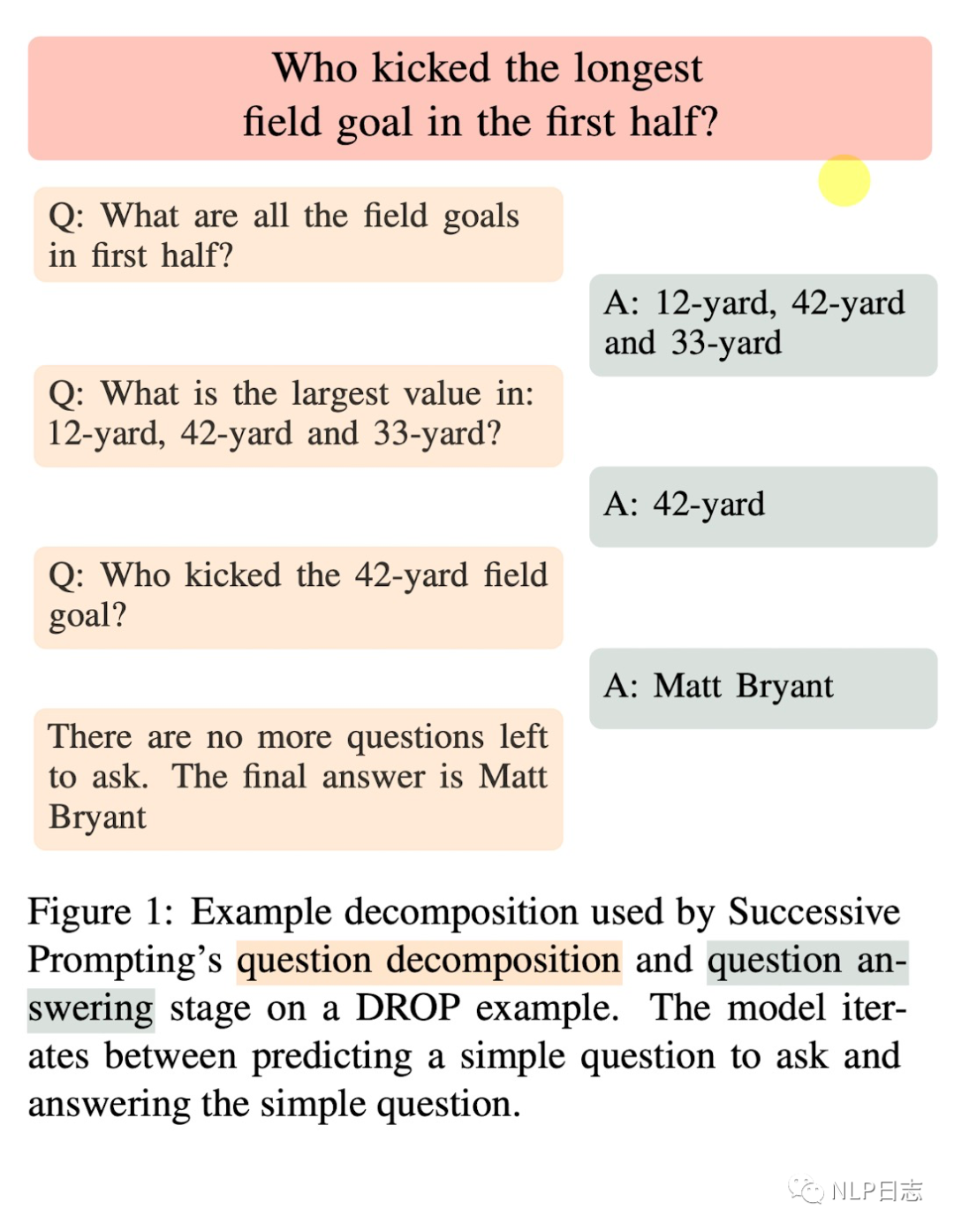

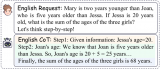

692 如果给语言模型生成一些 prompting,它还向人们展示了其解决复杂任务的能力。标准 prompting 方法,即为使用少样本的问答对或零样本的指令的一系列方法,已经被证明不足以解决需要多个推理步骤的下游任务(Chowdhery 等,2022)。

2023-02-02 16:15:26 772

772 传统的多模态预训练方法通常需要"大数据"+"大模型"的组合来同时学习视觉+语言的联合特征。但是关注如何利用视觉+语言数据提升视觉任务(多模态->单模态)上性能的工作并不多。本文旨在针对上述问题提出一种简单高效的方法。

2023-02-13 13:44:05 727

727 大型语言模型能识别、总结、翻译、预测和生成文本及其他内容。 AI 应用在大型语言模型的帮助下,可用于解决总结文章、编写故事和参与长对话等多种繁重工作。 大型语言模型(LLM)是一种深度学习算法,可以

2023-02-23 19:50:04 3887

3887 最近图灵奖得主Yann LeCun参与撰写了一篇关于「增强语言模型」的综述,回顾了语言模型与推理技能和使用工具的能力相结合的工作,并得出结论,这个新的研究方向有可能解决传统语言模型的局限性,如可解释性、一致性和可扩展性问题。

2023-03-03 11:03:20 673

673 大型语言模型能识别、总结、翻译、预测和生成文本及其他内容。

2023-03-08 13:57:00 6989

6989 谷歌正在朝着构建支持1000种不同语言的人工智能语言模型的目标迈进……

2023-03-07 10:22:58 466

466

能力。从现场展示来看,文心一言某种程度上具有了对人类意图的理解能力。但李彦宏也多次提及,这类大语言模型还远未到发展完善的阶段,进步空间很大。 百度同时公布了文心一言的邀请测试方案。3 月 16 日起,首批用户即可通过邀请测试码,在

2023-03-17 04:40:01 604

604 Bloom是个多语言模型,由于需要兼容多语言,所以词表有25w之多,在中文领域中,大部分词表并不会被用到。我们通过删减冗余的词表,从多语言模型中提取常用的中英文词表,最终词表从25w减少到46145,缩减为原来的18.39%,在保留预训练知识的同时,有效减少参数量,提高训练效率。

2023-04-07 10:36:08 4319

4319 在本文中,我们将展示如何使用 大语言模型低秩适配 (Low-Rank Adaptation of Large Language Models,LoRA) 技术在单 GPU 上微调 110 亿参数的 FLAN-T5 XXL 模型。

2023-04-14 17:37:40 1503

1503 基础 LLM 基本信息表,GPT-style 表示 decoder-only 的自回归语言模型,T5-style 表示 encoder-decoder 的语言模型,GLM-style 表示 GLM 特殊的模型结构,Multi-task 是指 ERNIE 3.0 的模型结构

2023-04-20 11:25:44 1071

1071 对于任何没有额外微调和强化学习的预训练大型语言模型来说,用户得到的回应质量可能参差不齐,并且可能包括冒犯性的语言和观点。这有望随着规模、更好的数据、社区反馈和优化而得到改善。

2023-04-24 10:07:06 2168

2168

GPT是基于Transformer架构的大语言模型,近年迭代演进迅速。构建语言模型是自然语言处理中最基本和最重要的任务之一。GPT是基于Transformer架构衍生出的生成式预训练的单向语言模型,通过对大 量语料数据进行无监督学习

2023-04-28 10:01:59 585

585

近来NLP领域由于语言模型的发展取得了颠覆性的进展,扩大语言模型的规模带来了一系列的性能提升,然而单单是扩大模型规模对于一些具有挑战性的任务来说是不够的

2023-05-10 11:13:17 1377

1377

大型语言模型LLM(Large Language Model)具有很强的通用知识理解以及较强的逻辑推理能力,但其只能处理文本数据。

2023-05-10 16:53:15 701

701

以ChatGPT为代表的大语言模型(Large Language Models, LLM)在机器翻译(Machine Translation, MT)任务上展现出了惊人的潜力。

2023-05-17 09:56:26 903

903

电子发烧友网站提供《PyTorch教程9.3.之语言模型.pdf》资料免费下载

2023-06-05 09:59:00 0

0 9.3. 语言模型¶ Colab [火炬]在 Colab 中打开笔记本 Colab [mxnet] Open the notebook in Colab Colab [jax

2023-06-05 15:44:24 268

268

大型语言模型研究的发展有三条技术路线:Bert 模式、GPT 模式、混合模式。其中国内大多采用混合模式, 多数主流大型语言模型走的是 GPT 技术路线,直到 2022 年底在 GPT-3.5 的基础上产生了 ChatGPT。

2023-06-09 12:34:53 3162

3162

在一些非自然图像中要比传统模型表现更好 CoOp 增加一些 prompt 会让模型能力进一步提升 怎么让能力更好?可以引入其他知识,即其他的预训练模型,包括大语言模型、多模态模型 也包括

2023-06-15 16:36:11 277

277

本文旨在让没有计算机科学背景的人对ChatGPT和类似的人工智能系统(GPT-3、GPT-4、Bing Chat、Bard等)的工作原理有一些了解。ChatGPT是一种基于*大语言模型(Large Language Model)* 的对话式AI聊天机器人。

2023-06-16 09:59:04 1036

1036

本文旨在更好地理解基于 Transformer 的大型语言模型(LLM)的内部机制,以提高它们的可靠性和可解释性。 随着大型语言模型(LLM)在使用和部署方面的不断增加,打开黑箱并了解它们的内部

2023-06-25 15:08:49 991

991

大型语言模型(LLM) 是一种深度学习算法,可以通过大规模数据集训练来学习识别、总结、翻译、预测和生成文本及其他内容。大语言模型(LLM)代表着 AI 领域的重大进步,并有望通过习得的知识改变

2023-07-05 10:27:35 1463

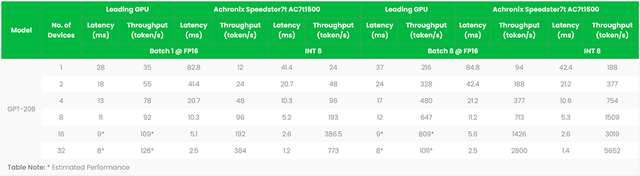

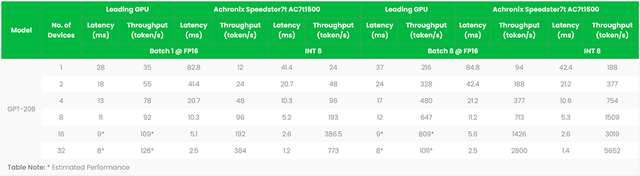

1463 7月6日,在世界人工智能大会WAIC上,墨芯人工智能发布了大模型算力方案的最新成果,宣告进入“千亿”时代:墨芯AI计算平台率先支持高达千亿参数的大语言模型,并在吞吐、延时等多项指标上表现优异,创下

2023-07-07 14:41:17 535

535 简单来说,语言模型能够以某种方式生成文本。它的应用十分广泛,例如,可以用语言模型进行情感分析、标记有害内容、回答问题、概述文档等等。但理论上,语言模型的潜力远超以上常见任务。

2023-07-14 11:45:40 454

454

LLM(大语言模型)因其强大的语言理解能力赢得了众多用户的青睐,但LLM庞大规模的参数导致其部署条件苛刻;

2023-07-20 10:49:29 655

655

近日,清华大学新闻与传播学院发布了《大语言模型综合性能评估报告》,该报告对目前市场上的7个大型语言模型进行了全面的综合评估。近年,大语言模型以其强大的自然语言处理能力,成为AI领域的一大热点。它们

2023-08-10 08:32:01 607

607

本篇内容是对于ACL‘23会议上陈丹琦团队带来的Tutorial所进行的学习记录,以此从问题设置、架构、应用、挑战等角度全面了解检索增强的语言模型,作为对后续工作的准备与入门,也希望能给大家带来

2023-08-21 09:58:01 1234

1234

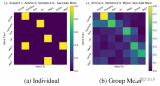

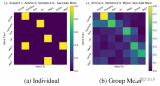

最近,AI大模型测评火热,尤其在大语言模型领域,“聪明”的上限 被 不断刷新。 商汤与上海AI实验室等联合打造的大语言模型“书生·浦语”(InternLM)也表现出色,分别在 智源FlagEval

2023-08-25 13:00:02 315

315

大语言模型的构建通常需要一个大规模的系统来执行该模型,这个模型会持续变大,在其发展到一定程度后,仅靠在CPU上的运行就不再具有成本、功耗或延迟的优势了。

2023-08-31 15:34:36 505

505

生成式AI和大语言模型(LLM)正在以难以置信的方式吸引全世界的目光,本文简要介绍了大语言模型,训练这些模型带来的硬件挑战,以及GPU和网络行业如何针对训练的工作负载不断优化硬件。

2023-09-01 17:14:56 1046

1046

作者:Bill Jenkins,Achronix人工智能/机器学习产品营销总监 探索FPGA加速语言模型如何通过更快的推理、更低的延迟和更好的语言理解来重塑生成式人工智能 简介:大语言模型 近年来

2023-09-04 16:55:25 345

345

腾讯发布混元大语言模型 腾讯全球数字生态大会上腾讯正式发布了混元大语言模型,参数规模超千亿,预训练语料超2万亿tokens。 作为腾讯自研的通用大语言模型,混元大语言模型具有中文创作能力、任务执行

2023-09-07 10:23:54 815

815 自ChatGPT发布以来,生成式AI在全球引起了新的浪潮,它影响着各行各业,为世界带来智能化的发展。然而,类ChatGPT的大语言模型极度依赖算力巨大的服务器,导致目前大部分应用只能通过集中调用

2023-09-09 08:02:39 952

952

本文提出了新型的可控光照增强框架,主要采用了条件扩散模型来控制任意区域的任意亮度增强。通过亮度控制模块(Brightness Control Module)将亮度信息信息融入Diffusion网络中,并且设计了和任务适配的条件控制信息和损失函数来增强模型的能力。

2023-09-11 17:20:14 384

384

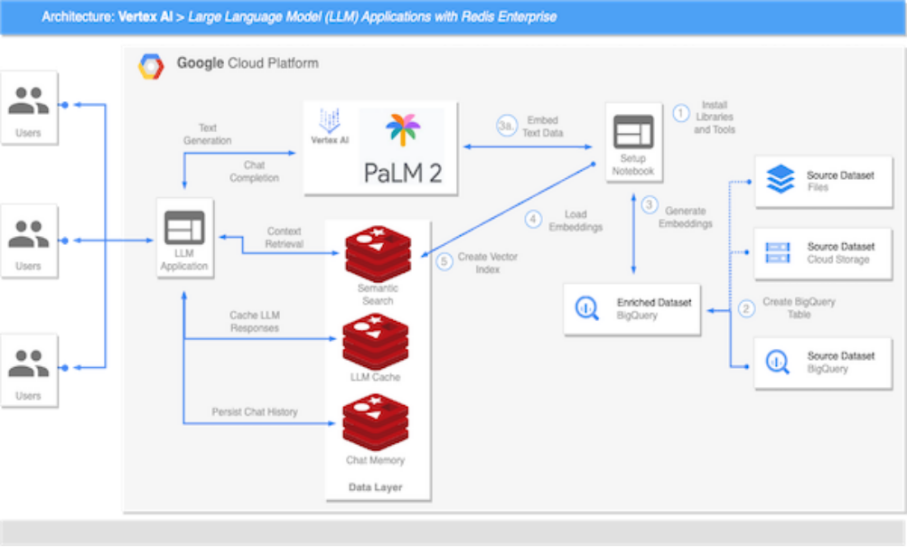

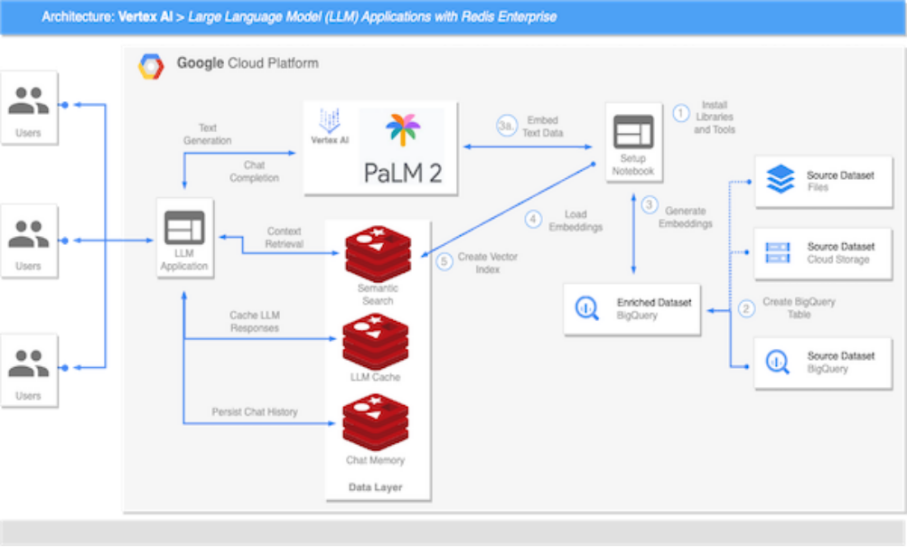

基础模型和高性能数据层这两个基本组件始终是创建高效、可扩展语言模型应用的关键,利用Redis搭建大语言模型,能够实现高效可扩展的语义搜索、检索增强生成、LLM 缓存机制、LLM记忆和持久

2023-09-18 11:26:49 316

316

近来,大语言模型 (LLM) 已被证明是提高编程、内容生成、文本分析、网络搜索及远程学习等诸多领域生产力的可靠工具。

2023-10-19 09:13:57 410

410

Transformer 架构的问世标志着现代语言大模型时代的开启。自 2018 年以来,各类语言大模型层出不穷。

2023-10-24 11:42:05 337

337

10 月 28 日,汽车行业大语言模型研讨会正式结束。 NVIDIA 解决方案架构师陈文恺 在研讨会中讲解了 汽车行业如何开发企业级大语言模型,以加速行业创新和发展 。同时,NVIDIA 汽车行业

2023-11-03 19:10:03 356

356 人工智能尤其是大型语言模型的应用,重塑了我们与信息交互的方式,也为企业带来了重大的变革。将基于大模型的检索增强生成(RAG)集成到业务实践中,不仅是一种趋势,更是一种必要。它有助于实现数据驱动型决策

2023-11-06 08:10:02 216

216

进一步地,提出了Cross-Lingual Self-consistent Prompting (CLSP),利用不同语言专家的知识和不同语言间更加多样的思考方式,集成了多个推理路径,显著地提高了self-consistency的跨语言性能。CLSP 都能够在CLP的基础上更进一步地有效提高零样本跨语言 CoT 性能。

2023-11-08 16:59:42 261

261

11月8日,2023年世界互联网大会乌镇峰会正式开幕,今年是乌镇峰会举办的第十年,本次峰会的主题为“建设包容、普惠、有韧性的数字世界——携手构建网络空间命运共同体”。百度知识增强大语言模型关键技术

2023-11-09 11:02:49 307

307 /算法/软件工程师的人力投入和包括硬件在内的物力投入。那么在自己的环境中搭建智能搜索大语言模型增强方案是必不可少的。因此,本篇内容主要为大语言模型方案的快速部署。该方案部署流程并不复杂,只需要您对于亚马逊云科技

2023-11-10 11:08:27 404

404

简介章节讲的是比较基础的,主要介绍了本次要介绍的概念,即检索(Retrieval)和大语言模型(LLM)

2023-11-15 14:50:36 282

282

本文基于亚马逊云科技推出的大语言模型与生成式AI的全家桶:Bedrock对大语言模型进行介绍。大语言模型指的是具有数十亿参数(B+)的预训练语言模型(例如:GPT-3, Bloom, LLaMA)。这种模型可以用于各种自然语言处理任务,如文本生成、机器翻译和自然语言理解等。

2023-12-04 15:51:46 356

356 近年来,随着科技的飞速发展,大语言模型成为人工智能领域的一颗璀璨明珠。在这个信息爆炸的时代,大语言模型以其强大的自学习能力和广泛的应用领域引起了广泛关注。作为亚马逊云科技的前沿技术之一,本文将深入探讨大语言模型的革新之处以及在实际应用中的崭新可能性。

2023-12-06 13:57:13 447

447 大规模语言模型(Large Language Models,LLM),也称大规模语言模型或大型语言模型,是一种由包含数百亿以上参数的深度神经网络构建的语言模型,使用自监督学习方法通过大量无标注

2023-12-07 11:40:43 1141

1141

在科技飞速发展的当今时代,人工智能技术成为社会进步的关键推动力之一。在广泛关注的人工智能领域中,大语言模型以其引人注目的特性备受瞩目。 大语言模型的定义及发展历史 大语言模型是一类基于深度学习技术

2023-12-21 17:53:59 555

555 尽管基本的CoT提示策略在复杂推理任务中展示出了强大的能力,但它仍然面临着一些问题,比如推理过程存在错误和不稳定等。因此,一系列的研究通过增强的提示方法激发大语言模型的能力,从而完成更通用的任务。

2023-12-27 14:19:04 268

268

在信息爆炸的时代,我们渴望更智能、更高效的语言处理工具。GPT-3.5等大语言模型的崛起为我们提供了前所未有的机会。这不仅是技术的进步,更是人与机器共舞的一幕。本篇文章将带你走进这个奇妙的语言王国

2023-12-29 14:18:59 276

276 最近复旦大学自然语言处理组郑骁庆和黄萱菁团队提出了基于表征工程(Representation Engineering)的生成式语言大模型人类偏好对齐方法RAHF(如图1所示),作为基于人类反馈的强化

2024-01-03 14:25:50 161

161

随着开源预训练大型语言模型(Large Language Model, LLM )变得更加强大和开放,越来越多的开发者将大语言模型纳入到他们的项目中。其中一个关键的适应步骤是将领域特定的文档集成到预训练模型中,这被称为微调。

2024-01-04 12:32:39 228

228

近期的大语言模型(LLM)在自然语言理解和生成上展现出了接近人类的强大能力,远远优于先前的BERT等预训练模型(PLM)。

2024-01-04 14:06:39 139

139

1月17日,商汤科技与上海AI实验室联合香港中文大学和复旦大学正式发布新一代大语言模型书⽣·浦语2.0(InternLM2)。

2024-01-17 15:03:57 332

332

ByteDance Research 基于开源的多模态语言视觉大模型 OpenFlamingo 开发了开源、易用的 RoboFlamingo 机器人操作模型,只用单机就可以训练。

2024-01-19 11:43:08 106

106

自然语言处理领域存在着一个非常有趣的现象:在多语言模型中,不同的语言之间似乎存在着一种隐含的对齐关系。

2024-02-20 14:53:06 84

84

研究者们提出了一个框架来描述LLMs在处理多语言输入时的内部处理过程,并探讨了模型中是否存在特定于语言的神经元。

2024-03-07 14:44:02 60

60

电子发烧友App

电子发烧友App

评论