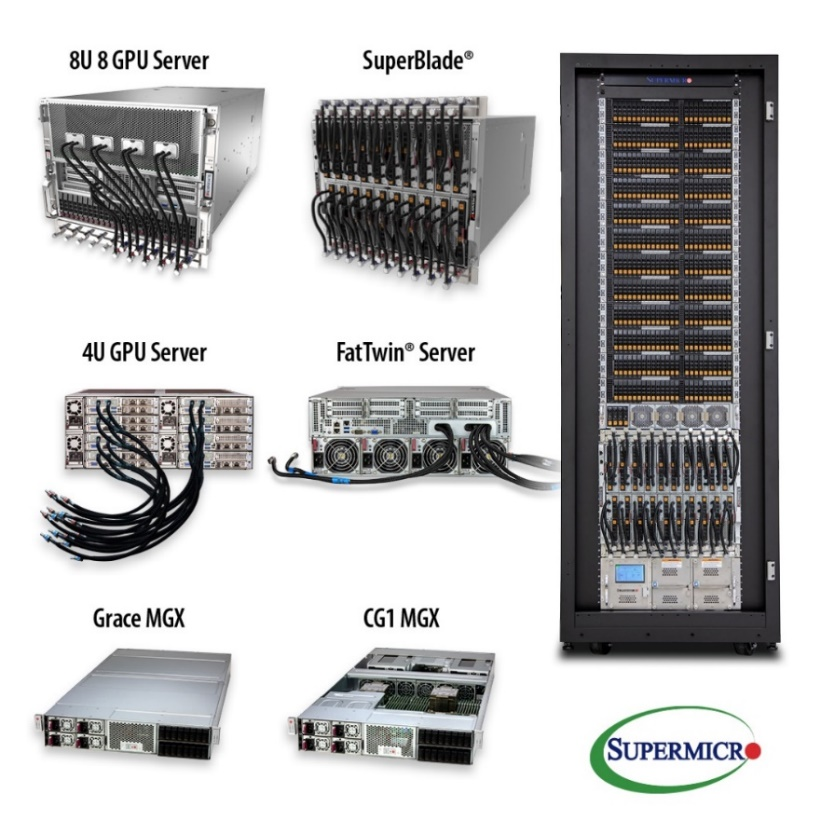

从云端到边缘完善的系统组合,支持NVIDIA HGX H100系统、L40和L4 GPU及OVX 3.0系统

【2023 年 3 月 21 日美国加州圣何塞讯】Super Micro Computer, Inc. (NASDAQ:SMCI) 为AI/ML、云端、存储和5G/智能边缘应用的全方位IT解决方案供应商,宣布其配备最新NVIDIA HGX H100 8-GPU系统的顶级全新GPU服务器开始出货。该服务器整合了最新的NVIDIA L4 Tensor Core GPU至从边缘到数据中心的各种应用优化服务器中。

Supermicro总裁暨首席执行官梁见后(Charles Liang)表示:“Supermicro提供业界最全面的 GPU系统产品组合,包含 8U、6U、5U、4U、2U 和 1U 外形尺寸的服务器,并支持全系列新NVIDIA H100 GPU的工作站和SuperBlade系统。 通过这款NVIDIA HGX H100 Delta-Next 服务器,客户将获得相较上一代 AI 训练应用9倍的性能提升。 我们的GPU服务器采用创新的气流设计,能全面降低风扇转速、噪音和功耗,进而降低总拥有成本(TCO)。 此外,对于正在寻找符合未来需求的数据中心的客户,我们也为其提供完整的机柜级(rack-scale)液冷选项。 ”

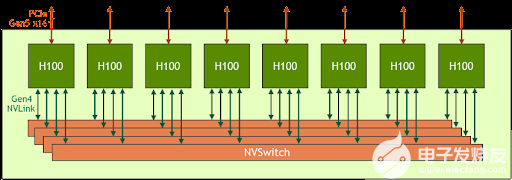

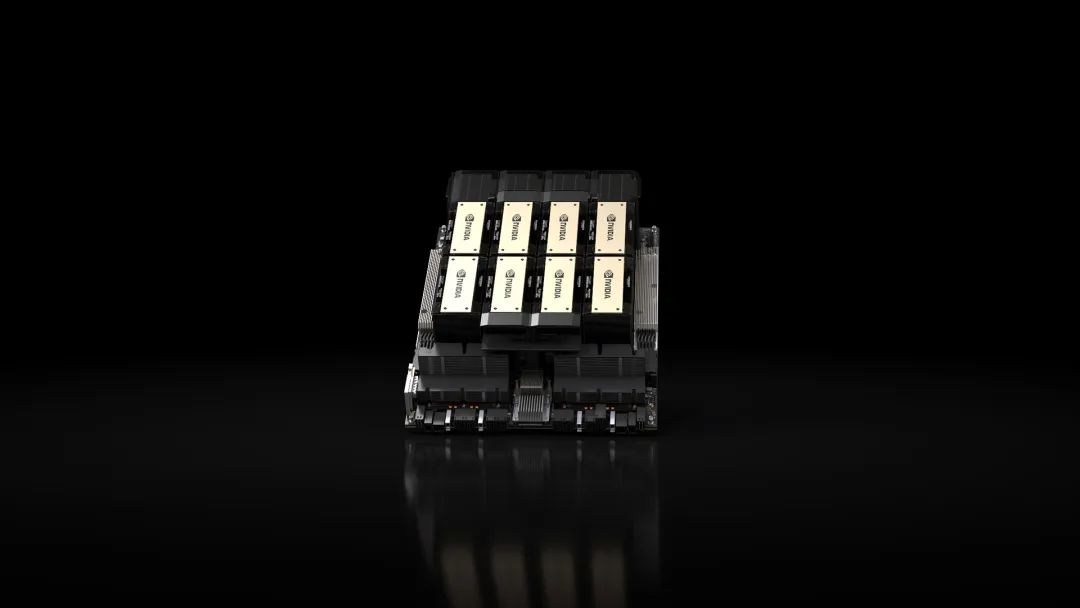

Supermicro的高性能新型8U GPU服务器现已大量出货。 这款全新 Supermicro 8U 服务器特别针对AI、DL、ML和HPC工作负载进行了优化,搭载能达到高GPU-to-GPU通信的NVIDIA HGX H100 8-GPU,使用高速NVIDIA NVLink® 4.0技术、NVSwitch 互连,以及 NVIDIA Quantum-2 InfiniBand 和 Spectrum-4 以太网,从而大幅突破 AI 的障碍。 此外,Supermicro还提供多种性能优化的GPU服务器配置,包括直连/单根(single-root)/ 双根(dual-root) CPU-to-GPU,另外还有前置或后置 I/O 机型,在标准和OCP DC机柜 配置中使用AC与DC 电源。 Supermicro X13 SuperBlade® 机壳可在一个 8U 机壳内放入 20 个 NVIDIA H100 Tensor Core PCIe GPU 或 40 个 NVIDIA L40 GPU,6U机壳则最多可使用10个NVIDIA H100 PCIe GPU或20个NVIDIA L4 TensorCore GPU。 这些新系统为运行NVIDIA AI 平台软件层 NVIDIA AI Enterprise提供理想的优化加速功能。

此类服务器内置的液冷系统也适用于其他众多GPU 服务器。 此外,Supermicro 发布了一款液冷式 AI 开发系统 (塔式或机架式配置皆可),内含两个 CPU 和四个NVIDIA A100 Tensor Core GPU,适合办公室和家庭办公环境,并能部署在部门和企业集群中。

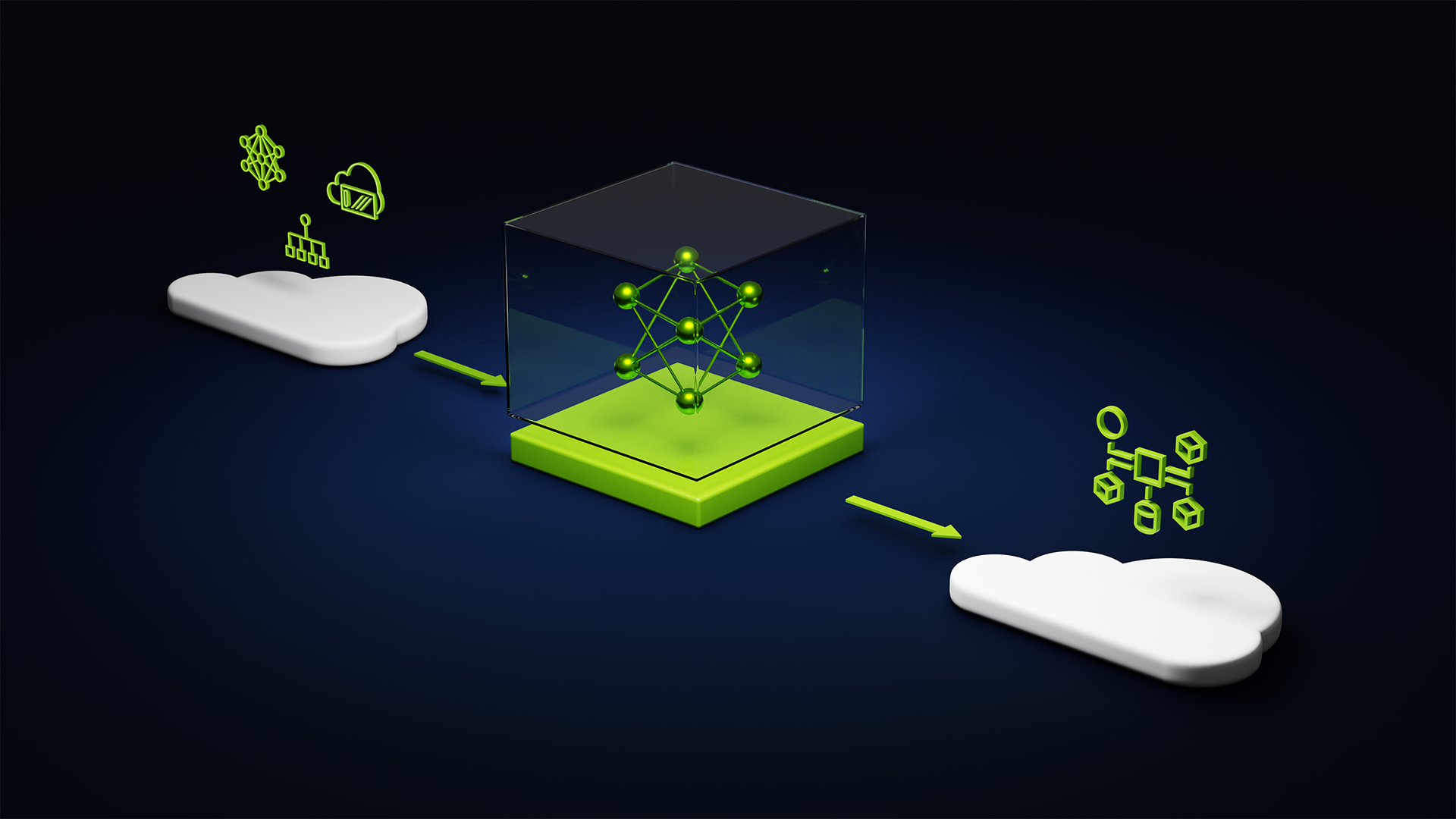

Supermicro系统支持新的 NVIDIA L4 GPU,与前几代产品相比,加速和能效均提升数倍。 此系统同样适用于企业、云和边缘的 AI 推理、视频流、虚拟工作站和图形应用程序。 L4 采用NVIDIA的AI平台和全堆叠方法,经过优化调整,适合进行各种 AI 应用程序的大规模推理,包括推荐、语音型 AI 虚拟人物助理、聊天机器人、视觉搜索和客服中心自动化等,能提供出色的个性化体验。 L4是适用于主流服务器的高效NVIDIA加速器,拥有高达4倍的AI性能、更高的能源使用效率,还有3倍以上的视频流容量与效率,因此能支持 AV1 编码/解码。 L4 GPU拥有多样化的推理和可视化功能,加上轻巧、节能、单插槽、薄型、72W的低功耗规格,是包括边缘位置在内全局部署的理想选择。

NVIDIA 加速计算产品主管Dave Salvator 表示:“Supermicro 服务器配备新的 NVIDIA L4 Tensor Core GPU,拥有无与伦比的强大性能,让客户能高效且可持续地加快工作负载速度。 NVIDIA L4经过优化,适合用于主流部署,加上外型轻薄,可在72W的低功耗范围内作业,将边缘AI性能和效率提升至全新境界。”

Supermicro最新的PCIe加速解决方案支持打造3D世界、数字孪生、3D模拟模型和工业元宇宙。 除了支持前几代NVIDIA OVX™系统,Supermicro也提供OVX 3.0 配置,配备四个NVIDIA L40 GPU、两个NVIDIA ConnectX-7® SmartNIC、一个NVIDIA BlueField-3® DPU及新的NVIDIA Omniverse Enterprise™软件。

深入了解所有 Supermicro 先进的新GPU系统,请访问:https://www.supermicro.com/en/accelerators/nvidia

欢迎至2023 NVIDIA GTC深入了解Supermicro:- https://register.nvidia.com/events/widget/nvidia/gtcspring2023/sponsorcatalog/exhibitor/1564778120132001ghs2/?ncid=ref-spo-128510

Supermicro推出配备NVIDIA HGX及PCIe型H100 8-GPU尖端服务器系统,适用于AI 训练、深度学习、HPC和生成式AI,加速AI和

- AI(263628)

- Supermicro(9217)

- H100(187)

- 生成式AI(160)

相关推荐

云服务、OEM 借助 NVIDIA AI让AI训练更上层楼

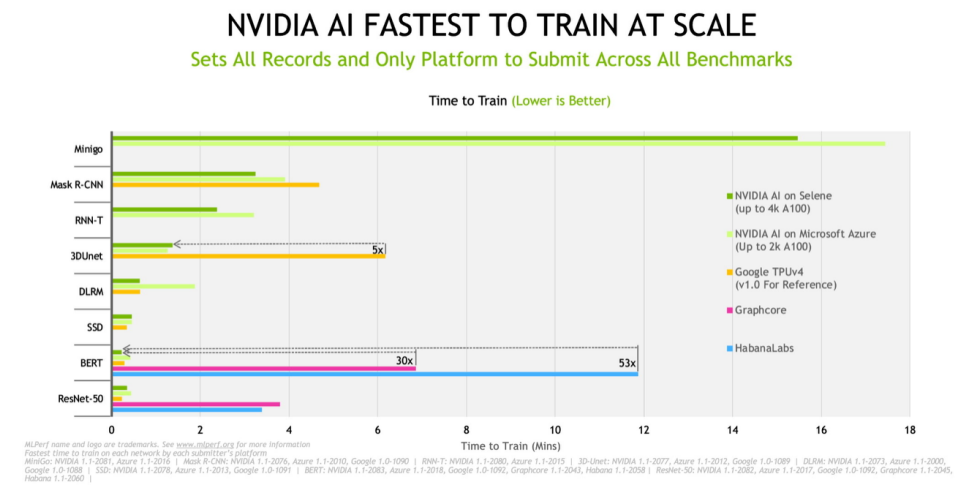

借助 NVIDIA AI,戴尔、浪潮、Microsoft Azure 和 Supermicro 在今天发布的新 MLPerf 基准测试中创下快速训练 AI 模型的记录。

2021-12-03 10:19:52 1469

1469

1469

1469

深度学习模型部署与优化:策略与实践;L40S与A100、H100的对比分析

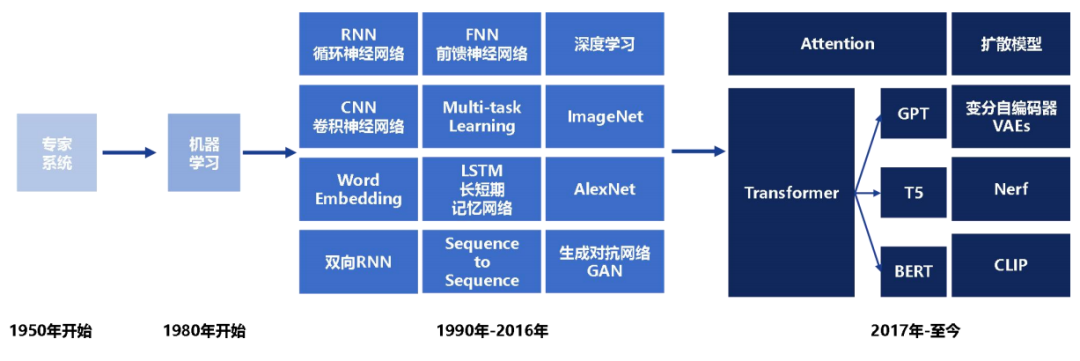

随着生成式AI应用的迅猛发展,我们正处在前所未有的大爆发时代。在这个时代,深度学习模型的部署成为一个亟待解决的问题。尽管GPU在训练和推理中扮演着关键角色,但关于它在生成式AI领域的误解仍然存在。近期英伟达L40S GPU架构成为了热门话题,那么与A100和H100相比,L40S有哪些优势呢?

2023-10-07 09:43:18 1112

1112

1112

1112

基于NVIDIA GPU的加速服务 为AI、机器学习和AI工作负载提速

2019年8月26日 ——NVIDIA和VMware今日宣布将为VMware Cloud on AWS推出基于NVIDIA GPU的加速服务,为AI、机器学习和数据分析工作流程等现代化企业应用提供支持。

2019-08-30 09:36:37 1170

1170

1170

1170华硕推出最新一代支持11路PCIe 4.0的2U单插槽GPU服务器

华硕这个服务器适用于数据中心,适合执行AI、数据分析及HPC运算,因为它同时支持AMD及NVIDIA最新产品,包括EYPC 7002系列CPU及NVIDIA A100加速卡,这两款都是最新的7nm工艺芯片。

2020-09-15 16:23:44 3359

3359

3359

3359ChatGPT热潮引发AI服务器爆单

、FPGA、ASIC等加速芯片,利用CPU与加速芯片的组合可以满足高吞吐量互联的需求,为自然语言处理、计算机视觉、机器学习等AI应用场景提供强大的算力支持,支撑AI算法训练和推理。 AI 服务器与普通服务器的区别 服务器是一种高性能计算机,作为网络的节点,存储、处理网络

2023-02-22 01:13:00 1737

1737

1737

1737AI-ESTATE标准(适用于所有测试环境的人工智能信息交换与服务)与ATML(自动测试标注语言)

AI-ESTATE标准(适用于所有测试环境的人工智能信息交换与服务)与ATML(自动测试标注语言)随着被测对象的日益复杂,以数据处理为基础的传统测试诊断制方法已经无法适应复杂设备的维护需要,应用以

2016-04-16 14:51:52

AI开发者福音!阿里云推出国内首个基于英伟达NGC的GPU优化容器

云计算服务异构加速平台,为人工智能产业提供多场景化的全球加速能力。2017年11月,阿里云发布了国内首个支持 NVIDIA ®Tesla ®V100 GPU 的实例GN6,可带来数倍的深度学习性能提升

2018-04-04 14:39:24

AI是什么呢?AI应用又会给人们带来哪些改变

Intelligence的缩写,即人工智能。它是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。AI的研究工作已取得惊人进展,经过学习后,机器在操作某些环节时比人类更快、更精

2021-12-20 06:42:13

AI芯片界的领头羊进军机器人行业

战略合作,共同设计开发新型超级计算机系统和服务器。英伟达开发的图形处理单元芯片(GPU),很好适用于浮点计算,表现胜于英特尔的传统CPU Xeon和AMD的Opteron。排名第二位的“泰坦”也搭载了

2018-06-11 08:20:23

AI视觉检测在工业领域的应用

的产品图像。

2.图像处理:系统将采集到的图像数据进行预处理、过滤、降噪等操作,以便更好地提取特征信息。

3.特征提取:系统采用深度学习等技术,对图像数据进行深度学习训练,提取出产品的特征向量。

4.特征

2023-06-15 16:21:56

AI运算核心,FPGA领域前程远大

发展的芯片。云端运算已在深度学习训练的效能表现相当显著,然而若要运用到终端产品上,除了功耗与芯片体积的限制,加上云端运算有数据存取、实时性与安全性的考虑,预期将会催生AI芯片向终端的「 边缘运算」迈进

2017-12-05 08:09:38

NVIDIA Jetson的相关资料分享

。Jetson是以机器学习应用为目的而设计的,具有GPU的并行处理用的嵌入式计算板,用于高速执行图像识别、机器学习和自动驾驶等。爆炸式增长的AI模型的复杂性近年来,由于传感器技术的革新,IoT设备比以往发挥

2021-11-09 08:26:45

NVIDIA 在首个AI推理基准测试中大放异彩

分为四个场景:与数据中心应用关联性最高的服务器和离线场景,以及用于满足边缘设备地芯片系统需求的单流和多流场景。 NVIDIA在两个数据中心场景(离线和服务器)的全部五项基准测试中均排在第一位

2019-11-08 19:44:51

深度学习推理和计算-通用AI核心

商业发行之前就已经过时了。算法明天需要对架构、内存/数据进行彻底改革资源和能力。推理的梦幻建筑重新定义重写在计算和交付突破性的人工智能加速和灵活的计算能力超越了服务器级CPU和比GPU/ASIC通用

2020-11-01 09:28:57

Arm Neoverse NVIDIA Grace CPU 超级芯片:为人工智能的未来设定步伐

和数据吞吐量进行优化的服务器和数据中心人工智能和机器学习 (ML) 的需求。否则,人工智能所需的成本、电力和碳将开始超过收益。NVIDIA 率先使用 GPU 来提高数据中心中 HPC 和 AI 的性能

2022-03-29 14:40:21

EdgeBoard FZ5 边缘AI计算盒及计算卡

,实现模型的训练、部署、推理等一站式服务,降低AI开发门槛。5 卓越品质与可靠性设计,直面工业场景高效开发宽温设计,适应-40度到+70度环境温度;整体式无风扇被动散热,适应工业场景的恶劣环境;此外

2020-08-31 14:12:48

FPGA在深度学习应用中或将取代GPU

、笔记本电脑或机架式服务器上训练神经网络时,这不是什么大问题。但是,许多部署深度学习模型的环境对 GPU 并不友好,比如自动驾驶汽车、工厂、机器人和许多智慧城市环境,在这些环境中硬件必须忍受热、灰尘、湿度

2024-03-21 15:19:45

ST MCU边缘AI开发者云 - STM32Cube.AI

STM32微控制器生成优化的C代码,无需事先安装软件。数据科学家和开发人员受益于STM32Cube.AI久经考验的神经网络优化性能,以开发边缘AI项目。• 访问STM32模型库,这是一个可训练的深度学习

2023-02-02 09:52:43

STM32Cube.AI工具包使用初探

STM32近日推出了Cube.AI人工智能神经网络开发工具包,目标是将AI引入微控制器供电的智能设备,位于节点边缘,以及物联网,智能建筑,工业和医疗应用中的深度嵌入式设备。 简而言之,以后就可以在

2022-02-22 06:50:34

TB-96AI是什么?TB-96AI核心板有哪些核心功能

LPDDR3+16GB eMMC(可选6GB LPDDR3+16GB eMMC或8GB LPDDR3+16GB eMMC),内置千兆以太网PHY芯片。TB-96AI设计为通过4个100Pin的松下高速板对板连接器

2022-06-20 16:28:28

Xeon处理器和FPGA卡窥见其AI策略

学习中的推理任务,而英特尔的目标则是利用结合Altera Arria FPGA的新型PCIe卡;Facebook利用Nvidia的芯片设计了自己的GPU服务器,以支持训练神经网络的运算密集任务。 至于

2016-12-23 16:50:37

[转]AI芯片已然存在,与既往的嵌入式处理器不可混淆!

使用最多的是GPU,因为它适用于单指令、多数据处理,可用于深度学习的训练和推理。英伟达AI技术中心亚太首席技术官Simon See接受第一财经采访时表示,英伟达要做通用性的芯片,“通用是我们的优势

2018-06-14 11:44:13

【CC3200AI实验教程11】疯壳·AI语音人脸识别-AI语音系统架构

传送到CC3200,CC3200通过wifi把采集到的语音信号发送给服务器,服务器再使用百度AI语音识别的API把语音信号传送到百度AI的服务器上;当语音识别成功后,百度AI返回识别后的字符串给到服务器

2022-08-30 14:54:38

【CC3200AI实验教程14】疯壳·AI语音人脸识别-AI人脸系统架构

CC3200AI实验教程——疯壳·开发板系列AI人脸系统架构AI人脸识别系统由7大块组成,分别是摄像头、CC3200、串口调试助手、路由器、公网、服务器、数据库以及百度AI组成。AI人脸识别系统

2022-08-31 16:35:59

【产品活动】阿里云GPU云服务器年付5折!阿里云异构计算助推行业发展!

用于搭建深度学习训练加速平台的云端利器。GN5采用了NVIDIA Pascal架构P100 GPU,可在云端按需构建敏捷弹性、高性能和高性价比的深度学习平台,让用户以最简便地方式享用阿里云遍布全球的高效

2017-12-26 11:22:09

【免费直播】AI芯片专家陈小柏博士,带你解析AI算法及其芯片操作系统。

仿真的优势?3、国产AI芯片如何突围,和传统SOC设计上设计差别?4、为什么选择ZYNQ做AI 深度学习?目录(主要大纲):1、AI应用场景介绍(人脸识别,物体识别/分类)2、AI算法设计、训练

2019-11-07 14:03:20

【免费直播】让AI芯片拥有最强大脑—AI芯片的操作系统设计介绍.

、深度学习推断处理器(DPU)运行时设计介绍3、如何加速优化,提高系统并行执行效率1、AI芯片中的操作系统管理原则2、操作系统运行时设计准则3、多核多线程加速计算效率方法主讲老师:陈小柏,男,中山大学

2019-11-07 14:18:45

【米尔FZ3深度学习计算卡试用体验】搭建Vitis Ai系统平台并测试

1 Vitis AiVitis™ AI 开发环境是 Xilinx 的开发平台,适用于在 Xilinx 硬件平台(包括边缘器件和 Alveo 卡)上进行人工智能推断。它由优化的 IP、工具、库、模型

2020-12-03 19:22:13

人工智能AI-卷积神经网络LabVIEW之Yolov3+tensorflow深度学习有用吗?

python编程语言的前提下,使用labview训练和部署深度学习模型,并配备相关案例视频以及源码。适用人群:1、适用于工业自动化行业从业者利用labview或者C#进行深度学习应用;2、适用于plc

2020-11-27 11:19:37

利用设计网关的 IP 内核在 Xilinx VCK190 评估套件上加速人工智能应用

XCVC1902 量产芯片AI 和 DSP 引擎的计算性能比当今的服务器级 CPU 高 100 倍用于快速原型设计的预构建合作伙伴参考设计用于前沿应用开发的最新连接技术内置 PCIe 第 4 代硬 IP,用于高性能

2022-11-25 16:29:20

可以在同一台服务器上混合使用不同的NVIDIA GPU

拥有相同的(Dell R740xd)服务器是否可能(或甚至有意义):1. P40- 用于VMWare Horizon VDI图形2. V100- 用于深度学习/ HPC开发或者是否需要/建议在

2018-10-10 16:11:04

在X-CUBE-AI.7.1.0中导入由在线AI平台生成的.h5模型报错怎么解决?

你好, 我试图在 X-CUBE-AI.7.1.0 中导入由在线 AI 平台生成的 .h5 模型,收到错误:E010(InvalidModelError): Model saved with Keras 2.7.0 but

2022-12-27 06:10:35

基于Python的GUI界面设计的AI学习

Python之GUI:基于Python的GUI界面设计的一套AI课程学习(机器学习、深度学习、大数据、云计算等)推荐系统(包括语音生成、识别等前沿黑科技)

2018-12-28 10:08:31

如何加速电信领域AI开发?

在即将开展的“中国移动全球合作伙伴大会”上,华为将发布一款面向运营商电信领域的一站式AI开发平台——SoftCOM AI平台,帮助电信领域开发者解决AI开发在数据准备、模型训练、模型发布以及部署验证

2021-02-25 06:53:41

嵌入式AI的相关资料下载

,小网络是一个学生让小网络逐渐学习到大网络的能力三、边缘侧的训练方法传统的机器学习训练方法是把数据在服务器上训练好,然后使用联邦学习是用户不把数据上传,而是把模型下发到对应的用户那里用户训练以后用户会把训练好的模型上传到服务器,服务器再把训练的模型进行合成,

2021-12-14 06:57:15

嵌入式边缘AI应用开发指南

、PyTorch和MXNet框架中常用的开源深度学习模型。这些模型在公共数据集上经过预训练和优化,可以在TI适用于边缘AI的处理器上高效运行。TI会定期使用开源社区中的新模型以及TI设计的模型对Model Zoo

2022-11-03 06:53:28

当AI遇上FPGA会产生怎样的反应

、LSTM以及强化学习网络等算法在内的应用加速平台和完整的生态系统。深度学习包含两个计算环节,即线下训练和线上推理环节。GPU在深度学习算法模型训练上非常高效,但在推理时,一次性只能对于一个输入项进行

2021-09-17 17:08:32

微型微控制器与强大的人工智能(AI)世界有什么关系

嵌入式应用可能的极限,嵌入式设计已经能够提高网络攻击的实时响应能力和设备安全性。支持AI的MCU云计算推动了对具有AI功能的MCU的需求;它减少了数据传输所需的带宽,并节省了云服务器的处理能力,如下图。配备AI算法的MCU正在应用包含对象识别,启用语音服务和自然语言处理等功能的应用程序..

2021-11-01 08:55:02

新思科技发布业界首款全栈式AI驱动型EDA解决方案Synopsys.ai

技(Synopsys, Inc.,纳斯达克股票代码:SNPS)隆重推出了业界首款全栈式AI驱动型EDA解决方案Synopsys.ai,覆盖了先进数字与模拟芯片的设计、验证、测试和制造环节。基于此,开发者第一次

2023-04-03 16:03:26

智能网卡简介及其在高性能计算中的作用

最高性能。SmartNIC 通过提供高级网络功能以及专门的硬件加速,在 HPC 应用中表现出色。提高人工智能系统的效率当前的机器学习趋势涉及分布式学习,它通常采用并行数据训练,其中每个节点在不同的数据

2023-07-28 10:10:17

硬件帮助将AI移动到边缘

工厂中,机器学习技术可能适用于工业过程控制中的复杂传感器融合,或工业机器中的异常检测和预测性维护方案。AspenCore Media深入研究了人工智能在边缘的应用,超越了收集大部分媒体的语音和视觉系统

2019-05-29 10:38:09

请问FP_AI_VISION1工程是否可以适用于stm32f746 discovery开发板?

FP_AI_VISION1工程是否可以适用于stm32f746discovery开发板?使用STM32CUBEIDE打开FP_AI_VISION1工程为什么没有stm32可运行文件,不能编译?

2023-08-07 08:37:02

通用型AI语音识别芯片音旋风611如何?

近日,国产原生芯片品牌探境科技宣布全球首款通用型AI语音识别芯片——音旋风611(英文名称:Voitist611)目前正式进入批量供货量产并已获得大量客户的认可和采用。这款芯片将适用于各种需要语音

2019-09-11 11:52:12

闲谈客服中心AI应用及挑战

的新鲜事物。上个世纪90年代出现的洗衣机模糊逻辑控制系统其实就是某种形式的AI。语音识别和语义识别本身也是AI的一部分。在数据分析与挖掘领域,我们利用很多传统的机器学习算法,比如决策树、逻辑引擎等,进行预测

2018-04-10 10:48:40

阿里云CPFS在人工智能/深度学习领域的实践

众多的计算核心可以大量并行的运行更多的AI训练/推理线程,使得AI训练/推理在更短的时间内完成更多的计算任务。简单的说,GPU让AI更快,更准。这种变化使得服务器的形态发生了很大的变化,用于AI/DL

2018-08-23 17:39:35

英伟达 GPU 算力 服务器 电信运营商 数据中心 云服务 显卡 IDC NVIDIA NVLINK

;VFG-SYS-821GE-TNHR 1 Base Configuration 8UX13HGX H100 8GPU(Rear I/O),X13DEG-OAD*12 CPU P4X-S

2024-01-02 09:35:32

英伟达HGX-2 GPU加速平台构建更强大的AI服务

百度、腾讯借助 HGX-2 构建更强大的AI服务;浪潮、联想、华为和曙光推出基于全新 HGX-2 的服务器。

2018-11-23 09:23:24 3411

3411

3411

3411NVIDIA发布了首款基于NVIDIA Ampere架构的GPU ——NVIDIA A100 GPU

了全球超强大的AI和HPC服务器平台HGX A100,最大可组成AI算力达10 PFLOPS的超大型服务器。

2020-06-02 17:11:45 3709

3709

3709

3709NVIDIA GPU加速AI推理洞察,推动跨行业创新

这些AI模型被运行在装载了V100Tensor Core GPU的NVIDIADGX系统上的数据中心服务器上,以及装载了JetsonAGX Xavier模块的边缘计算网络中。该硬件运行NVIDIA

2020-07-02 15:00:54 1819

1819

1819

1819NVIDIA公布通过NVIDIA认证系统测试的全球首批加速服务器 企业 AI 使用量倍增

芯东西1月27日报道,刚刚,NVIDIA公布通过NVIDIA认证系统测试的全球首批加速服务器,它们是目前业内唯一通过现代工作负载测试的服务器,可用于机器学习和分析。 通过NVIDIA认证系统的产品

2021-01-27 16:25:59 1716

1716

1716

1716VIDIA宣布在AI超级计算平台中加入融合了AI与高性能计算的新技术

NVIDIA A100 80G PCIe、NVIDIA NDR 400G InfiniBand和NVIDIA Magnum IO三箭齐发!超强HGX助力广大HPC系统和云服务 NVIDIA宣布

2021-06-29 09:50:06 2027

2027

2027

2027NVIDIA为需要加速计算的企业客户运行测试服务器

借助 NVIDIA AI,戴尔、浪潮、Microsoft Azure 和 Supermicro 在今天发布的新 MLPerf 基准测试中创下快速训练 AI 模型的记录

2021-12-15 15:35:44 1269

1269

1269

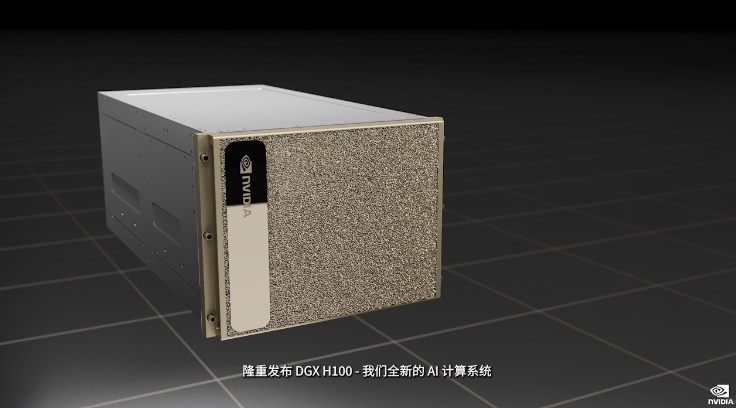

1269GTC2022大会亮点:NVIDIA发布全新AI计算系统—DGX H100

GTC2022大会亮点:NVIDIA发布全新AI计算系统—DGX H100,借助NVLink连接,DGX使八块H100成为了一个巨型GPU。

2022-03-24 15:06:31 1574

1574

1574

1574

NVIDIA发布DGX H100系统 罗德与施瓦茨提供O-RAN无线电单元方案

NVIDIA 近日宣布推出第四代 NVIDIA® DGX™ 系统,这是世界上第一个使用全新NVIDIA H100 Tensor Core GPU 构建的 AI 平台。

2022-03-25 11:44:23 4525

4525

4525

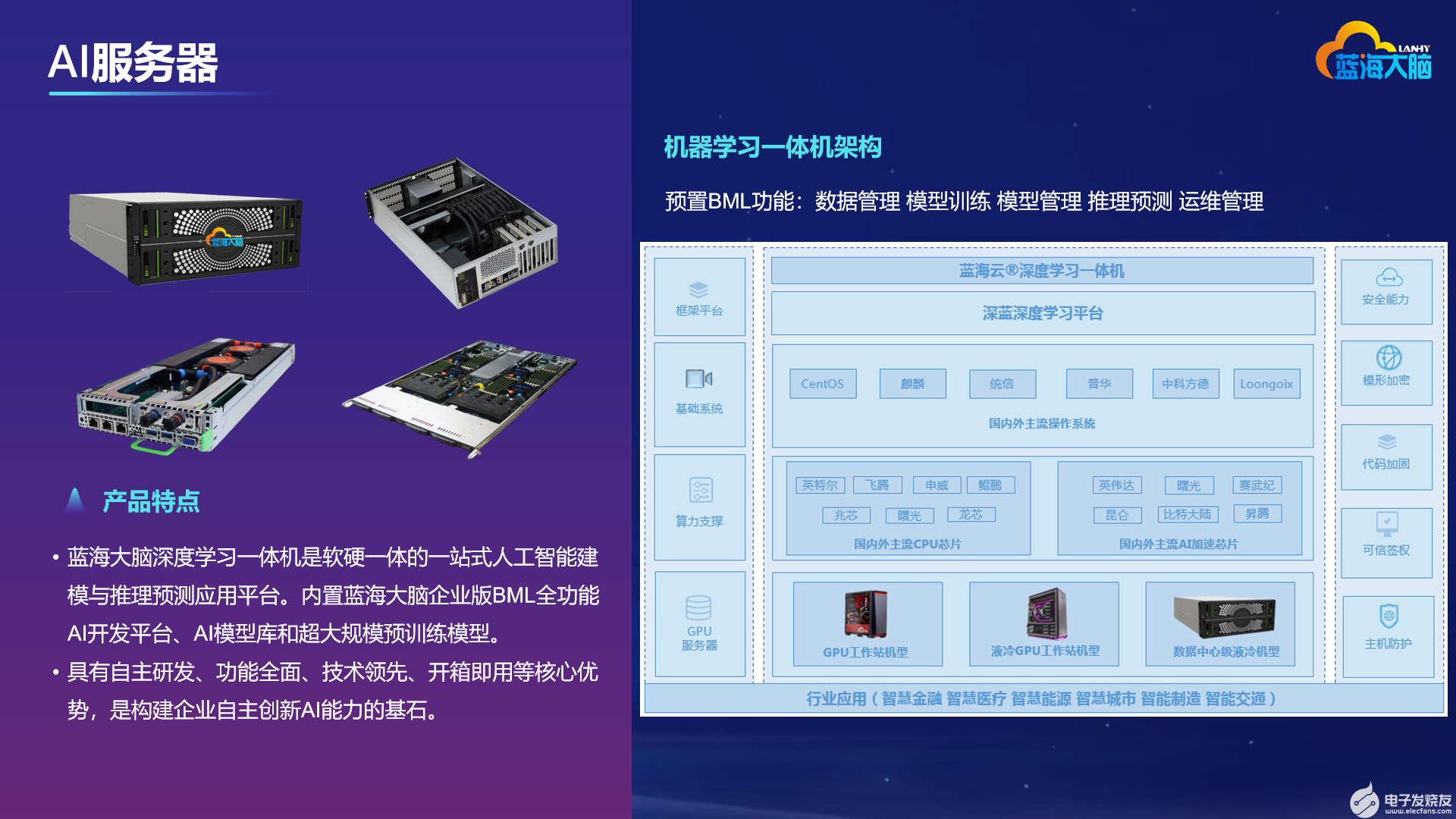

4525蓝海大脑服务器全力支持NVIDIA H100 GPU

蓝海大脑宣布服务器产品线全力支持最新的 NVIDIA H100 GPU。蓝海大脑服务器产品在单机上最多可支持4、8甚至9个H100 GPU,可为多种人工智能场景提供超强算力、灵活的资源调度和成熟的生态支持。

2022-03-31 11:47:09 1067

1067

1067

1067基于Arm服务器系统架构的NVIDIA HPC SDK v21.7软件开发工具包

英伟达 ARM HPC 开发工具包是第一个步骤,使 AR-HPC 生态系统 GPU 加速。 NVIDIA 致力于全面支持 Arm 的 HPC 和 AI 应用。

2022-04-14 14:51:08 1268

1268

1268

1268利用NVIDIA HGX H100加速计算数据中心平台应用

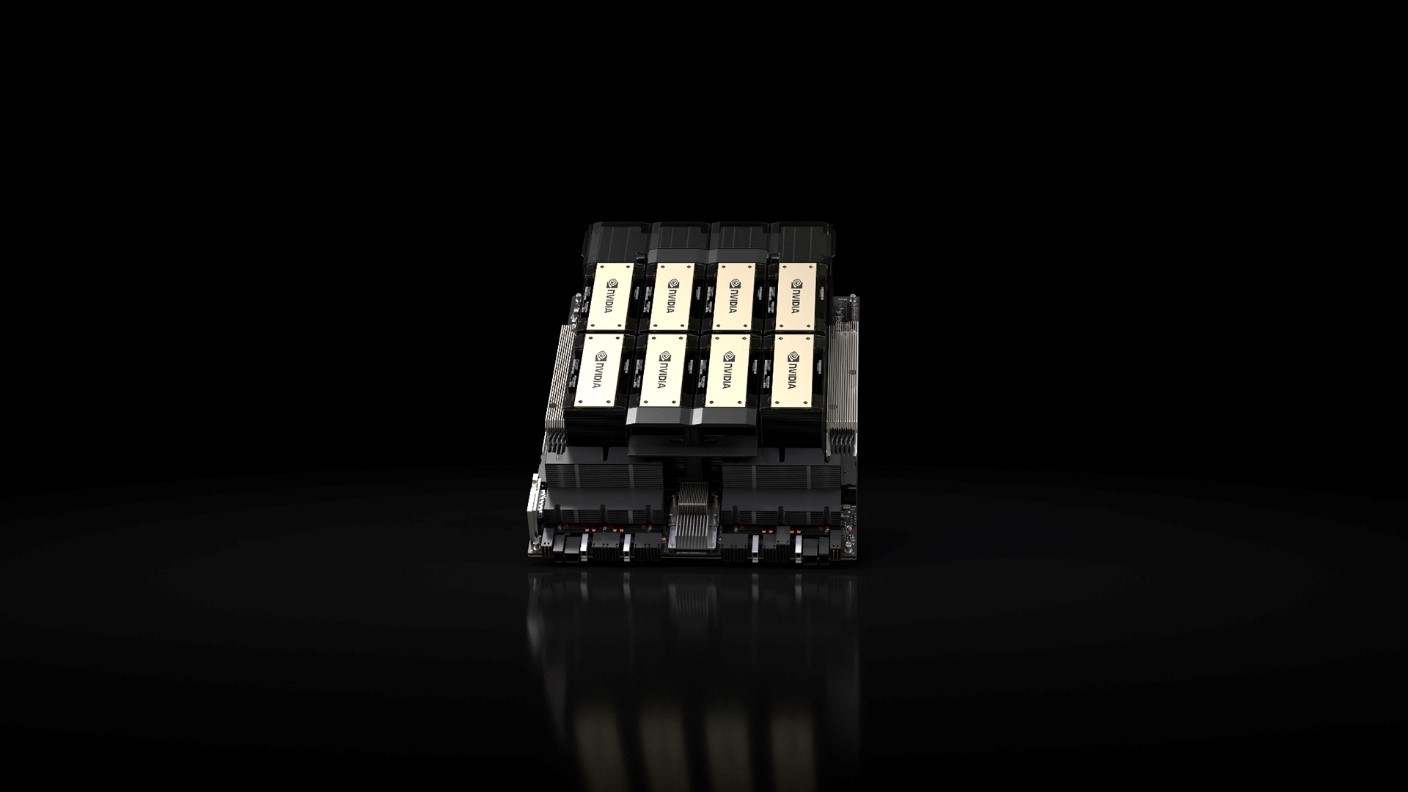

HGX H100 8- GPU 是新一代 Hopper GPU 服务器的关键组成部分。它拥有八个 H100 张量核 GPU 和四个第三代 NV 交换机。每个 H100 GPU 都有多个第四代

2022-04-20 10:54:19 2109

2109

2109

2109

NVIDIA Riva可快速开发出GPU加速对话式AI应用

为了加快生产级、高精度 AI 模型的开发,NVIDIA 提供多种工具用于生成训练数据、训练和优化模型以及快速创建可立即部署的 AI 模型。

2022-04-29 14:33:04 1537

1537

1537

1537NVIDIA GPU加速潞晨科技Colossal-AI大模型开发进程

通过 NVIDIA GPU 加速平台,Colossal-AI 实现了通过高效多维并行、异构内存管理、大规模优化库、自适应任务调度等方式,更高效快速部署 AI 大模型训练与推理。

2022-10-19 09:39:39 1149

1149

1149

1149AI服务器的应用场景有哪些?

关键词:人工智能、高性能计算、HPC、GPU、CPU、服务器、人工智能服务器、人工智能工作站、深度学习、机器学习、液冷散热、冷板式液冷、水冷工作站、液冷服务器、AI服务器 如今,市场上有越来越多熟悉

2023-01-30 10:06:42 1625

1625

1625

1625

NVIDIA 推出用于边缘 AI、5G 和 Omniverse 数字孪生的 GPU 加速 AI-on-5G 系统

上运行 5G、AI 应用和沉浸式图形工作负载的行业标准解决方案,以用于计算机视觉和元宇宙等领域。 为了满足这一需求,NVIDIA 正在开发一款新的 AI-on-5G 解决方案, 它将 5G vRAN、边缘 AI 和数字孪生工作负载整合于同一个一体化、超融合的 GPU 加速系统上。 该系统的较低拥

2023-03-13 09:25:02 503

503

503

503NVIDIA 为全球企业带来生成式 AI 推出用于创建大型语言模型和视觉模型的云服务

为AI驱动的应用构建自定义模型 加利福尼亚州圣克拉拉 – GTC – 太平洋时间 2023年3月21日 – 为了加速企业应用生成式AI,NVIDIA今日宣布推出一套云服务,使企业能够构建、完善

2023-03-22 13:45:40 261

261

261

261

NVIDIA推出用于大型语言模型和生成式AI工作负载的推理平台

日 – NVIDIA于今日推出四款推理平台。这些平台针对各种快速兴起的生成式AI应用进行了优化,能够帮助开发人员快速构建用于提供新服务和洞察的AI驱动的专业应用。 这些平台将NVIDIA的全栈推理

2023-03-22 14:48:39 256

256

256

256

NVIDIA GTC 2023:GPU算力是AI的必需品

从OpenAI发布GPT-4,到百度发布文心一言;AI开始了爆走模式,现在我们来看看 NVIDIA GTC 2023 。 手握GPU算力的NVIDIA是AI的必需品。 图源 NVIDIA官网直播

2023-03-22 15:23:28 2900

2900

2900

2900

GTC23 | NVIDIA 推出用于大型语言模型和生成式 AI 工作负载的推理平台

日 – NVIDIA 于今日推出四款推理平台。这些平台针对各种快速兴起的生成式 AI 应用进行了优化,能够帮助开发人员快速构建用于提供新服务和洞察的 AI 驱动的专业应用。 这些平台将 NVIDIA

2023-03-23 06:55:02 654

654

654

654GTC23 | NVIDIA 携手谷歌云提供强大的全新生成式 AI 平台,基于新款 L4 GPU 和 Vertex AI 构建

NVIDIA 生成式 AI 推理平台将集成至谷歌云 Vertex AI 中;谷歌云成为首家提供 NVIDIA L4 GPU 实例的云服务商 加利福尼亚州圣克拉拉 – GTC – 太平洋时间 2023

2023-03-23 06:55:02 438

438

438

438GTC23 | NVIDIA 发布大型语言模型和生成式 AI 服务以推动生命科学研发

年 3 月 21 日 – NVIDIA 今日推出一整套用于自定义 AI 基础模型的生成式 AI 云服务。这些服务将加速新蛋白质和治疗方法的创建以及基因组学、化学、生物学和分子动力学等领域的研究。 作为

2023-03-23 06:55:03 328

328

328

328NVIDIA 与微软合作加速企业就绪的生成式 AI

年 5 月 23 日—— NVIDIA 今天宣布将 NVIDIA AI Enterprise 软件套件 集成到微软的 Azure 机器学习中,以帮助企业加速推进 AI 计划。 此次集成将创建一个安全、企业

2023-05-25 09:15:02 347

347

347

347

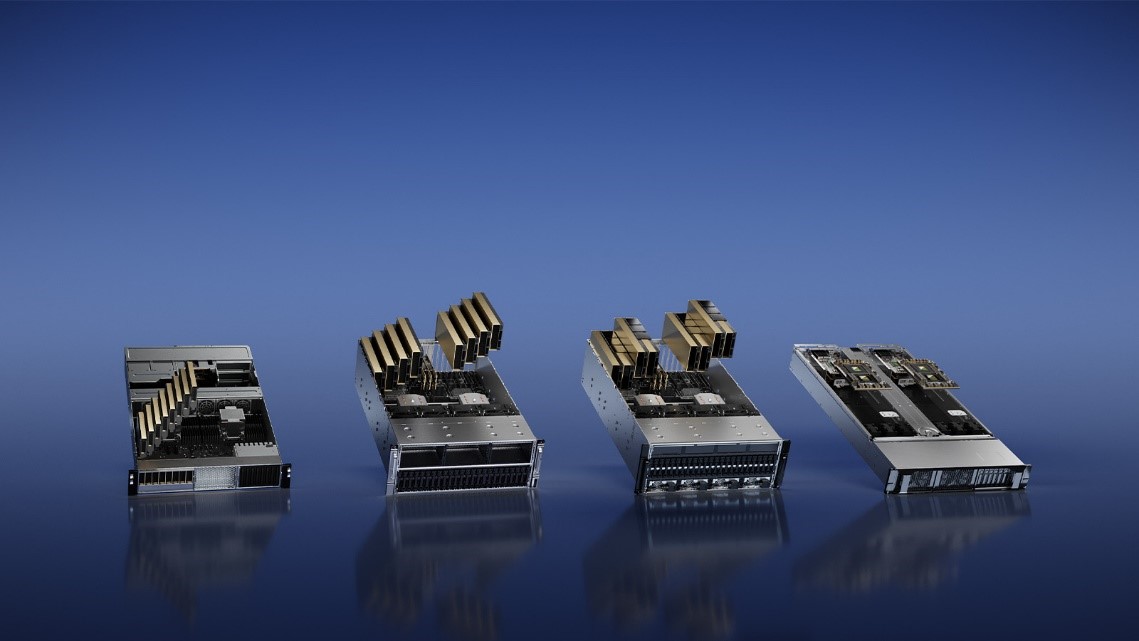

COMPUTEX2023 | NVIDIA MGX 为系统制造商提供模块化架构,以满足全球数据中心多样化加速计算需求

多样化的加速计算需求,NVIDIA 今天在 COMPUTEX 发布了 NVIDIA MGX 服务器规范 。该规范为系统制造商提供了一个模块化参考架构,以快速、经济高效地制造 100 多种服务器机型,适用于

2023-05-30 01:40:02 586

586

586

586

AI算力与能耗兼具,Supermicro梁见后畅谈服务器的绿色计算

随着生成式AI等人工智能席卷全球,服务器市场将作为产业先锋迎来巨大的发展机会。在日前举办的台北电脑展上,Supermicro总裁兼首席执行官梁见后(Charles Liang)接受电子发烧友网等媒体

2023-05-31 18:30:25 2206

2206

2206

2206

AI服务器与传统服务器的区别是什么?

AI 服务器确实是整个服务器市场的一部分,但它们是专门为基于云的 AI 模型训练或推理而设计的。在规格方面,广义的AI服务器是指搭载AI芯片(如前面提到的GPU、FPGA、ASIC)的服务器,而狭义的定义则包括至少搭载一块GPU的服务器。

2023-06-21 12:40:02 1208

1208

1208

1208大模型算力新选择——宝德AI服务器采用8颗英特尔Gaudi®2加速器

近日,英特尔专门针对中国市场推出深度学习加速器Habana® Gaudi®2.以领先的性价比优势,加速AI训练及推理,提高深度学习性能和效率,从而成为大规模部署AI的更优解。作为英特尔在中国最重

2023-07-19 14:43:32 468

468

468

468SIGGRAPH 2023 | NVIDIA 与全球数据中心系统制造商大力推动 AI 与工业数字化的发展

OVX 服务器采用全新 NVIDIA GPU 以加速训练和推理以及图形密集型工作负载,将通过戴尔科技、慧与、联想、超微等公司提供。 洛杉矶 — SIGGRAPH — 太平洋时间 2023

2023-08-09 19:10:06 264

264

264

264AI服务器架构的五大硬件拆解

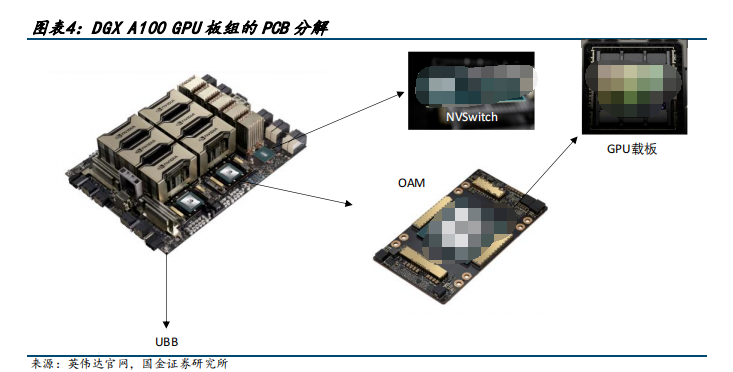

AI 服务器我们瞄准英伟达 DGX A100 和 DGX H100 两款具有标杆性产品力的产品进行分析,鉴于 H100 发布时间较短、资料详尽度不够,我们首先从 DGX A100 出发来观测具有产品力的 AI 服务器的基本架构。

2023-08-11 09:24:59 3121

3121

3121

3121

《开放加速规范AI服务器设计指南》发布,应对生成式AI算力挑战

》面向生成式AI应用场景,进一步发展和完善了开放加速规范AI服务器的设计理论和设计方法,将助力社区成员高效开发符合开放加速规范的AI加速卡,并大幅缩短与AI服务器的适配周期,为用户提供最佳匹配应用场景的AI算力产品方案,把握生成式AI爆发带来的算力产业巨大机遇。 当前,生成式A

2023-08-14 09:49:31 471

471

471

471AI新品 | 兆瀚RA5900-B AI训练服务器

END 原文标题:AI新品 | 兆瀚RA5900-B AI训练服务器 文章出处:【微信公众号:拓维信息】欢迎添加关注!文章转载请注明出处。

2023-08-14 17:25:02 567

567

567

567全球领先系统制造商推出 NVIDIA AI 就绪型服务器,为企业大幅提升生成式 AI 性能

戴尔科技、慧与和联想即将推出采用 NVIDIA L40S GPU 和 NVIDIA BlueField 的服务器,以支持 VMware Private AI Foundation

2023-08-23 19:10:09 350

350

350

350AI芯片CoWoS封装产能受限,中介层不足成关键

大语言模型训练和推理生成式AI(Generative AI)应用,带动高端AI服务器和高性能计算(HPC)数据中心市场,内置集成高带宽内存(HBM)的通用绘图处理器(GPGPU)供不应求,主要大厂英伟达(Nvidia)A100和H100绘图芯片更是严重缺货。

2023-08-30 17:09:49 600

600

600

600Apple 预定 3 纳米芯片,谷歌云 A3 虚拟机将改变 AI 训练

GPU 的 A3 GPU 虚拟机,加速 AI 模型训练速度 谷歌云近日宣布,他们将在下个月正式推出搭载 Nvidia H100 GPU 的 A3 GPU 虚拟机。这款 A3 虚拟机结合

2023-08-31 13:00:07 377

377

377

377

Oracle 云基础设施提供新的 NVIDIA GPU 加速计算实例

也即将在 OCI Compute 上推出。 OCI 上的 NVIDIA H100 Tensor Core GPU 实例 OCI Co mpute 裸机实例配备了具有 NVIDIA Hopper 架构 的 NVIDIA H

2023-09-25 20:40:02 269

269

269

269

传英伟达新AI芯片H20综合算力比H100降80%

但据悉,三种新型AI芯片不是“改良型”,而是“缩小型”。用于ai模型教育的hgx h20的带宽和计算速度是有限的。整体计算能力理论上比nvidia的h100 gpu芯片低80%左右。h20是h100的20%的综合计算性能。

2023-11-13 09:41:58 747

747

747

747英伟达确认为中国推三款改良AI芯片 性能暴降80%

据报道,nvidia的3种ai芯片不是“改良版”,而是“缩水版”,分别是hgx h20、l20 pcle和l2 pcle。用于ai模型训练的hgx h20虽然带宽和计算速度有限,但整体计算能力理论上比英伟达h100 gpu芯片低80%左右。

2023-11-13 10:46:07 410

410

410

410NVIDIA 为全球领先的 AI 计算平台 Hopper 再添新动力

世界顶级服务器制造商和云服务提供商即将推出 HGX H200 系统与云实例 丹佛 - SC23 - 太平洋 时间 2023 年 11 月 13 日 - NVIDIA 于今日宣布推出

2023-11-14 14:30:01 85

85

85

85

SC23 | NVIDIA 为全球领先的 AI 计算平台 Hopper 再添新动力

世界顶级服务器制造商和云服务提供商即将推出 HGX H200 系统与云实例。 11月13日,NVIDIA 宣布推出 NVIDIA HGX H200 ,为 Hopper 这一全球领先的 AI 计算平台

2023-11-14 20:05:01 269

269

269

269

NVIDIA 在 Microsoft Azure 上推出面向全球企业和初创公司的 生成式 AI Foundry 服务

AI Enterprise 软件进行部署 Microsoft Ignite — 2023 年 11 月 15 日 — NVIDIA 于今日推出一项 AI foundry 服务,助力企业

2023-11-16 14:13:08 116

116

116

116

NVIDIA 在 Microsoft Azure 上推出面向全球企业和初创公司的生成式 AI Foundry 服务

AI Enterprise 软件进行部署 NVIDIA 于今日推出一项 AI foundry 服务,助力企业和初创公司在 Microsoft Azure 上开发、调优和部署其自定义生成式 AI

2023-11-16 21:15:02 270

270

270

270AI服务器的内存接口芯片技术

DXG 服务器配备 8 块 H100 GPU,6400亿个晶体管,在全新的 FP8 精度下 AI 性能比上一代高 6 倍,可提供 900GB/s 的带宽。

2023-12-13 09:23:54 335

335

335

335

Supermicro推出适用于AI存储的机柜级全方位解决方案 加速高性能AI训练和推理的数据存取

【2024年2月1日,美国圣何塞讯】Supermicro, Inc.(纳斯达克股票代码:SMCI)作为AI、云端、存储和5G/边缘领域的全方位IT解决方案制造商,推出适用于人工智能(AI)和机器学习

2024-02-01 17:56:09 271

271

271

271Supermicro推新AI存储方案,助力AI和ML应用加速

Supermicro首席执行官梁见后先生高瞻远瞩地指出:针对AI和ML应用的加速处理,我们推荐配置以每机柜20 PB高速闪存为主,配备四个NVIDIA HGX H100系列优化版8-GPU气冷服务器或者八个同款液冷服务器。

2024-02-03 14:46:40 337

337

337

337使用NVIDIA Triton推理服务器来加速AI预测

这家云计算巨头的计算机视觉和数据科学服务使用 NVIDIA Triton 推理服务器来加速 AI 预测。

2024-02-29 14:04:40 162

162

162

162NVIDIA 推出 Blackwell 架构 DGX SuperPOD,适用于万亿参数级的生成式 AI 超级计算

块 Blackwell GPU 连成一个整体,由NVIDIA 系统专家加速即时 AI 基础设施的部署 美国加利福尼亚州圣何塞 —— GTC —— 太平洋时间 2024 年 3 月 18

2024-03-19 10:56:35 57

57

57

57

英伟达发布超强AI加速卡,性能大幅提升,可支持1.8万亿参数模的训练

得益于NVIDIA每两年进行一次GPU架构升级以提高性能的策略,全新的基于Blackwell的加速卡比之前的H100更为强大,尤其适用于AI相关任务。

2024-03-19 12:04:04 72

72

72

72 电子发烧友App

电子发烧友App

评论