的AI应用需要经历训练和推理两个过程。所谓训练,就是我们要将大量的数据代入到神经网络模型中运算并反复迭代,教会算法模型如何正确的工作,训练出一个DL模型。而接下来,我们就可以利用训练出来的模型来在线响应用户的需求,根据

2020-09-29 10:43:32 4435

4435 本月,高通推出其首款基于云端的 AI 加速器:Qualcomm Cloud AI 100,正式宣布进军云计算领域。根据高通的说法,Qualcomm Cloud AI 100 是一款用于数据中心的 AI 推理处理器。

2019-04-29 17:46:59 5450

5450 Flex Logix推出的InferX X1边缘推理加速器芯片采用了独步业界的开创性架构,具有可重构的张量处理器阵列。

2021-02-03 10:57:05 1714

1714 了在恩智浦,我们构建了一些世界上最先进的安全设备。我们在其中创建对策,以保护它们免受各种逻辑和物理攻击,例如侧通道或模板攻击。黑客依赖AI从安全系统中提取秘密和关键信息只是时间问题,因为它只会增强他们

2019-05-29 10:47:34

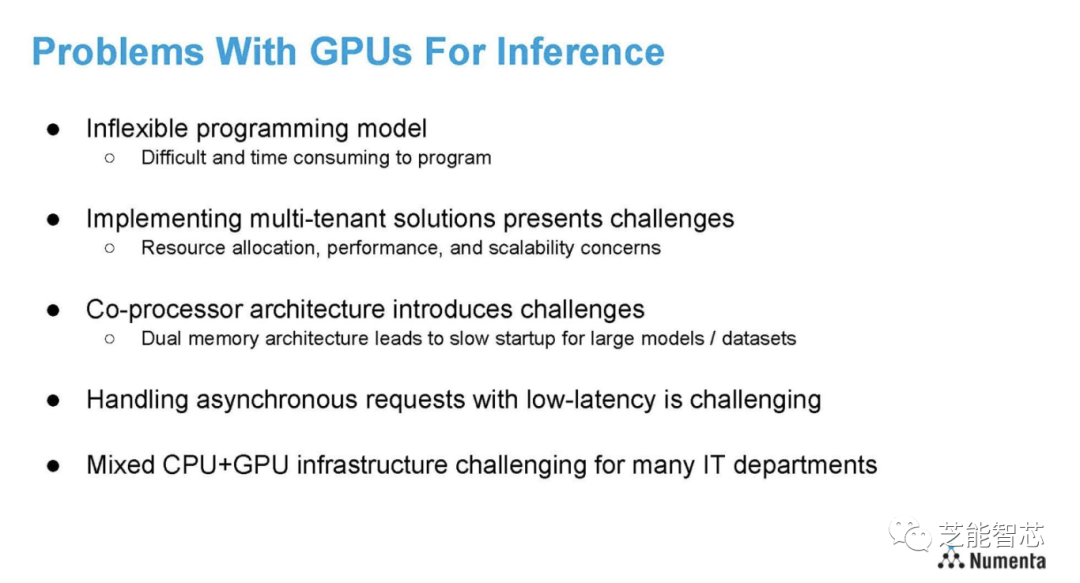

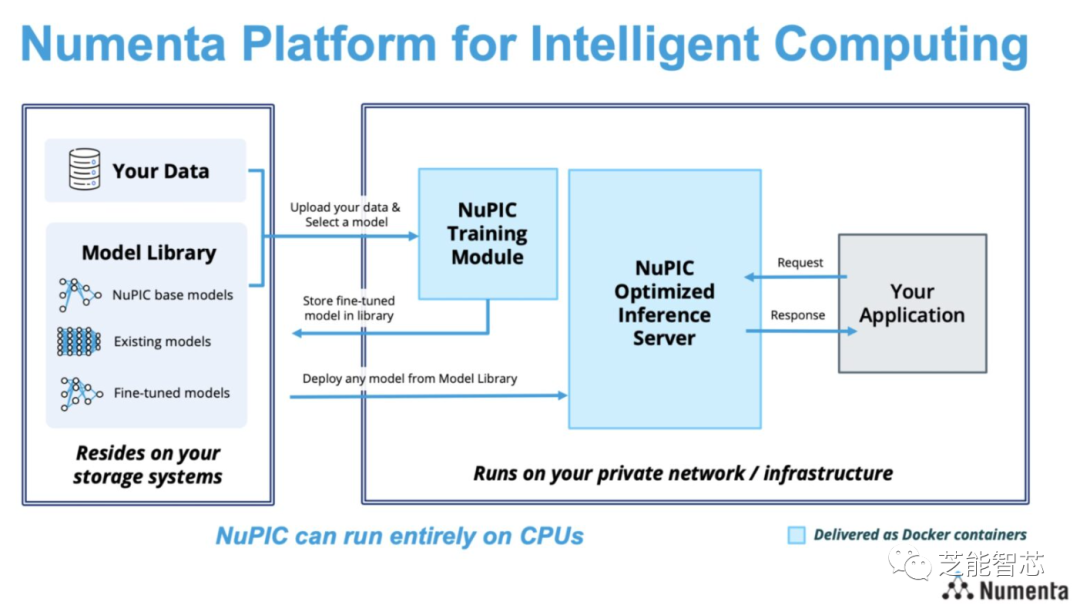

虽然GPU解决方案对训练,AI部署需要更多。

预计到2020年代中期,人工智能行业将增长到200亿美元,其中大部分增长是人工智能推理。英特尔Xeon可扩展处理器约占运行AI推理的处理器单元的70

2023-08-04 07:25:00

ai加速芯片,申耀的科技观察读懂科技,赢取未来!毫无疑问,以大数据分析、云计算、人工智能等新技术所推动的数字化转型正迅速的改变着我们所处的时代,其巨大的影响力已经从量变上升为质变,可以说数字化转型已成...

2021-07-28 07:53:56

DLLite-Micro 是一个轻量级的 AI 推理框架,可以为 OpenHarmony OS 的轻量设备和小型设备提供深度模型的推理能力DLLite-Micro 向开发者提供清晰、易上手的北向接口

2021-08-05 11:40:11

场景介绍

Neural Network Runtime 作为 AI 推理引擎和加速芯片的桥梁,为 AI 推理引擎提供精简的 Native 接口,满足推理引擎通过加速芯片执行端到端推理的需求。

本文以

2023-12-19 10:09:16

场景介绍

MindSpore Lite 是一款 AI 引擎,它提供了面向不同硬件设备 AI 模型推理的功能,目前已经在图像分类、目标识别、人脸识别、文字识别等应用中广泛使用。

本文介绍

2023-12-14 11:41:13

。可以轻松实现终端设备和边缘段设备的AI赋能方案。MLU220-M.2加速卡用于离线模型的部署,离线模型在MLU220上运行, 不依赖AI框架,只需要利用CNRT库,即可实现高效的AI推理运算。如果需要

2022-08-08 17:37:55

首个独立AI推理基准测试 ——MLPerf Inference 0.5中取得第一名。由于推理一直是AI市场中最大、同时也是最具竞争力的领域,业内此前一直希望能够有一套客观的推理性能测试指标。在参与

2019-11-08 19:44:51

STM32L1 和 STM32L0 可以用于 AI 开发(运行神经网络推理)吗?我希望将这些芯片与 X-CUBE-AI 一起使用。然而,当我阅读用户手册时,这些芯片被排除在微控制器列表之外。为什么会这样?

2022-12-28 08:21:26

YOLOv5s算法在RK3399ProD上的部署推理流程是怎样的?基于RK33RK3399Pro怎样使用NPU进行加速推理呢?

2022-02-11 08:15:55

首先感谢电子发烧友论坛提供的书籍和阅读评测的机会。

拿到书,先看一下封面介绍。这本书的中文名是《AI加速器架构设计与实现》,英文名是Accelerator Based on CNN Design

2023-09-17 16:39:45

,以及模擬人類感官識別和動作行為等。 • 然而,目前的AI(人工智慧)大多屬於「特定領域」的智慧,例如下棋、開車、監考等,而還無法達到像人類一樣的整體智慧,諸如心靈意識及假設性推理等層面。

2020-12-03 16:48:08

项目名称:AI图像开发试用计划:申请理由本人在AI图像识别中已有一年的开发经验,目前正采用瑞芯微的rk1808芯片进行模型的落地部署,但是该芯片没有任何的摄像头方案,需要自己选取。目前选取的摄像头在

2020-09-25 10:11:50

会对关键源码进行解析。

一、Vitis AI Library简介

上一篇帖子中,我们了解了Vitis统一软件平台和Vitis AI,并体验了Vitis AI Runtime的Resnet50图像分类示例

2023-10-06 23:32:47

后2个星期内提交不少于一篇试读报告要求300字以上图文并茂。4、试读报告发表在电子发烧友论坛>> 社区活动专版标题名称必须包含《 AI加速器架构设计与实现》+自拟标题

注1

2023-07-28 10:50:51

`直播内容:人工智能是新一轮科技革命和产业转型的核心驱动力,在海量数据、深度学习和超强算力的支持下,人工智能迎来了前所未有的发展机遇,正与人类社会诸多领域深度融合,重塑人类生产生活方式,加速人类社会

2019-11-07 14:03:20

`直播内容:人工智能是新一轮科技革命和产业转型的核心驱动力,在海量数据、深度学习和超强算力的支持下,人工智能迎来了前所未有的发展机遇,正与人类社会诸多领域深度融合,重塑人类生产生活方式,加速人类社会

2019-11-07 14:18:45

OMAP-L138(定点/浮点DSP C674x+ARM9)+ FPGA处理器的开发板。

编写一个用于AI加速的FPGA程序是一个相当复杂的过程,涉及硬件描述语言(如VHDL或Verilog)以及针对特定

2024-02-12 16:18:43

,机器的学习成效都远远超越人类了。机器所具有的AI智能是它自己学习来的,又能迅速精通。 然而从另一方面来看,机器的逻辑能力却一直无法超越人类。回顾一下AI的发展历史,自从1950年代,许多专家们就是希望将

2021-01-04 10:16:36

光耦PC817中文解析

2012-08-20 14:32:28

统一软件平台, Vitis™ AI, 用于 AI 推理应用开发的 AI 引擎工具利用赛灵思 Versal AI 内核系列器件实现 AI 接口加速图 2:赛灵思 Versal AI 内核 VC1902

2022-11-25 16:29:20

你好我使用 STM32CUBE-AI v5.1.2 ApplicationTemplate 将简单的 CNN 导入到 STM32L462RCT我发现压缩模型对推理时间没有影响。aiRun 程序在 8

2023-01-29 06:24:08

。K510是嘉楠公司推出的第二代AI加速芯片,它采用双核RISC-V CPU@800Mhz,内置DSP协处理器和强大的AI运算单元KPU,支持 BF16浮点数据格式,可在边缘端进行高精度推理,是国内少有

2022-11-22 15:52:15

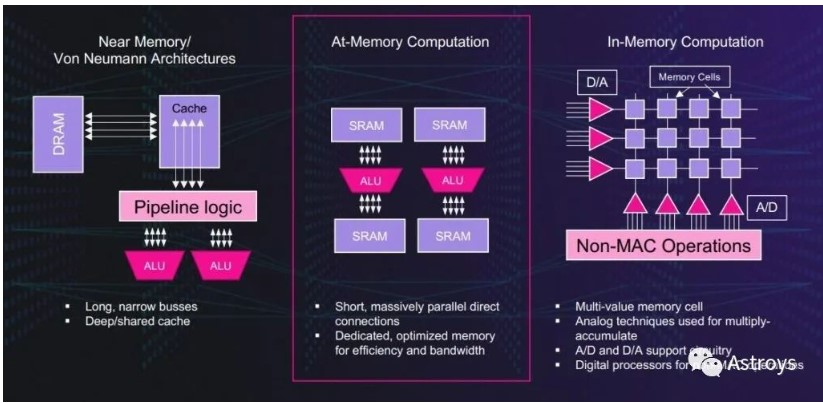

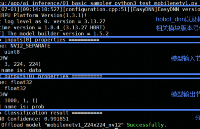

基于SRAM的方法可加速AI推理

2020-12-30 07:28:28

推理能力引入自己的嵌入式 AI 设备。”机器学习的开发主要分两个阶段完成。第一步,我们需要在快速且强大的机器或设备集群上利用大量样本数据进行训练,而后将训练完成的网络部署至负责解释实际数据的应用程序当中

2019-03-05 21:20:23

在即将开展的“中国移动全球合作伙伴大会”上,华为将发布一款面向运营商电信领域的一站式AI开发平台——SoftCOM AI平台,帮助电信领域开发者解决AI开发在数据准备、模型训练、模型发布以及部署验证

2021-02-25 06:53:41

Tengine是什么?如何在RK3399这一 Arm64 平台上搭建 Tengine AI 推理框架,并运行图像识别相关应用?

2022-03-07 07:53:43

Tengine是什么呢?如何在RK3399这一 Arm64平台上搭建Tengine AI推理框架呢?

2022-03-04 12:31:35

NN推理引擎构建一个示例应用程序,将图像分类为火或非火。

本指南使用Raspberry Pi 3或4设备。树莓派设备是由Arm CPU驱动的

霓虹灯的架构。Neon是针对Arm处理器的优化架构扩展

2023-08-02 15:40:13

步保驾护航。下面让我们来了解如何不借助手动工具或手动编程来选择模型、随时随地训练模型并将其无缝部署到TI处理器上,从而实现硬件加速推理。图1: 边缘AI应用的开发流程第1步:选择模型边缘AI系统开发

2022-11-03 06:53:28

一旦被训练完成,线上推理的效率才决定用户体验。比如,有2个同样AI模型的训练,一家公司用了1天训练完成,但线上推理的效率只有每秒100个任务;另一家公司用了7天训练完成,但线上推理效率可以达到每秒

2021-09-17 17:08:32

1 简介AI任务管理与统一的推理能力提供了接口的统一标准系统上CPU提供了AI任务调度管理的能力,对AI的能力进行了开放的推理和推理,同时,提供了一个不同的生命周期框架层级的应用程序。推理接口

2022-03-25 11:15:36

商业发行之前就已经过时了。算法明天需要对架构、内存/数据进行彻底改革资源和能力。推理的梦幻建筑重新定义重写在计算和交付突破性的人工智能加速和灵活的计算能力超越了服务器级CPU和比GPU/ASIC通用

2020-11-01 09:28:57

四次,如果将它们对应放入向量寄存器中,只需要一条向量化指令,就可以同时得出四个结果,计算效率得到提升。当然这个是需要硬件支持。因为AI推理大量使用了矩阵乘法,如今也有许多硬件对矩阵运算进行了加速

2022-12-23 16:02:46

AI寻觅出来的规则,只能以成千上亿个数字表示,成为无(文)字天书。让人们对其判断理由无从理解(Incomprehensibility),且对其推理过程无法解释(Inexplainability),所以

2020-11-26 10:45:23

。然后,每当 ai_mnetwork_run() 运行时,我们都会向 GPIO 发送脉冲,这将调用网络的推理运行函数,并且我们使用此 GPIO 脉冲来了解何时测量,例如,电路板上的电流消耗以测量推理期间

2022-11-30 16:39:29

rknn多图推理参数设置然后进行推理,推理的结果会把三张图片的结果合并在一个list中,需要我们自己将其分割开:最终其结果和单张推理的结果是相同的

2022-07-22 15:38:02

产品简介AIC-200是芯研通基于华为ATLAS 200 AI加速处理模块推出的人工智能推理加速卡,内部集成2颗ATLAS 200加速模块,可提供高达44TOPS INT8算力。AIC-200采用

2022-03-29 11:30:56

堆叠构建AI计算集群。4核ARMv8 64bit CPU@2.4GHz4个基于ManyCore计算架构的异构运算加速簇, 12.8TOPS@INT818GB LPD

2022-11-17 14:03:31

尤里云科技推理运算加速卡UXC2000内置TF16110高性能异构处理器及大容量内存,兼容各类标准外扩式机架服务器,可直接提供业务层级的软件交互接口。12.8TOPS@INT818GB

2022-11-17 14:05:09

的TensorRT推理引擎及其用于深度学习的CUDA/ cuDNN加速库,以及用于Jetson模块的NVIDIAJetPack工具套件。

2020-07-02 15:00:54 1819

1819 瑞芯微Rockchip正式宣布,旗下AI芯片RK1808、RK1806适配百度飞桨(PaddlePaddle)开源深度学习平台,充分兼容飞桨轻量化推理引擎Paddle Lite。此次瑞芯微与百度合作,旨在为AI行业赋能更多应用场景,加速AI产品落地进程。

2020-07-06 16:01:29 506

506 2020年9月16日,Qualcomm宣布,高性能的AI推理加速器Qualcomm Cloud AI 100正面向全球部分客户出货。凭借先进的信号处理能力和领先的能效,Qualcomm Cloud

2020-09-17 17:04:23 2218

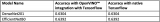

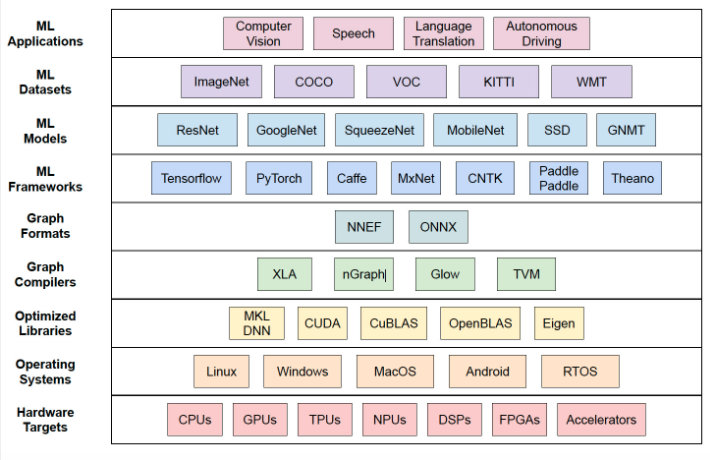

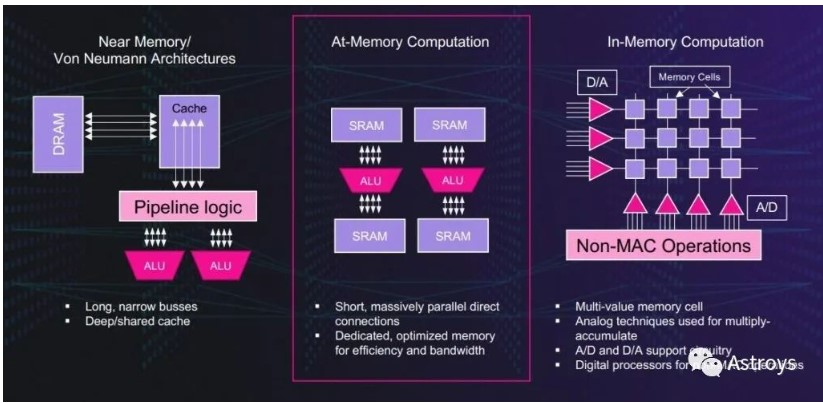

2218 三张图 在Xilinx官网找资料无意中在应用AI推断加速中看到了下面三张图,顿觉众里寻他千百度,蓦然回首,那人却在灯火阑珊处的意思了。三张图非常通俗易懂的介绍了FPGA/ACAP这样的体系结构在AI

2020-12-04 15:37:31 1143

1143 9月2日,欧洲航天局发射了46颗大小与台式机相当的实验卫星,其中一颗名为“PhiSat-1”的实验卫星搭载了新款高光谱热像仪,具备机载AI处理能力——卫星具备硬件加速AI推理能力,这还是第一次。

2020-10-22 09:46:13 1454

1454 在 2019 年 4 月,高通公司发布了一款专用于云端 AI 加速的处理器 Qualcomm Cloud AI 100,采用 7nm 工艺,性能比当时业界最先进的 AI 推理解决方案高出 10

2020-10-28 17:59:39 2408

2408 的 AI 应用需要经历训练和推理两个过程。所谓“训练”,就是我们要将大量的数据代入到神经网络模型中运算并反复迭代,“教会”算法模型如何正确的工作,训练出一个 DL 模型。而接下来,我们就可以利用训练出来的模型来在线响应用户的

2020-10-30 12:17:37 246

246 云端AI推理需求将在2022年迎来爆发。继去年底发布首款面向数据中心的AI训练芯片“邃思”及加速卡“云燧T10”后,燧原科技又发布了首款面向云端的高性能推理卡。

2020-12-22 10:09:36 2158

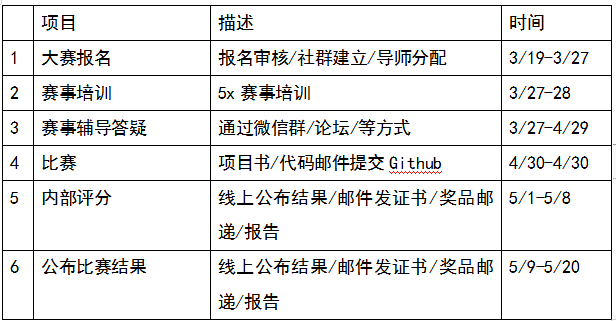

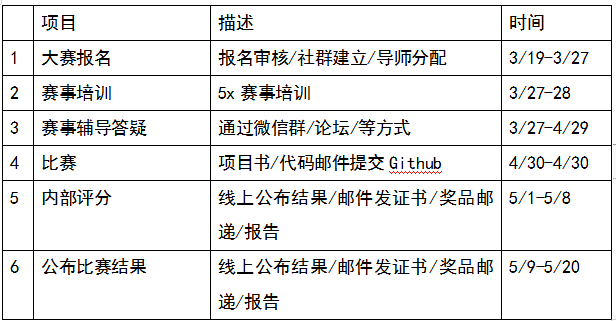

2158 为了让更多的工程师迅速掌握这个高性能的加速工具,英伟达将联合生态合作伙伴,面向全国开发者们发起TensorRT加速AI推理hackathon 2021大赛。

2021-03-21 10:04:22 3052

3052

如今在嵌入式开发领域,如何实现嵌入式AI推理是一个热门话题。其中,如何在低算力、低功耗、低成本的MCU上部署AI应用,是开发者普遍面临的一个设计“痛点”。 在硬件方面,MCU自身性能的局限性限制

2021-06-06 18:05:46 2184

2184 据 IDC 研究显示,到 2024 年,AI 服务器市场市值预计将超 260 亿美元,年增长率将达 13.7%。在中心和边缘的基础架构中,Ampere 的客户正在寻找解决方案,以管理 AI 推理任务成本和不断增长的需求。

2021-08-05 15:36:41 805

805 在模型开发和部署方面,极市平台集成了最新版本的OpenVINO工具,助力开发者在最小化代码修改的条件下加速AI算法在各类生产环境中规模化部署应用,尤其是在Intel丰富的硬件资源平台上(CPUs

2021-09-22 16:19:18 1571

1571

腾讯一直积极地推动强化学习在游戏AI领域的发展,并在2019年推出了“开悟”AI开放研究平台,提供不同游戏的训练场景、支撑AI进行强化训练的大规模算力、统一的强化学习框架以加速研发速度、通用的训练

2021-10-22 09:23:24 1320

1320 Capital One、Microsoft、Samsung Medison、Siemens Energy、Snap等全球行业领导者都在使用该平台 NVIDIA宣布其AI推理平台的重大更新,目前

2021-11-12 14:42:53 1684

1684 自第一代云端AI推理加速卡“云燧i10”发布后,燧原科技在构建原始创新的通用算力和自主生态上付出了卓绝的努力。

2021-12-07 15:29:23 565

565

2021年12月,燧原科技重磅发布第二代云端人工智能推理加速卡“云燧i20”——这是时隔仅五个月,继今年7月发布云端人工智能训练加速卡“云燧T20”之后,燧原科技又推出的全新一代针对云端推理场景的AI加速产品。

2021-12-09 15:16:17 1761

1761 数据算力需求的日益增长带动了AI芯片行业的兴起,作为中国AI芯片的中坚力量,燧原科技聚焦于AI训练与推理不断推出芯片以及加速卡产品。12月7日,燧原科技重磅发布第二代云端人工智能推理加速

2021-12-09 13:12:00 3178

3178

当前我们在做端侧的AI处理的时候,很难百分百的将整个网络的推理过程做到一个graph里面。于是我们将AI在端侧的推理过程一般化,可以分成...

2022-01-25 19:36:46 2

2 一个完整的医疗影像推理流程一般包含数据的前处理、AI 推理以及数据后处理这几部分。

2022-04-10 15:06:09 2396

2396 NVIDIA Clara Holoscan 为开发人员提供了一个可扩展的医疗设备计算平台,以创建人工智能微服务并实时提供见解。该平台优化了数据管道的每个阶段:从高带宽数据流和基于物理的分析到加速 AI 推理和图形可视化。

2022-04-15 14:45:29 1013

1013

网易互娱 AI Lab 的研发人员,基于 Wenet 语音识别工具进行优化和创新,利用 NVIDIA Triton 推理服务器的 GPU Batch Inference 机制加速了语音识别的速度,并且降低了成本。

2022-05-13 10:40:19 1481

1481 SiFive 将 RISC-V 处理器 IP 引入其下一代 AI 推理加速器,为边缘设备中的计算机视觉和语音提供更快、更高效的计算能力。

2022-05-31 10:47:55 770

770 客户对基准推理学习曲线的最后阶段是开发自己的模型,使用通常来自 Nvidia 或数据中心的训练硬件/软件,然后在可能的目标推理加速器上对该模型进行基准测试。

2022-06-06 16:02:21 1044

1044 最新的 AI 推理基准显然具有重要意义,因为它是目前可用的最接近真实世界 AI 推理性能的衡量标准。但随着它的成熟和吸引更多的提交,它也将成为成功部署技术堆栈的晴雨表和新实施的试验场。

2022-07-08 15:37:55 1246

1246

SiFive 将 RISC-V 处理器 IP 引入其下一代 AI 推理加速器,为边缘设备中的计算机视觉和语音提供更快、更高效的计算能力。RISC-V 处理器的高灵活性和强大功能使客户能够以比传统技术更简单和更快的速度创建智能城市、智能零售和汽车等复杂的人工智能应用程序。

2022-07-11 11:07:06 723

723 瑞萨电子开发了一种新的内存处理器 (PIM) 技术,用于在低功耗边缘设备中加速 AI 推理。用于基于 SRAM 技术的测试芯片实现了 8.8 TOPS/W 的运行卷积神经网络 (CNN) 工作负载

2022-07-21 15:50:32 1073

1073 当 AI 设计人员将硬件加速器整合到用于训练和推理应用的定制芯片中时,应考虑以下四个因素

2022-08-19 11:35:55 1268

1268

SiFive 将 RISC-V 处理器 IP 引入其下一代 AI 推理加速器,为边缘设备中的计算机视觉和语音提供更快、更高效的计算能力。

2022-08-16 11:24:05 830

830 存算一体技术需要解决的,往往都是AI运算上的问题,比如训练和推理等等,所以不少做存算一体公司与AI芯片公司并无二致。

2022-08-29 09:14:05 391

391 腾讯云计算加速套件 TACO Kit 包含 TACO Train 和 TACO Infer 两个 AI 组件。基于 GPU 异构计算平台针对业界 AI 训练和推理任务进行了全方位的加速优化。TACO

2022-08-31 09:24:07 1235

1235 一方面,有广泛使用的基于CPU和GPU的解决方案。另一方面,许多推理处理器通常专门作为视觉处理器。

2022-08-31 09:42:34 1512

1512

蚂蚁链 AIoT 团队与 NVIDIA 合作,将量化感知训练(QAT)技术应用于深度学习模型性能优化中,并通过 NVIDIA TensorRT 高性能推理 SDK 进行高效率部署, 通过 INT8 推理, 吞吐量提升了 3 倍, 助力蚂蚁链版权 AI 平台中的模型推理服务大幅降本增效。

2022-09-09 09:53:52 872

872 加速AI推理模型已成为一项基本任务,因为我们正朝着创建更复杂,更高效的AI应用程序迈进。灵活和完整的AI辅助是在快速增长的AI领域取得成功的关键组成部分。

2022-10-19 09:08:50 423

423 通过 NVIDIA GPU 加速平台,Colossal-AI 实现了通过高效多维并行、异构内存管理、大规模优化库、自适应任务调度等方式,更高效快速部署 AI 大模型训练与推理。

2022-10-19 09:39:39 1149

1149 电子发烧友网站提供《基于AdderNet的深度学习推理加速器.zip》资料免费下载

2022-10-31 11:12:28 0

0 近日,昆仑芯新品R100于2022智算峰会「智能芯力量」专题论坛正式发布。昆仑芯AI加速卡R100(以下简称“昆仑芯R100”)定位于边缘大算力推理,较昆仑芯1代AI加速卡K100平均性能提升2.3倍,以更低功耗、更小巧体积灵活适配各类服务器,赋能多种复杂边缘推理场景。

2022-12-29 11:36:23 1681

1681 今天简报较短,主要演示一下如何在RT-Thread OS环境下使用ncnn进行AI推理

2023-05-04 16:29:49 724

724

兆瀚RA2300-A系列服务器是湘江鲲鹏基于昇腾处理器开发的AI推理服务器,最多可搭载8张Atlas300VPro视频解析卡或Atlas300IPro推理卡,能够为用户在

2022-04-13 19:51:55 1655

1655

低门槛玩转X3派AI算法推理

2022-07-18 14:24:30 467

467

自动驾驶的最优 AI 推理流水线设计

2023-07-05 16:30:41 350

350

近日,英特尔专门针对中国市场推出深度学习加速器Habana® Gaudi®2.以领先的性价比优势,加速AI训练及推理,提高深度学习性能和效率,从而成为大规模部署AI的更优解。作为英特尔在中国最重

2023-07-19 14:43:32 468

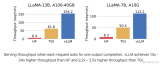

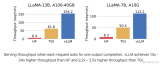

468 vLLM是一个开源的大模型推理加速框架,通过PagedAttention高效地管理attention中缓存的张量,实现了比HuggingFace Transformers高14-24倍的吞吐量。

2023-10-10 15:09:58 1556

1556

昆仑芯科技公众号全新栏目“用芯指南”重磅推出!面向AI行业技术从业者,系列好文将提供手把手的昆仑芯产品使用指南。第一期围绕昆仑芯自研效能工具——昆仑芯Anyinfer展开,这是一款基于昆仑芯AI加速卡的高效模型推理部署框架。种种行业痛点,昆仑芯Anyinfer轻松搞定。

2023-10-17 11:16:43 799

799

由 CSDN 举办的 NVIDIA AI Inference Day - 大模型推理线上研讨会,将帮助您了解 NVIDIA 开源大型语言模型(LLM)推理加速库 TensorRT-LLM 及其功能

2023-10-26 09:05:02 174

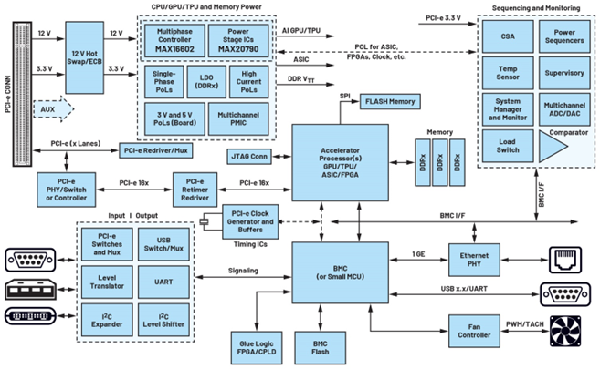

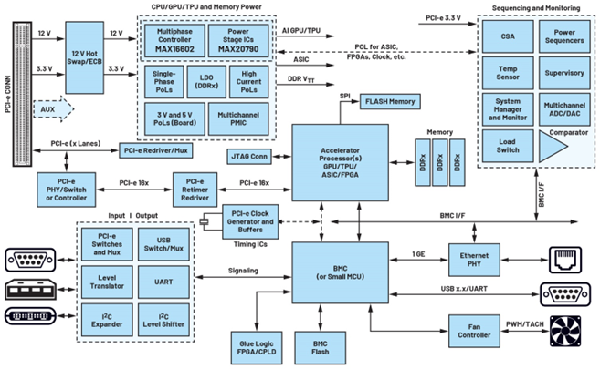

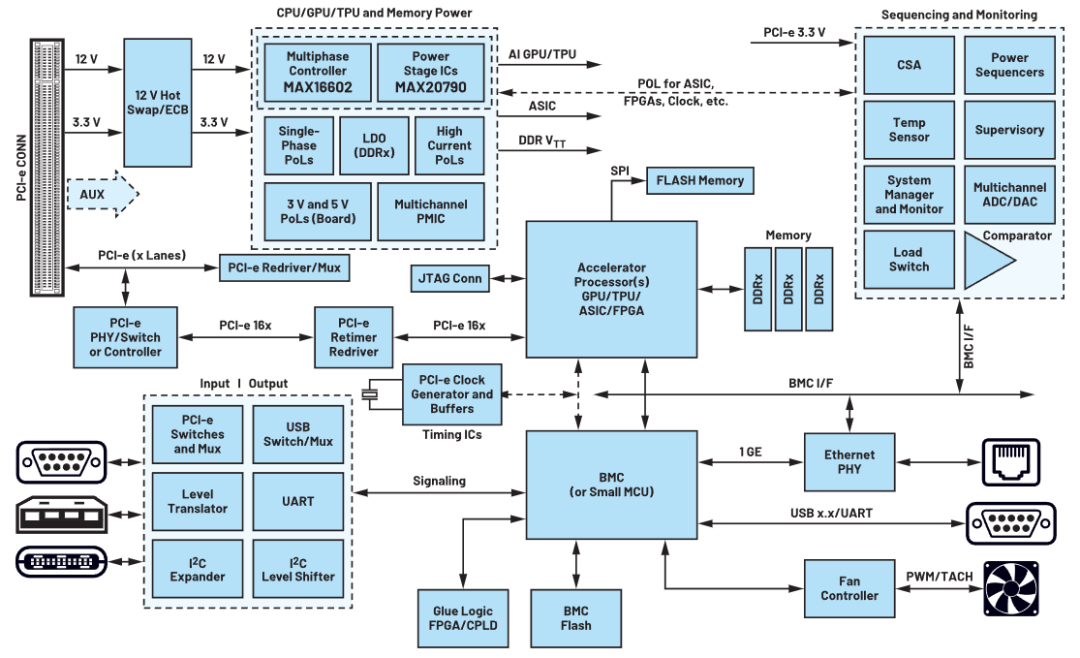

174 图形处理单元(GPU)、张量处理单元(TPU)和其他类型的专用集成电路(ASIC)通过提供并行处理能力来实现高性能计算,以满足加速人工智能(AI)训练和推理工作负载的需求。

2023-11-16 17:23:58 606

606

图形处理单元(GPU)、张量处理单元(TPU)和其他类型的专用集成电路(ASIC)通过提供并行处理能力来实现高性能计算,以满足加速人工智能(AI)训练和推理工作负载的需求 。 AI需要大量

2023-12-01 18:10:03 191

191

这家云计算巨头的计算机视觉和数据科学服务使用 NVIDIA Triton 推理服务器来加速 AI 预测。

2024-02-29 14:04:40 162

162 据多位知情人士透露,科技巨头字节跳动正在人工智能(AI)大模型领域秘密研发多个创新产品。其中,多模态数字人产品备受瞩目,该产品将结合先进的AI技术与虚拟形象,为用户提供全新的交互体验。此外,字节跳动还在研发AI生图、AI生视频产品,这标志着公司在AI内容生成领域迈出了重要步伐。

2024-03-05 11:22:05 339

339 近日,知名AI推理框架开源社区ONNX Runtime正式发布支持龙架构的版本1.17.0。

2024-03-12 12:23:20 225

225

如今,AMD EPYC处理器已经成为最常被选择用于AI推理的服务器平台,尤其是第四代Genoa EPYC 9004系列,执行AI推理的能力又得到了巨大的飞跃。

2024-03-15 09:47:09 68

68

电子发烧友App

电子发烧友App

评论