8月1日消息,又一支清华芯片团队取得重大突破!来自清华的“天机”类脑芯片架构登上了顶级学术杂志《自然(Nature)》封面。

28nm的天机芯片由156个FCores组成,面积为3.8×3.8毫米,包含大约40000个神经元和1000万个突触,可以同时支持机器学习算法和类脑电路。

2019-08-01 09:57:30 1570

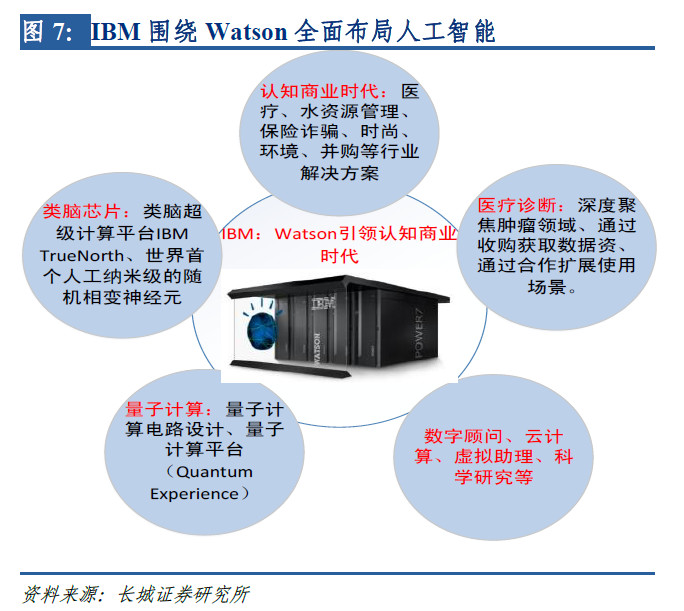

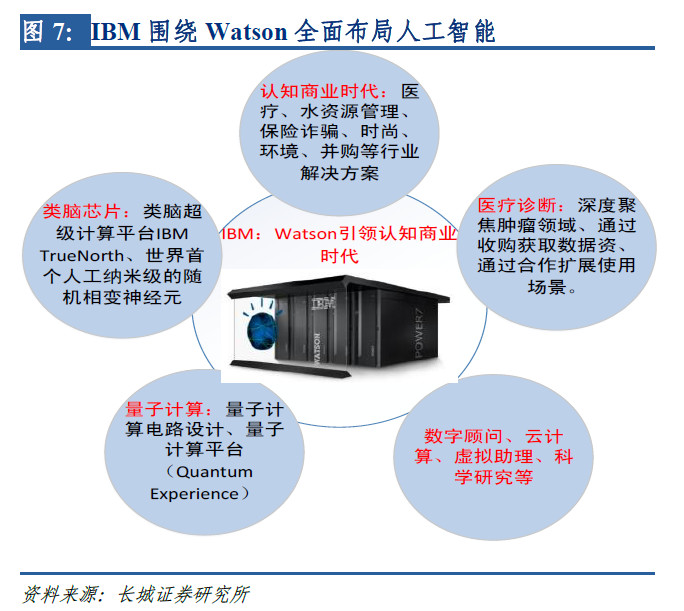

1570 只有将 AI 技术与数据结合,才可形成实用性的业务。本文主要侧重于介绍IBM、Google在基础层、技术层、应用层全面布局AI,并对其扩展应用场景等内容进行介绍。

2016-11-09 14:18:59 11800

11800

视觉人工智能的应用场景十分丰富,商业化价值巨大,全球40%的AI企业都集中在视觉AI领域。在视觉AI落地的这些项目过程中遇到了什么问题,主要的瓶颈来自哪里?现在是否都已经解决了呢?

2019-06-25 15:42:29 10519

10519 全新RTX A2000 GPU采用小巧、节能的设计,适用于更多台式机,同时加速设计工作流程中的AI和光线追踪。

2021-08-12 10:58:33 3914

3914

科技等。就在2021年3月,天数智芯发布全自研云端训练通用GPU芯片——天垓100芯片,这也是国内第一款全自研、GPU架构下的7nm制程通用GPU训练芯片。 电子发烧友网记者了解到,天数智芯的7nm 通用GPU训练芯片已经获得安防、人工智能、超算中心等多个应用领域的

2022-03-08 07:23:00 2546

2546 的完整 SoC。IBM声称,其比通用CPU工作更快、更高效。 AIU:32个处理器核心、230亿个晶体管 这款AIU芯片是IBM研究院AI硬件中心投入五年开发出的结果,AI硬件中心于2019

2022-11-24 01:53:00 2197

2197 电子发烧友网报道(文/李弯弯)日前消息,IBM总经理卡勒(Mukesh Khare)在旧金山的一次半导体会议上接受采访时表示,公司新一代企业级AI数据平台Watson系统将考虑采用自行研发的AI芯片

2023-07-19 01:22:00 1387

1387

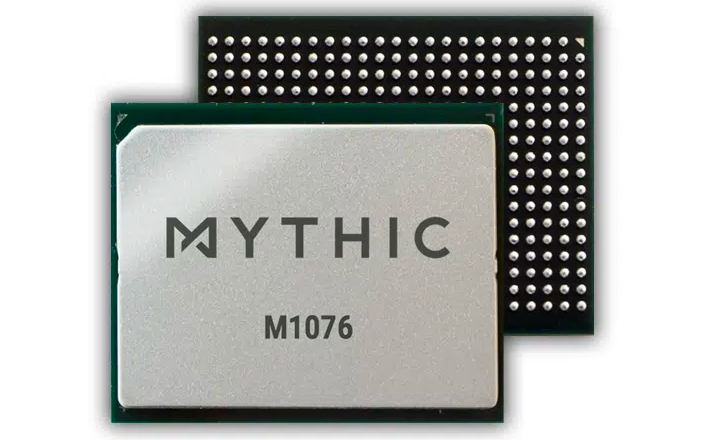

,硬件成本已经成了AI发展的最大瓶颈。 为了训练高质量的AI模型,堆硬件数量几乎是避无可避的。为此,越来越多的AI芯片厂商看到了这个缺口,力求以自己的高性能硬件产品来填补竞品造成的缺口。甚至不少此前专注在低功耗/边缘AI计算的半导体公司

2023-10-23 09:03:00 942

942

AI芯片作为产业核心,也是技术要求和附加值最高的环节,在AI产业链中的产业价值和战略地位远远大于应用层创新。腾讯发布的《中美两国人工智能产业发展全面解读》报告显示,基础层的处理器/芯片企业数量来看,中国有14家,美国33家。本文将对这一领域产业生态做一个简单梳理。

2019-08-13 08:42:38

算法的兼顾,英伟达不仅能用GPU满足AI构建的训练需求,还能用TeslaRT用来部署,很好实现AI构建,所以英伟达也率先成了这一波AI热潮的最大受益者。给机器人“造脑”,英伟达发布全新AI芯片

2018-06-11 08:20:23

然估计这个模型本身就是有瓶颈的,而现在离这个瓶颈现在已经很近了。接下来会是算法的时代,但人工智能的寒冬注定会在短期内再次降临。硬件会是有效的加速辅助工具,但人工智能的核心还会是软件。讲AI芯片是个伪概念,笔者认为倒也不算错。

2018-08-24 10:36:53

高性能的GPU+CPU+FPGA等硬件平台与云端计算服务,通过U盘大小的计算棒,即可获得强大的算力与深度学习推理能力。此前AI人工智能计算棒仅支持Linux系统终端,本次更新加入对Mac、Windows系统的兼容,将

2022-08-15 17:53:47

现在说AI是未来人类技术进步的一大方向,相信大家都不会反对。说到AI和芯片技术的关系,我觉得主要体现在两个方面:第一,AI的发展要求芯片技术不断进步;第二,AI可以帮助芯片技术向前发展。

2019-08-12 06:38:51

可以满足高吞吐量互联的需求,为自然语言处理、计算机视觉、语音交互等人工智能应用场景提供强大的算力支持,支撑AI算法训练和推理过程。当前在云端场景下被最广泛应用的AI芯片是英伟达的GPU,主要原因

2021-12-07 10:04:11

IBM Aspera采用了一种不同的方法来应对全球广域网上大数据移动的挑战。Aspera没有优化或加速数据传输,而是使用突破性的传输技术消除了潜在的瓶颈,充分利用可用的网络带宽来最大限度地提高速度,并在没有理论限制的情况下快速扩展。

2023-08-11 06:51:46

ai芯片和gpu的区别▌车载芯片的发展趋势(CPU-GPU-FPGA-ASIC)过去汽车电子芯片以与传感器一一对应的电子控制单元(ECU)为主,主要分布与发动机等核心部件上。...

2021-07-27 07:29:46

ai加速芯片,申耀的科技观察读懂科技,赢取未来!毫无疑问,以大数据分析、云计算、人工智能等新技术所推动的数字化转型正迅速的改变着我们所处的时代,其巨大的影响力已经从量变上升为质变,可以说数字化转型已成...

2021-07-28 07:53:56

G52 MP4(6EE) GPU,NPU for AI 支持 5.0 TOPS算力,支持摄像头和MIPI-CSI接口,HDMI输出,2个全千兆接口。板载4G内存和16gb eMMC存储

2021-09-30 12:41:58

G52 MP4(6EE) GPU,NPU for AI 支持 5.0 TOPS算力,支持摄像头和MIPI-CSI接口,HDMI输出,2个全千兆接口。板载4G内存和16gb eMMC存储

2021-09-30 14:37:44

是“XPU”等加速器兴起的原因。

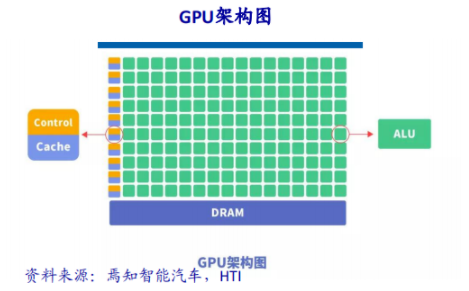

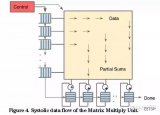

图1:CPU 面临算力瓶颈的原因

同时, 自 2010 年 AI 兴起, AI 模型的训练所需的算力是爆发式的增长,且 “加&乘”的本质

2023-11-09 14:09:46

Imagination全新BXS GPU助力德州仪器汽车处理器系列产品实现先进图形处理功能

2020-12-16 07:04:43

, 继承了该接口的诸多优点,也更适合此类场景应用,为用户提供了一种算力边缘侧部署的解决方案,同时MXM接口还可以为用户提供其它架构算力模块搭配方案,如MXM界面的寒武纪算力卡,MXM界面的登临算力卡等

2022-05-18 15:52:40

NPU算力集成有哪些特性呢?RK1808内置的NPU算力集成有何功能?

2022-02-16 07:52:14

目的本文介绍广州星嵌DSP C6657+Xilinx Zynq7035平台下Xilinx Zynq7035算力指标。基本概念FLOPs/FLOPSFLOPs,Floating Point

2022-12-15 21:19:38

有8G的显存,可以处理复杂的算法,提高挖掘稳定性。iBeLink ks max10.5T的超大特点是它的高效节能,它采用了先进的“存算一体”高通量算力芯片,专为“大型复杂”的区的块的链加密局域网运算而

2024-02-20 16:11:20

已下是rx580显卡算力9-11 Mh 没有开启计算模式,挖几分种重启自动开启,计算模式只支持WIN1022-28 Mh 原版BIOS,开启时序,并设置超频29-32 Mh 正常算力,卡体质不同算力

2021-07-23 06:59:09

簇都可以配置缓存大小和线程数。取决于簇/核心数量的配置,NEOX GPU的算力在12.8到409.6GFLOPS(800MHz)之间,支持FP16和FP32的浮点精度。NEOX不同配置下的算力

2022-03-24 15:53:12

”SoC产品的预期功耗约为3瓦,峰值算力4TOPS。考虑到网络压缩部分,等效的算力应该再扩大5-10倍。当下嵌入式领域的AI芯片中,无论是FPGA还是GPU,都很难越过每瓦1TOPs能效比,而听涛将会超过

2018-03-23 15:27:20

智慧化进程。人工智能芯片是人工智能发展的基石,是数据、算法和算力在各类场景应用落地的基础依托。“无芯片不AI”已经深入人心,成为业界共识。本次直播将述说AI芯片设计带你解析AI算法及其芯片操作系统

2019-11-07 14:03:20

智慧化进程。人工智能芯片是人工智能发展的基石,是数据、算法和算力在各类场景应用落地的基础依托。“无芯片不AI”已经深入人心,成为业界共识。本次直播将述说AI芯片设计带你解析AI算法及其芯片操作系统

2019-11-07 14:18:45

可以满足高吞吐量互联的需求,为自然语言处理、计算机视觉、语音交互等人工智能应用场景提供强大的算力支持,支撑AI算法训练和推理过程。当前在云端场景下被最广泛应用的AI芯片是英伟达的GPU,主要原因

2021-12-07 09:59:04

神经网络处理内核 NPU,算力达到 128 GOPS。多核异构的设计使芯片能以较低功耗满足音频及图像视频的 AI 应用需求。 环境搭建 本次体验使用的开发环境是 Ubuntu 20.04

2022-11-23 16:09:42

众多并且快速多变,AI芯片落地存在困难,难以大规模量产。无法量产的芯片,对宏观算力的提升,没有多大意义。最后是宏观层次,算力的利用率。我们有了这么多芯片,但如果是孤岛,有的系统性能不够用,而大部分

2022-11-24 16:37:10

公司Compass Intelligence发布了最新研究报告,在全球前15大AI芯片企业排名表中,前三名是英伟达(Nvidia)、英特尔(Intel)以及IBM,华为位列第12名,成为TOP15

2018-05-07 09:26:47

为什么需要嵌入式AI?嵌入式AI还有瓶颈半导体厂商的新商机

2021-01-22 06:14:40

芯片平台,具备高效的移动运算性能及超低功耗管理,带来极致的性能体验超强算力:15T超强算力,支持多种AI算法,满足多种AI应用场景的需求超凡视觉体验:支持多路4K高清摄像头,支持多MIC阵列,提供更高

2022-10-26 16:00:58

什么是人工智能(AI)芯片?AI芯片的主要用处有哪些?在AI任务中,AI芯片到底有多大优势?

2021-09-22 08:00:01

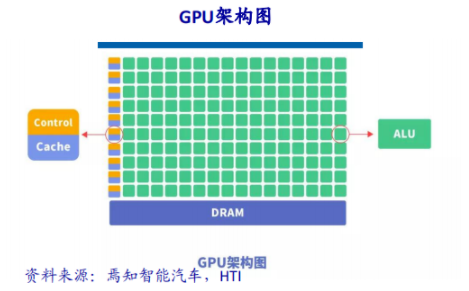

可以在图像处理领域大显身手,它还被用来科学计算、密码破解、数值分析,海量数据处理(排序,Map-Reduce等),金融分析等需要大规模并行计算的领域。所以GPU也可以认为是一种较通用的芯片。▌ FPGA

2017-03-15 11:40:15

3月18日消息,继推出智能语音专用处理器R328之后,近日全志科技正式发布主打AI语音专用的重磅产品R329,这是全志科技首款搭载Arm中国全新AI处理单元(AIPU)的高算力、低功耗AI语音专用芯片。

2020-11-23 14:18:03

基本数据结构。所以,张量处理单元,我们可以简单理解为“AI处理单元”。

2015年,为了更好地完成自己的深度学习任务,提升AI算力,Google推出了一款专门用于神经网络训练的芯片,也就是TPU v1

2024-01-23 19:08:55

随着人工智能应用的不断普及,各种行业应用对于算力的需求不断增加。从当前提供AI加速运算的解决方案来看,在云端仍然以GPU方案为主,在终端领域,使用边缘AI芯片的方案则变得越来越广泛,成为行业共识

2022-11-22 15:52:15

输入充沛算力进行图像处理3D识别模组典型用例:人流人数统计相机多方向高清输入深度信息计算提升准确度办公消费智能硬件典型用例:考勤门禁门锁智能终端多目活体检测高清屏幕显示STEAM智能教育典型用例:AI教育开发板/机器人工具链灵活易用完整Linux支持和持续开源生态丰富示例,开放社区

2022-11-18 15:04:55

,RK3588AI拓展能力更强 QCS8250跟RK3588都内置了独立的NPU,不过高通的AlI算力构成比较复杂,有内置独立NPU,也有AI DSP,还有GPU,官方给出的综合算力是15TOPS,在

2022-08-04 15:29:00

随着人工智能高速发展,逐渐向人们的生活场景渗透,其对数据计算量要求越来越庞大,处理速度要求越来越快,硬件性能要求也越来越高。针对此需求,飞凌嵌入式推出了面向AI边缘系统的最新产品:高算力“魔盒

2021-12-10 10:18:20

随着人工智能高速发展,逐渐向人们的生活场景的渗透,对数据计算量要求也是越来越庞大,处理速度要求越来越快,这对硬件性能要求也就越来越高,针对这个需求,飞凌嵌入式推出了面向AI边缘系统的最新产品高算力“魔盒”—AI 边缘计算终端FCU3001。

2021-12-14 09:22:44

AI实现的特点有哪些?AI芯片设计和开发面临哪些挑战?

2021-11-02 09:19:08

背景介绍数据、算法和算力是人工智能技术的三大要素。其中,算力体现着人工智能(AI)技术具体实现的能力,实现载体主要有CPU、GPU、FPGA和ASIC四类器件。CPU基于冯诺依曼架构,虽然灵活,却

2021-07-26 06:47:30

依托其自研IDMV架构、指令集和编译器,具有高算力、高通用性和高能效三大优势。该芯片工作主频为1200MHz,像素填充率19.2Gpixels/s,纹理填充率76.8Gpixels/s,单浮点运算力

2023-02-15 09:36:38

型号最大分辨率摄像头个数算力其它hi3519AV1004k@60fps Max 5 In2T AIISP4 ENC4 AI1hi3559V2004k@30fps Max 2 In0.4T

2020-09-01 12:52:38

1.端侧AI的发展现状与挑战AI云计算端侧仅负责发送输入数据,并接收计算结果优势:计算资源集中管理和分配单一计算可达很高的算力和精度部署便捷劣势:算力成本高流量成本高、延迟大离线无法工作2.瑞芯微

2020-07-24 10:58:40

我有一個reference capacitor 50pF一個variable capacitor 50 + (0-5)pF是用來計算其壓力有什麼IC適合我使用 THANKS!

2018-09-30 14:10:24

NXP第一颗带NPU的高端芯片,面向AI场景高性能i.MX 8M Plus处理器2.3 TOPS算力,强大边缘计算能力;4核 Cortex-A53 + Cortex-M7,主频1.8GHz+

2021-12-31 11:47:57

目前市场上炙手可热的芯片矿机 当数芯动 A10PRO , 7g 版本的 算力750m 功耗 1300w 这款机器厂家出厂时预定价格在 48900 左右那时候定的客户到如今 机器价格已经涨到

2021-07-23 07:39:58

,AI硬件正成为越来越多数据中心扩容建设的关键所在。当超强AI算力成为数据中心的刚需,英伟达GPU凭借强大的并行计算和浮点能力,突破了深度学习的算力瓶颈,成为AI硬件的首选。这一契机才使得英伟达能够在数

2022-03-29 14:42:53

编者按: 在刚刚结束的 PyCon China 2022 大会上,龙蜥社区开发者朱宏林分享了主题为《ARM 芯片的 Python+AI 算力优化》的技术演讲。本次演讲,作者将向大家介绍他们在倚天

2022-12-23 16:02:46

RK3588是Rockchip全新一代旗舰AIoT芯片,采用了8nm LP制程;搭载八核64位CPU,主频高达2.4GHz;集成ARM Mali-G610 MP4四核GPU,内置AI加速器NPU

2023-09-11 20:25:54

,每颗ATALS 200 AI处理加速模块内含1颗华为Ascend 310 AI芯片,可提供高达22TOPS的INT8算力,使其在一种边缘计算产品中脱颖而出。满足

2022-04-20 16:15:56

斑梨电子 地平线AI开发板旭日X3派 接口兼容树莓派5TOPs等效算力超Jetson Nano地平线旭日X3派简介:地平线旭日X3 派是一款面向生态开发者的嵌入式 AI 开发板

2022-07-27 17:36:19

适用范围YNH-512属于智能POS机主板,适用于:POS机、AI称等设备。 产品概述YNH-512采用瑞芯微RK3566 四核64位处理器,芯片自带1.0T算力

2023-04-11 10:19:13

日前,IBM宣布该公司2016在美国获得了8088项专利,连续24年位居第一。其中,与人工智能、认知计算和云计算相关的专利约2700项,可谓功不可没。 人工智能送助攻 IBM登上2016年专利榜首

2017-01-10 12:43:11 483

483 IBM x3650M5_系统全新安装教程

2017-09-11 08:39:32 19

19 所谓的AI芯片,一般是指针对AI算法的ASIC(专用芯片)。传统的CPU、GPU都可以拿来执行AI算法,但是速度慢,性能低,无法实际商用。

2018-07-25 14:58:51 33472

33472

所谓的AI芯片,一般是指针对AI算法的ASIC(专用芯片)。传统的CPU、GPU都可以拿来执行AI算法,但是速度慢,性能低,无法实际商用。

2018-08-01 10:34:57 10550

10550

美国低功耗现场可程序逻辑门阵列(FPGA)制造商Xilinx表示,伙伴厂商利用FPGA芯片进行基因体定序与优化语音识别所需的深度学习、察觉FPGA的耗能低于GPU且处理速度较快。

2018-11-26 16:03:19 2859

2859 随着人工智能(AI)日益改变未来的工作方式和人力资源的职能,IBM日前推出全新业务 —— IBM Talent & Transformation(IBM人才与转型),致力帮助企业及其员工在AI和智能自动化时代释放更大潜能。

2018-12-02 09:55:33 2836

2836 亚马逊宣布推出Inferentia,这是由AWS设计的芯片,专门用于部署带有GPU的大型AI模型,该芯片将于明年推出。

2018-12-03 09:46:08 1753

1753 2019年1月2日,云知声在北京召开一场主题为”声视不凡“的新闻发布会,正式公布了其全新的多模态AI芯片战略与规划。

2019-01-04 09:41:31 4643

4643 昨日,阿里达摩院发布2019十大科技趋势,其中就指出:AI专用芯片将挑战GPU的绝对统治地位。当下数据中心的AI训练场景下,计算和存储之间数据搬移已成为瓶颈,新一代的基于3D堆叠存储技术的AI芯片架构已经成为趋势。

2019-01-04 15:52:00 1579

1579 NVIDIA 虽凭借通用GPU(GPGPU)登上人工智慧(AI)芯片一哥位置,但竞争对手早已在一旁虎视眈眈。美国低功耗现场可程式逻辑闸阵列(FPGA)制造商Xilinx 表示,伙伴厂商利用FPGA

2019-01-18 14:14:42 499

499 北京,2018年12月3日:随着人工智能(AI)日益改变未来的工作方式和人力资源的职能,IBM(NYSE: IBM)日前推出全新业务 —— IBM Talent & Transformation

2019-03-10 08:56:46 711

711 据Times Union报道,IBM日前宣布,与纽约州立大学理工学院(SUNY Polytechnic Institute)合作设立AI硬件研发中心(AI Hardware Center),研发测试用于AI的电脑芯片。

2019-03-01 17:29:00 553

553 当前主流的AI芯片主要分为三类,GPU、FPGA、ASIC。其中GPU、FPGA均是前期较为成熟的芯片架构,属于通用型芯片。ASIC属于为AI特定场景定制的芯片。

2019-03-07 14:39:21 29058

29058 来源:陆志方科学网博客最近,看到一篇关于医疗AI的文章《IBM医疗AI宣告失败,率先入局却踏步不前》。199

2019-05-09 14:06:48 2928

2928 Watson 是IBM 的重量级AI 系统;

2019-05-10 15:59:46 2573

2573 Nature Electronics 期刊上发表的一篇论文中,IBM 研究人员描述了这种新的 “混合精度内存计算” 方法。

2019-09-04 15:00:50 513

513 专业知识 通过跨行业合作应对AI性能扩展和能效提升方面的关键技术挑战,以拓展AI在各种应用场景和用例中的使用 新思科技(Synopsys)近日宣布与IBM研究院的后续合作阶段正式启动,共同推进下一代AI芯片中至关重要的芯片架构和设计方法的开发。双方自去年起就开展

2020-12-31 09:09:54 1648

1648 外媒 tweaktown 消息,AMD 于 2020 年 12 月 31 日向美国专利及商标局提交了一份专利申请,展现了全新的模块化 GPU 设计方法。 根据这项专利显示,新的 GPU 将采用

2021-01-04 15:22:06 2461

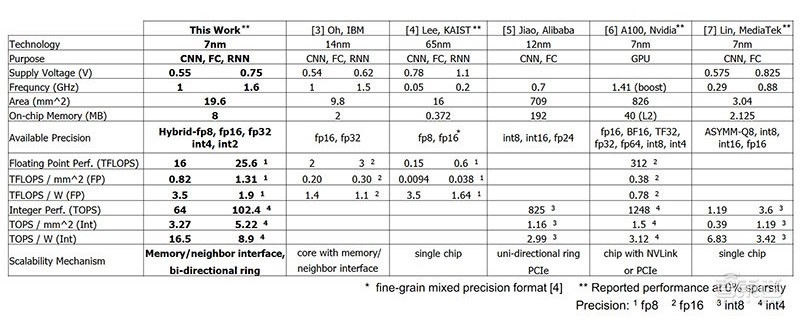

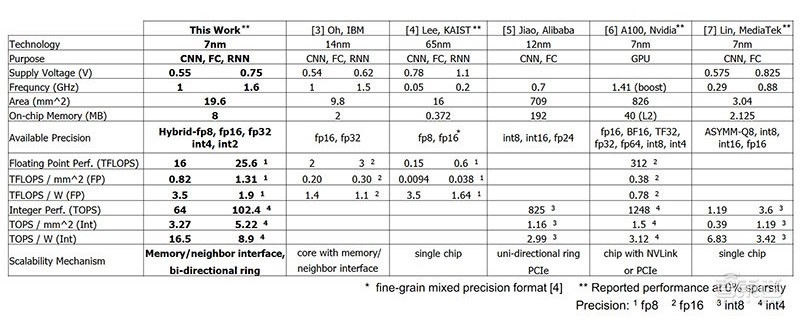

2461 ,ISSCC 2021 亦被许多厂商视为发布其领先芯片技术的权威舞台。 本届会议上,IBM 发表了据称是 “全球首款”的高能效 AI 芯片,该芯片采用 7nm 制程工艺,可达到 80% 以上的训练利用率

2021-02-19 11:03:10 1821

1821

根据《华尔街日报》在1月19日的消息,IBM旗下的Watson Health业务或将被出售。据悉,该业务曾经是IBM的明星项目,主打AI医疗。而此次出售也表明,IBM十年的AI医疗梦将画上句号。

2021-02-25 11:43:03 2092

2092 来看下我们的GPU对手——Nvidia T4和V100分别有320个和640个张量核(专门用于AI工作负载的矩阵乘法引擎) Nvidia Tesla T4 Nvidia Tesla V100 下面

2021-03-29 14:15:37 2448

2448

北京,2022 年 4 月 6 日 -- IBM (NYSE: IBM) 发布 IBM® z16™,这是把 AI 加速器集成在其芯片之上的IBM 下一代系统。

2022-04-07 10:52:07 988

988 IBM 宣布将发布三个全新的软件库,进一步扩大其嵌入式 AI(embeddable AI)软件产品组合,以帮助 IBM 生态合作伙伴、客户和开发人员更轻松、迅速且经济地构建基于 AI 的解决方案并推向市场。

2022-10-28 11:27:18 513

513 的完整 SoC。IBM声称,其比通用CPU工作更快、更高效。 AIU:32个处理器核心、230亿个晶体管 这款AIU芯片是IBM研究院AI硬件中心投入五年开发出的结果,AI硬件中心于2019年启动

2022-11-24 07:10:03 788

788 IBM (NYSE: IBM) 近日发布了全新的合作伙伴计划 IBM Partner Plus,将为合作伙伴提供前所未有的 IBM 资源、激励措施以及量身定制的支持,以重塑 IBM

2023-01-06 13:39:46 925

925 当前主流的AI芯片主要分为三类,GPU、FPGA、ASIC。GPU、FPGA均是前期较为成熟的芯片架构,属于通用型芯片。ASIC属于为AI特定场景定制的芯片。行业内已经确认CPU不适用于AI计算,但是在AI应用领域也是必不可少。

2023-03-17 11:05:30 1519

1519 愿景的期待,也带来了多款重磅硬件新品。包括全新的GPU推理平台L4 Tensor Core GPU、L40 GPU、H100 NVL GPU和Grace Hopper超级芯片。 这

2023-03-22 15:23:28 2900

2900

近日,芯片巨头AMD推出全新AI GPU MI300系列芯片,与英伟达在AI 算力市场展开竞争。

2023-07-04 09:45:45 1575

1575

AI芯片在处理大规模数据和复杂计算任务(例如深度学习算法)时具有更高的计算性能。它们通常集成了多个高性能的计算单元,如GPU(图形处理器)或专门的神经网络处理器(NPU)。

2023-08-05 16:11:02 4028

4028

人工智能(AI)芯片和图形处理单元(GPU)芯片都是现代计算机中使用的重要组件。虽然两者可以用于处理大规模数据,但它们的设计目的是不同的。在本文中,我们将深入探讨两种芯片之间的区别,以及各种应用。

2023-08-07 17:42:27 3753

3753 能够满足消费者或专家用工作负荷(如ai)的gpu的制作问题会在后续包装阶段发生。nvidia的h系列gpu使用设备的2.5d cowos包装技术,这是一个多阶段的高精密工程过程,可以减少在给定时间内组装的gpu数量,从而影响供应。

2023-08-08 09:37:42 374

374 ai芯片和gpu芯片有什么区别? AI芯片和GPU芯片是当今比较流行的芯片类型,它们都是为了更好地处理数据而设计的。虽然它们都在处理数据方面有类似之处,但在设计和使用方面还是有很大的区别。 首先

2023-08-08 18:02:28 3616

3616 面向非结构化数据的全新云规模、高性能存储设备,支持最严苛的 AI 和容量密集型工作负载 近日,IBM (纽交所股票代码:IBM) 推出了全新的 IBM Storage Scale System

2023-11-14 19:45:02 271

271

百度最新研究成果登上Nature子刊封面,文心生物计算大模型获国际顶刊认可!

2023-11-25 11:25:56 614

614

IBM 的新型模拟内存芯片证明了 AI 操作的性能和能源效率都是可能的。

2023-12-18 10:09:30 268

268

电子发烧友App

电子发烧友App

评论