3月15日,上海,由智东西主办、AWE 和极果联合主办的 GTIC 2019 全球 AI 芯片创新峰会成功举办!峰会现场延续上一届的火爆场景,全场从开幕到下午结束座无虚席,而且有不少热情观众坚持站着听完峰会全程。

20位海内外 AI 芯片业界大咖齐聚一堂,围绕 AI 芯片在架构创新、生态构建、场景落地等方面的技术前景和产业趋势“华山论剑”。

本届峰会报名参会的观众覆盖了近4500家企业,到会观众极为专业,其中总监以上级别占比超过62%,现场实际到会人数超过1800位。

▲新思科技全球战略项目副总裁 Chekib Akrout

谈及 AI 芯片,除了芯片本身、IP、代工、晶圆等元素外,EDA 厂商在其中所承载的价值亦不容忽视。作为全球第一大 EDA 解决方案提供商,新思科技(Synopsys)长期致力于提供适合开发复杂集成电路的设计工具。

当 AI 技术春回大地,新思科技也敏感地觉察到 AI 技术将对上游的应用带来的冲击,早早将 AI 引入其业界先进的设计工具之中,力图为芯片带来前所未有的自动化设计新高度。

在 GTIC 2019 峰会现场,新思科技全球战略项目副总裁 Chekib Akrout 发表了题为《为下一代 AI 芯片的架构探索与设计赋能》的演讲,探讨当下和未来 AI 芯片架构发展将面临的一些挑战和机遇、新一代 AI 芯片的驱动力,并分享了新思科技在帮助客户进行 AI 芯片开发所做的一系列努力。

Chekib Akrout 将 AI 视作火、土、气、水之外的第五元素,他认为,AI 芯片架构设计面临制程升级、集成度提高、算力需求暴增、功耗管理等挑战,同时脉冲神经网络、预测和解释、计算复杂性等问题都有极大的优化空间。

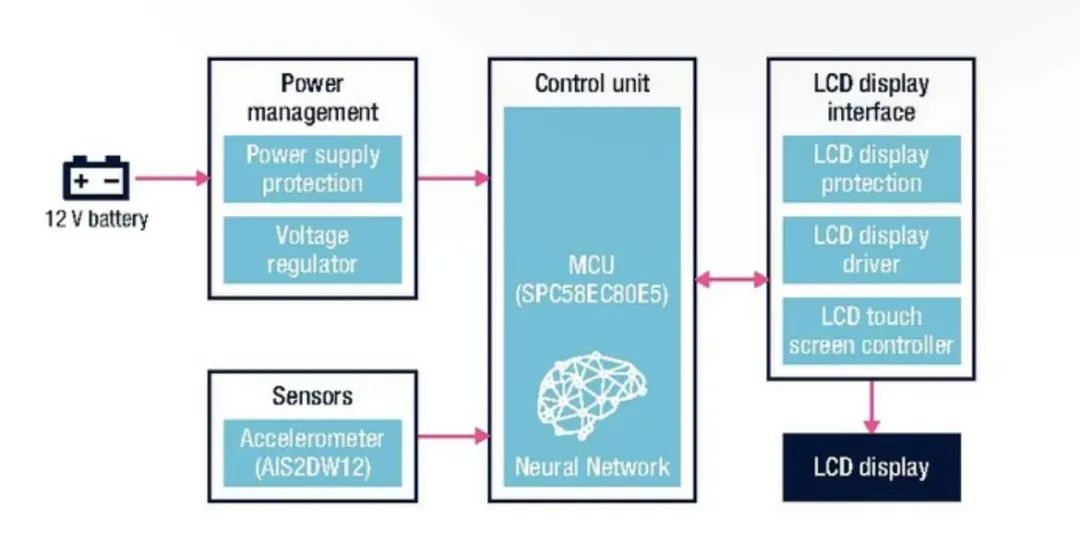

他还提到,应用自动化设计工具将是加速 AI 芯片应用的重要手段。为了推进 AI 芯片架构创新,新思科技推出了专用的AI芯片设计套件来赋能下游企业,这一套件能实现芯片设计的架构优化与应用优化,支持端到端的软硬件一体方案,同时可搭建对机器学习数据进行预处理的架构。

这些针对性的基础设施将大大提升芯片设计的自动化水平,从而降低AI芯片的设计难度,提高AI芯片设计、验证乃至最终投入使用的速度。

附新思科技全球战略项目副总裁 Chekib Akrout 演讲实录

Chekib Akrout:非常高兴来到上海,天气是如此的晴朗,蓝天白云令人心情愉悦。听到很多关于新架构、新芯片的进展,对于产业而言无疑是好消息。接下来,我将会讲述我们关于新一代 AI 芯片架构发展的一些观点。

当你听说 AI 芯片热潮的爆发,你总想知道是否另一个 AI 寒冬会归来,一切节奏都会变得缓慢,需要很长的时间来等待 AI 东山再起,这一领域的投资也会放缓。

我们首先看一下 AI 的定义,它是开发和应用表现认知行为的方法和系统的跨学科信息科学,有专门的 AI 学科和方法论,它的特征包括学习、泛化、归纳与演绎推理等,同时机器意识、自组装、自我复制、AI 社交网络等正在成为 AI 新的“标签”。

一件很有意义的事情是思考 AI 的终极形态是什么?这是一个“奇点”,可能需要量化计算和类脑计算。我们相信 AI 最终会达到人类智慧的水平。在物理或数学中,AI 可能呈现一个指数式的进化过程。从这个进化底层来看,我们始于承载延续生命重任的 DNA、RNA 等基因型及其显性性状,陆续发展到研究人类大脑,下一步就是信息技术,世间万物都在提供信息,再往后发展,或许就是生物与数字化技术的混合。

很多人疑惑为什么我们有五种基本自然元素,它们分别是火、土、气、水,第五元素被命名为 AETHER,寓意宇宙,这就是我所相信的 AI 的形态,它会给提供深度的信息数据供人类收集和分析,帮助我们更好地理解这个世界。

下面,让我们思考一下现在所处的发展阶段,以及面临的一些挑战和机遇。

我们在此前演讲中听到的 AI 芯片2.0、scale up 和 scale out,这些 AI 芯片架构都正面临着机遇和挑战。

首先,大多数数据是静态的,其中不包含时间的概念。有一种脉冲神经网络 SNN(Spike Neural Network),它可以实现对脉冲序列中包含的时间信息的学习。

思考哪一种 AI 机器学习将从其他机器那里学习,并得到一种机器学习监督者,同样会带来很多机会。

另一个机会在于预测和解释,我们有越来越多的深度学习层,这些就像黑匣子一样是不可解释的。而机器学习可以统一现有的强大力量来帮助我们进行预测和对神经网络深层的解释。

计算复杂性同样不容忽视,比如我们可能听说过的 P、NP、 NP 完全和 SAT 问题都亟待解决,以及量子计算的概率部分,这些都是机器学习和新架构应当思考的问题。

现在我想再说一下新架构——类脑计算,它模仿大脑来处理信息,有望把类似大脑的突触做到芯片上,很多人正在进行此类研发工作。我认为这一架构或许会超越来自 CPU、GPU 及其他特殊的微架构带来指数级增长。

AI 应用领域非常广阔,每个领域都包含不同的方法、算法、需要解决的问题、商业目标和最终目标。比如自动驾驶汽车催生了对 AI 芯片和AI 能力的需求,著名的战胜人类围棋冠军的 AlphaGo 适用越来越优化的强化学习。

还有很多其他领域也在取得进步,比如另外 AI 还涉及软件升级、语音识别、机器翻译、辅助医生诊疗等。其中,对 AI 芯片架构而言,AI 芯片设计领域格外重要,它将智能计算带到从特定的系统规格到最终产品的整个芯片设计流程之中,使得机器可以通过学习进行独立的芯片设计,你可以称之为“自动化设计”。

我们能做什么来助力更多 AI 芯片功能的实现?这一领域,我们能做的其实很多。比如说硅谷就非常的关注在这一领域的开发,我们看到它的这个领域的投资回报如何,比如说光刻技术越发精细, 7nm、5nm、3nm 制程工艺陆续浮出水面,来帮助提升芯片的产能,而不仅仅只是投资上面的回报。

芯片设计也在持续提高系统集成度,设计优化将探索如何使 AI、机器学习在整个集成电路上达到全局最优,算力需求的暴涨致使数据收集以及如何使资源的应用得到更多的部署成为难题。另外,芯片本身功耗、功率的控制和管理也是计算处理的核心挑战之一,有很多完善的空间。

在新思科技,我们如何引入 AI 为我们的产品赋能?我们的设计安装工具有 AI ,不仅加速了检查验证过程,提高了结果质量得到加速,还帮助优化功耗和性能。在云端,我们可以用更多的 AI 处理能力,提供更多的数据中心解决方案。

在新的方向,我们如何提供新的工具帮助客户进行 AI 芯片的开发?我们推出了专用的AI芯片设计套件来赋能下游企业,这一套件能实现芯片设计的架构优化与应用优化,支持端对端的软硬件一体解决方案,同时可搭建对机器学习数据进行预处理的架构。另外我们也在开发新的机器学习基础设施,来为机器学习准备数据。这些基础设施将有助于提升自动化设计水平,降低 AI 芯片设计难度,并提高AI芯片设计、验证乃至最终投入使用的速度。

对于 AI 从业者、实践者来说,放眼未来,我们又有着怎样的机遇和挑战?我们也对此进行了总结并分为四类。

首先,监督式机器学习需要大量被标记的数据来做训练,我们并不知道最终关于监督式的机器学习会走向什么样的程度,强化学习、在数据流中的监督和非监督学习正在被进一步探索。

另一个就是大数据集,所有的机器学习需要非常大的数据集,受限于法律规章和数据保护规则的限制,要获取超大规模数据集并非易事。最终我们可能会通过从少量数据中进行一次性学习和类比学习,其后再进行进一步的大数据的分析。

第三,我们还需要进一步的分析和解释最终的结果,深度学习就像一个黑盒子,你很难知理解里面发生了什么,简化网络和限制特征值或许会有所帮助。

最后,泛化能力同样不容忽视,新的重量级训练方式需要更多的数据,需要我们从一类数据集进行迁移学习,并将新的训练最小化到效数据集。经过一代又一代的迭代更新,确保我们的性能能够做的更好。

从一个数据集到另一个数据集到更多数据挖掘,这些都是我们所需要的一些先决条件。当前的 AI 芯片架构,有 CPU 、GPU 的部署,还有 FPGA、ASIC 等定制化微架构。未来我们会进行更多定制化的产品和服务的提供,这些都是值得深思的问题。

新一代的 AI 芯片架构有哪些驱动因素呢?除了功能更强大的处理器,更优化的功耗等性能外,还有更多其他的驱动因素。

人脑智能和人工智能正在有更多的交集,人脑存储数据的容量有限,而人工智能可以进行很好的补充和提升。同时人类擅长分层思考,可以根据相似性判断因果关系,认识到这个世界正在变化中,并信任近似的答案。

有些时候我们的机器可能不知道怎么样去处理这种关联关系,所以我们需要去思考一下我们将会有什么样的架构,我们到底需要什么样的架构。这是我们最需要去追求的最终目标,它可以帮助我们更好地利用 AI 中的常识和推理。

深度学习的结果也是在我们期望之外的,我们根本没有想到它会有这样巨大的发展。而随着数据的规模和标记难度等问题的凸显,强化学习、先进算法催生的新观点正在快速发展中。

此外,量子计算将会带来性能的飞跃,5G、硅光子和新架构等技术也都在推动我们达到下一个层面的深度学习。5G 迫使我们需要了解到如何快速处理数据,并解决延时等问题可以;硅片晶体的进步既需要更强的数据处理能力,同时也可以给 AI 芯片带来更好的发展。当我们想发展新的架构时,这些基础问题的重大突破是非常重要的。

最后,我可能会讲一些非常重要的问题。大家有没有听过盲人摸象的故事,每个人都蒙着眼睛去摸大象的一个局部,摸到象鼻的人以为是蛇,摸到象腿的人以为是树,摸到象尾巴的人以为是绳子,谁也不能确切知道大象究竟长什么样。AI 就像那个大象,我们所知不过冰山一角,对于所有人来说,我们要去继续学习和探索如何利用机器学习和 AI 的能力。

电子发烧友App

电子发烧友App

评论