完善资料让更多小伙伴认识你,还能领取20积分哦,立即完善>

标签 > transformer

文章:135个 浏览:6019次 帖子:3个

基于Transformer的大型语言模型(LLM)的内部机制

本文旨在更好地理解基于 Transformer 的大型语言模型(LLM)的内部机制,以提高它们的可靠性和可解释性。 随着大型语言模型(LLM)在使用和部...

2023-06-25 标签:存储语言模型Transformer 1492 0

Transformer在下一个token预测任务上的SGD训练动态

【导读】 AI理论再进一步,破解ChatGPT指日可待? Transformer架构已经横扫了包括自然语言处理、计算机视觉、语音、多模态等多个领域,...

2023-06-12 标签:Transformer自然语言ChatGPT 887 0

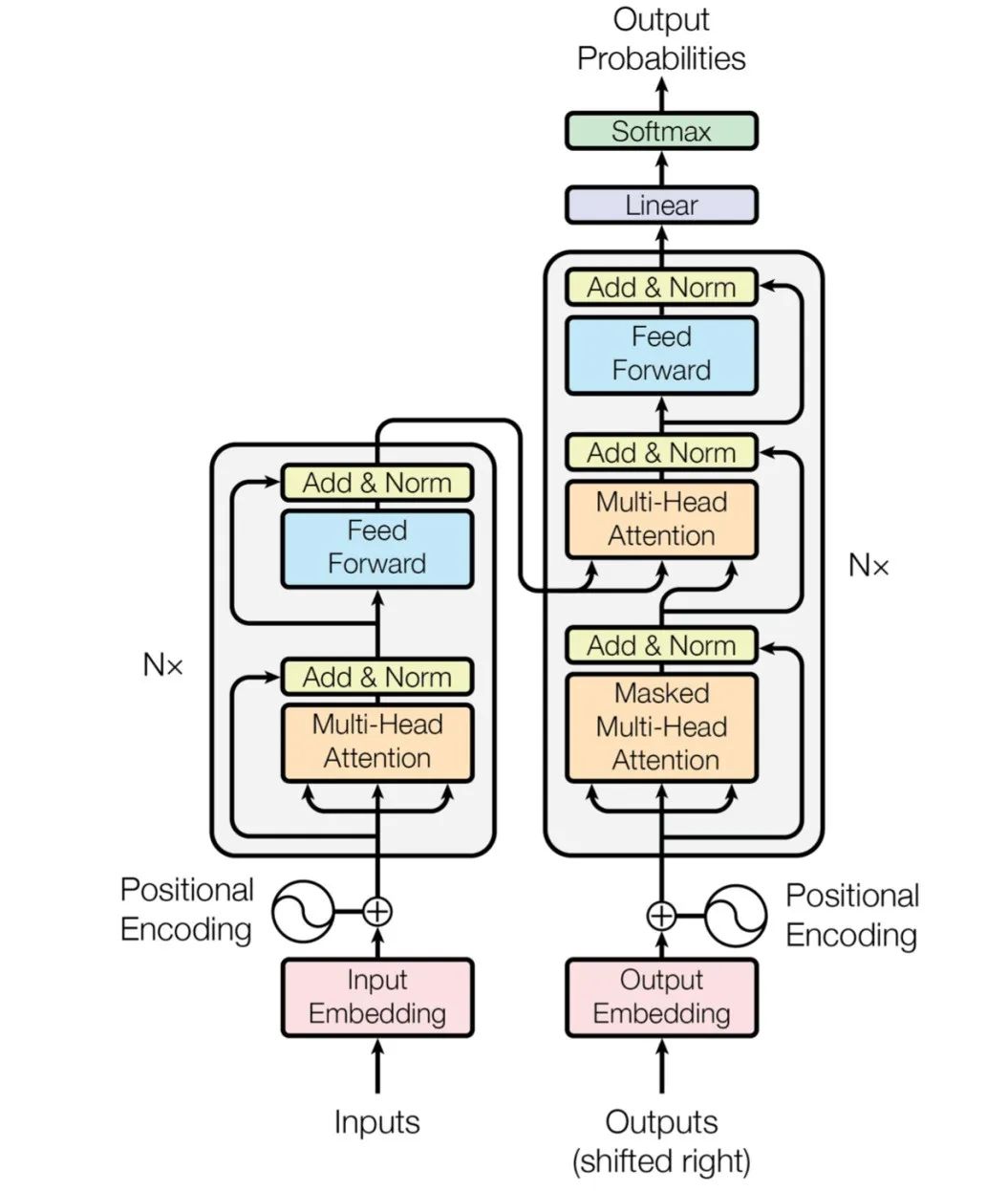

与基于 RNN 的编码器-解码器模型类似,基于 transformer 的编码器-解码器模型由一个编码器和一个解码器组成,且其编码器和解码器均由 残差注...

2023-06-11 标签:解码器编码器Transformer 2284 0

PyTorch教程-11.9. 使用 Transformer 进行大规模预训练

11.9. 使用 Transformer 进行大规模预训练¶ Colab [火炬]在 Colab 中打开笔记本 Colab [mxnet] Op...

2023-06-05 标签:Transformerpytorch 1257 0

现在比较先进的目标跟踪方法采用了“分而治之”的策略,即将跟踪问题解耦成多个子任务,例如中心点预测、前景/背景二分类、边界框回归、角点预测等。尽管在各个跟...

2023-05-16 标签:建模函数Transformer 897 0

Thinking Like Transformers 这篇论文中提出了 transformer 类的计算框架,这个框架直接计算和模仿 Transform...

2023-03-08 标签:Transformer 794 0

Transformer的主要优点是它可以并行地处理输入序列中的所有位置,因此在训练和推理时都有着很好的效率。此外,Transformer没有使用循环结构...

2023-03-08 标签:TransformernlpChatGPT 844 0

如何让Transformer在征程5上跑得既快又好?以SwinT部署为例的优化探索

摘要:SwinT是目前视觉transformer模型中的典型代表,在常见视觉任务,如分类、检测、分割都有非常出色的表现。虽然在相同计算量的模型指标上,S...

2023-03-03 标签:gpu模型Transformer 979 0

之前的文章和大家详细的介绍了静态的词向量表示word2vec理论加实战,但是word2vec存在一个很大的问题,由于是静态词向量所以无法表示一词多义,对...

2023-02-28 标签:GPTELMOSTransformer 6.7万 0

ChatGPT 由 GPT-3.5 模型提供支持,与传统思路不同,它采用了一种半监督式的训练机器说话。这是它的创新所在,也是它的独到之处。 GPT...

2023-02-21 标签:TransformernlpChatGPT 575 0

GPT家族与BERT模型都是知名的NLP模型,都基于Transformer技术。GPT-1只有12个Transformer层,而到了GPT-3,则增加到96层。

2023-02-21 标签:TransformernlpChatGPT 2863 0

ChatGPT 是一种专注于对话生成的语言模型。它能够根据用户的文本输入,产生相应的智能回答。这个回答可以是简短的词语,也可以是长篇大论。其中GPT是G...

2023-02-21 标签:TransformerOpenAIChatGPT 3809 0

ChatGPT的计算逻辑来自于一个名为transformer的算法,它来源于2017年的一篇科研论文《Attention is all your nee...

2023-02-21 标签:AITransformerChatGPT 864 0

一般讲解transformer都会以机器翻译任务为例子讲解,机器翻译任务是指将一种语言转换得到另一种语言,例如英语翻译为中文任务。

2023-02-09 标签:计算机视觉cnnTransformer 746 0

利用Transformer和CNN 各自的优势以获得更好的分割性能

概述 在这篇论文中,提出了一种新的医学图像分割混合架构:PHTrans,它在主要构建块中并行混合 Transformer 和 CNN,分别从全局和局部特...

2022-11-05 标签:数据集cnnTransformer 6579 0

如何继续提升速度?降低计算精度是比较直接的方法。2017 年以来,fp16 混合精度技术 [2] 获得了广泛应用。在对模型效果无损的前提下,将模型训练和...

2022-11-01 标签:Transformer字节跳动 582 0

使用自适应条形采样和双分支Transformer的DA-Net

目前的视网膜血管分割方法根据输入类型大致分为 image-level 和 patches-level 方法,为了从这两种输入形式中受益,这篇文章引入了一...

本文探讨了普通视觉Transformer(ViT)用于语义分割的能力,并提出了SegViT。以前基于ViT的分割网络通常从ViT的输出中学习像素级表示。...

2022-10-31 标签:计算机视觉数据集Transformer 5166 0

编辑推荐厂商产品技术软件/工具OS/语言教程专题

| 电机控制 | DSP | 氮化镓 | 功率放大器 | ChatGPT | 自动驾驶 | TI | 瑞萨电子 |

| BLDC | PLC | 碳化硅 | 二极管 | OpenAI | 元宇宙 | 安森美 | ADI |

| 无刷电机 | FOC | IGBT | 逆变器 | 文心一言 | 5G | 英飞凌 | 罗姆 |

| 直流电机 | PID | MOSFET | 传感器 | 人工智能 | 物联网 | NXP | 赛灵思 |

| 步进电机 | SPWM | 充电桩 | IPM | 机器视觉 | 无人机 | 三菱电机 | ST |

| 伺服电机 | SVPWM | 光伏发电 | UPS | AR | 智能电网 | 国民技术 | Microchip |

| 开关电源 | 步进电机 | 无线充电 | LabVIEW | EMC | PLC | OLED | 单片机 |

| 5G | m2m | DSP | MCU | ASIC | CPU | ROM | DRAM |

| NB-IoT | LoRa | Zigbee | NFC | 蓝牙 | RFID | Wi-Fi | SIGFOX |

| Type-C | USB | 以太网 | 仿真器 | RISC | RAM | 寄存器 | GPU |

| 语音识别 | 万用表 | CPLD | 耦合 | 电路仿真 | 电容滤波 | 保护电路 | 看门狗 |

| CAN | CSI | DSI | DVI | Ethernet | HDMI | I2C | RS-485 |

| SDI | nas | DMA | HomeKit | 阈值电压 | UART | 机器学习 | TensorFlow |

| Arduino | BeagleBone | 树莓派 | STM32 | MSP430 | EFM32 | ARM mbed | EDA |

| 示波器 | LPC | imx8 | PSoC | Altium Designer | Allegro | Mentor | Pads |

| OrCAD | Cadence | AutoCAD | 华秋DFM | Keil | MATLAB | MPLAB | Quartus |

| C++ | Java | Python | JavaScript | node.js | RISC-V | verilog | Tensorflow |

| Android | iOS | linux | RTOS | FreeRTOS | LiteOS | RT-THread | uCOS |

| DuerOS | Brillo | Windows11 | HarmonyOS |