相比GPU和GPP,FPGA在满足深度学习的硬件需求上提供了具有吸引力的替代方案。凭借流水线并行计算的能力和高效的能耗,FPGA将在一般的深度学习应用中展现GPU和GPP所没有的独特优势。同时,算法

2016-07-28 12:16:38 7367

7367 NVIDIA CUDA 深度神经网络库(cuDNN)是一个 GPU 加速的深度神经网络基元库,能够以高度优化的方式实现标准例程(如前向和反向卷积、池化层、归一化和激活层)。

2022-07-23 11:04:34 1341

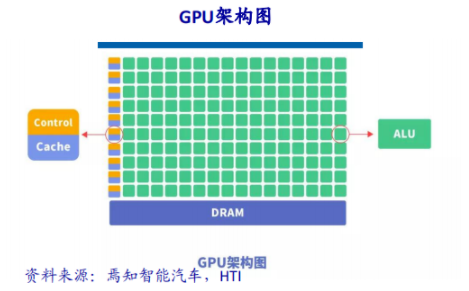

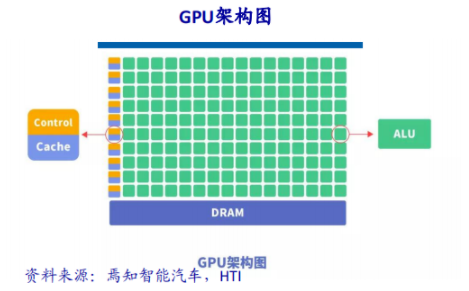

1341 随着由ChatGPT引发的人工智能热潮,GPU成为了AI大模型训练平台的基石,甚至是决定性的算力底座。为什么GPU能力压CPU,成为炙手可热的主角呢?要回答这个问题,首先需要了解当前人工智能(AI

2024-04-24 08:05:10 177

177

随着各个运营商网络的DC化网络重构,DC将成为主要载体,用于对云化网络资源的承载,提供计算存储和转发能力。 5G中传和回传光模块https://www.gigalight.com/cn

2019-12-12 17:36:16

,预计光模块需求上升。 4G网络是从RRU到BBU再到核心机房,到5G网络时代可能会把BBU功能做一些拆分,切分成DU和CU。原来RRU到BBU属于前传,BBU到核心机房属于回传,5G新增出中传

2019-11-07 17:23:35

的开发环境需求强烈。过去,安装驱动、编译库文件等软件集成工作费时费力,阿里云上的GPU计算平台联同NGC将为开发者节省大量准备开发环境的的时间。NGC可以帮助开发人员免费访问深度学习容器,包括

2018-04-04 14:39:24

、数据驱动决策以及人力成本节约,旨在深入剖析其核心优势和对企业的重要意义。一、自动化处理AI智能呼叫中心通过引入自然语言处理(NLP)、机器学习和自动化技术,使得呼叫中心的处理过程更加高效和准确,AI

2023-09-20 17:53:17

算法和大数据时代的到来、以及AI芯片的出现。 第三波AI浪潮的发展主要由深度学习技术的突破引领,而英伟达(Nvidia)凭借其通用的GPU单元,专门的TensorRT加速器,强劲的矩阵运算性能加上对其他

2018-06-11 08:20:23

装置」与「感测装置」成为不可或缺的一环。在AI模块中,处理芯片与储存系统之间的信道优化,将直接影响系统在实时判断与深度学习的效能,因此内存模块必须更重视客制化与稳定性等需求。目前就AI产业面观察,尤其

2017-12-05 08:09:38

%数据中心的工作量。平方GPU对培训工作量有效,但在人工智能的所有不同阶段都不需要GPU。在2021年的一项研究中,56%的研究受访者将成本列为他们面临的最重大挑战实施AI/ML解决方案。

2023-08-04 07:25:00

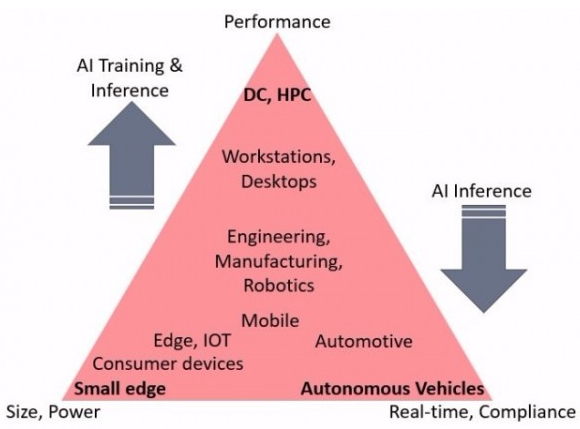

产生新需求,将带来高性能GPU市场快速增长。GPU分类与主要厂商,资料来源:架构师技术联盟、华西证券研究所云端AI服务器AI服务器通常搭载GPU、FPGA、ASIC等加速芯片,利用CPU与加速芯片的组合

2021-12-07 10:04:11

ai芯片和gpu的区别▌车载芯片的发展趋势(CPU-GPU-FPGA-ASIC)过去汽车电子芯片以与传感器一一对应的电子控制单元(ECU)为主,主要分布与发动机等核心部件上。...

2021-07-27 07:29:46

`光模块在现在的生活中应用很广,平时我们所用到的光网络传输中也离不开光模块的作用。光模块在生活中应用那么广泛,那么,光模块价格是多少钱?小编在上一篇文章中也有介绍到光模块有着多种类型(不明白的戳这里

2017-08-31 14:09:57

安装好光模块后,测试其性能是必不可少的步骤。当整个网络系统中的光器件是由一个供应商供应时,如果网络系统能够正常工作,那么就不需要对系统的子组件分别进行测试。但是,现在大部分网络系统中的子部件都来

2022-04-14 20:46:41

光模块是什么?光模块有着哪些分类呢?光模块的作用是什么?

2021-05-18 06:53:56

本文基于光模块标准和需求出发,介绍了TI多款小体积电源产品在光模块里的应用及其在光模块应用场景下的注意事项。1. 光模块简介光模块(Optical module)是光电和电光转换的光电子器件,见图1

2022-11-03 07:14:50

利用光复用器将不同波长的光信号复用至单根光纤进行传输,在链路的接收端,借助光解复用器将光纤中的混合信号分解为不同波长的信号,连接到相应的接收设备。在本文中,易飞扬通信将详细剖析10G粗波分复用CWDM

2018-03-27 14:58:14

,基于NCNN、MNN、Paddlelite多种常用端侧推理框架进行了接口的统一。图1 AI推理任务管理与统一推理接口架构图各模块介绍:任务安排:创建、任务、任务。框架调度:推理框架加载、卸载。算法引擎

2022-03-25 11:15:36

的“深度”层面源于输入层和输出层之间实现的隐含层数目,隐含层利用数学方法处理(筛选/卷积)各层之间的数据,从而得出最终结果。在视觉系统中,深度(vs.宽度)网络倾向于利用已识别的特征,通过构建更深的网络

2019-03-13 06:45:03

,支持广泛的应用程序和动态工作负载。本文将讨论这些行业挑战可以在不同级别的硬件和软件设计采用Xilinx VERSAL AI核心,业界首创自适应计算加速平台超越了CPU/GPU和FPGA的性能。

2020-11-01 09:28:57

TensorFlow&TensorFlow-GPU:深度学习框架TensorFlow&TensorFlow-GPU的简介、安装、使用方法详细攻略

2018-12-25 17:21:10

MI60与MI50加速器,为全球首款7奈米资料中心GPU,旨在满足新一代深度学习、高效能运算、云端运算以及渲染等应用所需的运算效能需求。研究人员、科学家以及开发者等将能够运用AMD Radeon

2018-11-20 11:35:12

C语言深度剖析

2017-08-25 09:08:28

C语言深度剖析[完整版].pdfC语言深度剖析[完整版].pdf (919.58 KB )

2019-03-19 05:11:41

C语言深度剖析——一本关于C语言学习的教程,里面包含C语言编写规范,各种变量指针用法等。以含金量勇敢挑战国内外同类书籍

2012-08-14 11:36:46

,以使得数据可以理解和处理。 数据分析通常依赖于机器学习(ML)算法。在ML算法中,深度卷积神经网络(DNN)为重要的图像分类任务提供了最先进的精度,并被广泛采用。 在最近

2017-04-27 14:10:12

硬件公司供货的不断增加,GPU 在深度学习中的市场需求还催生了大量公共云服务,这些服务为深度学习项目提供强大的 GPU 虚拟机。

但是显卡也受硬件和环境的限制。Larzul 解释说:“神经网络训练

2024-03-21 15:19:45

,这就转化为对训练系统高效扩展的日益增长的需求。

典型的深度学习训练算法包括多种类型的算子,这些算子加起来要进行数十亿次运算。这些大量的操作可以通过使用先进GPU提供的固有并行处理来加速。然而,GPU主要

2023-08-04 06:48:48

Mali GPU 支持tensorflow或者caffe等深度学习模型吗? 好像caffe2go和tensorflow lit可以部署到ARM,但不知道是否支持在GPU运行?我希望把训练

2022-09-16 14:13:01

,高度模块化,可扩展性)。 • 同时支持卷积神经网络和循环神经网络,以及两者的组合。• 在 CPU 和 GPU 上无缝运行。--摘自《Keras:基于-Python-的深度学习库》

2018-06-04 22:32:12

Tir-RK3399+movidius是什么呢?Tir-RK3399+movidius AI深度学习评估板有哪些性能呢?RK3399的板卡配置主要有哪几点呢?

2022-03-07 07:51:05

c语言深度剖析

2013-04-02 09:12:46

linux内核深度剖析,对于想学linux内核的人来说,绝对值得一看,另附有光盘资料。

2014-01-15 21:25:14

【嵌入式AI】多目标分类检测系统实战中,tengine是如何使用arm的GPU进行加速的,这个原理能详细说明一下吗?

2022-09-02 14:18:54

服务,基于系统软硬件结合方案,搭载华为云的云容器引擎CCE、GPU高性能计算、对象存储服务(OBS)、高性能网络等能力,并对分布式训练的调度算法、分布式梯度压缩等进行深度优化后,在1000块GPU的大规模集群中

2018-08-02 20:44:09

本帖最后由 zgzzlt 于 2012-8-16 14:23 编辑

《C语言深度剖析》【超经典书籍】

2012-08-02 08:59:42

,本周将会推出针对异构计算GPU实例GN5年付5折的优惠活动,希望能够打造良好的AI生态环境,帮助更多的人工智能企业以及项目顺利上云。随着深度学习对人工智能的巨大推动,深度学习所构建的多层神经网络模型

2017-12-26 11:22:09

的过程中,要留给大家自己体会的。第3章 深度学习简史从神经网络的神经元开始介绍感知机算法,主要是介绍深度学习一些主要概念背后的灵感,为深入了解他们的工作原理打下基础。左图是人类大脑的神经元,右图是感知器

2019-07-25 16:07:04

C语言深度剖析

2015-10-16 15:16:24

产生新需求,将带来高性能GPU市场快速增长。GPU分类与主要厂商,资料来源:架构师技术联盟、华西证券研究所云端AI服务器AI服务器通常搭载GPU、FPGA、ASIC等加速芯片,利用CPU与加速芯片的组合

2021-12-07 09:59:04

不断变化的,因此深度学习是人工智能AI的重要组成部分。可以说人脑视觉系统和神经网络。2、目标检测、目标跟踪、图像增强、强化学习、模型压缩、视频理解、人脸技术、三维视觉、SLAM、GAN、GNN等。

2020-11-27 11:54:42

了。下面介绍几种深度学习的方法,它们使识别错误率极大地降低。 卷积神经网络:AlexNet 在 2012 年,深度学习第一次被运用到 ImageNet 比赛中。其效果非常显著, 错误率从前一年的 26

2018-05-11 11:43:14

什么是光模块?光模块又有着哪些类型和参数?光模块又应用在哪些领域呢?

2021-05-18 06:10:08

什么是深度学习为了解释深度学习,有必要了解神经网络。神经网络是一种模拟人脑的神经元和神经网络的计算模型。作为具体示例,让我们考虑一个输入图像并识别图像中对象类别的示例。这个例子对应机器学习中的分类

2023-02-17 16:56:59

深度残差收缩网络是深度残差网络的一种新的升级版本,其实是深度残差网络、注意力机制(参照Squeeze-and-Excitation Network,SENet)和软阈值化的深度集成

2020-11-26 06:33:10

什么是CWDM光模块?CWDM光模块有哪些封装方式?CWDM光模块应用在什么地方?

2021-05-18 06:46:07

什么是SFP光模块?SFP光模块由哪些器件构成?SFP光模块有哪些分类?

2021-05-17 06:09:51

思维导图如下:发展历程DNN-定义和概念在卷积神经网络中,卷积操作和池化操作有机的堆叠在一起,一起组成了CNN的主干。同样是受到猕猴视网膜与视觉皮层之间多层网络的启发,深度神经网络架构架构应运而生,且

2018-05-08 15:57:47

电脑、智能手机等)上运行绘图运算工作的微处理器。因为对于处理图像数据来说,图像上的每一个像素点都有被处理的需要,这是一个相当大的数据,所以对于运算加速的需求图像处理领域最为强烈,GPU也就

2017-03-15 11:40:15

在光伏电站系统设计中,光伏组件的安装容量和逆变器的额定容量的比值即为容配比,是一个非常重要的设计参数。在2012年发布的《光伏发电系统效能标准》中,容配比是按1:1设计的,但是由于光照条件以及温度

2022-09-10 12:02:41

多用于SR等短距离的传输中,这类网络的节点和接头都比较多,使用多模光模块可以降低成本; 单模光模块多用于传输速率相对较高的线路中,如城域网。 此外,多模设备只能在多模光纤上有效运行,而单模设备在单模

2018-03-13 15:02:23

和流畅度。

声音模组:在人脸识别终端产品中,通常需要输出语音提示信息,以指导用户操作。因此,可以选择支持高保真音质、多种音频格式解码的声音模组,以提供优质的语音输出效果。

网络通信模组:为了实现人脸

2023-05-06 14:30:45

如何用stm32cube.ai简化人工神经网络映射?如何使用stm32cube.ai部署神经网络?

2021-10-11 08:05:42

本文由回映电子整理分享,欢迎工程老狮们参与学习与评论内容► 射频系统中的深度学习► Deepwave Digital技术► 信号检测和分类示例► GPU的实时DSP基准测试► 总结回映电子是一家

2022-01-05 10:00:58

本帖最后由 lee_st 于 2018-4-3 09:43 编辑

嵌入式网络那些事LwIP协议深度剖析与实战演练

2018-04-02 10:44:08

是人工智能大跃进的基础,在线下模型训练中Xeon-Phi、GPU等发挥着巨大的作用,而在线上的推理任务中,浪潮FPGA深度学习加速解决方案则能够实现7倍以上的能效比提升。 卷积网络之父、Facebook

2021-09-17 17:08:32

嵌入式应用可能的极限,嵌入式设计已经能够提高网络攻击的实时响应能力和设备安全性。支持AI的MCU云计算推动了对具有AI功能的MCU的需求;它减少了数据传输所需的带宽,并节省了云服务器的处理能力,如下图。配备AI算法的MCU正在应用包含对象识别,启用语音服务和自然语言处理等功能的应用程序..

2021-11-01 08:55:02

最先进的人工智能模型在不到五年的时间内经历了超过 5,000 倍的规模扩展。这些 AI 模型严重依赖复杂的计算和大量内存来实现高性能深度神经网络 (DNN)。只有使用 CPU、GPU 或专用芯片等

2023-07-28 10:10:17

最近在看labview中GPU模块的使用,但是GPU模块只有3个例子,难懂啊。有木有大神会的

2014-03-12 10:05:14

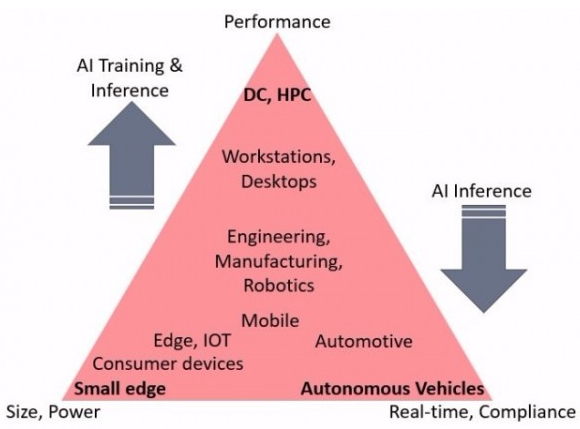

虽然人工智能和机器学习计算通常在数据中心中大规模地执行,但是最新的处理设备使得能够将AI / ML能力嵌入到网络边缘的IoT设备中。边缘的AI可以快速响应,无需等待云的响应。如果可以在本地完成推理

2019-05-29 10:38:09

有没有转让 嵌入式网络那些事lwip协议深度剖析与实战演练 这本书的呀?现在除了某宝能买到这本书(八成是盗版),其他网站都买不到了,我特别想看看这本书,求各位大神帮助~~

2019-08-18 21:19:32

嵌入式网络那些事LwIP协议深度剖析与实战演练

2016-06-12 13:43:17

自动驾驶车辆中的AI分析车辆中的AI应用

2021-03-09 07:53:23

明确了5G网络承载需求,明确指出25G/100G/400G光模块新需求将成为5G时代光通信的主流。那么国内有此资质的光模块厂商有哪些呢?公司主营业务备注光迅科技光器件国内光无源器件生产规模大,品种多

2020-03-05 14:13:28

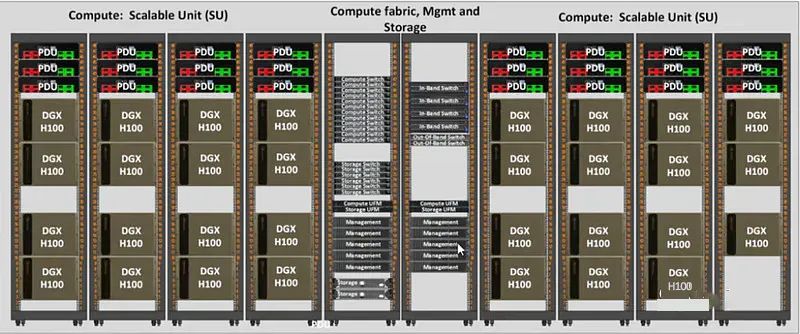

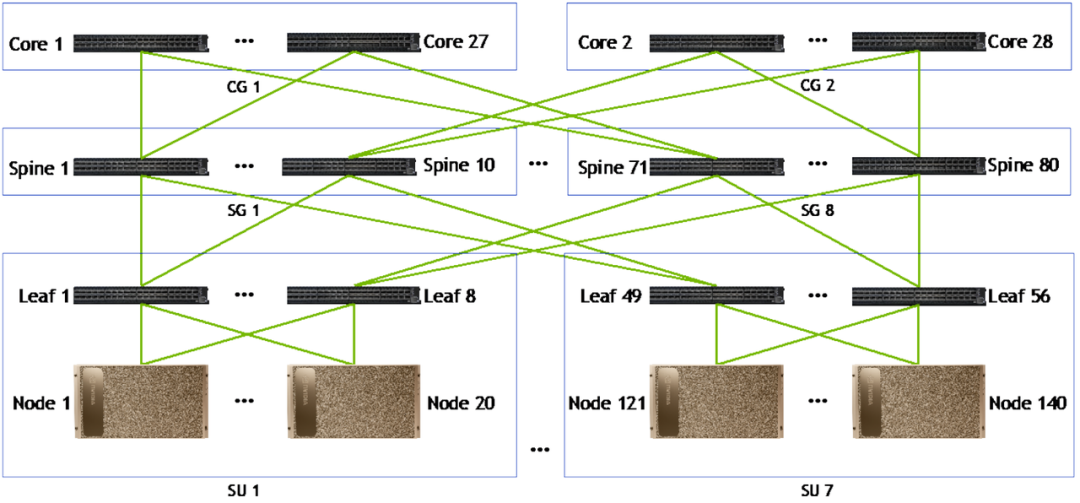

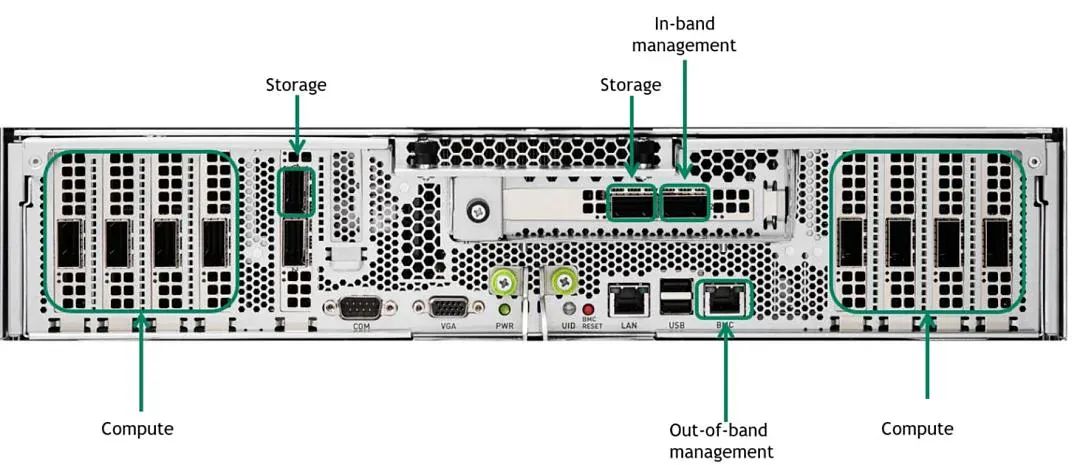

拷贝多份占用存储空间,也给网络管理和数据管理带来了复杂性;并且由于数据无法共享,无法支持整个GPU集群同时运行任务,降低了整个IT系统的使用效率。为了便于数据管理和共享,传统文件存储在AI系统中得到一定

2018-08-23 17:39:35

陈正冲编写的《C语言深度剖析》,挺经典,刚来论坛,多多指教~~

2013-08-17 12:06:03

考虑到POLA 模块电源的电路设计基本相同,本文以PTH03030 POLA 模块电路为例,对其电路设计进行了深度剖析。

2009-11-24 11:54:39 35

35 C语言深度剖析。

2016-05-05 17:40:59 7

7 GPU应用因AI开始有了截然不同的新转变,不只让一些支援高度平行运算应用的高阶GPU相继问世,现在连整套GPU深度学习专用服务器也抢滩登陆,要助企业加快AI应用。

2016-05-03 10:25:22 912

912 C语言深度剖析

2016-12-20 22:50:25 0

0 到只有有限硬件资源的嵌入式系统上。 为了解决这个限制,可以使用深度压缩来显著地减少神经网络所需要的计算和存储需求。例如对于具有全连接层的卷积神经网络(如Alexnet和VGGnet),深度压缩可以将模型大小减少35到49倍。

2017-11-16 13:11:35 1630

1630

那么到底多少层算深度呢?这个问题可能没有一个明确的答案。某种意义上,这个问题类似“有多少粒沙子才能算沙丘”。但是,一般而言,我们把有两层或两层以上隐藏层的网络叫做深度网络。相反,只有一个隐藏层的网络

2017-12-27 17:20:05 31000

31000

本文谈了谈gpu的一些重要的硬件组成,就深度学习而言,我觉得对内存的需求还是比较大的,core多也并不是能够全部用上,但现在开源的库实在完整,想做卷积运算有cudnn,想做卷积神经网络caffe

2018-01-06 12:01:09 3517

3517

针对深度神经网络在分布式多机多GPU上的加速训练问题,提出一种基于虚拟化的远程多GPU调用的实现方法。利用远程GPU调用部署的分布式GPU集群改进传统一对一的虚拟化技术,同时改变深度神经网络在分布式

2018-03-29 16:45:25 0

0 相比GPU和GPP,FPGA在满足深度学习的硬件需求上提供了具有吸引力的替代方案。凭借流水线并行计算的能力和高效的能耗,FPGA将在一般的深度学习应用中展现GPU和GPP所没有的独特优势。

2019-10-18 15:48:14 1337

1337 这些AI模型被运行在装载了V100Tensor Core GPU的NVIDIADGX系统上的数据中心服务器上,以及装载了JetsonAGX Xavier模块的边缘计算网络中。该硬件运行NVIDIA

2020-07-02 15:00:54 1831

1831 差不多的风扇,效率总会因这些因素而出现较大的差异。 深度剖析散热风扇 在笔记本散热模块的三要素中,散热风扇在很大程度上可以弥补热管和散热鳍片自身导热和散热效率的不足,而这也就是为什么硬件配置相同,散热风扇、热管

2020-08-27 10:41:30 7383

7383 目前,整个AI芯片市场都围绕着深度学习而展开。深度学习(DL),则正是让AI应用程序在现实世界中真正发挥作用的最成功的机器学习技术范例。

2020-08-13 10:46:40 2006

2006

这篇文章为大家介绍了一下面向低功耗AI芯片上的神经网络设计,随着这几年神经网络和硬件(CPU,GPU,FPGA,ASIC)的迅猛发展,深度学习在包...

2020-12-14 23:40:08 559

559 深度学习是推动当前人工智能大趋势的关键技术。在 MATLAB 中可以实现深度学习的数据准备、网络设计、训练和部署全流程开发和应用。联合高性能 NVIDIA GPU 加快深度神经网络训练和推断。

2022-02-18 13:31:44 1762

1762 相信每一位录友都接触过时间复杂度,但又对时间复杂度的认识处于一种朦胧的状态,所以是时候对时间复杂度来一个深度的剖析了。

2022-03-18 10:18:51 1589

1589 三维图形是 GPU 拥有如此大的内存和计算能力的根本原因,它与 深度神经网络 有一个共同之处:都需要进行大量矩阵运算。

2022-08-06 15:56:02 649

649 汽车新热点:T-BOX系统解决方案深度剖析之接口

2022-11-01 08:26:21 5

5 汽车新热点: T-BOX系统解决方案深度剖析之电源轨

2022-11-01 08:26:22 2

2 GPU 引领的深度学习

2023-01-04 11:17:16 501

501 称重模块工作原理剖析

2022-03-11 13:22:34 1739

1739

GPU服务器相对CPU服务器来说是非常昂贵的,大约是美金和人民币汇率的差距(以8卡GPU服务器为例),而且在芯片紧缺的年代,GPU到货周期还比较长!面对资源昂贵、算力又是AI的发动机、AI业务又必须开展之间的矛盾,如何更好的利用和管理GPU资源就变得尤其关键。下面一起来看看这五大典型场景。

2023-06-25 11:31:36 1157

1157

AI芯片在处理大规模数据和复杂计算任务(例如深度学习算法)时具有更高的计算性能。它们通常集成了多个高性能的计算单元,如GPU(图形处理器)或专门的神经网络处理器(NPU)。

2023-08-05 16:11:02 4807

4807

,AI芯片是专门为人工智能而设计的,它在处理神经网络和深度学习方面更加高效。而GPU芯片则是为了更好地处理图像和视频等方面而略微弱于AI芯片。 其次,AI芯片通常采用多核心硬件设计,这些核心之间可以并行工作,处理复杂的神经网络,并且更加灵

2023-08-08 18:02:28 4084

4084 本文通过分析千兆光模块的技术特点和现在的网络需求,讨论了千兆光模块是否还能满足现代网络需求的问题。文章提出,在一些特定场合,千兆光模块仍然是一种可行的选择,但在面对更高速、更大容量的数据传输时,就需要选择更高速率光模块。

2023-10-09 10:04:26 225

225 万兆光模块在网络传输中发挥着重要的作用,但是随着未来网络需求的不断提升,它是否能够应对越来越高的需求呢?本文通过对万兆光模块与未来网络需求来分析。

2023-10-30 11:30:16 227

227

C语言深度剖析

2022-12-30 09:20:02 5

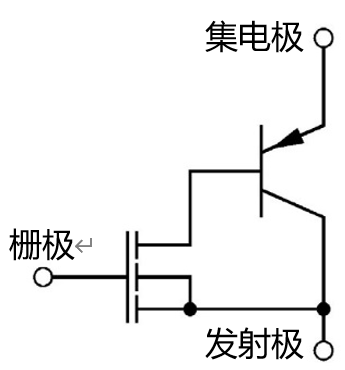

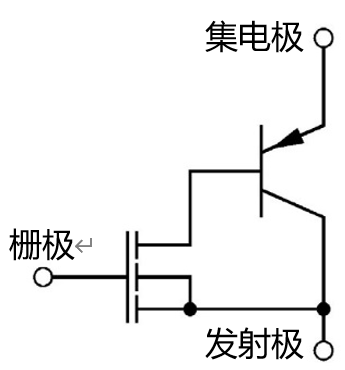

5 深度剖析 IGBT 栅极驱动注意事项

2023-11-24 14:48:25 299

299

人工智能的飞速发展,深度学习作为其重要分支,正在推动着诸多领域的创新。在这个过程中,GPU扮演着不可或缺的角色。就像超级英雄电影中的主角一样,GPU在深度学习中拥有举足轻重的地位。那么,GPU在深度

2023-12-06 08:27:37 705

705

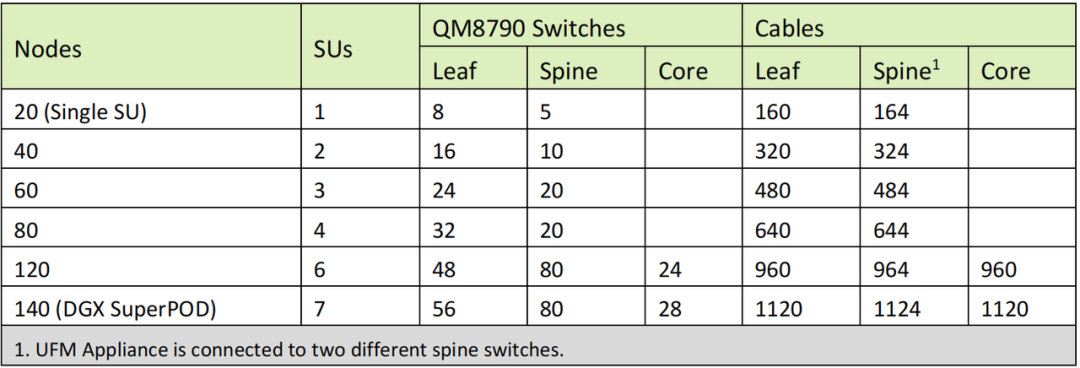

以传统三层架构到叶脊架构的转变为例,叶脊网络架构下,光模块数量提升最高可达到数十倍。

2024-04-01 10:09:47 133

133

为AI PC元年。 不仅是AI PC,还包括AI服务器、AI手机、AI汽车等,众多AI实际应用让算力GPU的需求大增,也在不断追求性能更高的GPU。而随着GPU性能的提升,其功耗与稳定性的难度也随之增加。这就需要电源管理在背后为其提供稳定的电力供应,让GPU提供更好的AI算力支持

2024-03-30 00:12:00 3033

3033

电子发烧友App

电子发烧友App

评论