文本分类是NLP领域的较为容易的入门问题,本文记录文本分类任务的基本流程,大部分操作使用了torch和torchtext两个库。

1. 文本数据预处理

首先数据存储在三个csv文件中,分别是train.csv,valid.csv,test.csv,第一列存储的是文本数据,例如情感分类问题经常是用户的评论 review ,例如imdb或者amazon数据集。第二列是情感极性 polarity ,N分类问题的话就有N个值,假设值的范围是0~N-1。

下面是很常见的文本预处理流程,英文文本的话不需要分词,直接按空格split就行了,这里只会主要说说第4点。

1.去除非文本部分

2.分词

3.去除停用词

4.对英文单词进行 词干提取 (stemming)和 词型还原 (lemmatization)

5.转为小写

6.特征处理

•Bag of Words•Tf-idf•N-gram•Word2vec词干提取和词型还原

from nltk.stem import SnowballStemmer

stemmer = SnowballStemmer("english") # 选择语言

from nltk.stem import WordNetLemmatizer

wnl = WordNetLemmatizer()

SnowballStemmer较为激进,转换有可能出现错误,这里较为推荐使用WordNetLemmatizer,它一般只在非常肯定的情况下才进行转换,否则会返回原来的单词。

stemmer.stem('knives')

# knive

wnl.lemmatize('knives')

# knife

因为我没有系统学习和研究过NLTK的代码,所以就不在这里展开说了,有兴趣的可以自己去看NLTK源代码。

2. 使用torchtext加载文本数据

本节主要是用的模块是torchtext里的data模块,处理的数据同上一节所描述。

首先定义一个tokenizer用来处理文本,比如分词,小写化,如果你已经根据上一节的词干提取和词型还原的方法处理过文本里的每一个单词后可以直接分词就够了。

tokenize = lambda x: x.split()

或者也可以更保险点,使用spacy库,不过就肯定更耗费时间了。

import spacy

spacy_en = spacy.load('en')

def tokenizer(text):

return [toke.text for toke in spacy_en.tokenizer(text)]

然后要定义 Field ,至于Field是啥,你可以简单地把它理解为一个能够加载、预处理和存储文本数据和标签的对象。我们可以用它根据训练数据来建立词表,加载预训练的Glove词向量等等。

def DataLoader():

tokenize = lambda x: x.split()

# 用户评论,include_lengths设为True是为了方便之后使用torch的pack_padded_sequence

REVIEW = data.Field(sequential=True,tokenize=tokenize, include_lengths=True)

# 情感极性

POLARITY = data.LabelField(sequential=False, use_vocab=False, dtype = torch.long)

# 假如train.csv文件并不是只有两列,比如1、3列是review和polarity,2列是我们不需要的数据,

# 那么就要添加一个全是None的元组, fields列表存储的Field的顺序必须和csv文件中每一列的顺序对应,

# 否则review可能就加载到polarity Field里去了

fields = [('review', REVIEW), (None, None), ('polarity', POLARITY)]

# 加载train,valid,test数据

train_data, valid_data, test_data = data.TabularDataset.splits(

path = 'amazon',

train = 'train.csv',

validation = 'valid.csv',

test = 'test.csv',

format = 'csv',

fields = fields,

skip_header = False # 是否跳过文件的第一行

)

return REVIEW, POLARITY, train_data

加载完数据可以开始建词表。如果本地没有预训练的词向量文件,在运行下面的代码时会自动下载到当前文件夹下的'.vector_cache'文件夹内,如果本地已经下好了,可以用Vectors指定文件名name,路径cache,还可以使用Glove。

from torchtext.vocab import Vectors, Glove

import torch

REVIEW, POLARITY, train_data = DataLoader()

# vectors = Vectors(name='glove.6B.300d.txt', cache='.vector_cache')

REVIEW.build_vocab(train_data, # 建词表是用训练集建,不要用验证集和测试集

max_size=400000, # 单词表容量

vectors='glove.6B.300d', # 还有'glove.840B.300d'已经很多可以选

unk_init=torch.Tensor.normal_ # 初始化train_data中不存在预训练词向量词表中的单词

)

# print(REVIEW.vocab.freqs.most_common(20)) 数据集里最常出现的20个单词

# print(REVIEW.vocab.itos[:10]) 列表 index to word

# print(REVIEW.vocab.stoi) 字典 word to index

接着就是把预训练词向量加载到model的embedding weight里去了。

pretrained_embeddings = REVIEW.vocab.vectors

model.embedding.weight.data.copy_(pretrained_embeddings)

UNK_IDX = REVIEW.vocab.stoi[REVIEW.unk_token]

PAD_IDX = REVIEW.vocab.stoi[REVIEW.pad_token]

# 因为预训练的权重的unk和pad的词向量不是在我们的数据集语料上训练得到的,所以最好置零

model.embedding.weight.data[UNK_IDX] = torch.zeros(EMBEDDING_DIM)

model.embedding.weight.data[PAD_IDX] = torch.zeros(EMBEDDING_DIM)

然后用torchtext的迭代器来批量加载数据,torchtext.data里的BucketIterator非常好用,它可以把长度相近的文本数据尽量都放到一个batch里,这样最大程度地减少padding,数据就少了很多无意义的0,也减少了矩阵计算量,也许还能对最终准确度有帮助(误)?

sort_within_batch设为True的话,一个batch内的数据就会按sort_key的排列规则降序排列,sort_key是排列的规则,这里使用的是review的长度,即每条用户评论所包含的单词数量。

train_iterator, valid_iterator, test_iterator = data.BucketIterator.splits(

(train_data, valid_data, test_data),

batch_size=32,

sort_within_batch=True,

sort_key = lambda x:len(x.review),

device=torch.device('cpu'))

最后就是加载数据喂给模型了。

for batch in train_iterator:

# 因为REVIEW Field的inclue_lengths为True,所以还会包含一个句子长度的Tensor

review, review_len = batch.review

# review.size = (seq_length, batch_size) , review_len.size = (batch_size, )

polarity = batch.polarity

# polarity.size = (batch_size, )

predictions = model(review, review_lengths)

loss = criterion(predictions, polarity) # criterion = nn.CrossEntropyLoss()

3. 使用pytorch写一个LSTM情感分类器

下面是我简略写的一个模型,仅供参考

import torch.nn as nn

import torch.nn.functional as F

from torch.nn.utils.rnn import pack_padded_sequence

import torch

class LSTM(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim, output_dim,

n_layers, bidirectional, dropout, pad_idx):

super(LSTM, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim, padding_idx=pad_idx)

self.lstm = nn.LSTM(embedding_dim, hidden_dim, num_layers=n_layers,

bidirectional=bidirectional, dropout=dropout)

self.Ws = nn.Parameter(torch.Tensor(hidden_dim, output_dim))

self.bs = nn.Parameter(torch.zeros((output_dim, )))

nn.init.uniform_(self.Ws, -0.1, 0.1)

nn.init.uniform_(self.bs, -0.1, 0.1)

self.dropout = nn.Dropout(p=0.5)

def forward(self, x, x_len):

x = self.embedding(x)

x = pack_padded_sequence(x, x_len)

H, (h_n, c_n) = self.lstm(x)

h_n = self.dropout(h_n)

h_n = torch.squeeze(h_n)

res = torch.matmul(h_n, self.Ws) + self.bs

y = F.softmax(res, dim=1)

# y.size(batch_size, output_dim)

return y

训练函数

def train(model, iterator, optimizer, criterion):

epoch_loss = 0

num_sample = 0

correct = 0

model.train()

for batch in iterator:

optimizer.zero_grad()

review, review_lengths = batch.review

polarity = batch.polarity

predictions = model(review, review_lengths)

correct += torch.sum(torch.argmax(preds, dim=1) == polarity)

loss = criterion(predictions, polarity)

loss.backward()

epoch_loss += loss.item()

num_sample += len(batch)

optimizer.step()

return epoch_loss / num_sample, correct.float() / num_sample

if __name__ == '__main__':

for epoch in range(N_EPOCHS):

train_loss, acc = train(model, train_iter, optimizer, criterion)

print(f'\\tTrain Loss: {train_loss:.3f} | Train Acc: {acc* 100:.2f}%')

4. 注意事项和遇到的一些坑

1.文本情感分类需不需要去除停用词?

•应该是不用的,否则acc有可能下降。

2.data.TabularDataset.splits虽然好用,但是如果你只想加载训练集,这时候如果直接不给validation和test参数赋值,那么其他代码和原来一样,比如这样

train_data = data.TabularDataset.splits(

path = '',

train = 'train.csv',

format = 'csv',

fields = fields,

skip_header = False # 是否跳过文件的第一行

)

那么底下你一定会报错,因为data.TabularDataset.splits返回的是一个元组,也就是如果是训练验证测试三个文件都给了函数,就返回(train_data, valid_data, test_data),这时候你用三个变量去接受函数返回值当然没问题,元组会自动拆包。

当只给函数一个文件train.csv时,函数返回的是(train_data)而非train_data,因此正确的写法应该如下

train_data = data.TabularDataset.splits(

path = '',

train = 'train.csv',

format = 'csv',

fields = fields,

skip_header = False # 是否跳过文件的第一行

)[0] # 注意这里的切片,选择元组的第一个也是唯一一个元素赋给train_data

3.同理data.BucketIterator.splits也有相同的问题,它不但返回的是元组,它的参数datasets要求也是以元组形式,即(train_data, valid_data, test_data)进行赋值,否则在下面的运行中也会出现各种各样奇怪的问题。

如果你要生成两个及以上的迭代器,那么没问题,直接照上面写就完事了。

如果你只要生成train_iterator,那么正确的写法应该是下面这样

train_iter = data.BucketIterator(

train_data,

batch_size=32,

sort_key=lambda x:len(x.review),

sort_within_batch=True,

shuffle=True # 训练集需要shuffle,但因为验证测试集不需要

# 可以生成验证和测试集的迭代器直接用data.iterator.Iterator类就足够了

)

4.出现的问题 x = pack_padded_sequence(x, x_len) 当数据集有长度为0的句子时, 就会后面报错

5.当vocab size较大而训练数据不多的情况下,我在实验时发现Adagrad效果比Adam好,如果数据较多,可以尝试使用RMSProp和Adam

5. 总结

不仅仅是NLP领域,在各大顶会中,越来越多的学者选择使用Pytorch而非TensorFlow,主要原因就是因为它的易用性,torchtext和pytorch搭配起来是非常方便的NLP工具,可以大大缩短文本预处理,加载数据的时间。

我本人之前用过tf 1.x以及keras,最终拥抱了Pytorch,也是因为它与Numpy极其类似的用法,更Pythonic的代码,清晰的源码让我在遇到bug时能一步一步找到问题所在,动态图让人能随时看到输出的Tensor的全部信息,这些都是Pytorch的优势。

现在tf 2.0也在不断改进,有人称tf越来越像pytorch了,其实pytorch也在不断向tf学习,在工业界,tf仍然处于王者地位,不知道未来pytorch能不能在工业界也与tf平分秋色,甚至更胜一筹呢?

-

数据预处理

+关注

关注

1文章

20浏览量

2852 -

nlp

+关注

关注

1文章

490浏览量

22440 -

pytorch

+关注

关注

2文章

809浏览量

13715

发布评论请先 登录

pyhanlp文本分类与情感分析

NLPIR平台在文本分类方面的技术解析

基于文章标题信息的汉语自动文本分类

textCNN论文与原理——短文本分类

文本分类的一个大型“真香现场”来了

基于深度神经网络的文本分类分析

融合文本分类和摘要的多任务学习摘要模型

基于不同神经网络的文本分类方法研究对比

基于双通道词向量的卷积胶囊网络文本分类算法

基于LSTM的表示学习-文本分类模型

带你从头构建文本分类器

卷积神经网络在文本分类领域的应用

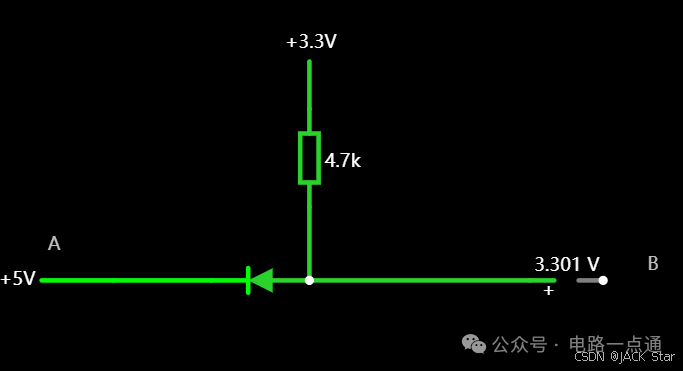

有几种电平转换电路,适用于不同的场景

一.起因一般在消费电路的元器件之间,不同的器件IO的电压是不同的,常规的有5V,3.3V,1.8V等。当器件的IO电压一样的时候,比如都是5V,都是3.3V,那么其之间可以直接通讯,比如拉中断,I2Cdata/clk脚双方直接通讯等。当器件的IO电压不一样的时候,就需要进行电平转换,不然无法实现高低电平的变化。二.电平转换电路常见的有几种电平转换电路,适用于

瑞萨RA8系列教程 | 基于 RASC 生成 Keil 工程

对于不习惯用 e2 studio 进行开发的同学,可以借助 RASC 生成 Keil 工程,然后在 Keil 环境下愉快的完成开发任务。

共赴之约 | 第二十七届中国北京国际科技产业博览会圆满落幕

作为第二十七届北京科博会的参展方,芯佰微有幸与800余家全球科技同仁共赴「科技引领创享未来」之约!文章来源:北京贸促5月11日下午,第二十七届中国北京国际科技产业博览会圆满落幕。本届北京科博会主题为“科技引领创享未来”,由北京市人民政府主办,北京市贸促会,北京市科委、中关村管委会,北京市经济和信息化局,北京市知识产权局和北辰集团共同承办。5万平方米的展览云集

道生物联与巍泰技术联合发布 RTK 无线定位系统:TurMass™ 技术与厘米级高精度定位的深度融合

道生物联与巍泰技术联合推出全新一代 RTK 无线定位系统——WTS-100(V3.0 RTK)。该系统以巍泰技术自主研发的 RTK(实时动态载波相位差分)高精度定位技术为核心,深度融合道生物联国产新兴窄带高并发 TurMass™ 无线通信技术,为室外大规模定位场景提供厘米级高精度、广覆盖、高并发、低功耗、低成本的一站式解决方案,助力行业智能化升级。

智能家居中的清凉“智”选,310V无刷吊扇驱动方案--其利天下

炎炎夏日,如何营造出清凉、舒适且节能的室内环境成为了大众关注的焦点。吊扇作为一种经典的家用电器,以其大风量、长寿命、低能耗等优势,依然是众多家庭的首选。而随着智能控制技术与无刷电机技术的不断进步,吊扇正朝着智能化、高效化、低噪化的方向发展。那么接下来小编将结合目前市面上的指标,详细为大家讲解其利天下有限公司推出的无刷吊扇驱动方案。▲其利天下无刷吊扇驱动方案一

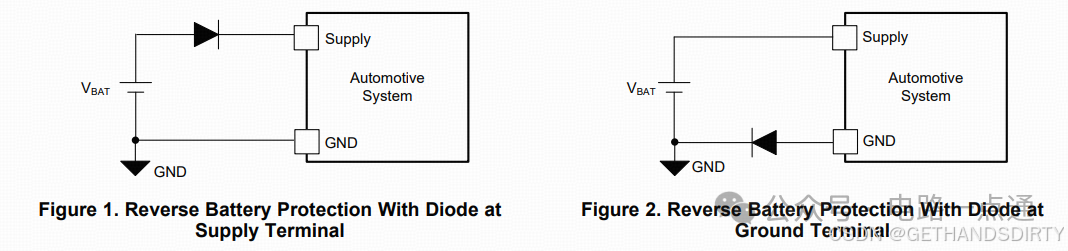

电源入口处防反接电路-汽车电子硬件电路设计

一、为什么要设计防反接电路电源入口处接线及线束制作一般人为操作,有正极和负极接反的可能性,可能会损坏电源和负载电路;汽车电子产品电性能测试标准ISO16750-2的4.7节包含了电压极性反接测试,汽车电子产品须通过该项测试。二、防反接电路设计1.基础版:二极管串联二极管是最简单的防反接电路,因为电源有电源路径(即正极)和返回路径(即负极,GND),那么用二极

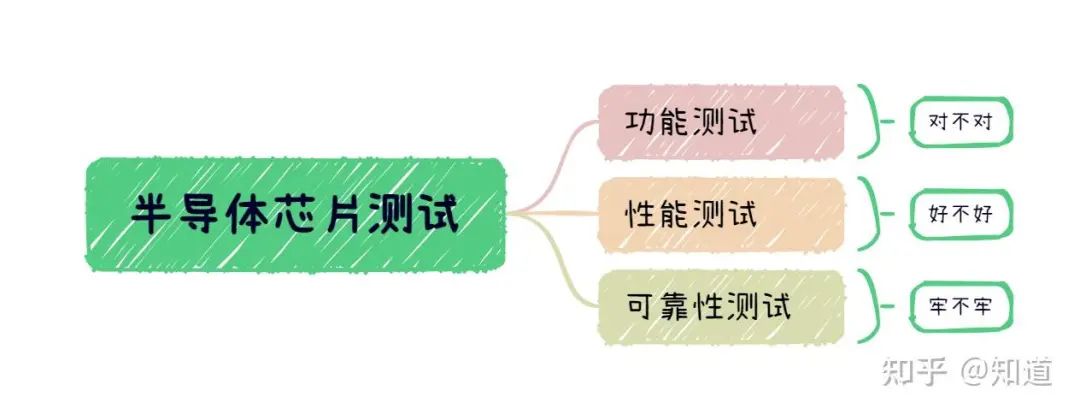

半导体芯片需要做哪些测试

首先我们需要了解芯片制造环节做⼀款芯片最基本的环节是设计->流片->封装->测试,芯片成本构成⼀般为人力成本20%,流片40%,封装35%,测试5%(对于先进工艺,流片成本可能超过60%)。测试其实是芯片各个环节中最“便宜”的一步,在这个每家公司都喊着“CostDown”的激烈市场中,人力成本逐年攀升,晶圆厂和封装厂都在乙方市场中“叱咤风云”,唯独只有测试显

解决方案 | 芯佰微赋能示波器:高速ADC、USB控制器和RS232芯片——高性能示波器的秘密武器!

示波器解决方案总述:示波器是电子技术领域中不可或缺的精密测量仪器,通过直观的波形显示,将电信号随时间的变化转化为可视化图形,使复杂的电子现象变得清晰易懂。无论是在科研探索、工业检测还是通信领域,示波器都发挥着不可替代的作用,帮助工程师和技术人员深入剖析电信号的细节,精准定位问题所在,为创新与发展提供坚实的技术支撑。一、技术瓶颈亟待突破性能指标受限:受模拟前端

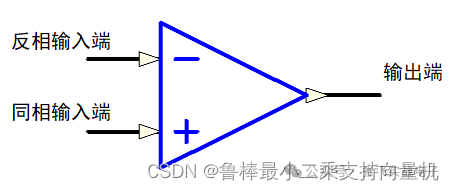

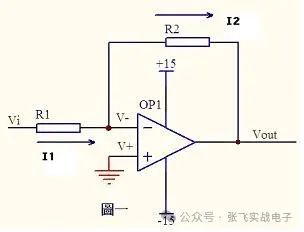

硬件设计基础----运算放大器

1什么是运算放大器运算放大器(运放)用于调节和放大模拟信号,运放是一个内含多级放大电路的集成器件,如图所示:左图为同相位,Vn端接地或稳定的电平,Vp端电平上升,则输出端Vo电平上升,Vp端电平下降,则输出端Vo电平下降;右图为反相位,Vp端接地或稳定的电平,Vn端电平上升,则输出端Vo电平下降,Vn端电平下降,则输出端Vo电平上升2运算放大器的性质理想运算

ElfBoard技术贴|如何调整eMMC存储分区

ELF 2开发板基于瑞芯微RK3588高性能处理器设计,拥有四核ARM Cortex-A76与四核ARM Cortex-A55的CPU架构,主频高达2.4GHz,内置6TOPS算力的NPU,这一设计让它能够轻松驾驭多种深度学习框架,高效处理各类复杂的AI任务。

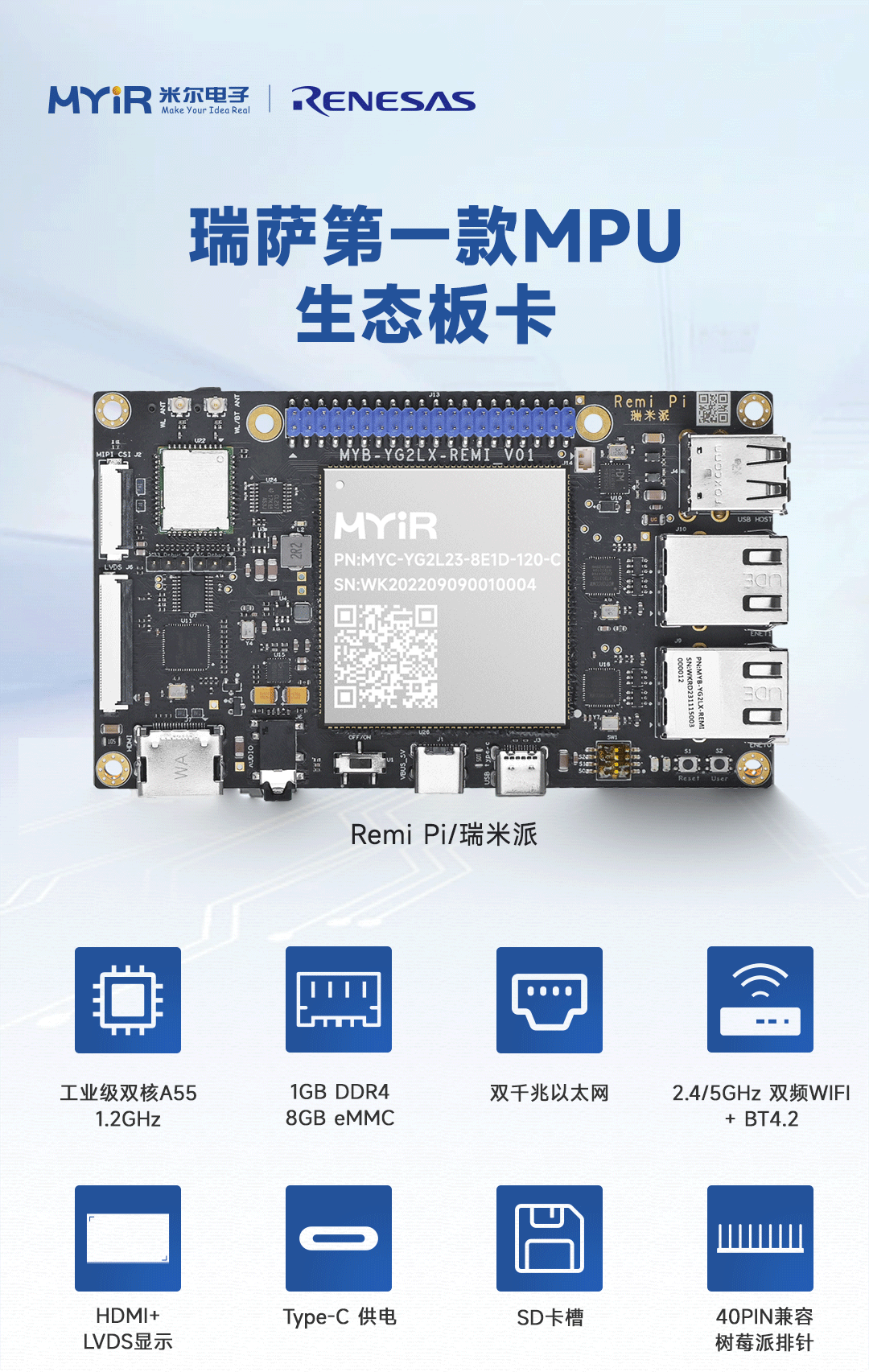

米尔基于MYD-YG2LX系统启动时间优化应用笔记

1.概述MYD-YG2LX采用瑞萨RZ/G2L作为核心处理器,该处理器搭载双核Cortex-A55@1.2GHz+Cortex-M33@200MHz处理器,其内部集成高性能3D加速引擎Mail-G31GPU(500MHz)和视频处理单元(支持H.264硬件编解码),16位的DDR4-1600/DDR3L-1333内存控制器、千兆以太网控制器、USB、CAN、

运放技术——基本电路分析

虚短和虚断的概念由于运放的电压放大倍数很大,一般通用型运算放大器的开环电压放大倍数都在80dB以上。而运放的输出电压是有限的,一般在10V~14V。因此运放的差模输入电压不足1mV,两输入端近似等电位,相当于“短路”。开环电压放大倍数越大,两输入端的电位越接近相等。“虚短”是指在分析运算放大器处于线性状态时,可把两输入端视为等电位,这一特性称为虚假短路,简称

飞凌嵌入式携手中移物联,谱写全国产化方案新生态

4月22日,飞凌嵌入式“2025嵌入式及边缘AI技术论坛”在深圳成功举办。中移物联网有限公司(以下简称“中移物联”)携OneOS操作系统与飞凌嵌入式共同推出的工业级核心板亮相会议展区,操作系统产品部高级专家严镭受邀作《OneOS工业操作系统——助力国产化智能制造》主题演讲。

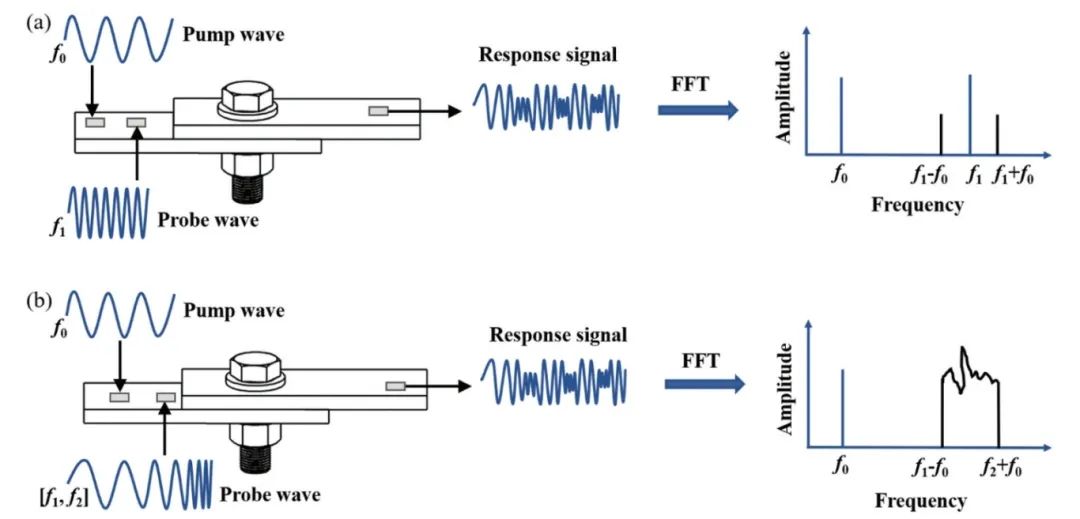

ATA-2022B高压放大器在螺栓松动检测中的应用

实验名称:ATA-2022B高压放大器在螺栓松动检测中的应用实验方向:超声检测实验设备:ATA-2022B高压放大器、函数信号发生器,压电陶瓷片,数据采集卡,示波器,PC等实验内容:本研究基于振动声调制的螺栓松动检测方法,其中低频泵浦波采用单频信号,而高频探测波采用扫频信号,利用泵浦波和探测波在接触面的振动声调制响应对螺栓的松动程度进行检测。通过螺栓松动检测

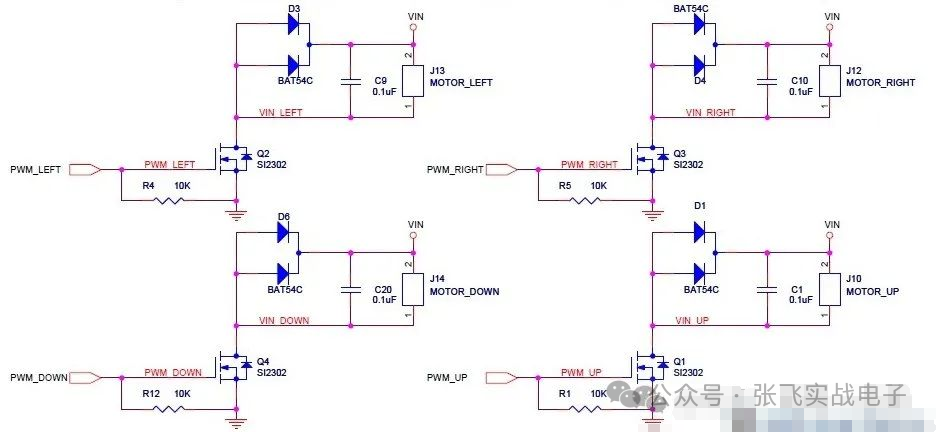

MOS管驱动电路——电机干扰与防护处理

此电路分主电路(完成功能)和保护功能电路。MOS管驱动相关知识:1、跟双极性晶体管相比,一般认为使MOS管导通不需要电流,只要GS电压(Vbe类似)高于一定的值,就可以了。MOS管和晶体管向比较c,b,e—–>d(漏),g(栅),s(源)。2、NMOS的特性,Vgs大于一定的值就会导通,适合用于源极接地时的情况(低端驱动),只要栅极电压达到4V或10V就可以

PyTorch文本分类任务的基本流程

PyTorch文本分类任务的基本流程

评论