刚落幕的LiveVideoStackCon 2018音视频技术大会上,Akamai媒体业务群首席架构师William Law通过主题演讲介绍了如何通过分块编码和分块传输CMAF,为观众提供极低延迟的视频直播服务。本文由Akamai整理,并授权LiveVideoStack发布。

对于当今年轻人,电视早已没什么吸引力,大家更喜欢通过网络追剧、看比赛,甚至看各种直播内容。那么延迟到底会有多重要?为什么要强调低延迟?

假设你和邻居都在自己家看足球赛,邻居看电视直播,你看网络直播。邻居那边已经在为进球欢呼,你这边因为延迟,球员才准备起脚射门……你说低延迟重不重要。

面对数量激增的用户和复杂的网络环境,如何为观众提供更流畅的播放体验,并且对直播类节目提供低延迟快速高效的内容交付,已成为很多视频平台最关心,并且投入最多资源进行改善的领域之一。

那么「分块编码」和「分块传输」的「CMAF」到底是什么?

CMAF,一种全新的「容器」格式

随着HTTP自适应流媒体(HAS)技术的发展,视频直播观众对OTT质量和延迟提出了更高要求,甚至堪比传统广播电视节目。然而业内通常认为,HAS交付内容不可避免会遇到端到端延迟,甚至可能长达视频片段时长的数倍,自然无法比拟广播电视效果。但这种观点已经站不住脚了,现在已经有HAS解决方案能将这种端到端延迟降低到远低于一个片段时长的程度,甚至可以让整体延迟与片段时长完全无关,这个解决方案就是超低延迟CMAF(ULL-CMAF)。

CMFA(Common Media Application Format,通用媒体应用程序格式)由标准化组织MPEG在2017年正式颁布,这种格式定义了一种碎片化的MP4容器,其中可以封装视频、音频及文本数据。该格式最大的特点在于,能高效地让HLS播放列表同时引用多个媒体片段和DASH清单,同时还在DASH ATSC3广播配置文件的继承方面实现了很多优势,有助于进一步降低延迟。

但简单来说,只使用CMAF片段还不足以降低延迟,CMAF容器还必须与编码器、CDN以及客户端行为完全匹配,在整个系统范围内实现低延迟。

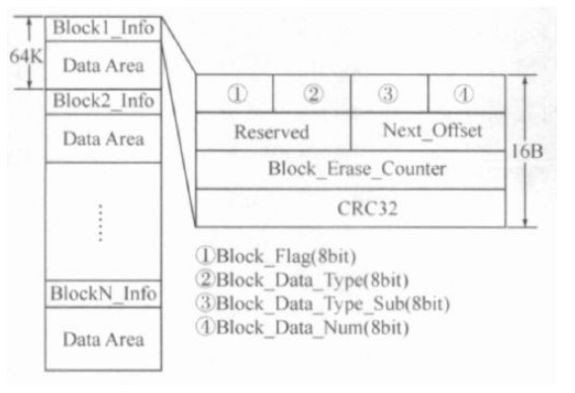

图1:CMAF的对象命名

分块编码,化整为零提效率

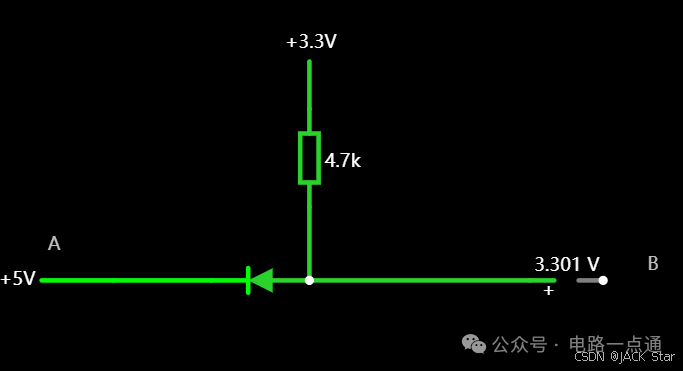

降低延迟的第一步是分块编码。按照MPEG CMAF标准,CMAF轨道由多个对象组成,如图1所示。「块」是最小的可引用单位,其中至少包含一个moof 和一个mdat原子(Atom)。一个或多个块组合在一起形成一个片段,而一个或多个片段还可进一步组合成一个片段。

标准的CMAF媒体片段将使用一个moof 和一个mdat 原子进行编码,如图2所示。其中mdat还包含一个IDR(Instantaneous Decoder Refresh,瞬时解码器刷新)帧,每个片段开头都会有。

图2:CMAF段的分块编码

虽然每个「分块编码」片段会包含一系列「块」,即多个moof/mdat 元(Tuple)组成的序列,如图2所示,但只有第一个元具备IDR帧。将片段分解为更短的碎片,这样做好处在于编码器能在编码完成后立即输出每个块。块数量相同的情况下,这种「提前」输出的做法可显著降低整体延迟。

分块传输,合零为整降延迟

接下来需要考虑如何实现分块传输。

图3:HAS媒体分发系统

编码器会使用HTTP 1.1分块传输编码机制,将编码后的CMAF块推送至源位置。例如,对于一个产生4s 30fps片段的编码器,将每4秒发出一个HTTP POST请求(每个请求对应一个片段),在接下来的4秒里,共有120个块(每个块时长为33毫秒)构成一个完整的片段,并发送至源位置。但编码器并不会对每个单独的块发出一个POST请求。

接下来,这个块会通过拉取的方式到达播放器。播放器读取清单或播放列表,了解内容描述信息,随后计算希望开始播放的位置起点,并向对应片段发出请求。清单中必须列出片段数据的早期可用性。对于MPEG DASH,这是通过MPD@availabilityTimeOffset参数实现的。

图4:视频直播过程中,播放器的启动选项

我们可以用图4所示过程为例,演示播放器起始播放算法对整体延迟的影响。这是一个会产生2秒片段的直播编码器。图中可见,系统正处于产生片段5的过程中。对于不分块解决方案,为了尽可能降低延迟,必须从上一个完整可用片段(片段4)开始播放,这会导致整体延迟增加3秒。但如果使用每500毫秒(仅供示例,实际中分块时长远低于500毫秒)一个片段进行分块编码,播放器就可从包含IDR的上一个块(块5a)开始播放,此时延迟可降低至1秒。

此外,还有两种方法可以进一步降低延迟。首先,播放器可以下载块5a和块5,但在开始播放前就从块5a向前解码块5b,这样可将延迟降低至500毫秒以内。第二种方法,播放器可将播放过程延迟1秒,随后在块6a生成后立即发出请求,这样也可以降延迟降低到500毫秒以内。

ULL-CMAF前提要求总结

总的来说,只有在全部满足下列要求的情况下,才能通过ULL-CMAF获得稳定的低延迟交付:

CMAF片段中的内容是分块编码的;

编码器调整DASH清单/HLS播放列表,以适应并标注自己使用了分块编码的方式,并借此告知数据的早期可用性;

编码器使用HTTP 1.1分块编码传输机制将内容推送至源分发位置;

CDN在分发链上的每个环节,都使用HTTP分块编码传输机制传播内容,并最终到达客户端;

而客户端也需要全部满足下列要求:

对片段请求进行精确计时,并在一个片段的有效时长内请求所需片段;

在收到比特流后立即解码,而不要等待片段结束。浏览器中使用的HTML5播放器必须使用Fetch而非XHR API,因为Fetch可以在数据下载完成前立即读取响应的正文内容;

具有估算吞吐量的方案,因为此时无法使用标准的Segment-timing技术;

缓冲区和自适应逻辑必须能应对非常低的缓冲;

由于吞吐量波动,能够在滞后于现场的情况下立即「赶超」。

所以说了半天,这种技术的效果到底如何?亲自体验一下吧。请使用Google Chrome浏览器(其他浏览器可能无法支持)访问:

http://mediapm.edgesuite.net/will/dash/lowlatency/low-latency-public-example.html

该演示使用由开源FFmpeg生成的直播流,发布至Akamai Media Services liveOrigin™,并通过Akamai Media Delivery网络交付,在客户端使用开源播放器dash.js播放。视频流为AVC 720p编码,码率2Mbps,片段时长6秒,每1帧的块时长29.97fps,availabilityTimeOffset设置为5.967秒,延迟目标设置为2.8秒,视频流在美国波士顿进行编码。

-

解码器

+关注

关注

9文章

1162浏览量

41620 -

编码器

+关注

关注

45文章

3762浏览量

136840 -

编码

+关注

关注

6文章

965浏览量

55401

原文标题:William Law:CMAF如何支持的超低延迟视频直播

文章出处:【微信号:livevideostack,微信公众号:LiveVideoStack】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

采用分块管理和状态转换的嵌入式NOR Flash管理

labview数据分块

CC2540 数据分块处理怎么实现?

FPGA怎么对引脚进行分块?DDR3与FPGA的引脚连接

分块广义对角占优矩阵的条件

空间数据库的分块多级索引机制的研究

分块NSA在人脸识别上的应用

基于位串内容感知的数据分块算法

分块式空间望远镜波前探测与控制

如何通过CMAF提供海量并发的低延迟流媒体服务的

基于神经网络的循环程序分块大小预测

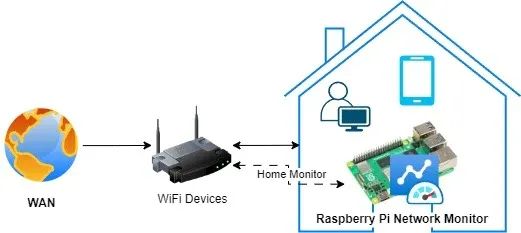

搭建树莓派网络监控系统:顶级工具与技术终极指南!

树莓派网络监控系统是一种经济高效且功能多样的解决方案,可用于监控网络性能、流量及整体运行状况。借助树莓派,我们可以搭建一个网络监控系统,实时洞察网络活动,从而帮助识别问题、优化性能并确保网络安全。安装树莓派网络监控系统有诸多益处。树莓派具备以太网接口,还内置了Wi-Fi功能,拥有足够的计算能力和内存,能够在Linux或Windows系统上运行。因此,那些为L

STM32驱动SD NAND(贴片式SD卡)全测试:GSR手环生物数据存储的擦写寿命与速度实测

在智能皮电手环及数据存储技术不断迭代的当下,主控 MCU STM32H750 与存储 SD NAND MKDV4GIL-AST 的强强联合,正引领行业进入全新发展阶段。二者凭借低功耗、高速读写与卓越稳定性的深度融合,以及高容量低成本的突出优势,成为大规模生产场景下极具竞争力的数据存储解决方案。

芯对话 | CBM16AD125Q这款ADC如何让我的性能翻倍?

综述在当今数字化时代,模数转换器(ADC)作为连接模拟世界与数字系统的关键桥梁,其技术发展对众多行业有着深远影响。从通信领域追求更高的数据传输速率与质量,到医疗影像领域渴望更精准的疾病诊断,再到工业控制领域需要适应复杂恶劣环境的稳定信号处理,ADC的性能提升成为推动这些行业进步的重要因素。行业现状分析在通信行业,5G乃至未来6G的发展,对基站信号处理提出了极

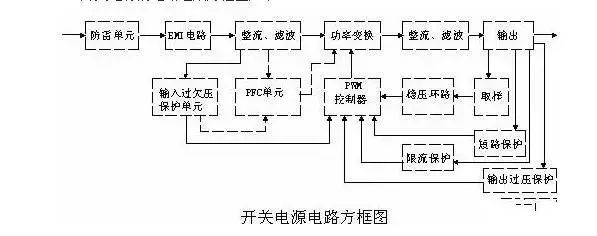

史上最全面解析:开关电源各功能电路

01开关电源的电路组成开关电源的主要电路是由输入电磁干扰滤波器(EMI)、整流滤波电路、功率变换电路、PWM控制器电路、输出整流滤波电路组成。辅助电路有输入过欠压保护电路、输出过欠压保护电路、输出过流保护电路、输出短路保护电路等。开关电源的电路组成方框图如下:02输入电路的原理及常见电路1AC输入整流滤波电路原理①防雷电路:当有雷击,产生高压经电网导入电源时

有几种电平转换电路,适用于不同的场景

一.起因一般在消费电路的元器件之间,不同的器件IO的电压是不同的,常规的有5V,3.3V,1.8V等。当器件的IO电压一样的时候,比如都是5V,都是3.3V,那么其之间可以直接通讯,比如拉中断,I2Cdata/clk脚双方直接通讯等。当器件的IO电压不一样的时候,就需要进行电平转换,不然无法实现高低电平的变化。二.电平转换电路常见的有几种电平转换电路,适用于

瑞萨RA8系列教程 | 基于 RASC 生成 Keil 工程

对于不习惯用 e2 studio 进行开发的同学,可以借助 RASC 生成 Keil 工程,然后在 Keil 环境下愉快的完成开发任务。

共赴之约 | 第二十七届中国北京国际科技产业博览会圆满落幕

作为第二十七届北京科博会的参展方,芯佰微有幸与800余家全球科技同仁共赴「科技引领创享未来」之约!文章来源:北京贸促5月11日下午,第二十七届中国北京国际科技产业博览会圆满落幕。本届北京科博会主题为“科技引领创享未来”,由北京市人民政府主办,北京市贸促会,北京市科委、中关村管委会,北京市经济和信息化局,北京市知识产权局和北辰集团共同承办。5万平方米的展览云集

道生物联与巍泰技术联合发布 RTK 无线定位系统:TurMass™ 技术与厘米级高精度定位的深度融合

道生物联与巍泰技术联合推出全新一代 RTK 无线定位系统——WTS-100(V3.0 RTK)。该系统以巍泰技术自主研发的 RTK(实时动态载波相位差分)高精度定位技术为核心,深度融合道生物联国产新兴窄带高并发 TurMass™ 无线通信技术,为室外大规模定位场景提供厘米级高精度、广覆盖、高并发、低功耗、低成本的一站式解决方案,助力行业智能化升级。

智能家居中的清凉“智”选,310V无刷吊扇驱动方案--其利天下

炎炎夏日,如何营造出清凉、舒适且节能的室内环境成为了大众关注的焦点。吊扇作为一种经典的家用电器,以其大风量、长寿命、低能耗等优势,依然是众多家庭的首选。而随着智能控制技术与无刷电机技术的不断进步,吊扇正朝着智能化、高效化、低噪化的方向发展。那么接下来小编将结合目前市面上的指标,详细为大家讲解其利天下有限公司推出的无刷吊扇驱动方案。▲其利天下无刷吊扇驱动方案一

电源入口处防反接电路-汽车电子硬件电路设计

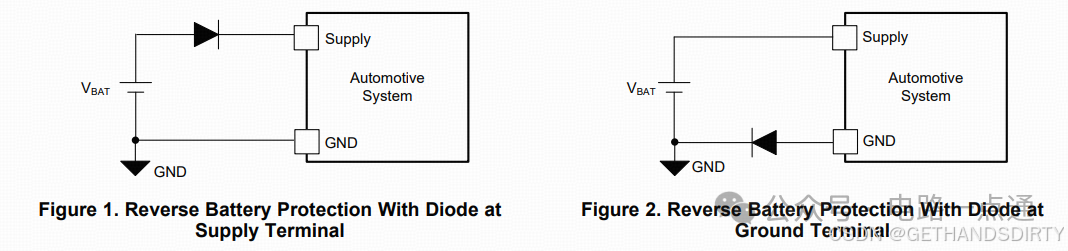

一、为什么要设计防反接电路电源入口处接线及线束制作一般人为操作,有正极和负极接反的可能性,可能会损坏电源和负载电路;汽车电子产品电性能测试标准ISO16750-2的4.7节包含了电压极性反接测试,汽车电子产品须通过该项测试。二、防反接电路设计1.基础版:二极管串联二极管是最简单的防反接电路,因为电源有电源路径(即正极)和返回路径(即负极,GND),那么用二极

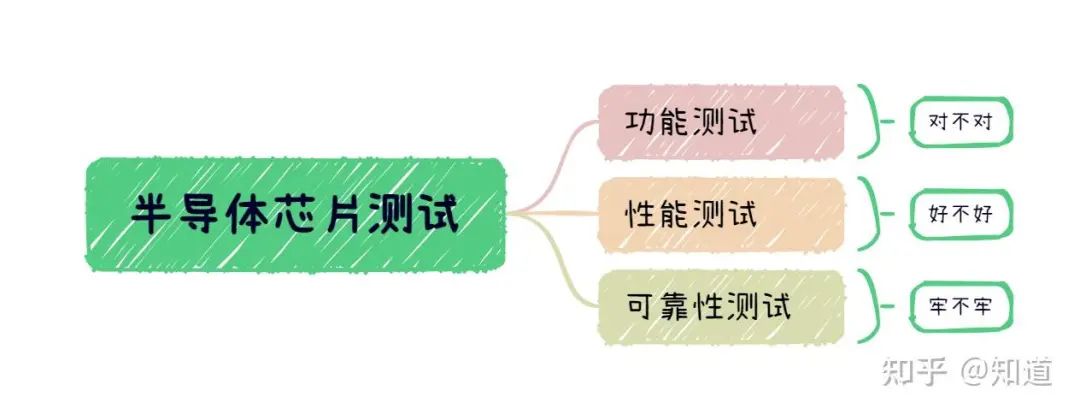

半导体芯片需要做哪些测试

首先我们需要了解芯片制造环节做⼀款芯片最基本的环节是设计->流片->封装->测试,芯片成本构成⼀般为人力成本20%,流片40%,封装35%,测试5%(对于先进工艺,流片成本可能超过60%)。测试其实是芯片各个环节中最“便宜”的一步,在这个每家公司都喊着“CostDown”的激烈市场中,人力成本逐年攀升,晶圆厂和封装厂都在乙方市场中“叱咤风云”,唯独只有测试显

解决方案 | 芯佰微赋能示波器:高速ADC、USB控制器和RS232芯片——高性能示波器的秘密武器!

示波器解决方案总述:示波器是电子技术领域中不可或缺的精密测量仪器,通过直观的波形显示,将电信号随时间的变化转化为可视化图形,使复杂的电子现象变得清晰易懂。无论是在科研探索、工业检测还是通信领域,示波器都发挥着不可替代的作用,帮助工程师和技术人员深入剖析电信号的细节,精准定位问题所在,为创新与发展提供坚实的技术支撑。一、技术瓶颈亟待突破性能指标受限:受模拟前端

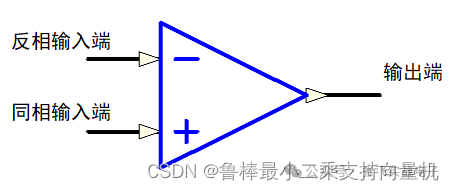

硬件设计基础----运算放大器

1什么是运算放大器运算放大器(运放)用于调节和放大模拟信号,运放是一个内含多级放大电路的集成器件,如图所示:左图为同相位,Vn端接地或稳定的电平,Vp端电平上升,则输出端Vo电平上升,Vp端电平下降,则输出端Vo电平下降;右图为反相位,Vp端接地或稳定的电平,Vn端电平上升,则输出端Vo电平下降,Vn端电平下降,则输出端Vo电平上升2运算放大器的性质理想运算

ElfBoard技术贴|如何调整eMMC存储分区

ELF 2开发板基于瑞芯微RK3588高性能处理器设计,拥有四核ARM Cortex-A76与四核ARM Cortex-A55的CPU架构,主频高达2.4GHz,内置6TOPS算力的NPU,这一设计让它能够轻松驾驭多种深度学习框架,高效处理各类复杂的AI任务。

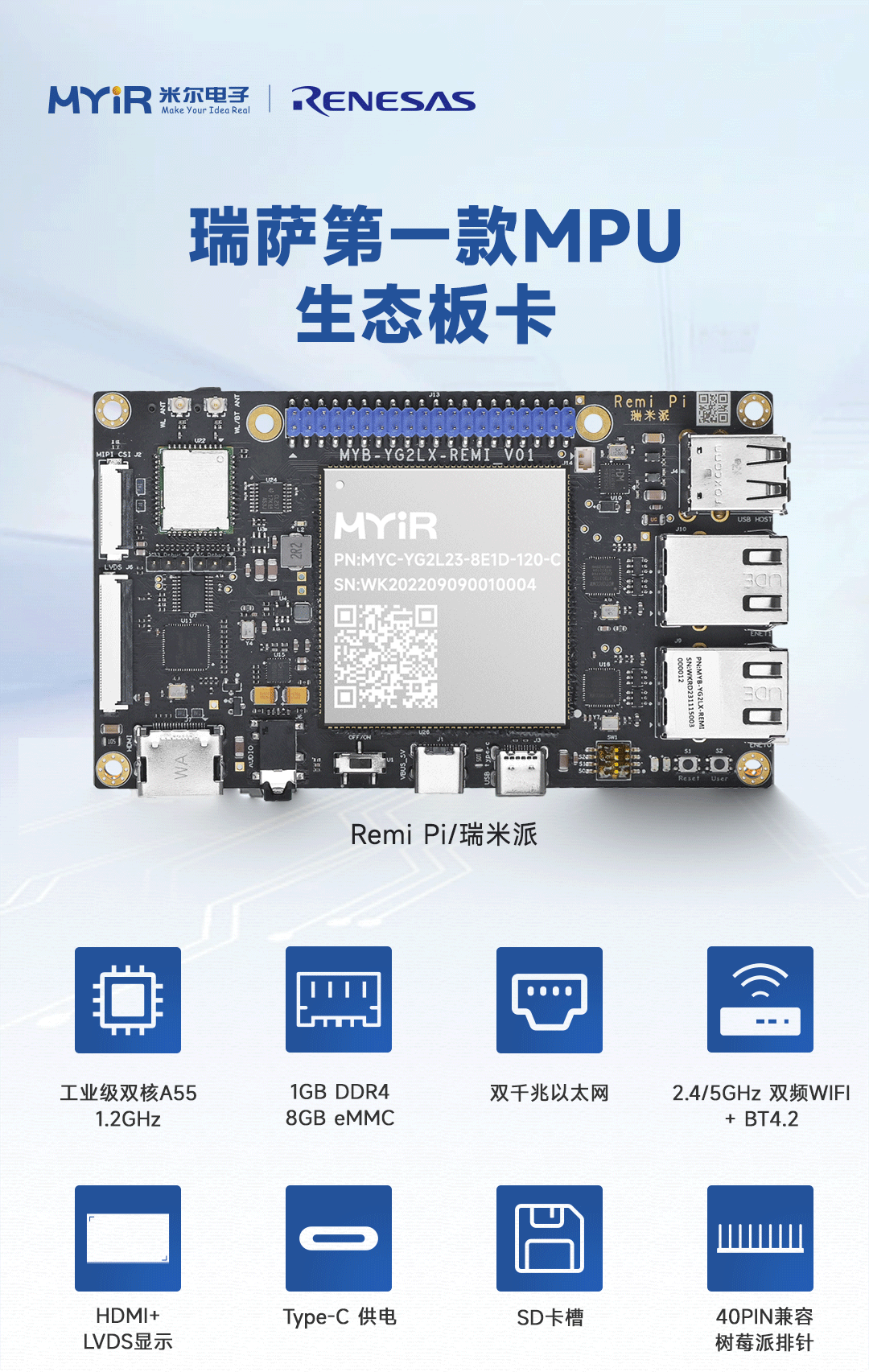

米尔基于MYD-YG2LX系统启动时间优化应用笔记

1.概述MYD-YG2LX采用瑞萨RZ/G2L作为核心处理器,该处理器搭载双核Cortex-A55@1.2GHz+Cortex-M33@200MHz处理器,其内部集成高性能3D加速引擎Mail-G31GPU(500MHz)和视频处理单元(支持H.264硬件编解码),16位的DDR4-1600/DDR3L-1333内存控制器、千兆以太网控制器、USB、CAN、

如何通过分块编码和分块传输CMAF

如何通过分块编码和分块传输CMAF

评论