完善资料让更多小伙伴认识你,还能领取20积分哦,立即完善>

电子发烧友网技术文库为您提供最新技术文章,最实用的电子技术文章,是您了解电子技术动态的最佳平台。

AI服务器按芯片类型可分为CPU+GPU、CPU+FPGA、CPU+ASIC等组合形式,CPU+GPU是目前国内的主要选择(占比91.9%)。...

评估三类模型:(i) 在ImageNet-21k上预训练的ViT,(ii) 在LAION-2B上预训练的OpenCLIP,以及(iii) 在ImageNet-1k上预训练的MAE。重建损失是所有输出标记的平均值,并在ImageNet-1k上进行评估。...

当前,业界在将传统优化技术引入 LLM 推理的同时,同时也在探索从大模型自回归解码特点出发,通过调整推理过程和引入新的模型结构来进一步提升推理性能。...

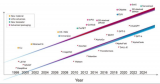

GPT模型对比BERT模型、T5模型的参数量有明显提升。GPT-3是目前最大的知名语言模型之一,包含了1750亿(175B)个参数。在GPT-3发布之前,最大的语言模型是微软的Turing NLG模型,大小为170亿(17B)个参数。训练数据量不断加大,对于算力资源需求提升。...

基于B100双Die架构,采用双Socket板级3D扩展可以实现与X100同等的算力。类似的方法也可以应用到X100中进一步扩展算力。...

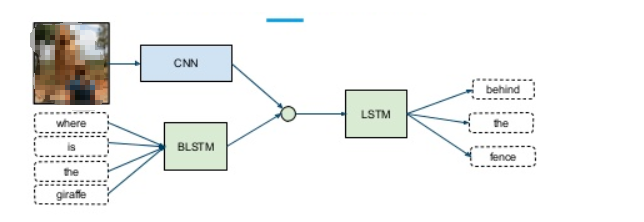

卷积神经网络(CNN)是一种在图像处理和计算机视觉领域广泛应用的深度学习模型,因其能够自动学习图像的层次化特征表示而成为SAR目标分类的理想选择。...

同一主机内GPU之间的通信:通过NVLink技术,双向带宽达到600GB/s,单向带宽达到300GB/s。...

为了增强对训练稳定性和性能的监控,开发了一个精度达到毫秒级的监控系统。采用不同级别的监控来跟踪各种指标。...

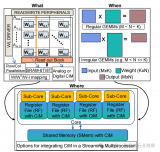

机器学习(ML)应用已经在汽车、医疗保健、金融和技术等各个领域变得无处不在。这导致对高性能、高能效 ML 硬件解决方案的需求不断增加。...

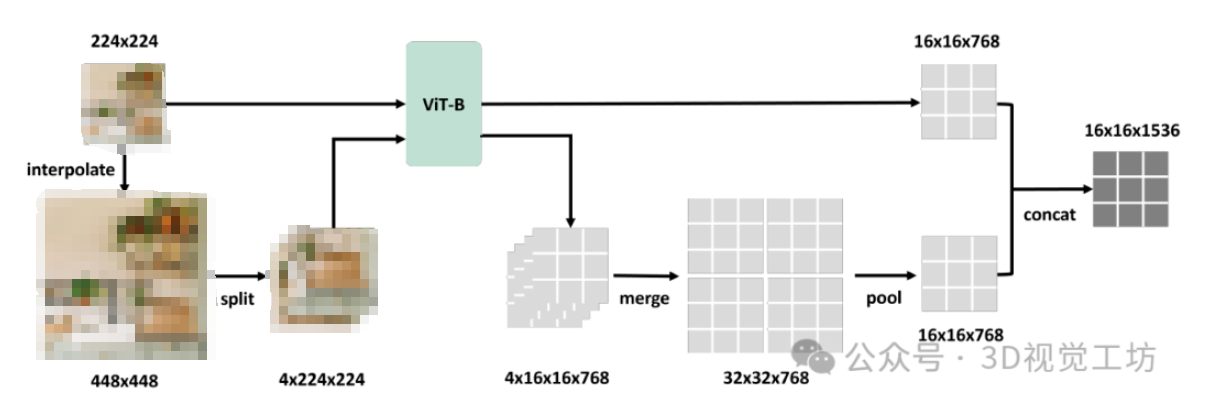

视觉Transformer的一般结构如图2所示,包括编码器和解码器两部分,其中编码器每一层包括一个多头自注意力模块(self-attention)和一个位置前馈神经网络(FFN)。...

人工智能成为所有人类事业的数字助手,拥有着巨大的机遇。ChatGPT是人工智能如何使高性能计算的使用民主化、为社会中的每个人带来好处的一个很好的例子。...

DBN 和 SAE 是完全连接的神经网络。在这两个网络中,隐藏层中的每个神经元都连接到前一层的每个神经元,这种拓扑结构会产生大量连接。...

在分布式训练中大规模使用默认的DCQCN协议时,all-to-all通信可能会导致拥塞和PFC级别的提高。过度使用PFC可能会导致头部阻塞(HoL),从而降低网络吞吐量。...

GANs真正的能力来源于它们遵循的对抗训练模式。生成器的权重是基于判别器的损失所学习到的。因此,生成器被它生成的图像所推动着进行训练,很难知道生成的图像是真的还是假的。...

利用偏振信息成像本质上是对光场信息获取维度的提升,通过多维偏振信息的获取与融合处理,可以解决不同复杂环境和应用领域的成像任务。...

AI 应用计算量呈几何级数增长,算法模型向巨量化发展,人工智能模型参数在过去十年增长了十万倍,当前AI超大模型的参数目前已经达到了千亿~万亿的级别。...

GPU和显卡的关系,就像是CPU和主板的关系。前者是显卡的心脏,后者是主板的心脏。有些小伙伴会把GPU和显卡当成一个东西,其实还有些差别的,显卡不仅包括GPU,还有一些显存、VRM稳压模块、MRAM芯片、总线、风扇、外围设备接口等等。...