完善资料让更多小伙伴认识你,还能领取20积分哦,立即完善>

电子发烧友网技术文库为您提供最新技术文章,最实用的电子技术文章,是您了解电子技术动态的最佳平台。

GPU和深度学习的结合对于使人工智能更快、更高效地升级也至关重要。GPU可以同时处理大量数据,从而实现更快的训练和推理。...

OpenRAN技术路线理论上可行,产品能够正常运行,但实际表现仍然不如华为产品,成本也更高。华为通过有机的系统设计路线,将设备前后级融为一体,实现了效能的最大化,同时降低了成本。...

基于多尺度变换(MST)的偏振图像融合方法研究开始较早且应用广泛。2016年,中北大学提出一种红外偏振与强度图像融合算法,融合结果能够保留红外强度图像的全部特征和大部分偏振图像的特征。...

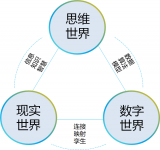

研究者们提出了一个框架来描述LLMs在处理多语言输入时的内部处理过程,并探讨了模型中是否存在特定于语言的神经元。...

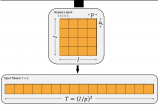

Al算力对高效电源提出新需求,背面供电技术蓄势待发:越来越高度化的集成会造成针对加速芯片的电源解决方案越来越复杂,方案需要不同电压、不同路的多路输入,这种情况下电压轨会越来越多。...

本质是让设计人员聚焦于修复BUG,而不是花时间发现BUG。将需要大量人力的工作交給AI,极大的推动了覆盖率收敛的速度。...

传统的雷达目标检测方法,主要围绕雷达回波信号的统计特性进行建模,进而在噪声和杂波的背景下对目标存在与否进行判决,常用的典型算法如似然比检测(LRT)、检测前跟踪(TBD)以及恒虚警(CFAR)等。...

循环神经网络 (RNN) 是一种深度学习结构,它使用过去的信息来提高网络处理当前和将来输入的性能。RNN 的独特之处在于该网络包含隐藏状态和循环。...

ASR 是自然语言中一项颇具挑战性的任务,它由语音分割、声学建模和语言建模等一系列子任务组成,根据噪声和未分割的输入数据形成预测(标签序列)。...

人工智能是由约翰·麦卡锡(John McCarthy)于1956年提出来的,当时的定义是“制造智能机器的科学与工程”。 现在的人工智能是指“研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学”。...

有监督学习通常是利用带有专家标注的标签的训练数据,学习一个从输入变量X到输入变量Y的函数映射。Y = f (X),训练数据通常是(n×x,y)的形式,其中n代表训练样本的大小,x和y分别是变量X和Y的样本值。...

在人工智能领域,谷歌可以算是开源的鼻祖。今天几乎所有的大语言模型,都基于谷歌在 2017 年发布的 Transformer 论文;谷歌的发布的 BERT、T5,都是最早的一批开源 AI 模型。...

那关于LLM的长文本能力,目前业界通常都是怎么做的?有哪些技术点或者方向?今天我们就来总结一波,供大家快速全面了解。...

门控网络或路由: 这个部分用于决定哪些令牌 (token) 被发送到哪个专家。例如,在下图中,“More”这个令牌可能被发送到第二个专家,而“Parameters”这个令牌被发送到第一个专家。...

大模型:即基础模型,在海量数据和计算资源的基础上通过预先训练出来的,具有大参数规模的深度学习模型 >狭义多指大语言模型,广义还包括CV、多模态等各种模型类型...

大模型的核心技术是自然语言处理(NLP)和深度学习。具体而言,它基于Transformer架构,使用了大规模无监督学习方法,例如自回归语言建模和掩码语言建模,来训练一个庞大的神经网络模型。...

图神经网络直接应用于图数据集,您可以训练它们以预测节点、边缘和与图相关的任务。它用于图和节点分类、链路预测、图聚类和生成,以及图像和文本分类。...

LDM 就是 Stable Diffusion 使用的模型架构。扩散模型的一大问题是计算需求大,难以拟合高分辨率图像。为了解决这一问题,实现 LDM时,会先训练一个几乎能无损压缩图像的自编码器,能把 512x512 的真实图像压缩成 64x64 的压缩图像并还原。...

自然语言处理领域存在着一个非常有趣的现象:在多语言模型中,不同的语言之间似乎存在着一种隐含的对齐关系。...